G検定 4-3 14. 正則化

シラバス 14. 正則化 についてまとめていきます

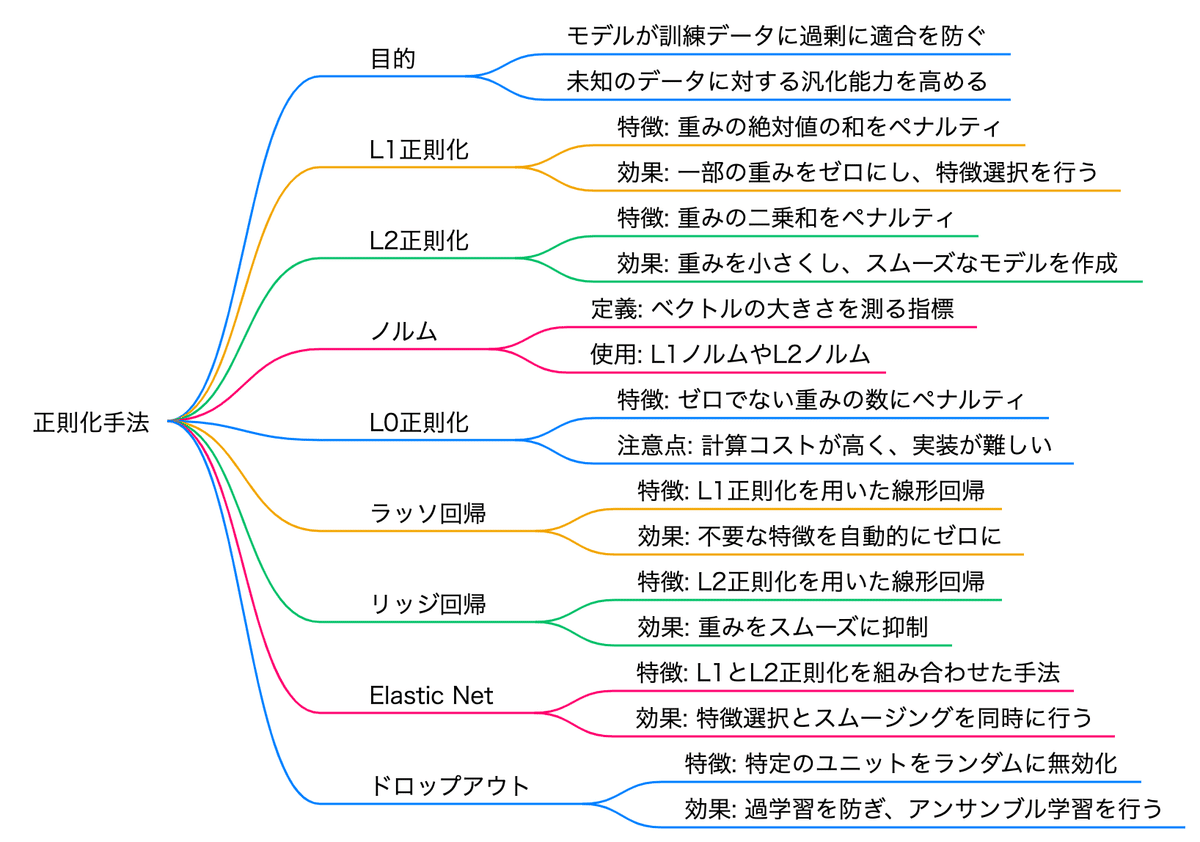

目標

・正則化を導入する目的を説明できる

・代表的な正則化手法の特徴を説明できる

・獲得したいモデルの特性に応じて、適切な正則化手法を選択できる

キーワード

L0 正則化, L1 正則化, L2 正則化, 正則化, ドロップアウト, ラッソ回帰, リッジ回帰

誤差関数を最小化することでモデル学習が行われ、適切な予測ができるようになる。

過学習を防ぎます。

対応策は総じて正則化と呼ぶ。

誤差関数にペナルティ項を課すことで、モデルが過度に複雑にならないようにします。

正則化 (Regularization)

モデルが訓練データに過剰に適合してしまう現象(過学習)を防ぐための手法です。

モデルの複雑さを抑えることで、未知のデータに対する汎化能力を高めます。

L1正則化 (L1 Regularization)

特徴の重みの絶対値の和をペナルティとして加えることで、モデルの重みの一部をゼロにします。

不要なパラメータを削減できます

ノルム (Norm)に対応(ベクトル(数の集まり)の大きさを測るための指標)

ラッソ回帰 (Lasso Regression)

L1正則化を用いた線形回帰手法で、不必要な特徴を自動的にゼロにします。

モデル選択に役立ちます。

L2正則化 (L2 Regularization)

特徴の重みの二乗和をペナルティとして加えることで、重みを小さくしながら全体的にスムーズなモデルを作ります。

異常に大きな重みを抑制します。

ノルム (Norm)に対応

リッジ回帰 (Ridge Regression)

L2正則化を用いた線形回帰手法で、重みをスムーズに抑制しながら全ての特徴を考慮します。

L0正則化 (L0 Regularization)

重みがゼロでないものの数にペナルティを加える手法です。

計算コストが高く、直接的な実装は難しいため、実際には近似的な方法が使われます。

Elastic Net (エラスティックネット)

L1とL2正則化を両方活用することで、それぞれの利点を組み合わせた回帰手法です。

特徴選択と全体的なスムージングを同時に行います。

ドロップアウト (Dropout)

ディープニューラルネットワーク(DNN)における正則化手法の一つで、過学習(overfitting)を防ぐために使用

モデルが学習中に特定のニューロンに過度に依存することを抑え、

多様性を向上させるのが目的

基本的な仕組み

トレーニング中:

各エポック(訓練の1周)またはミニバッチで、一定確率 ppp(ドロップアウト率)の割合でニューロンを無効化します(ランダムに選択し、その出力を0にします)。

この操作により、ネットワークは常に異なるサブネットワーク(縮小されたネットワーク構造)で学習します。

推論(テスト)中:

ドロップアウトは適用されません。

代わりに、全てのニューロンを使用し、それらの出力値を学習時のドロップアウト率に応じてスケーリング(通常は 1−p1-p1−p を掛ける)します。

メリット

過学習の抑制:

特定のニューロンやパラメータに依存しにくくなり、モデルの汎化性能が向上します。

アンサンブル学習:

ドロップアウトによるランダムなニューロンの無効化は、複数のモデルをランダムに作って学習することに相当し、実質的なアンサンブルモデルの効果を得られます。

ニューラルネットワークの特定のユニットを訓練の間にランダムに無効化することで、過学習を防ぐ手法です。

ランダムに複数の異なるサブモデルを同時に訓練、ニューロンを除外するような効果があります。