NAI Diffusion Anime V3がリリースされたので試してみた

「NAI Diffusion Anime V3」がリリースされたので試してみました。

[Update] NovelAI Diffusion Anime V3

— NovelAI (@novelaiofficial) November 15, 2023

We are happy to introduce you to our newest model: #NAIDiffusionV3

Better knowledge, better consistency, better spatial understanding and it is even quite adept at drawing hands (finally!)

Full Release Post: https://t.co/v7q3ljxV58 pic.twitter.com/mvkLeR8kBD

リリースノート

下の方に日本語訳があるので大事そうなところを抜粋引用させていただきます

NovelAI Diffusion Anime V3のご紹介

アニメAI画像モデルのV2をご紹介してからまだ1ヶ月も経っていませんが、今日は最新モデル『NovelAI Difuusion Anime V3』をご紹介します。

より優れた知識、より優れた一貫性、より優れた空間理解力を持ち、(ついに!)手を描くことにさえ長けています。

SDXLと隠し味がベース

私たちの最新モデルは、StabilityAIのSDXLモデルをベースにしていますが、いつものように、私たち独自の隠し味を大量に投入し、さらに進化させています。例えば、純正のSDXLよりも暗いシーンを生成するのがはるかに簡単です。もちろん、モデル名からお分かりのように、CoreWeaveがホストする高性能H100 GPUクラスタShoggyを利用した、アニメスタイルの徹底的なトレーニングによって、V2モデルをリリースして以来、迅速に反復することができました。

Stable DiffusionのSDXLは非常に高い学習能力があることが証明されており、利用可能なトレーニングデータの量が非常に限られている場合でも、その知識は以前のSD1.5モデルをはるかに上回っています。このバージョンの画像生成AIでは、より幅広いアートスタイルが可能です。

また、より広い画像生成コミュニティが恩恵を受けられるように、私たちの新しいテクニックの適切な文書化に取り組んでいます。

プロンプトを反映する正確度の再調整

NovelAI Diffusion Anime V3は、私たちの前のモデルよりもはるかに低いプロンプトガイダンス値(プロンプトを反映する正確度)で動作します。現在の推奨値は5〜6です。しかし、より高いプロンプトガイダンス値を使用することで、プロンプトをより適切な方向に導くことができる場合もあります。そこで、「プロンプトを反映する正確度の再調整」という新しいオプションを追加しました。このオプションは画像の色合いをおかしくせずに高いプロンプトを反映する正確度を使用することができます。

これは主に上級ユーザーを対象としているため、ユーザーインターフェースの新しい「詳細設定」セクションに移動しました。また、「除外したい要素の強さ」の設定もこの新しいセクションに移動しました。

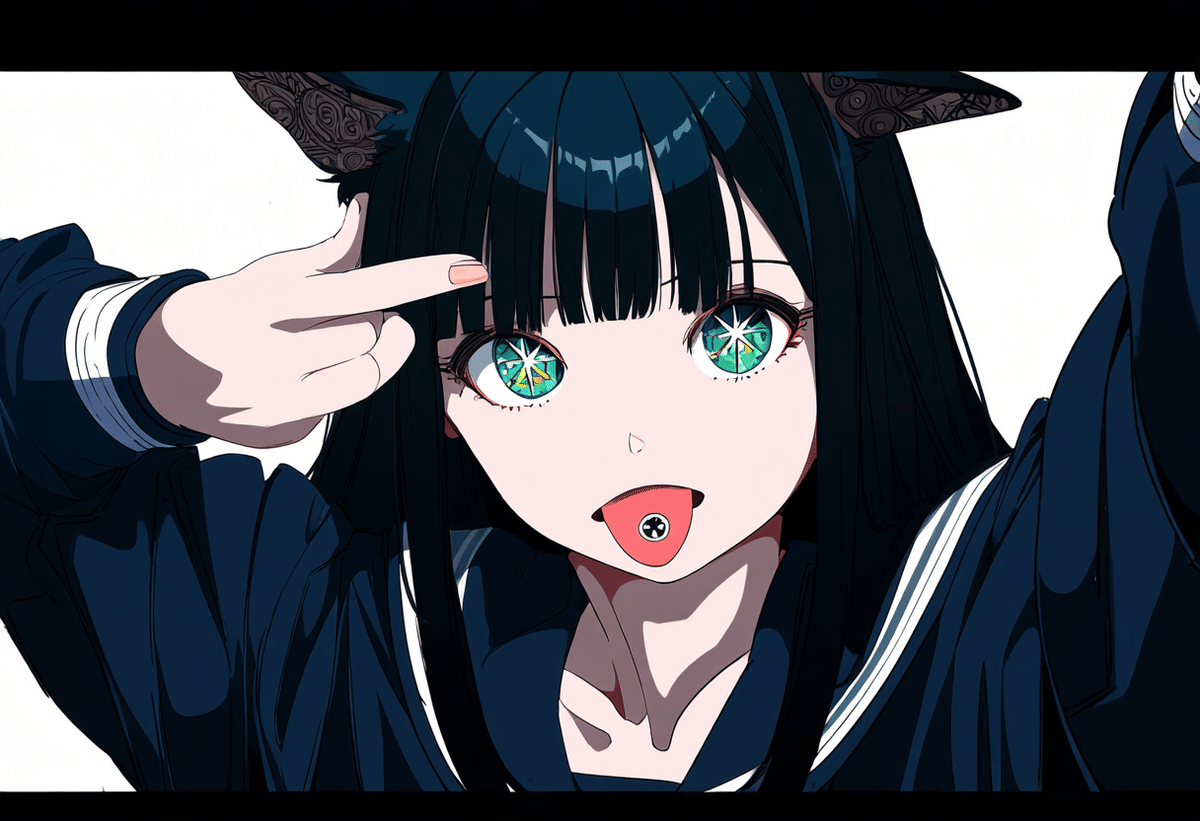

実際にやってみた。

プロンプトはこんな感じ

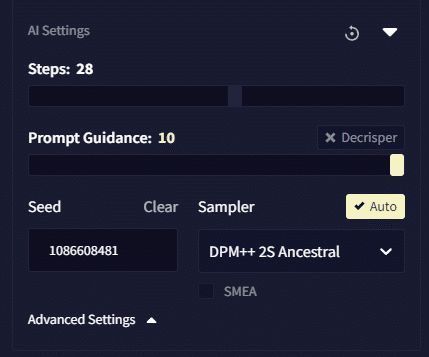

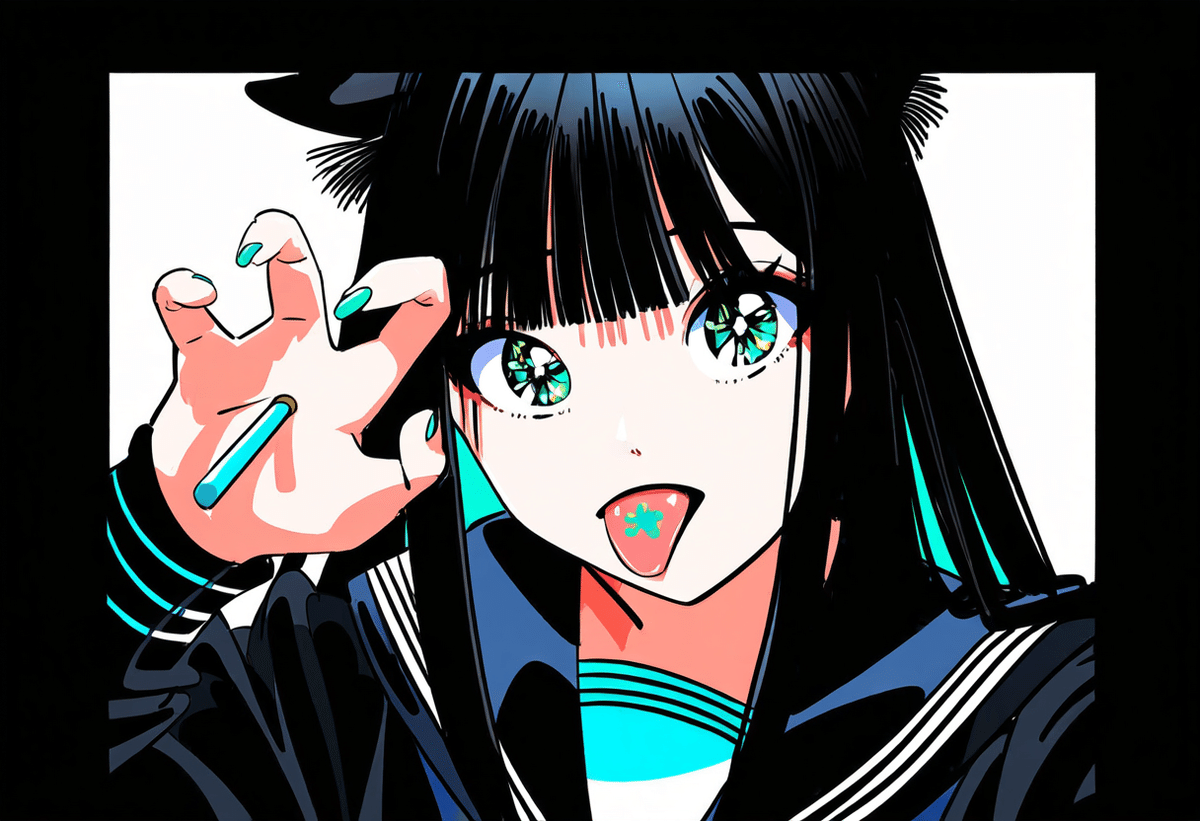

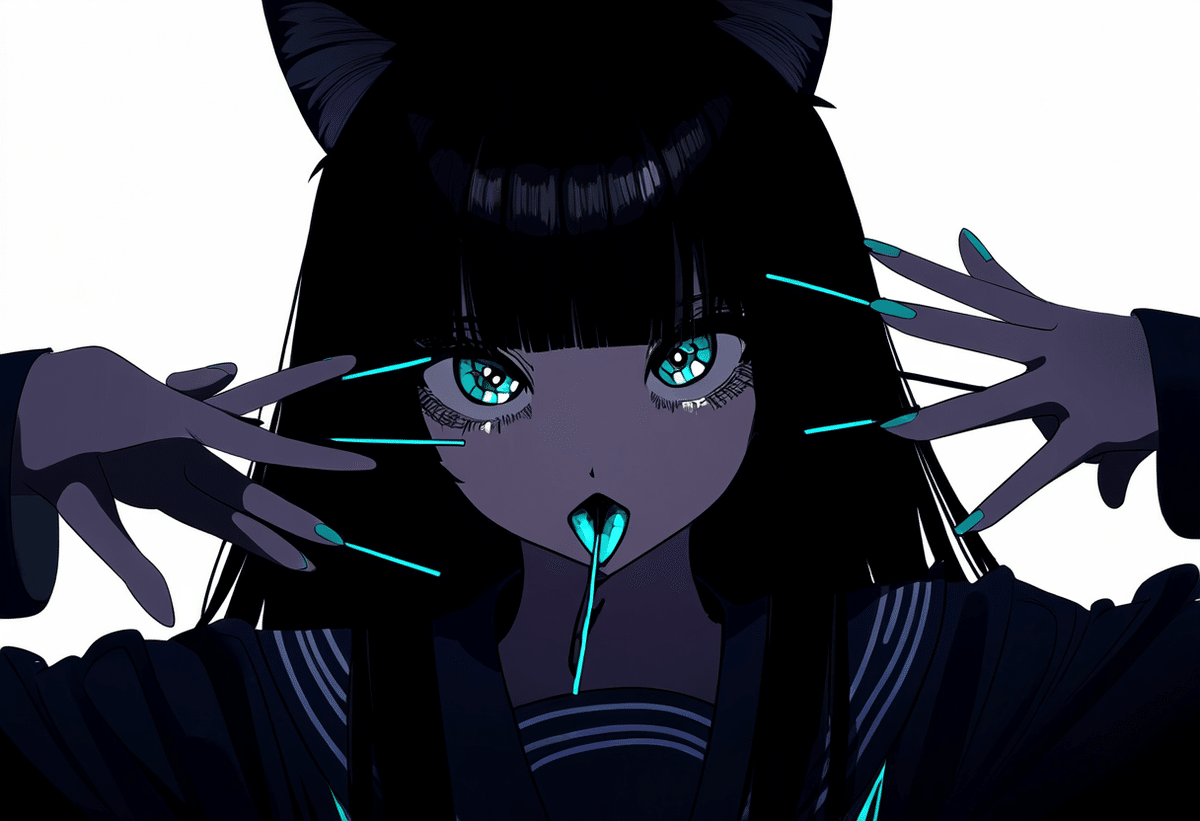

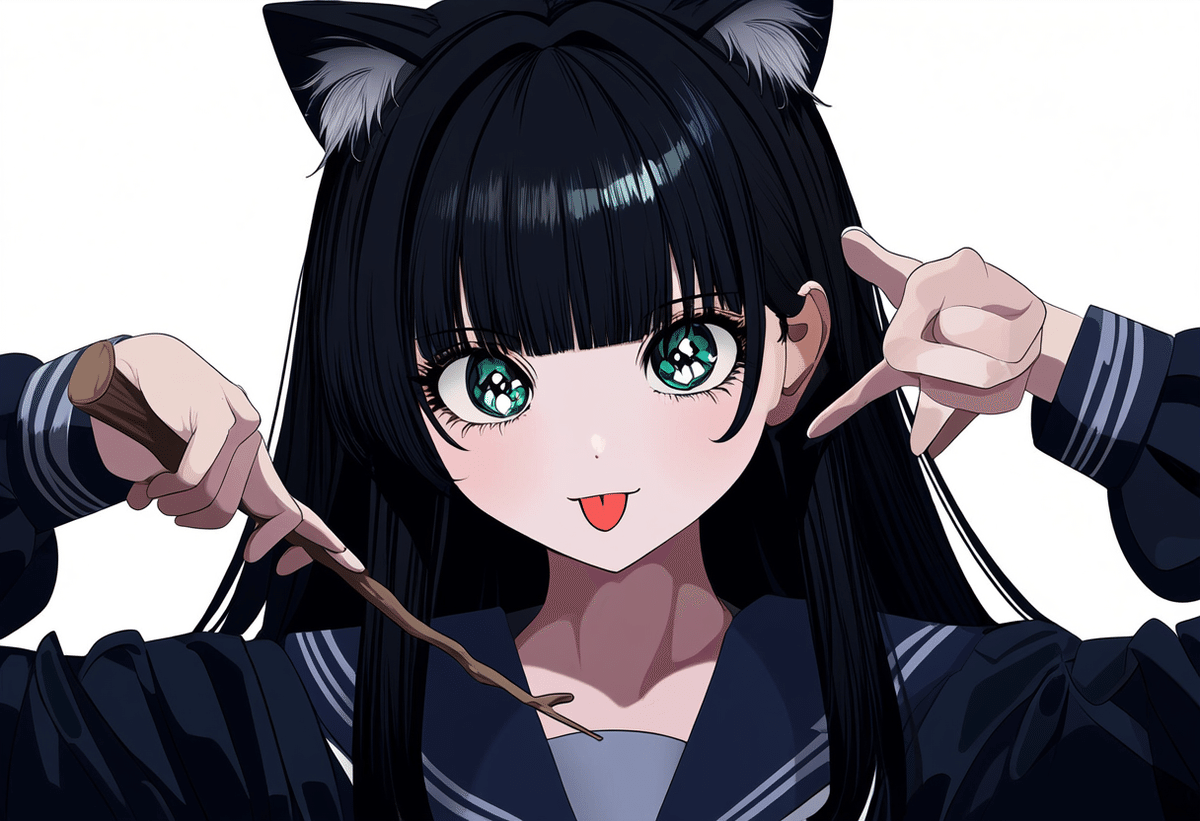

dynamic pose,masterpiece,1girl,solo,best quality,anime style,ultra_detailed,intricate details,hyper detail,dark hair turquoise point,hime_cut,turquoise_eyes,school_uniform,unfinished,straight bangs,cat ears,long hair, simple background, stick out tongue

こんな感じに生成されます

Prompt Guidanceを7から10へ

Guidanceを7に戻して、サンプラーを「Euler」にかえてみます

DPM++2S Ancestral

DDIM

その他のリリース情報

再度引用に戻ります

新しいインペイントモデル

SDXLベースの新しいV3モデルに基づいて、新しいインペイント(描いて新しいマスクを追加する)モデルもトレーニングしました。以前と同じように、モデルにもう一度生成させたい画像の部分をマスクすることができ、内容を変更したり調整したり、あるいはまだ綺麗ではない手を修正したりすることができます。

サブスクリプションなしでAnlasを購入

NovelAIの通貨Anlasは、サブスクリプションをお持ちでなくてもご購入いただけるようになりました。有効なサブスクリプションをお持ちの方は、特典として現在の割引価格でご購入いただけます。

クオリティタグ

novelAIやってる人、これからやろうという人、ぜひお試しください!プロンプトの枠の右上にある歯車をクリックすると品質タグを加えるというボタンがあります。これを有効にすると1girlだけ(ネガティブも無し)でもかなりのイラストが出せます!右は1girlだけです。 #novelaidiffusionanimeV3 pic.twitter.com/viwbgsRMu1

— pariparifilm (@pariparifilm) November 16, 2023

確かに「1girl」でネガティブタグなしでもかなりのものが出ますね…

個人的な感想

オリジナルのSDXLに対して、かなり商用IPを食っているなあという印象です。また新機能「Quality Tags」は、より効率的に目的の絵を作るための有効なワードを探せるのですが、かなり具体的に商用IPのキャラクター名、つまり商標やIPを侵害しやすくなっているので、注意が必要と思いました。

大丈夫そうな作例はこちらに置いておきます。

https://www.pixiv.net/artworks/113463524