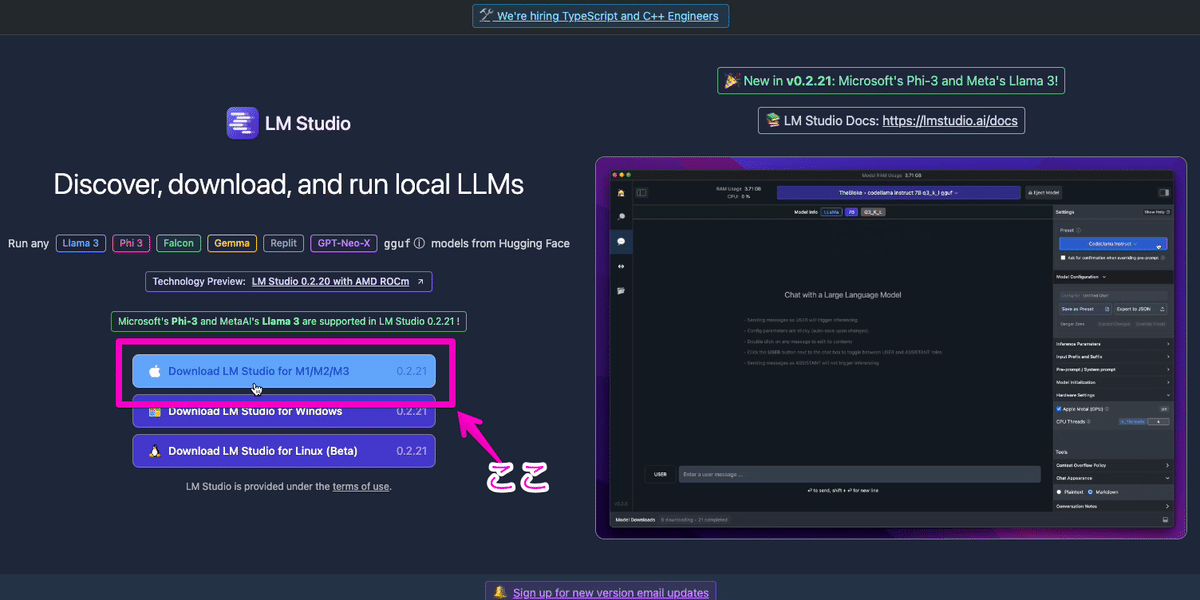

【え?こんなに簡単なの!?】 LMstudioでローカルAIを動かす方法 【Mac】

M1/M2/M3あたりを搭載しているMacがあれば、つよつよGPUが無くてもローカルでAIが動かせるってさ! じゃぁやってみよう!

M1/M2/M3シリーズは、なんか通常のメモリをGPUのメモリとして使っちゃうことができる仕組みがあるんだってさ。だからAIを動かすために必要なGPUメモリが足りなくても動かせちゃうんだって!? すごー

まずここにアクセスして LM studio をインストールする(無料)

https://lmstudio.ai/

アプリを立ち上げましょう!

立ち上げたらさっそく試したいmodelダウンロードしましょう

(オープンになってるmodelですが沢山あります)

↓

試すmodelがダウンロードされるのを待ちます

↓

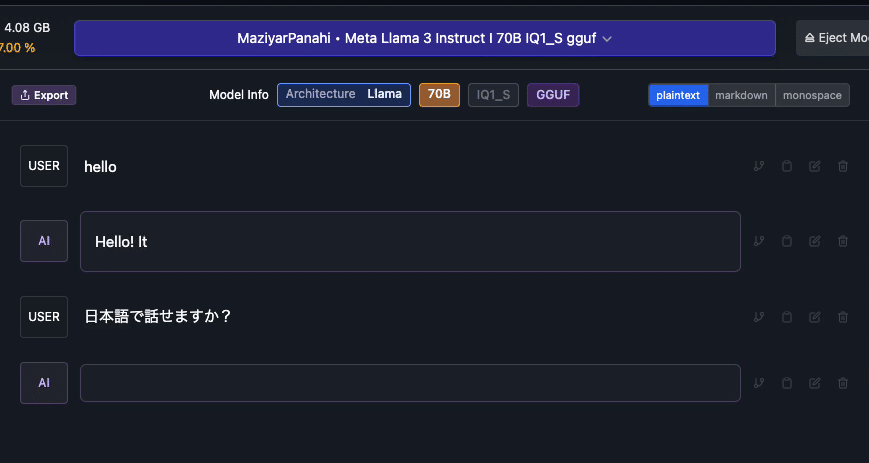

ダウンロード終わったら話しかけてみよう!

↓

(まずは英語でこんにちは)

↓

以上!簡単でしたね!(簡単すぎ)

もっと喋れるAI model を探す

先ほど入れたmistralちゃんはあんまり日本語得意じゃないみたい(知能も低め…)

↓

Llama3賢いって聞くけど、マシンスペック的にちょっと動くかわからないなぁ

↓

llama3の8Bモデルを探した(7B/8Bとかより70Bとかのほうが知能高いよ。動かせるなら)

↓

DL後、model選択を変更して話しかけてみる

↓

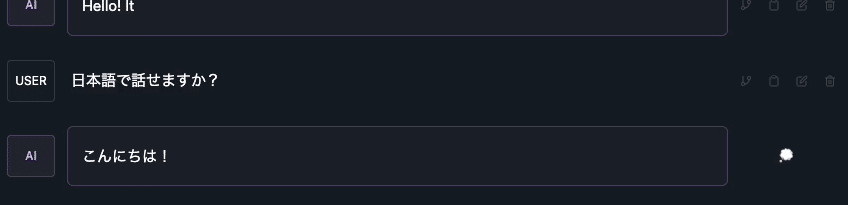

思い切って、「君のマシンには辛いかもよ」ってモデルをDLして試す

↓

DL完了!

(さて、どうなりますか…)

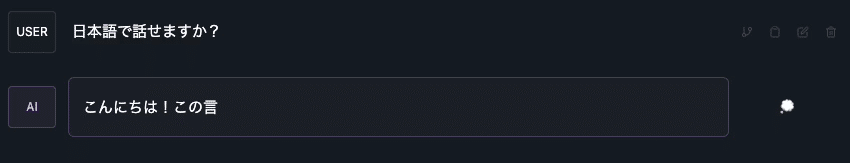

おっそぉぉぉぉぉい

おっそいけどがんばってる

すごいね!2024/5の時点でローカルMacでちゃんとAIちゃんが動いてる

インストール簡単。いろんなモデルの試せる!

(M1/M2/M3系搭載のMacならGPUメモリ足りなくて動かなそうなmodelでも動かせちゃう)

動きが遅くても、そこそこの知能のAIがローカルで動くのは素晴らしいですね! ※電気代のみでいいし

最近はmodel開発の方もどんどん進化してるので、軽快に動いて高知能のAIモデルもそのうち出てきそうだよね。楽しみだね!

ではでは良きローカルAIライフを!!

ちなみに

もっとマシンパワー使ってよ!って設定も可能

ちなみに その2

DLしたモデルを、サーバーを立ててAPI化することも可能