自宅環境でLLMの環境を作ってみた

背景

生成AIはChatGPTを使って、調べごとやお仕事で使っているが、一般公開できない内容をChatGPTでは書くことはできない。生成AIを組み込んで何かできないかのお勉強のため、自宅PCでLLMの環境を作れないかと考えてWeb上で調べていたところ、「LM Studio」というツールの存在を知った。それを使って、自宅PCでLLMの環境を作ってみたのでその手順を個人備忘録として記載。

※今回、初note投稿なので、うまく書けるかは微妙です。

環境説明

自宅PCスペック:

プロセッサ:11th Gen Intel(R) Core(TM) i5-11400 @ 2.60GHz 2.59 GHz

実装RAM:32.0 GB (31.8 GB 使用可能)

GPU:NVIDIA GeForce GTX 1660 SUPER

利用したモデル

読み込ませたモデル:

ELYZA-japanese-Llama-2-7b-fast-instruct-q5_K_M.gguf

open_gpt4_8x7b.Q4_K_M.gguf

※色々試したけど、下のopen_gpt4_8x7b.Q4_K_M.gguf方が色々返ってくるのでこちらにした。

事前に必要なツール

ChatGPT (色々分からないことは、ChatGPTで質問していた、なら、わざわざ作らんでもというのはあるが…)

※ChatGPTは4.0を使っています。有料まで使ってるのに…

何はともあれ、LM Studioをインストール

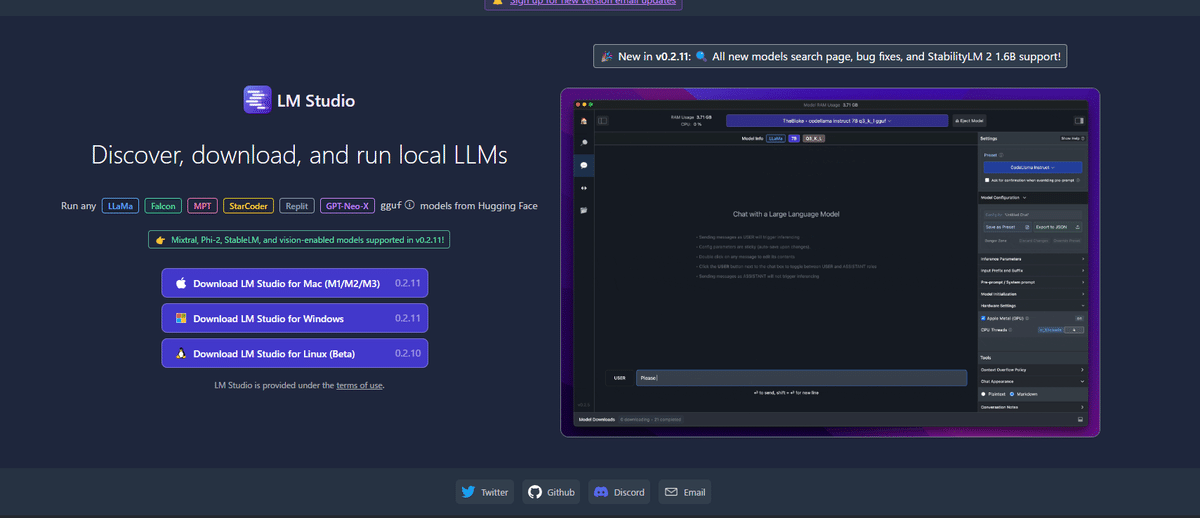

LM Studioをサイトからダウンロードする。

このあたりは、Webで調べたらあったので調べまくった形。

以下、サイトの画面です。(2024/01/27現在)

私の使っているのはWindowsなのでWindows版をダウンロード。ダウンロードが終わったらインストールしました。

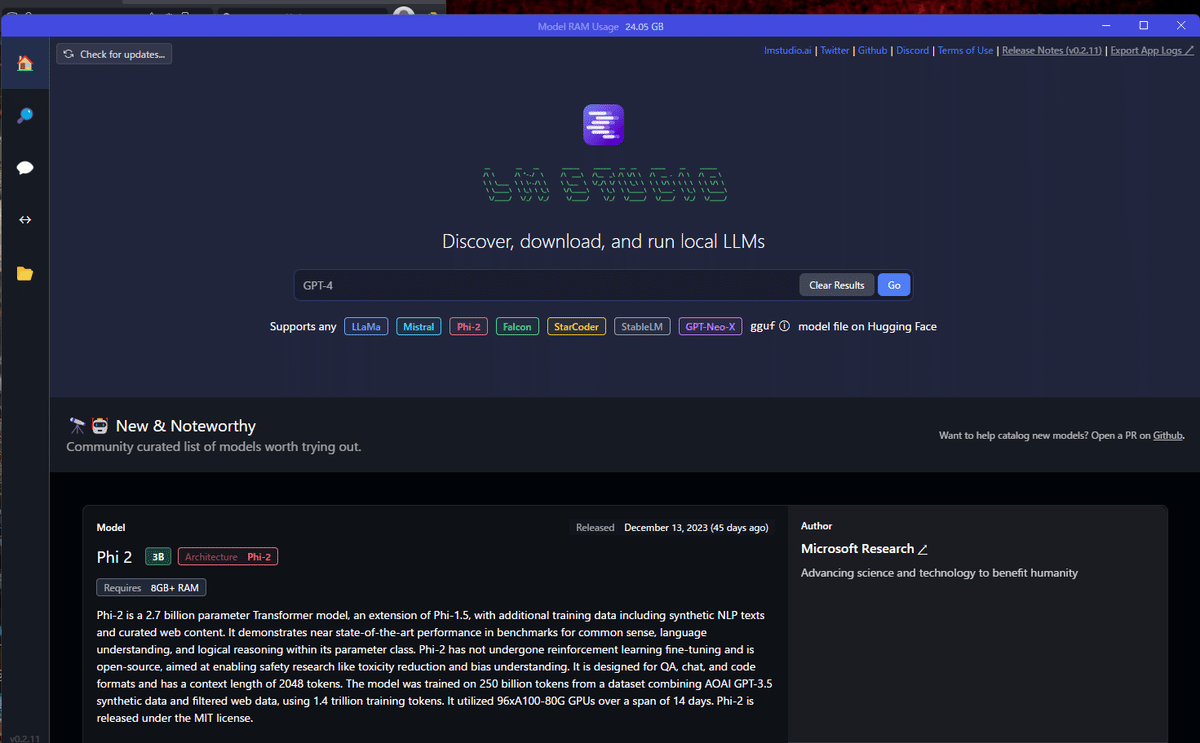

インストール後、LM Studioを起動すると以下のような画面が出ます。(こちらも2024/01/27現在)

モデルを落としてくる

センターのところからモデルを検索することができます。他には、左バーの虫眼鏡のところからでもできます。

まず、「ELYZA-japanese-Llama-2-7b」と入力してもらうと以下のような画面になります。

ここから一応PCとして使えそうなので、「ELYZA-japanese-Llama-2-7b-fast-instruct-q5_K_M.gguf」を入れてみました。

こちらを入れて、LM Studioの左バーにある、白色の吹き出しみたいなアイコンがあると思いますので、そこをクリック。

画面の上の方に添付したようなものがあるので、そこでダウンロードしたモデルを選択します。選択すると読み込むのにちょっと時間がかかります。

この吹き出しのところでChatGPTのようなことができます。

実は、ここでチャット使っていたのですが、やはり、ChatGPTとは差が出てくるなと思い、他ないかなとモデルを調べて、個人的に割といけるかもと思ったのが試した「open_gpt4_8x7b.Q4_K_M.gguf」というモデルでした。

割と容量が大きいのと、大きい奴は私のPCスペックではダメっぽいのでDownloadも無理でした。

これでLM Studioを使ってChatGPT風にはローカルでできるなと一段落。

まとめ

割と簡単に自宅PCに入れることができたのが驚き。

後、PCのスペックが無くても小さなモデルを入れたら、全然動きます。

調べてて分かったのは、LM StudioってHTTPサーバー機能があって、アプリとか作ってそこから生成AIを使ったりできるようなので、そのあたり遊べないかなと思っています。(このNote書きながらPythonアプリを作ってHTTPサーバーとお話させたり…次はそちらの備忘録を書きたいな。)

この記事が気に入ったらサポートをしてみませんか?