AIエージェントのすぐ先の世界 -組織の壁はなくなり,AIロボットと机を並べる

前回の記事で僕は、OpenAIのAIエージェント「Operator(オペレーター)」の発表をふまえて、僕がよく質問される「AIと働く未来」とは具体的にどんなことか、について記しました。

そして記事の中で、こう書いています。

NVIDIAの語る「AIエージェントの未来」も重要(次回)

このあたりの話は、年明け1月7日に行われた、「NVIDIA CEO Jensen Huang Keynote at CES 2025」でも映像とともにプレゼンされています。

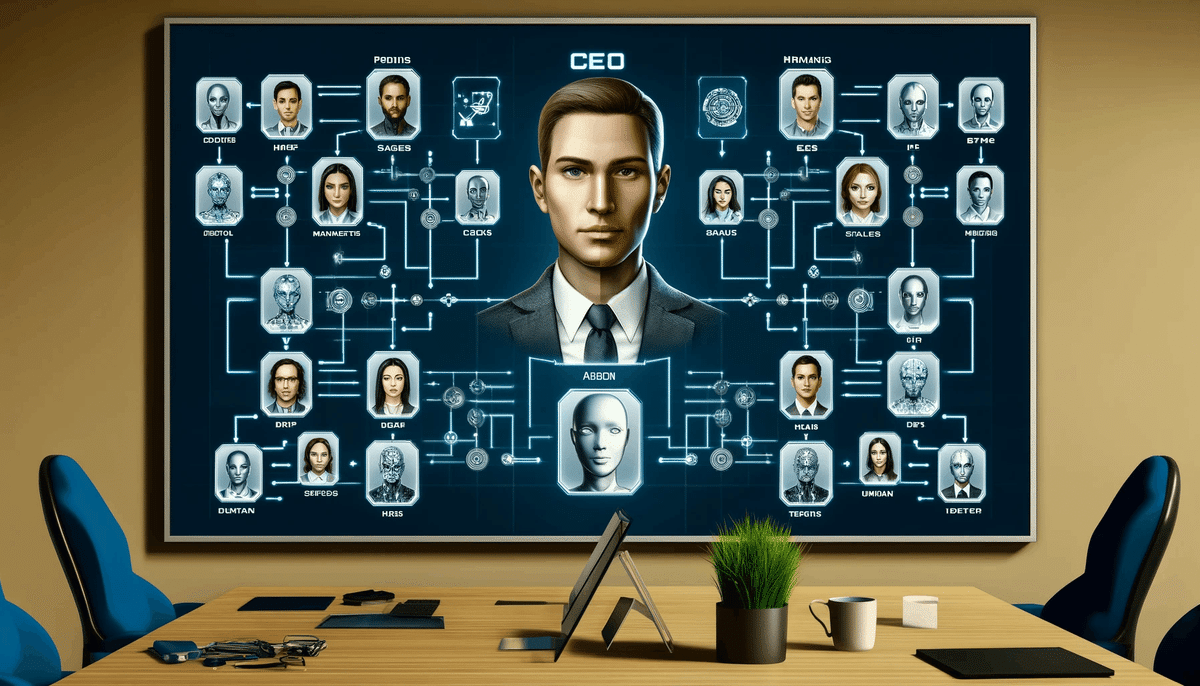

ジェンスン・フアンCEOはこのカンファレンスで「IT部門は人事部になる。AIエージェントを作り出し、その企業文化をAIに教育し、実際の仕事に就かせる(オンボーディングといいます)」と発言してました。

AIエージェント社会を端的に表現して、とてもわかりやすい。

つまり、

人事部:人を採用して教育して、各部門に配置する

IT部門:会社に必要なAIエージェントを開発して、各部門に配置する

ということですね。

AIエージェントが同僚に

1月7日に行われた「NVIDIA at CES 2025」では、同社の抜け漏れのない、したたかとも思える、完璧な論理に基づく戦略が語られていました。

NVIDIA CEO Jensen Huang Keynote at CES 2025

AIが人事部門の「バーチャル社員」

AIエージェントはOpenAIはじめ、各社から発表されていますが、

NVIDIAの発表は、その先を行っていました。

それは、AIエージェントが単なる個人ツールから、組織の一員となる、といった未来でした。

それをふまえると、僕が前回の記事で書いたような未来が、訪れることになります。

部署50人のうち30人はAI、の時代へ?

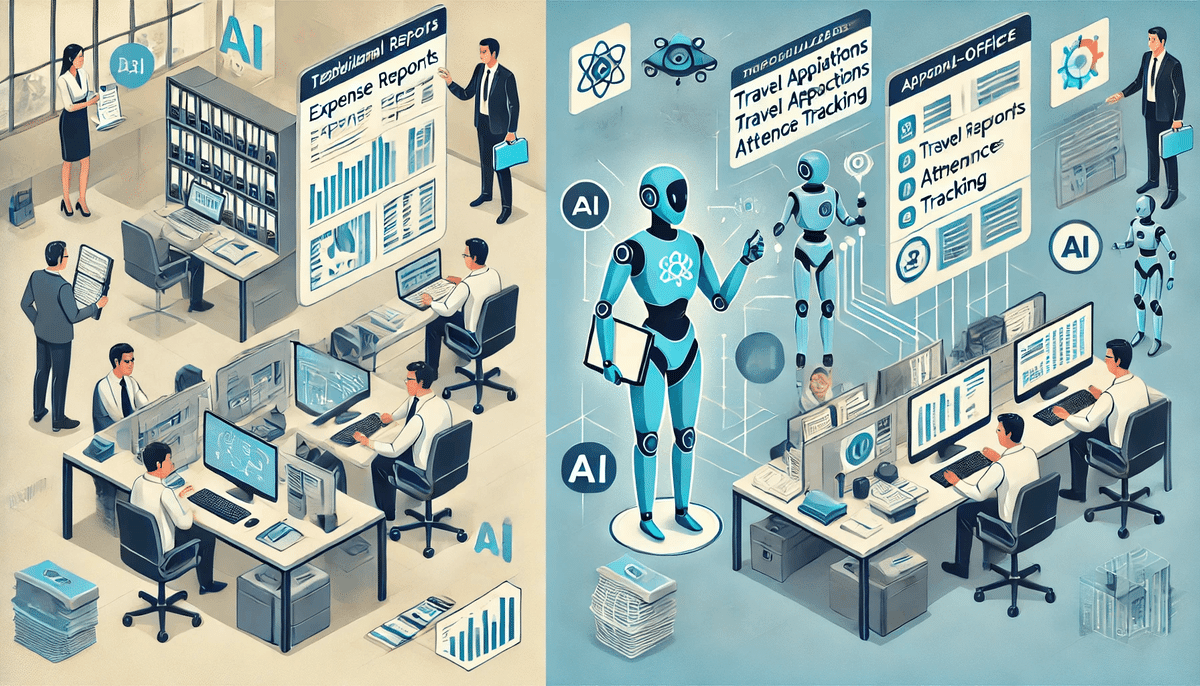

経費精算したい時、Cさんに、@Cさん、お願いね!とメンションすると、Cさんは、頼まれた人の経費情報を、例えばタクシーサービスのGOの領収書画面にログインして、情報を取得して、交通費精算表を起票して、経理課にメールをする、という作業をしてくれます。

こうして、あと2年もすれば、XX部SLACK上に、50人が登場。うち20人はヒト、30人はAIエージェント、といった部門になるという訳です。

組織の壁をAIが破る AIオーケストレーション

さらに、究極的には、組織の概念すら無くなるでしょう。

「え?」と思われるかもしれませんが、日本企業の問題点は組織の壁の高さ故の、業務の非効率にあるのです。

「オーケストレーションスタイル」とは

そのため、組織ではなく、「経費生産するAIエージェント機能」、「人事評価をするAIエージェント機能」といった機能単位で人やAIが存在し、全社横断型の業務プロセスをコントロールするAIがそれらの機能を繋げて、仕事を完結していく……。

これをオーケストレーションと呼びますが、そんなスタイルに今後変わっていくことでしょう。

例えば、現在の会社組織には、コーポレート担当役員がいますよね。

それと同じように、バックオフィスの仕事(機能)である、経費精算、出張申請、勤怠入力などの仕事(機能)を実行するAIエージェントが、協調、連動して動き、働けるよう、業務(プロセス)を統括してコンロールする……つまり部長のようなAIエージェントが登場し、AIエージェント機能の管理をするようになるでしょう。

組織の壁を壊し、業務効率化が圧倒的に改善

そうすることで、今までは、例えば、「結婚しました」となったら、姓の変更は人事部に申請し、福利厚生施設の利用変更は総務部に個別に問い合わせたり……といった、それぞれのシステムを利用していて面倒だなと思っていたことが、組織の壁を超えて、できるようになります。

日本の大企業の組織は総じて、サイロ化していて、壁があります。部門を超えて稟議書を提出したら、稟議が承認されるのに、3週間かかった、そんな経験はありませんか?

誰でもあると思います(笑)

組織間の思惑、考えや方針のばらつき、人間関係のバイアスなどが、その原因ですが、AIエージェントが機能別に用意され、その機能をつないで業務が回るように設計して、その業務進行状況をAIエージェントが監督する…

こうすれば、おそらく、稟議は3週間から1日に短縮されるでしょう。これは劇的な業務の効率化、生産性の向上を企業に生み出します。

こうした組織の壁を壊して、業務効率が圧倒的に改善されるのは、意外と、AIエージェントの登場で実現できるかもしれませんね。

AIエージェントが真の自律機能を持つと

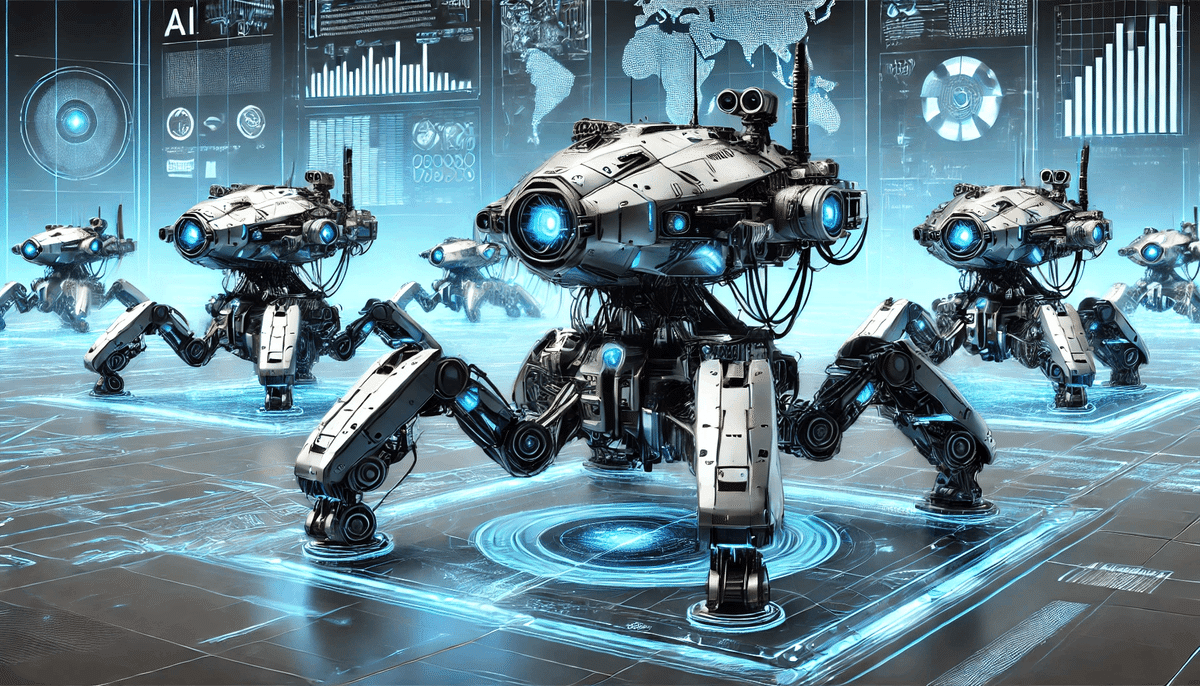

さて、AIエージェントがより自律的に動けるようになると、次にどのように進化するでしょうか?

AIエージェントが真の自律機能を持つようになると、オーケストレーションするAI、あるいはヒトのマネージャーは、ただ業務の進行状況だけを淡々と管理するだけになります。

AIエージェント同士が会話して、仕事を実行していく……。業務のプロセスをAIが自律的に判断し、AIエージェント同士が情報交換して、業務を完結する世界が到来します。

これは、攻殻機動隊の「タチコマ」(「攻殻機動隊」シリーズに登場するAI戦車。ネットを介してタチコマ同士が知識を共有する「並列化」ができる)ようなものですね。

「人の代わりに働くAI」には2種類ある

ところで。AIエージェントは「人の代わりに働く」ものですが、今まで挙げた例は、身体を持たないエージェントでした。

Slack上に「AIエージェントA」という名前はあっても、実態があるわけではない、読者のみなさんも、そうした理解だと思います。

しかし会社の業務には、身体を持たないと、こなせないものもあります。

AIエージェントの未来とは

NVIDIAのジェン・スン・フアンCEOは、CES2025の基調講演で、「AIが肉体労働の分野にも進出する可能性にも言及しています。

つまりAIエージェントが将来的にAIロボットへと進化を遂げていく未来を語りました。

AIエージェント(人の代わりに働く)

↓

脳で処理(AIシステム) 身体を使って働く(ロボット)

三次元で動かすには「世界」の認識が必要に

今までの生成AIは大規模言語モデル、つまり言語(テキスト)を大量に学習してきました。

そのため、人間ように流暢に会話できるようになったのですが、Chat-GPT4oが登場してから、この能力はもう十分に達成できた感があります。

今後、AIが人のようになるには、僕たちが当たり前と思っていること、例えば、「りんごは木から落ちる。地球には重力があるから」といった、僕たちの生きる「3次元での法則」を覚えないといけません。

AIエージェントが、人間のように身体を持って三次元で活動をするとなると、絶対に必要なのが「世界」の認識です。

これを研究者の間では昔からワールドモデルと呼ばれ、特定の分野ごとに、ばらばらに研究されてきました。例えば自動車や工業機械の自動運転や、自走型ロボットの開発においてです。

この、分野ごとのワールドモデルを統合し、人と同じ3次元の概念理解をAIにさせる、という壮大な構想が、NVIDIAが先日発表したCOSMOSです。

以下のNVIDIAの発表をお読みください。

私たちは世界の基盤モデル(a world Foundation model)を作成したいと考えています。

本日、非常に大きな発表を行います。NVIDIA Cosmosという、物理世界を理解するために設計された世界の基盤モデル(ワールドモデル)を発表します。これを理解する唯一の方法は、実際に見ていただくことです。

このworld Foundation model、「ワールドモデル」については、以前、記事を書いています。

【事例】推論だけでは物事の概念に到達できない

しかし、物事の概念を推論だけで考えつくのは難しいのです。

例えば、30㎝球上の綿菓子の上に、直径30センチの石をのせたら、高さの合計はどうなるでしょうか?

当然、綿菓子は、石に押し潰されてしまいますよね。でも、AIは綿菓子が柔らかく空気にように繊細で形が定まらないモノだという認識、すなわち、概念を理解していないのです。

そのため、「綿菓子の上に石を置くと高さは何センチ?」とChat-GPTに聞くと、推論により、綿菓子と石の高さ単純に足し算して、「60センチです」と間違った答えをしてしまいます。

このように、生成AIが今後、ヒトを超える能力を身に着けるには、知識と推論だけでは足りません。

「重いものは下に落ちる」など、人間が直感的に把握しているワールドモデルを 学んでいく必要があります。

生成AIがいくら優秀な推論で答えをはじき出しても、僕ら人間が意識せずとも認識している世界や物理現象を理解していなければ、正解が導けないことも非常に多いのです。

大規模言語モデルからワールドモデルへ

先ほど、生成AIの大規模言語モデルは、既に機能の限界に達していると述べました。

今後は生成AIのモデルは推論能力の進化と共に、言語以外の、3次元の空間概念を学習するワールドモデルへの進化が始まります。

つまり、

大規模言語モデル(この世のあらゆるテキストの理解)

→ ワールドモデル(3次元のあらゆる事象の概念理解)

ということです。

NVIDIAが「ワールドモデル」作りに名乗りを上げた

膨大なデータの収集と解析、そして高度なシミュレーション技術が必要になるため、各社とも、なかなか声を大にして語ることができなかった「ワールドモデル」。

その開発をNVIDIAが宣言したことは、大変興味深いお話しです。

同じく、ビジネスパーソンの目線でフアンCEOのプレゼンでの発言該当部分(下記)を読んでみてください。

NVIDIAが開発者に開発プラットフォーム提供して、ワールドモデル作りを牽引していく、と宣言していることが読み取れると思います。

NVIDIA Cosmosは、フィジカルAIを進化させるための世界の基盤モデル開発プラットフォームです。

開発者は、NVIDIA Omniverseを使用して物理ベースで地理的に正確なシナリオを構築し、OmniverseのレンダリングをCosmosに出力して、フォトリアルで物理的にベースの合成データを生成します。

Cosmosはリアルタイムでトークンを生成し、予見とマルチバースシミュレーションの力をAIモデルにもたらし、あらゆる可能な未来を生成して、モデルが正しい道を選択するのを支援します。

世界の開発者エコシステムと協力して、NVIDIAは次の波のフィジカルAIを進化させています。

開発環境を提供する「囲い込み」もNVIDIAの強さ

こうした、AIが人のように動けるようにするためのAIエージェントの先にある、人型AIエージェント、つまりAIロボットの開発環境を提供する、これはとても大きなことです。

こうしたエコシステムというか、AIの開発基盤を提供するビジネスモデルは、NVIDIAらしい戦略です。

つまり、3次元のあらゆる概念をCOSMOSに学習させて、その知識をもとに、Omniverseというシュミレーションソフトにより、あらゆる産業のヒトの作業を、AIに移植していく、のが、NVIDIAの戦略です。

このCOSMOSとOmniverseが、AIロボット開発基盤に、世界中の研究開発者に使われるようになれば、NVIDIAのGPUは、未来永劫的に使われることでしょう。

実はNVIDIAが世界有数の企業になったのも、CUDA(クーダ)と呼ばれるAI(機械学習)の開発基盤を15年近くに渡り、ユーザー向けに提供してきたのが功を奏しています。

生成AIの世界でも同じ戦略を取ろうとしているところが、面白いですね。

ワールドモデルの学習

今回のCES 2025の発表で、NVIDIAは、AIモデル群Cosmosによって、ヒューマノイドロボットや産業用ロボット、自動運転車のトレーニングに活用できると語りました。

AIが「世界」を認識したら? 例えば、あらゆる「事故」や、100年に1度、1000年に1度といった大災害による被害のシミュレーションも可能になるでしょう。

例えば、自動車の運転をロボット(クルマ+AIのソフトウエア)に覚えさせるとします。でも、現実社会で、あらゆるシーンを学習させるのは大変なんですよね。

時速60kmで走行中に人が飛び出してきた場合、ハンドルを切る運転を学習するには、そのシーンを作って、実際にハンドルを切って、AI(クルマ)に挙動を学習させなければなりません。

これぐらいなら、何とか状況を作れそうですが、では時速100kmで人が飛び出した場合、人でなくクマが飛び込んできた場合、視界に入りにくいリスの場合、とか…

そういった3次元で起こりゆる、あらゆる事象を学習させるのがワールドモデルなのですが、今までは学習させるのが大変でした。

3次元のあらゆるシーンが、文字入力で作り出せる

しかし、最近の生成AI技術によって、3次元のあらゆるシーンが、プロンプトによって作り出せるようになりました。

例えば、「時速60km走ってる車の前に人が飛び出してくるシーンを作成して」と文字入力して、次に、「人」の部分を「リス」に置き換えてまたシーンを作り出す、ことが可能になりました。

これを合成データと呼びます。

合成データを生成AIで作り出すことが可能になってきたため、世の中のあらゆる事象を言語化して、ワールドモデル(これもAIのモデルですが)に学習させることで、ワールドモデルを開発できるのです。

学習データ(合成データ)作成専用の生成AIまでが登場しています。

ビジネスの現場では、例えば、倉庫内でのシミュレーションを通じて、ロボットが事故を認識し、適切に対応するための能力を身に着けることも可能になります。

高い能力を持つ、TESLAの「オプティマス」

でも、人間並みに動けるロボットなんて、未来の夢物語でしょ?思っているのなら、それは間違いです。実は生成AIが発展しているのと並行して、人型ロボットも凄まじい発展を遂げています。

昔は、「洗濯物もたためない」と言われてましたが、いえいえ、既に洗濯物を上手に畳むロボットは開発されています。

ほかにも、TESLAのオプティマスというロボットは、人のように動けるようになっています。ぜひ動画をご覧ください。このレベルまで、と驚くと思います。

早い思考と遅い思考をもつことで、人を遥かに超える、IQ140の脳を持ち、洗濯物を畳んだり、ポンポン玉をお箸でつまめるぐらい、手先が器用なロボットの登場は2年以内に実現することでしょう。

そんなわけで、AIロボットが同僚に

ここまで読んでいただき、だんだん、現実味が出てきたでしょうか。

SLACK上に登場するAIエージェントではなく、オフィスにリアルにいるロボットがAI脳を使って話をし、仕事を分担し、完結させる……。

「ロボット社員」というSF小説や漫画の世界が、本当に実現するかもしれません。

ところで、現時点では、NVIDIAの「Cosmos」のような、汎用性の高い「ワールドモデル」の開発に関する発表は行われていないようです。

しかし、この業界のことです。ある日、あっと驚くニュースが駆け巡ることになるかもしれませんね。