LLaMA 2 70BをWindows PCで実用的に動作させるためのスペックと値段

LLaMA(Large Language Model Meta AI)は、Meta社(旧Facebook)が開発した言語モデルで、LLaMA 2はその最新バージョンです。LLaMAシリーズは、特にパラメータ数と計算リソースのバランスを考慮し、効率的かつ性能の高いモデルを目指しています。

パラメータ数: 700億パラメータ

必要ストレージ容量: 約120GB(FP16形式)

相対性能(ChatGPT比): 約85%

特徴と技術的な詳細

計算効率: LLaMA 2はパラメータ数を抑えながらも、効率よく高精度の出力が得られるよう設計されています。高い計算効率により、BLOOM 176Bよりもリソースの少ない環境で運用可能です。

高いパフォーマンス: 特に推論性能において優れており、特定タスクにおいて高い精度を維持しながらも効率的に動作します。

トレーニングデータと最適化: LLaMA 2は、主に英語を含む一般的なデータセットでトレーニングされており、さまざまな自然言語処理タスクに対応可能です。

デプロイ可能な環境: LLaMA 2 70BはBLOOM 176Bほどの計算資源を必要とせず、VRAM 40GB程度のGPUがあればローカルPCでも動作可能。これにより、BLOOM 176Bよりも広範な環境での実装が可能です。

主な用途

自然言語生成と応答: カスタマーサポートや会話エージェントなど、自然な対話生成において有用です。

分析と推論タスク: 言語理解や要約、文章分類などの推論タスクにおいて、効率的かつ高精度な処理が可能です。

研究用途: Meta社の支援により、学術研究やプロトタイプ開発に向けて広く提供されています。

必要スペック

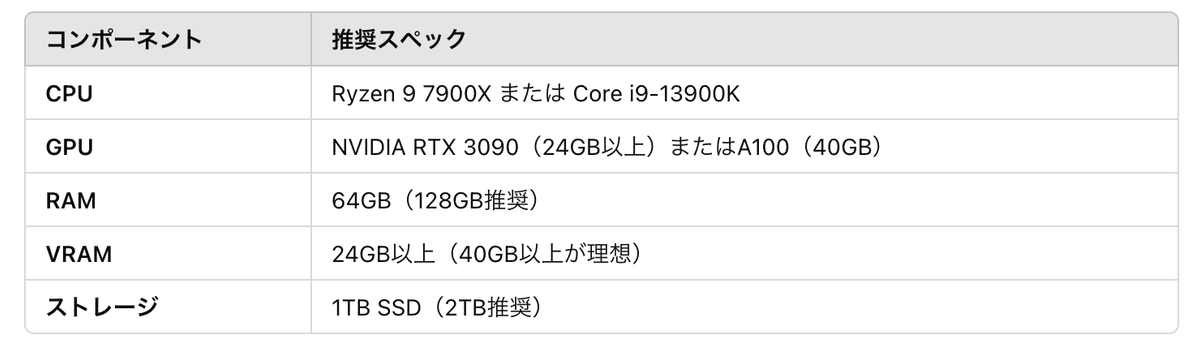

LLaMA 2 70BをWindows PCで実用的に動作させるためのスペックについて、以下のような構成が理想的です。

1. CPU

推奨仕様: 最新世代の高性能CPU(例: AMD Ryzen 9 7900X、Intel Core i9-13900K)

理由: 高いスレッド数とクロック速度により、モデルのロードや非GPUの計算部分でパフォーマンスが向上します。特に、データ処理や前処理・後処理部分での役割が重要です。

2. GPU

推奨仕様: NVIDIA RTX 3090(24GB VRAM)、RTX 4090(24GB VRAM)、またはA100(40GB VRAM以上)

理由: LLaMA 2 70Bはパラメータが700億と非常に多いため、VRAMが24GB以上のGPUが望ましいです。可能であれば、40GB以上のVRAMがあればより安定して動作します。

注意点: 24GB未満のVRAMでも動作は可能ですが、モデルの量子化や分割によるメモリ管理が必須になります。

3. RAM

推奨仕様: 64GB以上(理想的には128GB)

理由: Windows上でのモデルの実行には、モデルデータの一時保存やキャッシュにも大量のメモリが必要です。特に量子化したモデルであっても、一定のメモリ量が必要になるため、64GB以上を推奨します。

4. VRAM容量

推奨仕様: 少なくとも24GB(高負荷な用途には40GB以上が理想)

理由: パラメータ数が多いLLaMA 2 70Bは、VRAMにできるだけ多くのデータを保持することで、転送コストを抑えながら処理が可能になります。分割や量子化しても、24GB以上が最低ラインです。

5. ストレージ容量(HDD/SSD)

推奨仕様: 1TB以上のSSD(モデルファイルは約120GB、余裕を持つなら2TB推奨)

理由: モデルファイルのロード速度や推論のパフォーマンスを考えると、HDDよりSSDが推奨されます。120GBのモデルファイルに加え、関連するキャッシュやデータを保存するため、1TB以上の容量が理想的です。

注意点

分割実行・量子化: これらのスペックを満たしても、完全なモデルをそのまま動作させるのは難しいため、分割実行や量子化(FP16やINT8)を行うと、パフォーマンスの最適化が可能です。

モデルの最適化: Windows環境では、GPUリソースの利用効率を高めるため、モデルの最適化(Transformersライブラリやbitsandbytesなど)も併用することを推奨します。

価格

補足

価格の変動: 上記の価格は2024年11月現在のものであり、市場の状況により変動する可能性があります。

GPUの選択肢: RTX 3090は高性能ですが、予算に余裕がある場合はRTX 4090やNVIDIA A100などの上位モデルも検討できます。ただし、これらはさらに高価になります。

その他の費用: 上記にはOSや周辺機器(モニター、キーボード、マウスなど)の費用は含まれていません。これらも考慮する必要があります。

この構成であれば、LLaMA 2 70Bモデルをローカル環境で実用的に動作させることが可能です。ただし、モデルの量子化や分割実行などの最適化手法を併用することで、より効率的な運用が期待できます。

さて、LLMだけではなく画像生成系も2025年に向けて、個人PCへのインストールが実用射程距離に入ってきました。

↑ グレードに応じて、目安となるコストも算出しました。ご興味ある方はご参考ください。