ローカルLLMを動かすことができるOpen WebUIのインストール方法

Open WebUIは、ChatGPTみたいなウェブ画面で、ローカルLLMをOllama経由で動かすことができるWebUIです。

GitHubのプロジェクトは、こちらになります。

GitHub - open-webui/open-webui: User-friendly WebUI for LLMs (Formerly Ollama WebUI)

上記のプロジェクトを実行すると、次のような画面でローカルLLMを使うことができます。

このOpen WebUIは、OllamaでローカルLLMを動かしています。

Open WebUIのインストール方法は、DockerでOpen WebUIを起動させることになります。

前提あるOllamaをインストールしていない人は、こちらの記事でOllamaをインストールすることができます。

Ollamaがインストールされましたら、DockerでOpen WebUIを稼働させます。

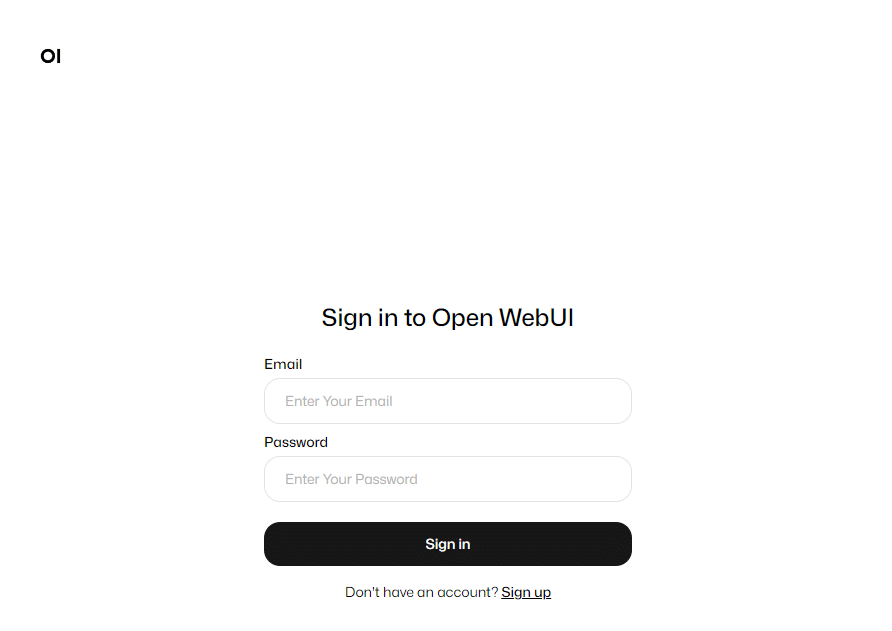

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main次に、http://localhost:3000/にアクセスすると、Open WebUIの初期画面になります。

最初は、アカウントがないので、Dont't have an account?のところにあるSing upに進みます。

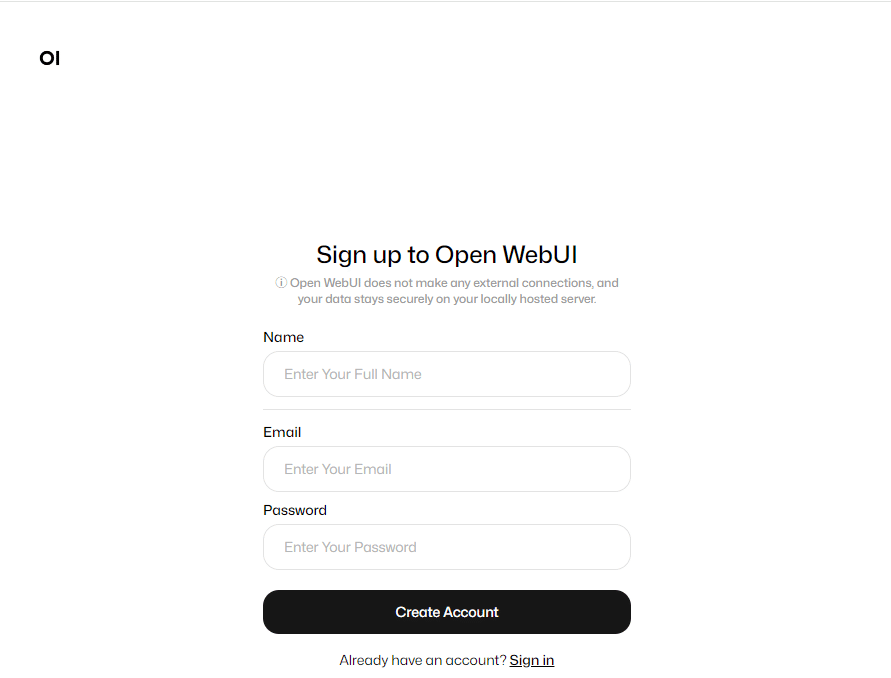

Name、Email、Passwordを入力して、Create Accountをクリックします。

はい、ChatGPTみたいなウェブ画面が出てきます。

上部にあるSelect a modelをクリックすると、Ollamaで既に利用しているローカルLLMが表示されます。

一度もOllamaでローカルLLMを動かしていない人は何も表示されないはずです。

今回は、phi3:latestのローカルLLMを選択すると、次のような画面になります。

今回は、Open WebUIのインストール方法の記事を書きました。ChatGPTと同じようなウェブインタフェースなので使いやすいです。気が向いたら、Open WebUIの画面の使い方の記事を書いてみたいです。