AI好きなら気になるOpen Interpreterのアップデートを眺めてみる

Open Interpreterがアップデートされていましたので、紹介します。

今回のOpen Interpreterのアップデートでは、3つです。

llama3-70Bがiオプション指定で手軽に使える

ollama3、Llamafile、LM Studio、JanでローカルLLMを取り扱える

ローカル画像を取り扱える

Open-Interpreterとは何?という人は、下記の記事で雰囲気を味わって頂けたらと思います。

今回のOpen Interpreterのアップデートは、ローカルLLMを使うことができるようになったということです。

ということで、先に進む前に、open-interpreterをアップデートしておきましょう。

pip install --upgrade open-interpreter今回、3つのポイントがあります。

llama3-70Bがiオプション指定で手軽に使える

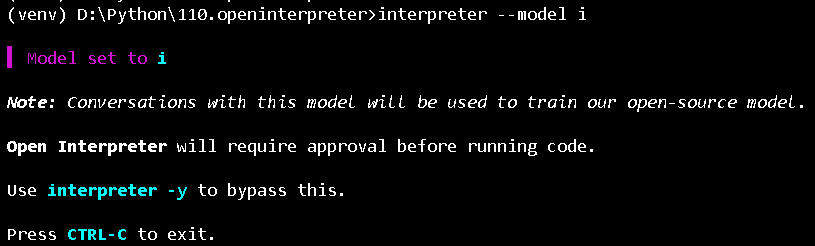

1つ目は、iオプションで、無料で700億パラメータのllama3-70Bを使うことができるということです。

interpreter --local i但し、このモデルの会話は、モデルの訓練データに使われると書いてありますね。

さて、この場合の実行結果を軽く見てみます。

ollama3、Llamafile、LM Studio、JanでローカルLLMを取り扱える

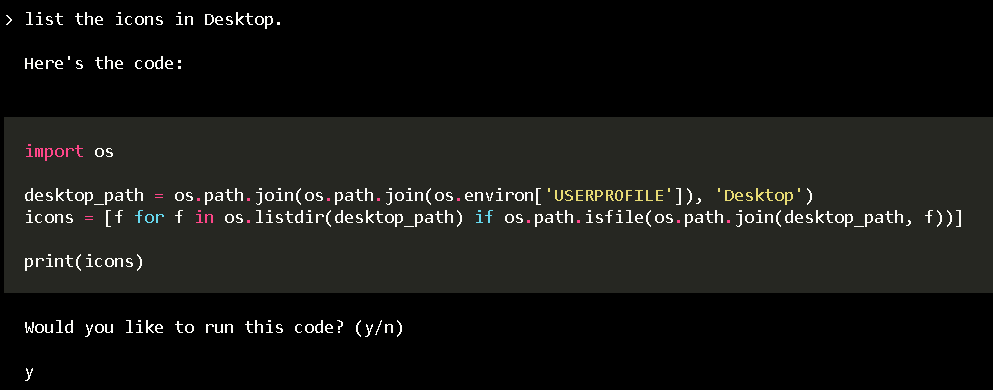

2つ目は、Open Interpreterは、ollamaを使えるようになりました。

つまり、ollama経由でOpen Interpreterは、ローカルLLMを使うことができます。

interpreter --localproviderで、ollamaを選択して、Enterをクリックします。

次に、modelでphi3を選択して、Enterをクリックします。

phi3モデルが読み込まれて設定されます。

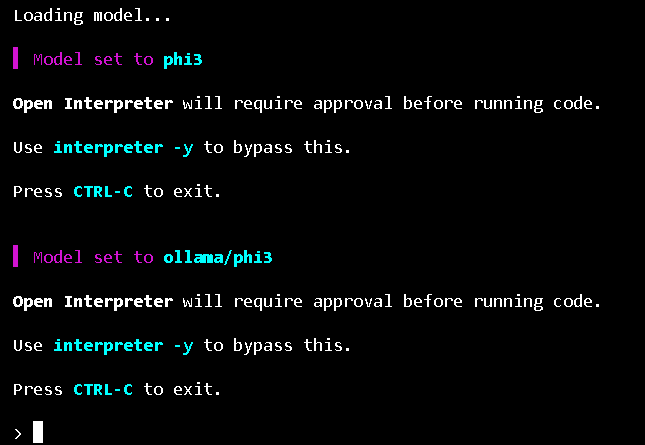

ついでに、phi3で、デスクトップアイコンの列挙を先ほどと同じようにしてもらいます。

今回は、ollamaを使用しましたが、他にもLlamafile、LM Studio、JanでローカルLLMを動かすことができます。

ローカル画像を取り扱える

3つ目は、Local VisionとLocal OSモードを活用すれば、マウスやキーボードを動かして色々できるみたいですが、私のパソコンのメモリでは限界でした。

moondreamというビジョンLLMを使って、Local OSモードを有効にすればキーボードやマウス操作ができるということみたいです。

所感

所感としては、Open InterpreterがローカルLLMを扱うことができるようになったのは良いです。

Copilot +PCの登場により、ローカルLLMを自PCで動かすことの新規性は奪われてしまいそうですが、今後どのように棲み分けていくのか、それとも、巨大IT企業に飲み込まれてしまうのかは気になるところです。