AI搭載PCのCopilot+PCでLM Studio

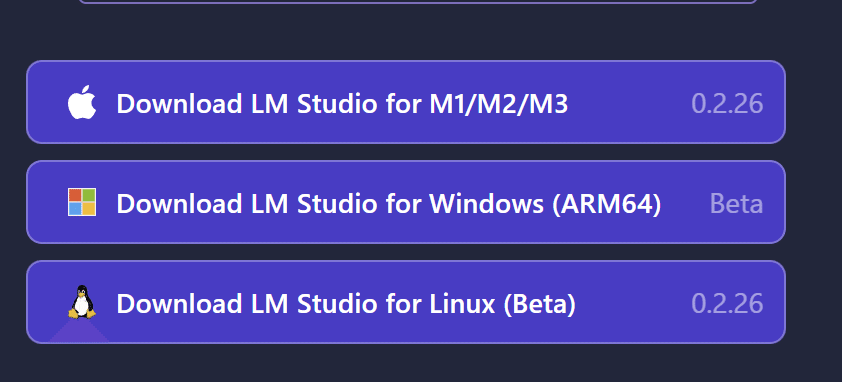

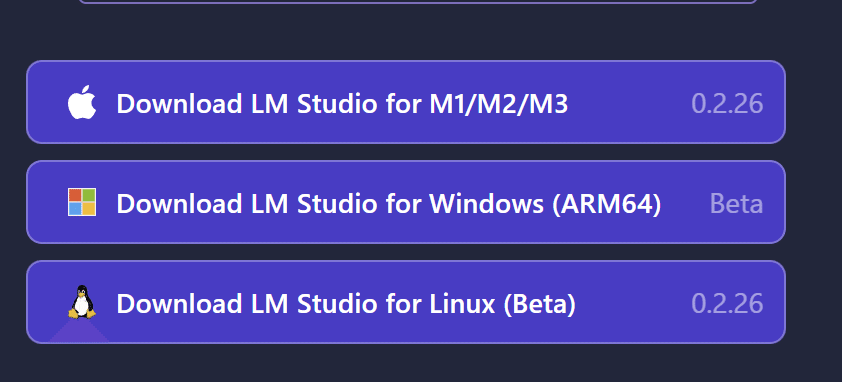

LM Studioに、ARM64用のLM Studioが登場していました。これは、AI搭載のCopilot+PCであるSnapdoragonで使えるということを意味しています。

真ん中に、Download LM Studio for Windows (ARM64)となっています。Beta版ということで最近リリースされたものだと考えられます。

早速、ダウンロードしてみます。

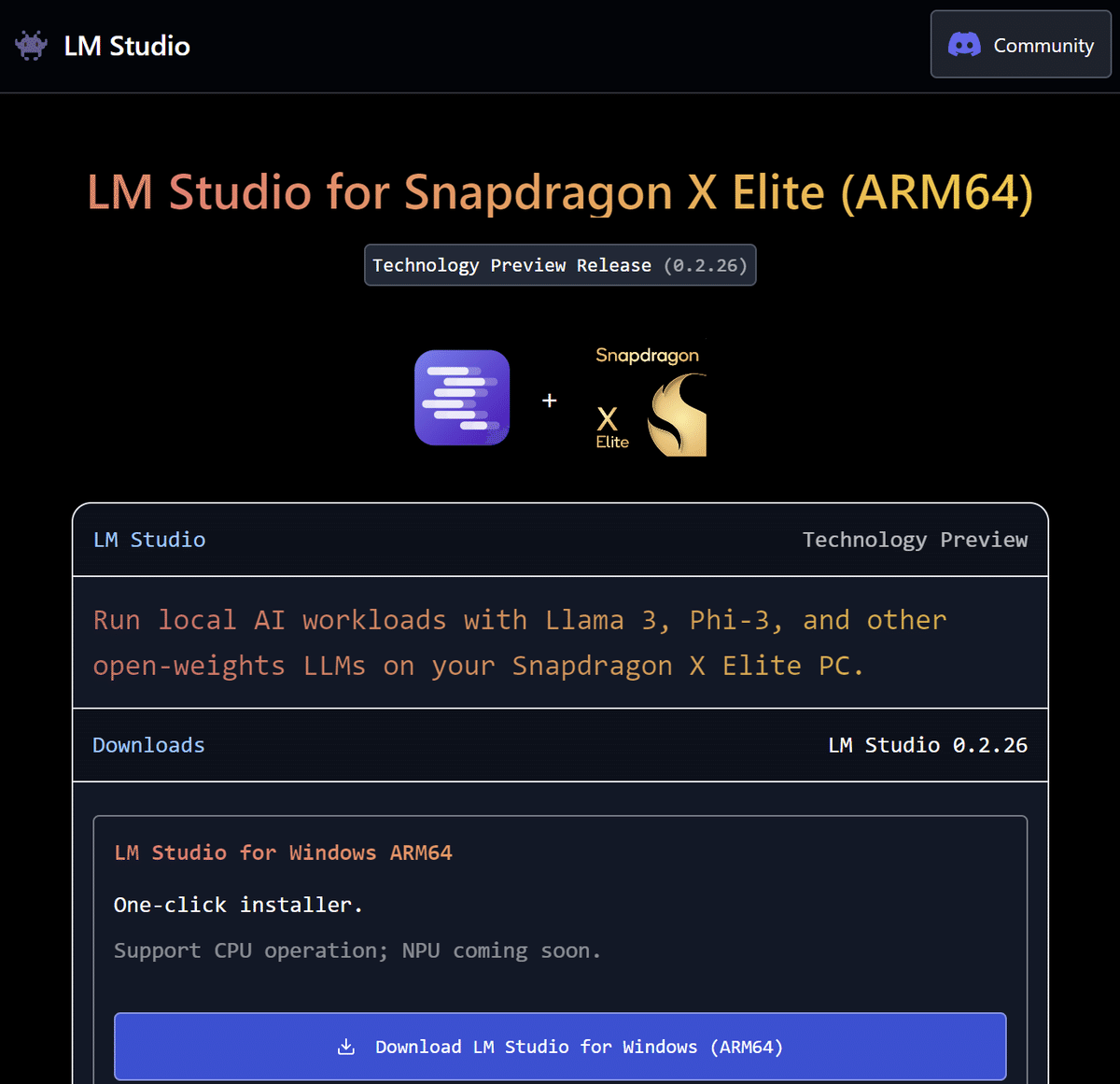

上記のページを開いたら、Download LM Studio for Windows (ARM64)をクリックします。

Snapdoragon X ELite用のLM Studioのダウンロードページが表示されたら、Download LM Studio for Windows (ARM64)をダウンロードします。

ダウンロードが終了したら、exeファイルを実行していけば完了となります。

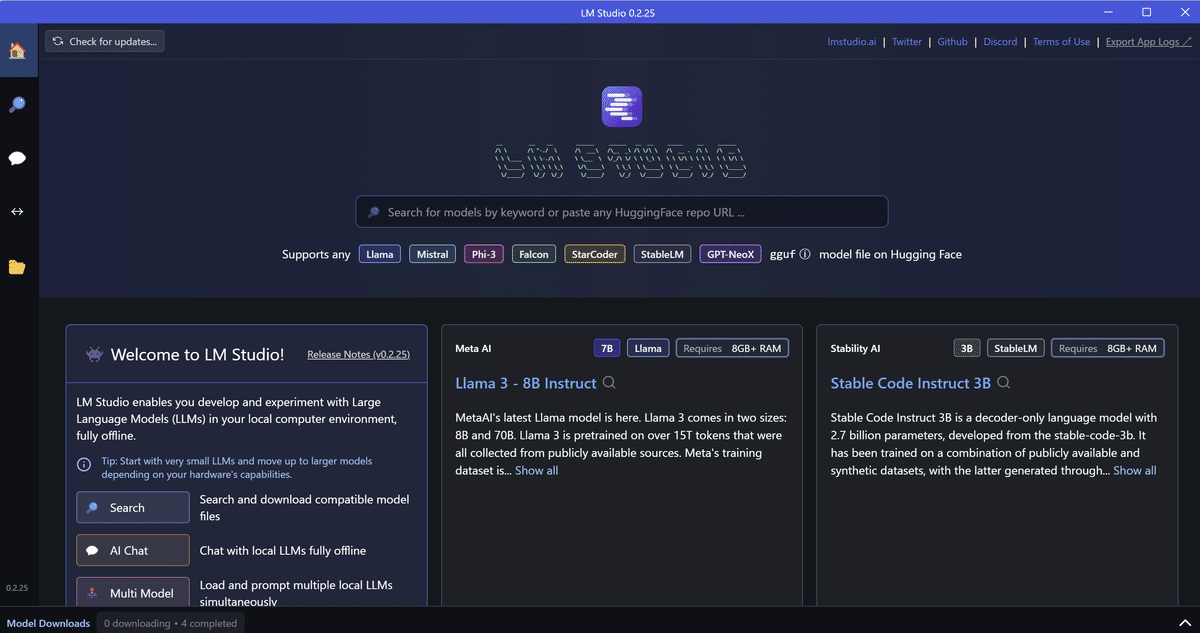

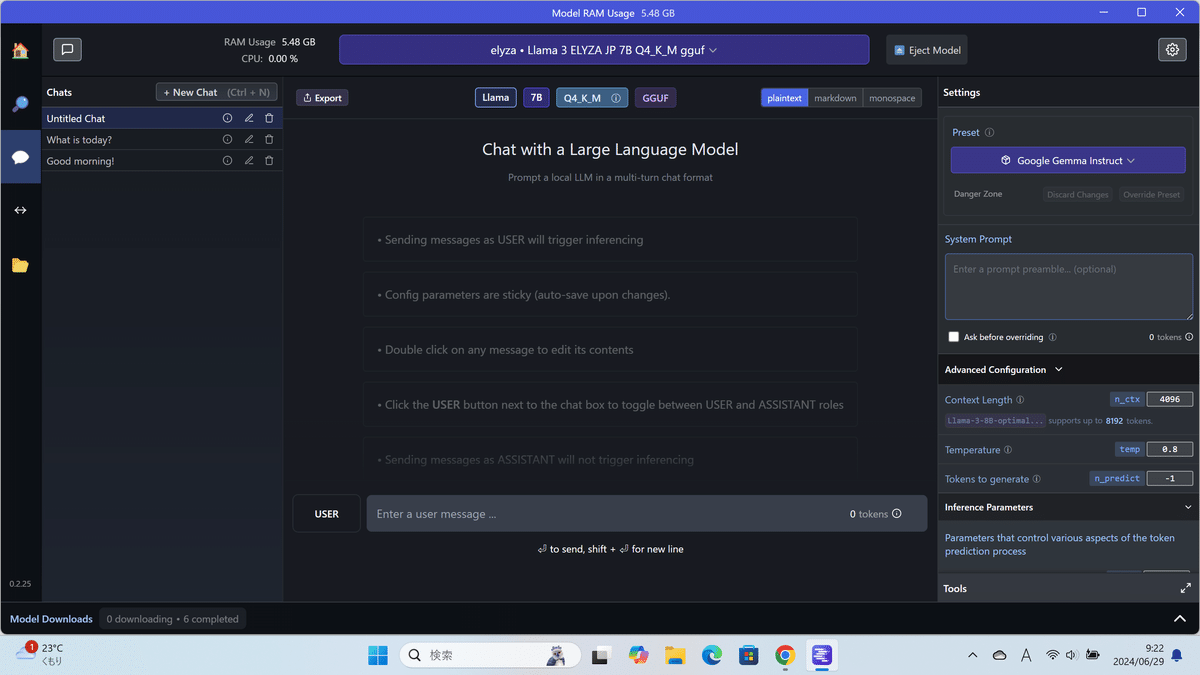

LM Studioを起動すると、次のような画面になります。

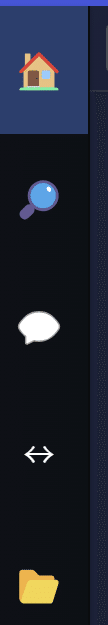

簡単に、左の家マークから説明します。

家マークは、ホーム画面で、虫眼鏡マークで使いたいLLMを探し、吹き出しマークでLLMを実行し、矢印マークでAPIサーバを立てて、フォルダマークでダウンロードしたLLMを確認できます。

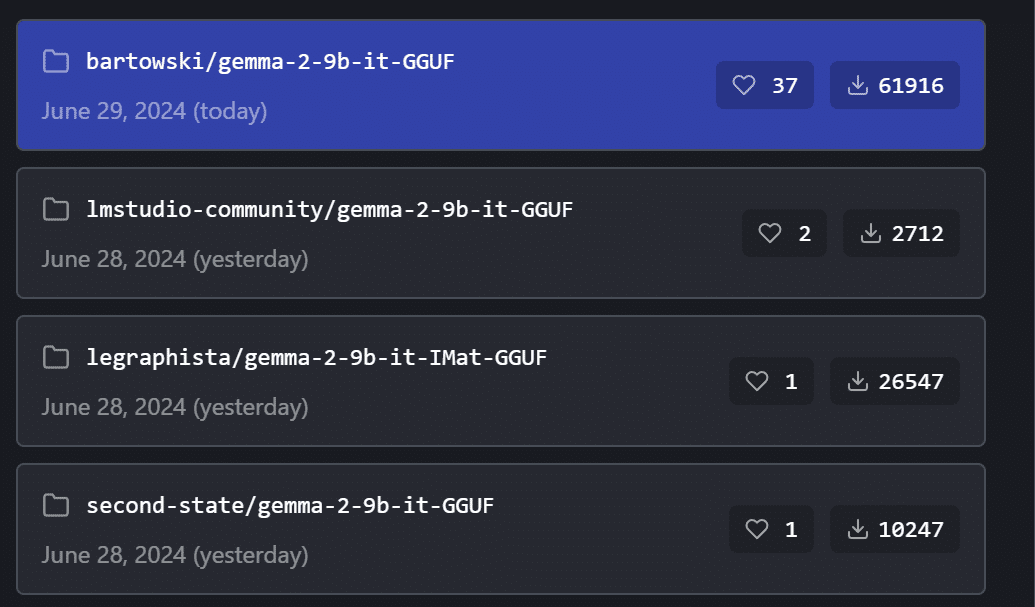

では、虫眼鏡マークでLLMを探してみますので、虫眼鏡をクリックします。

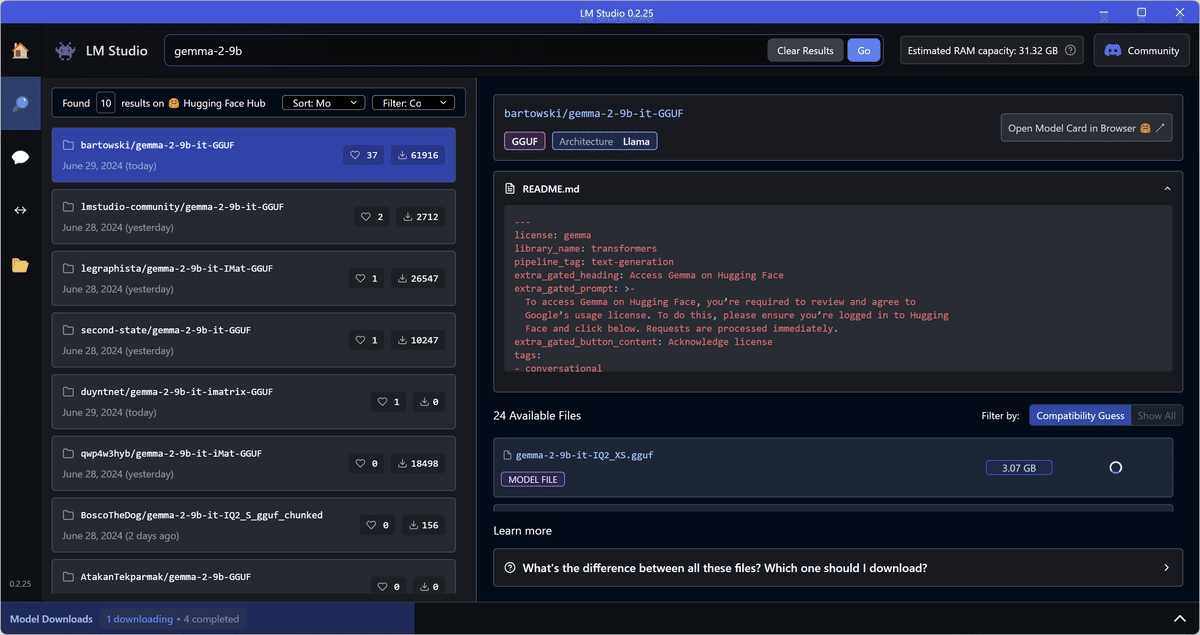

上記のように、画面上の入力フォームに、探したいモデル名の一部を入力して、Goボタンをクリックします。

ダウンロード候補のLLMが左に表示されますので、気になるモデルを選んでみてください。

次に、右画面のDownloadをクリックします。

LLMのダウンロードが始まると、LM Studioの画面下にダウンロード状況が表示されます。

ダウンロードが完了しましたら、LLMを使ってみます。左側の吹き出しマークをクリックすると、次のような画面が出てきます。

画面上の「Select a model to load」をクリックして、ダウンロードしたLLMを選択します。今回は、Elyzaを使ってみます。

ELYZAがロードされましたら、一番下あたりにある入力フォームに、何か書いてクリックします。

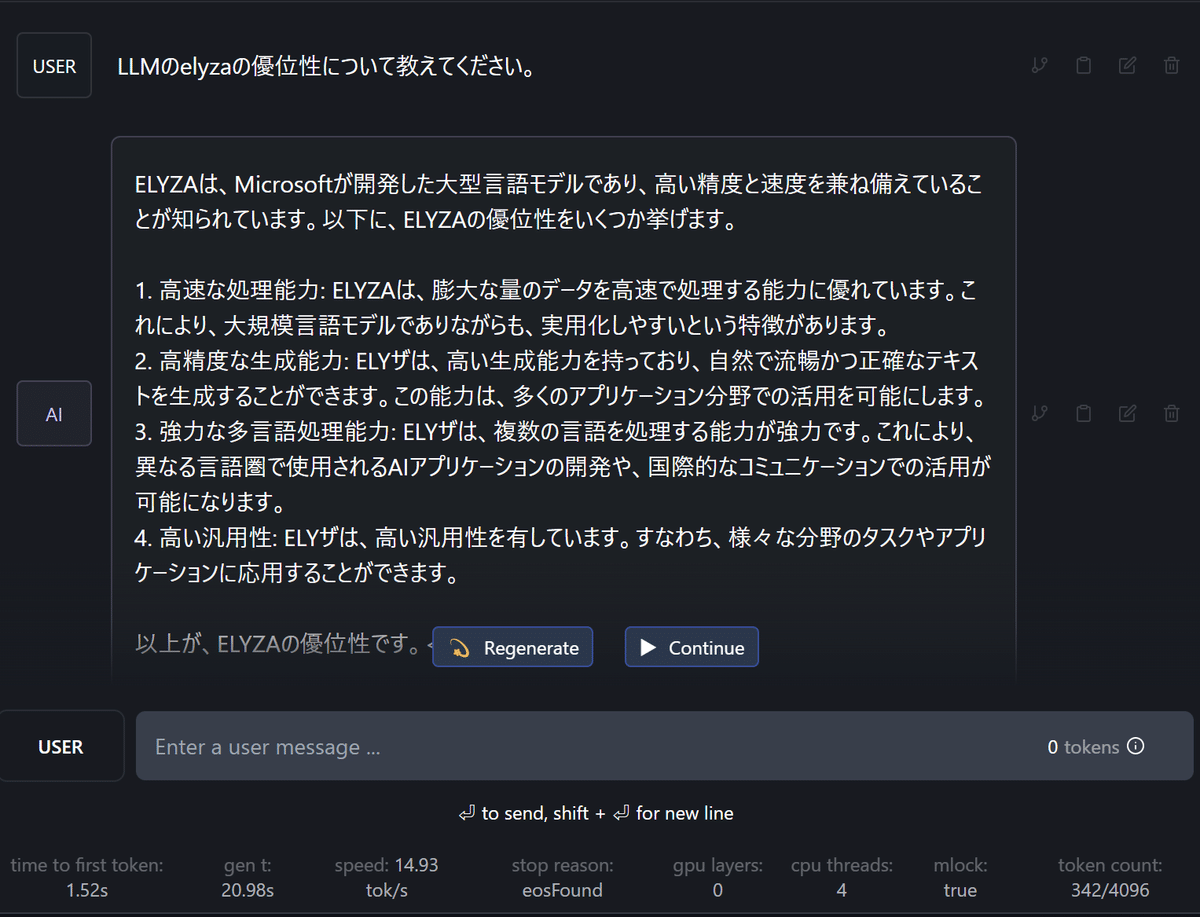

ChatGPTみたく質問と回答が出力されます。また、画面下には、最初のトークン生成までの時間や、生成時間、1秒あたりのトークン生成スピードなどが出力されます。モデルの比較には良い数値となります。

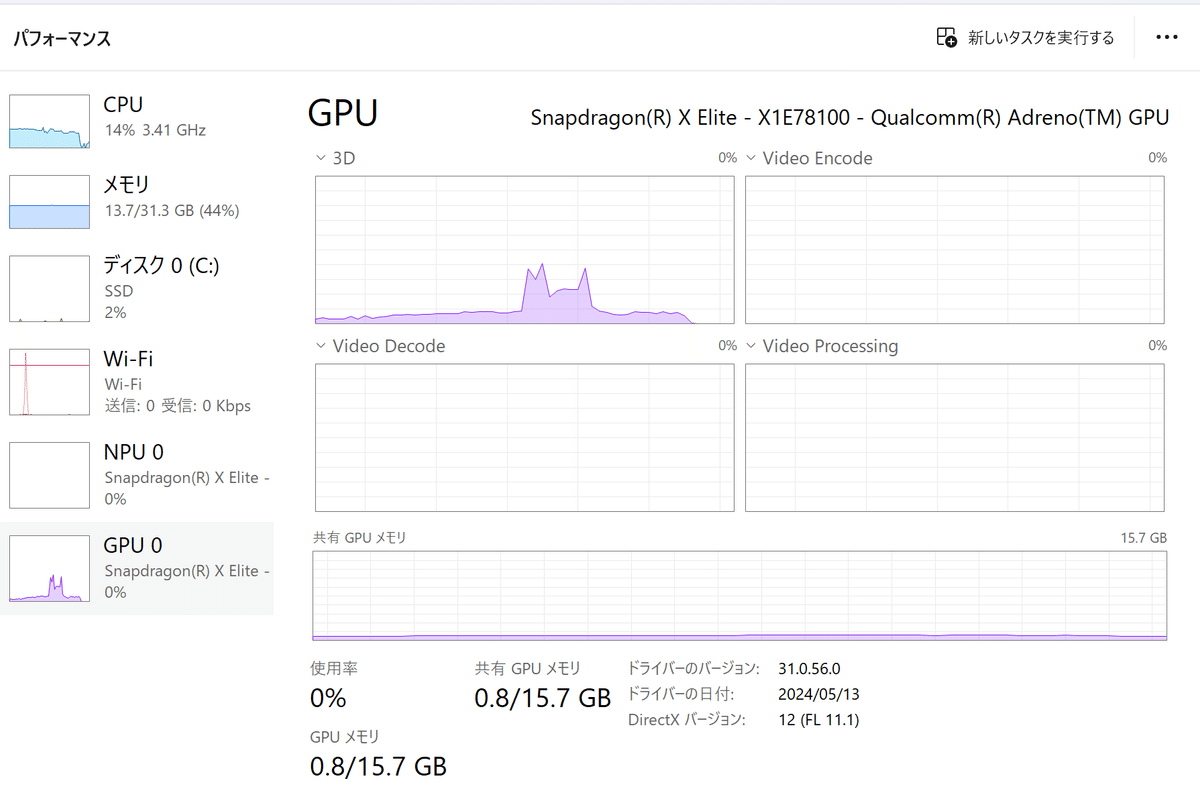

ちなみに、NPUは全く使われていないです。

所感として、ARM64でもLM Studioが使えるようになったのは良かったです。つまり、最近発売したSnapdoragon利用のCopilot+PCでもLM Studioが動くはメリットが大きいです。LM StudioはローカルLLMを動かすものですので、ローカルLLMが本質であるCopilot+PCで使えるというのは時流に合っている気がします。

まだ、NPUは使われていないですので、そのうちアップデートでNPUも使えるようになることを期待しています。

また、Elyzaのように日本語のLLMも出てきておりある程度実用性に耐えられるようにも見えますので、スタンドアローン型のLLMを動かす環境として今後、LM Studioが流行っていくのかと考えられます。