GoogleのGemini, OpenAIのGPTs, etc - Generative AI 情報共有会 #12

今週、12月12日(火)にZENKIGEN社内で実施の「Generative AI最新情報共有会」でピックアップした生成AI関連の情報を共有します。

この連載の背景や方向性に関しては 第一回の記事 をご覧ください。

Google、Gemini発表

衝撃的なデモ(と実際のところ)

かなり衝撃を持って迎えられたデモ動画。

しかし、デモはかなり誇張という見方が強い。

Googleから公開された How it’s Made: Interacting with Gemini through multimodal prompting を見ると個人的にもそう思うところが多い。

デモは全て動画と音声で行われていたが、上記ブログ記事では入力は全て画像とテキスト、出力も画像とテキスト。

ブログ記事で記載されている、実際のタスク設定をいくつか紹介。

じゃんけん

デモ動画では人間側は何も話さずじゃんけんの手を示し、Geminiが "I know what you're doing! You're playing Rock, paper, Scissors."(「何をしているのかわかりますよ!じゃんけんをしていますね!」) と出力(テキストと音声で)している(ように見える)。

ブログ記事では、3枚の画像とともに「何をしていると思いますか?ヒント:ゲームです。」というプロンプトを与え、Geminiに回答させている。

カップシャッフル

デモ動画では人間側は何も話さず3つのカップのうち一つに丸めた紙を入れている。するとGeminiが "You are trying to get me to find the paper ball under the cup. I accept the challenge."(「カップの下にある紙のボールを見つけさせようとしていますね。挑戦を受けましょう。」) と出力し、意図を理解(しているように見える)。

そして、人間側がまあまあ素早くカップをシャッフルしたものに対し、Geminiが "The cup to the left."(「カップは左です。」) と正しい回答(テキストと音声で)をしている(ように見える)。

ブログ記事では、テキストと画像の入力によるシンプルなタスク設定となっている。

設定のプロンプトを与える。

Instructions: There are three cups in position 1 (left), position 2 (middle), position 3 (right).

Instructions: 位置 1 (左)、位置 2 (中央)、位置 3 (右) に 3 つのカップがあります。

最初のボールの位置を伝える。

Starting position: The ball is in position 3.

Current state: empty, empty, ball

スタートポジション: ボールは3番の位置にあります。

現在の状態: 空、空、ボール

few-shotで、カップに手を添える画像、手を交差させる画像、最終状態の3枚の画像を入力し、何番目と何番目を入れ替えたか("Swap: 2 and 3")と現在の状態(""Current state")の正解を与える。

Geminiに新たな画像を与え、何番目と何番目を入れ替えたかと現在の状態を回答させる。

絵に描いた楽器

デモ動画では、人間が描いた楽器の絵を認識し、その楽器の音を生成出力している(ように見える)。

ブログ記事では、手書きの楽器画像の入力に対し、サントラの検索クエリを出力させているのみ。

ステップ1. この絵を見て、描かれているものをすべて説明し、良い音楽サントラのジャンル、ムード、サウンドトラックについて、楽しく具体的なアイデアを考えてください。

ステップ2. 検索クエリを入力してください:"検索 [クエリを挿入]"

Gemini:

ギター、ドラム、アンプの絵。ヤシの木もある。楽しく、明るく、トロピカルなムード。ジャンルはレゲエ。南国を舞台にした映画やテレビ番組のサウンドトラックに使えそう。

検索 "Reggae music for a tropical vacation"

Gemini Technical Reportの概要

デモに関して若干ネガティブな紹介の仕方をしたが、公開されたGeminiのTechnical Reportを見ると、マルチモーダル性能はかなり高いことがわかる。

掻い摘んで紹介。

https://storage.googleapis.com/deepmind-media/gemini/gemini_1_report.pdf

モデル

3つのサイズのモデルを開発。32kコンテキストをサポート。

Ultra : 最も高性能なモデル。推論タスクやマルチモーダルタスクを含む、非常に複雑なタスクの広い範囲にわたって最先端の性能を発揮。

Pro : コストとレイテンシの観点から性能を最適化したモデルで、幅広いタスクで大きな性能を発揮。

Nano : オンデバイスで動作するように設計された最も効率的なモデル。1.8Bと3.25Bの2モデルがある。

評価

[テキストベースのタスクでの評価]

様々なベンチマークでGPT-4を上回り最高性能。MMLUでは初めて人間の専門家のスコア(89.8%)を上回ったことで話題になっている。

Technical Reportでは、ベンチマークでの公正な評価はリークの問題などで困難が常に付き纏うことが述べられている。

多言語性能でも高性能。MSGM, SLsum, Wikilingua 全て日本語も含まれる。

[画像を含むタスクでの評価]

様々なベンチマークでGPT-4Vを上回り高性能。

画像とテキストを組み合わせたマルチモーダル例 :

生徒の手書きの回答に対して、正しい解答かの判定、誤答の場合何が間違っているかと正しい解き方の説明、LaTexを利用しての数式の記述を行なっている。

[動画理解のベンチマークでの評価]

ビデオクリップからサンプリングした等間隔のフレームを入力としてタスクに取り組む設定。これまでのSoTAを上回り最高性能。

動画とテキストを組み合わせたマルチモーダル例 :

[音声認識ベンチマークでの評価]

全ベンチマークで高性能。小さいモデルであるGemini Nano-1でもWhisperを上回る。

FLEURS, VoVoST2は日本語を含む。

FLEURSについては、Geminiの学習データ内に含まれているのでGeminiがかなり有利と記載されている。ただ、FLEURSを除いたGeminiモデルでもWER=15.8でWhisperを上回るとのこと。

Gemini Ultraではまだ評価していないとの記載。

画像と音声を組み合わせたマルチモーダル例 :

社内共有会ではざっと掻い摘んで紹介をしましたが、より詳細にまとめられた日本語記事も公開されており、参考になります。

GPTs

現在、社内では業務効率化や事業へ結びつけるためのGPTs提案・作成の企画が走っており、私が主に非技術者向けに作り方のサポートを担当しています。

その中で、GPTsにおいて少々わかりづらいKnowledgeとActionsについて簡単に使い方を紹介する内容を今回の社内共有会で入れました。

Knowledgeの使い方

csvなどのファイルをアップロードし、その内容を元に回答させることができる。

Knowledgeを使ったGPTを作ってみる(子育て支援FAQチャットボット)

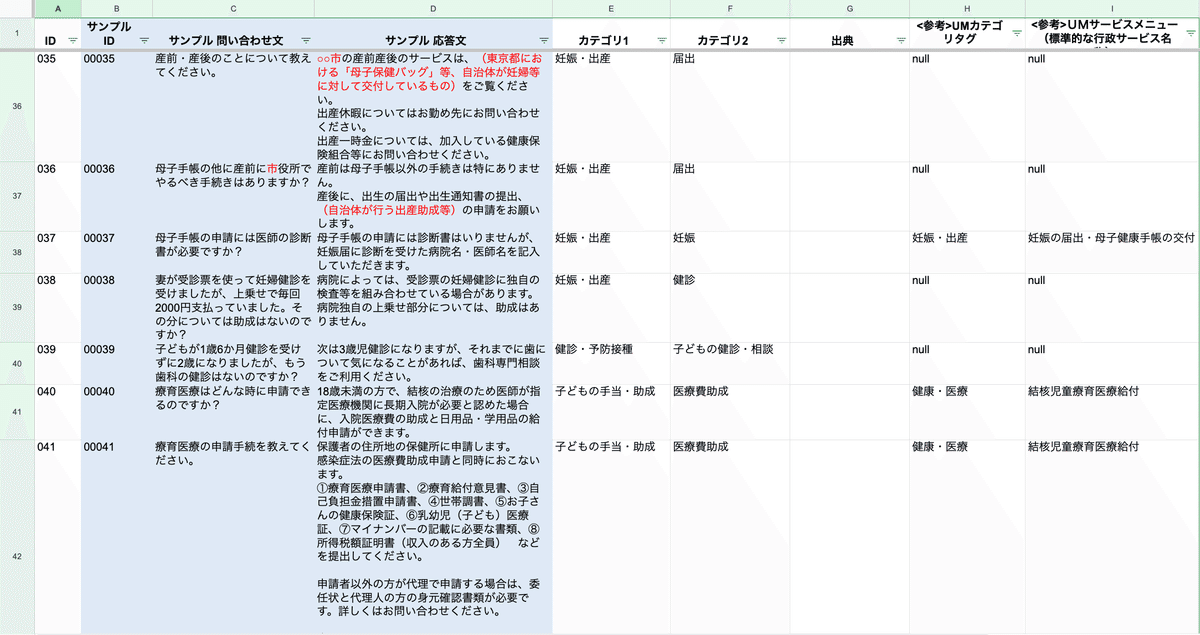

今回Knowledgeにアップロードするデータ:

具体的な自治体名は空白になった子育てにおいて想定されるFAQ想定集。(これだと実際には使い物にならないがデモ用ということで…)

このデータを元にしたGPTを作成。

1. ファイルアップロード

2. Instructions設定

3. csv内のデータを検索するために「Capabilities」の “Code Interpreter” をONにし、Web Browsing をOFF(csvの内容を元に回答して欲しいので、Web検索禁止)、画像生成は必要ないので ”DALL-E Image Generation” をOFF。

完成!(https://chat.openai.com/g/g-gSf6JuotF-zi-yu-tefaq)

Actionsの使い方

外部APIを呼び出し、その内容を元に回答を生成できる機能。

Actionsを使ったGPTを作ってみる(猫を拝めるGPT)

社内共有会では実際にGPTを作成しながら解説を行いましたが、行ったことは以下の記事の内容とほとんど同じなため、ここでは記事の共有までとさせていただきます。

終わりに

少しでも弊社にご興味を持っていただけた方は、お気軽にご連絡頂けますと幸いです。まずはカジュアルにお話を、という形でも、副業を検討したいという形でも歓迎しています。