人工知能と人間のコーチング、どう違う?どっちがいい?

もはや知らない人はいないであろうchatGPTに、「誰にも言えない悩みを相談してみた」という方は多いのではないでしょうか。

「コーチングをして」とリクエストすれば、しっかりとフォーマットに沿ってコーチングをしてくれます。自分の考えを押し付けることもなく、的確な内容が返してくれます。おそらく、基本の関わりのみを身につけた経験の浅いコーチと比べれば、人工知能はよっぽど安定したコーチングができるようになっています。

値段が高くてコーチングの利用を迷っていた方がおられるとしたら、chatGPTに「現状整理のためにコーチングして」とか「目標設定のためにコーチングして」とか「今悩んでるところから一歩踏み出したいからコーチングして」などと話しかけるだけで、それなりのコーチングを受けることができますし、おそらくコミュニケーションが苦手な上司よりはずっと良い壁打ち相手になってくれるはずです。

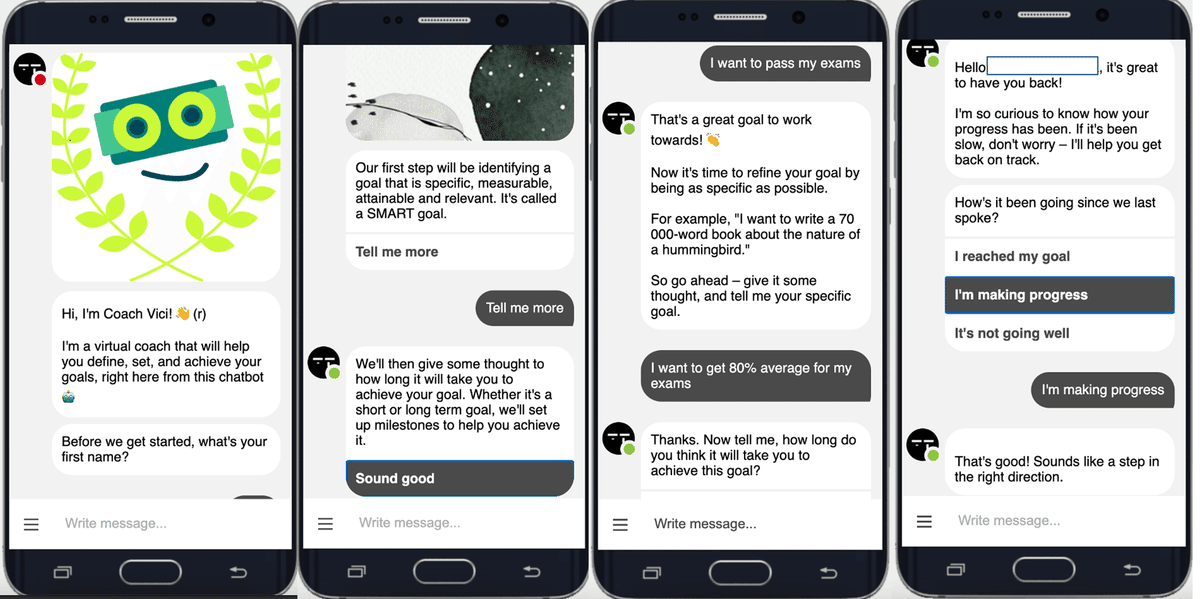

人工知能のコーチングの効果で言うならば、chatGPTと比べれば見るからにレトロな選択肢型の対話ベースの人工知能と人間のコーチングの「効果」は、変わらなかったという研究結果がすでに出ています。

Surprisingly however, the AI coach was as effective as human coaches at the end of the trials.(人工知能のコーチは、最終的に人間のコーチと同じくらい効果的であった)

もちろん測定された効果は、実際には多面的なコーチングのもたらす影響のごく一部であるとはいえ、この時点でのチャットbotでそれだけの効果があるのなら、chatGPTは間違いなく人間を超えてくる効果を持ちうるのでは、と思わされます。これまでにもたくさんの研究者や起業家がこのようなチャットbot型のカウンセリングやコーチングツールを開発しようとアルゴリズムを練ってきたわけですが、もはや世界が違います。

それでも、人間にしかできないことがある。きっと人間のコーチはそう思いたいはずです。共感?直感?つながり感?

受ける側の体験から考えれば、人間にしかできないこと、は存在しない

結論から言うと、例えばAIが主体として実際に共感しているかどうかは定義によるとして、「受ける側の体験」の観点から捉えるのであれば、「共感されている」と感じる反応を返すことはできるように思います。正直なところ「人間にしかできないこと」は存在しないのでは、と感じています。

ただ、現時点では「人間の方が上手にできること」と「人間がおこなったほうが効果的にはたらくこと」は存在します。現時点で人間の方が上手にできることは、将来的に人工知能が追いつき、追い越している可能性もありますが、「人間がおこなったほうが効果的にはたらくこと」は残り続ける、ということはできるかと思います。

こんなふうに整理してみました。

共感的な反応

その最たるものが「共感的な反応」です。AIに悩みを相談するとまずは「それはつらかったですね」と共感的な反応が返ってきますから、AIが共感的な反応が「できない」わけではありません。もちろん、実際に感情が動いているかというと、感情の定義にもよりますが、感情のパラメーター的なものは存在しているように思えますし、話し手の感情をある程度察知することもできています。

ただし、人間の側が、「人工知能には感情がないはずである」という信念を持っている限りは「この共感的な反応は、本当の共感によるものではない」という推論がはたらいていることになります。それ自体が人工知能の持つハンディキャップとなるため、この推論が有効である限りにおいては、承認は「人間のほうが得意なこと」であり続けるはずです。

承認・フィードバック

「できるようになったんだね!」「あなたの強みが発揮されてるね!」などの承認や、「目標と違う方向に向かってる感じがするね」などのフィードバックも、同じように人間がおこなったほうがポジティブにはたらく可能性がある行動です。

それは、承認・フィードバックが上手かどうかということよりも、人工知能による承認・フィードバックは「情報」という側面が大きいのに対し、人間によるフィードバックは「主体を持った他者の肯定的関心・勇気づけ」という側面が大きいからです。

「主体」が前提となるという意味でへは承認・フィードバックは「誰が言うか」もとても大切です。尊敬している師匠に「成長したね」と言われるのと、通りすがりの人に「成長したね」と言われるのは、生み出される価値が全く違います。

そういう意味ではコーチ相手でも「このコーチに言われると嬉しい!」と感じるコーチと「あなたに言われても」と思ってしまうコーチは存在するわけで、「相手がこの人だから、嬉しい」といった存在であれるかどうかは、まさしく「人間性」のなせることであり続けるのかもしれません。

もちろんこのあたりも、人工知能側では「このアルゴリズム厳し目のツンデレbotが褒めてくれた…!」みたいな承認のあり方も生まれてくるはずで、人間には持たない価値をbotが持ち始める、ということを十分に起こり得ることです。

非言語情報の察知

非言語情報の察知は、現時点では人間の方が得意なことです。表情・ジェスチャー・沈黙・におい・温度などの、言葉にならない「その場に流れるもの」は、現時点ではまだ、chatGPTが感じとることはできません。

ここから、カメラがついたり、音声解析がついたりして、人工知能がどんどん進化していく部分でもあると思います。

完全に人間に追いつくかどうかは別として、時系列での非言語情報の変化などは、人工知能のほうが得意になる場面も出てくるかもしれません。

扱える現実レベル

言語・非言語は察知するチャンネルの話ですが、もうひとつ、「3つの現実レベル」という観点もあります。

「こんなことが実際に起こった」というような合意的現実については、人工知能も人間も同様に扱うことができるようになるかもしれません。一方、その裏側にある想いや願い、感情や葛藤、そしてさらに深いところに流れる「本質」については、現時点では人間のほうが上手にできる、より正確に言えば「上手にできる人がいる」「できない人は全然できない」という、人間の中でも差がある世界だと思います。

このあたりは言語化されることが少ない分、人工知能にとってはデータ化して学習することが当面は困難であり続けると思います。ただ、これは人間であってもうまくできている人は限られており、かつ無意識のバイアスも関わってくるために、それがもとでトラブルになることも多い領域です。どちらが圧倒的にうまくできる、という話ではないのかもしれません。

問いかけ

「問いかけ」のスキルは現時点でも「人間が圧倒的に上手」とは言いがたいように思います。人工知能は、圧倒的なデータ量をもとに良い質問を捻り出してくる。例えば、キャリアに悩んでる人にはこんな問いを投げかけたらいいよね、というのを熟知しているので「キャリアの相談をしたい」と言えば、それに役立つ問いを100個一気に出すことができます。

人間が生み出す良い問いは、データや理論に基づくというよりも、直感や、複数の観点をつなぎあわせたもの、ということになるかもしれません。

問いかけは思考のきっかけなので、人間からであろうと人工知能であろうと機能は変わりません。ただ「この人が聞いてくれるから答えたい」という気持ちや「承認してほしいから答えたい」などの気持ちは対人間のほうが生まれやすいのではないでしょうか。ここでも、そこに主体があるという認知自体が重要になります。

タイムリーな反応・知識の提供・情報の保存

これらは、明確に人工知能のほうが上手なことです。

例えば、緊急性の高い相談にタイムリーに反応する。コーチングを受けながらキャリアに関する知識を提供する。過去に言ったことは全て覚えておく。

これらは全て、人間には限界があることです。そしてむしろ、これらは人間が満足しやすい反応でもあり、これらをもって圧倒的に「人工知能のほうがいいね!」となってしまうことも十分ありえます。

秘匿性の高い相談

たとえば、人に言えない人間関係の相談、失敗体験、苦悩など、「人に言ったらどう思われるだろうか」が不安で話せないような内容は、むしろ人工知能でないと受け取れない相談です。

知っている人には言えない、知らない人であっても人間には言えない、でも人工知能なら、恥ずかしくないし正直に自己開示できる。そういう悩みの領域というのが存在しています。

これは、むしろ「AIにしかできないこと」でもあるのかもしれません。そして、これも、人工知能によるコーチングを圧倒的に優位にさせる要因でもあります。

人は、葛藤や苦悩を開示し、問いかけを受けることで、それに関する捉え方が深まり、思考が変化し、感情が変化します。まずは自己開示することができる、ということが大きなハードルになっているのです。これを人間のカウンセラーやコーチは、傾聴したり承認したりして安全な関係を生み出したりして信頼関係を生み出すことで乗り越えてきたわけです。

人工知能によるコーチングは、そもそも自分に対する批判的な目が向けられない場となりうるという意味で、非常に価値があります。

依存を生み出すリスク

ただ、ここにはリスクもあります。カウンセリングやコーチングといった関わりは、受ける人の主体性を育むことを目的としています。ですから、頻度や時間についての「構造」をとても大切にしています。けれど「いつでも相談できる、なんでも聞けば答えてくれる」という状況がつくられてしまえば、それは明らかな依存を生み出してしまいます。

「依存」とは何か、といえば、その人の力を奪ってしまうことです。

「chatGPTが出てきてから、考えなくなった」という方はおられるのではないでしょうか。もちろん、聞けばすむことを聞くのはとても意味のあることです。でも、そうしているうちに解くべき課題がなくなって、葛藤することができなくなる、困難な課題と向き合う耐性がなくなる、ということは、将来的に十分に考えうることです。

「chatGPTに頼った分、自分はもっとクリエイティブなことに時間と能力を使える」という状態が理想ですが、人間は苦しいときにしっかりと向き合って自ら解決策を生み出したり乗り越えたりしたときに最も成長するのも事実です。困難な時には力を発揮できるけど、クリエイティブなことはなかなかがんばれない、という人もいるかもしれません。

また、人工知能のようなスピード感や豊富な知識を、他の人間が持っているわけではありません。そうしたときに、人工知能のわかりやすい価値を人間と比べたときに、「人間とつながる意味」はどのように変化していくのでしょうか。

2次元のかわいいキャラクターに没頭している人が、生身の人間に魅力を感じなくなってしまうこととも似ているかもしれません。

おわりに

先日、あるサービスのチャットによるカスタマーサポートを受けていて、相手がアルゴリズムなのだと思い込んで機械的に対応していたら、途中で相手は人間の担当者だったことがわかって申し訳ない気持ちになって焦った、という出来事がありました。

これだけ、人工知能が日に日に進化していく中、

「人工知能が人間のように思えてくる」

「人間が人工知能のように思えてくる」

いずれも、十分に起こりうることであると感じます。

不気味の谷を乗り越えたCGあるいはアンドロイドが、人工物であると知らされないままにzoomで現れて、完璧なテキスト読み上げと高速な反応で会話ができたら?そこに、人間のように不安定で有限性のある知識と反応のアルゴリズムがインストールされていたら?

そこでは、人は相手に「主体」を感じてしまうであろうし、「人格」を見出すであろうし、それによって励まされたり、癒されたりするはずです。

そして、今、それぞれの技術はすでにかなりのレベルまで来ており、これかも進化し続けることが目に見えている。

「人間にしかできないことがあるよね」と簡単に言える時代ではなくなりました。人工知能と住み分けて競おうと思えば、それは脅威にも思えるかもしれません。でも「人間が、人工知能によってさらにその可能性が拡張される」と考えるならば、それは実に大きな希望です。

その意味では、「人工知能と人間のコーチング、どっちがいい?」という問い自体が、あまり意味を持ちませんね。人間のコーチが、人工知能を活用しながら、自らのコーチング力を拡張していく。受ける側は、人工知能ですむときには、人工知能のコーチングを受ける。これがこれからのコーチングのあり方です。

人間が人工知能をいかに使って、可能性を広げていくことができるのか、が問われる時代です。そのためには、人工知能に依存して力を奪われてしまわない強さも必要なのだろうと感じます。