AIの安全利用を支える新たな国際規格『ISO/IEC 42001』の発行|AIシステムのリスク管理と信頼性向上を目指して

ISO/IEC 42001の発行

日々の生活の中で、AI技術に触れる機会が増えています。AIはますます私たちの生活にさらに深く根付いていくことが予想されます。しかし、この急速な技術の進展に伴い、AIシステムの安全性や信頼性に関する懸念も高まっています。そんな中、AIシステムの安全かつ安心な利用を目指す新たな国際規格「ISO/IEC 42001」が2023年12月18日に発行されました。この記事では、この新規格がどのような影響を与えるのか、その背景と内容、期待される効果について詳しく解説します。

背景

AIが日常生活の様々な場面で使われるようになる中で、AIシステムが適切に管理されることの重要性が増しています。このニーズに応えるため、ISOとIECは共同でAIマネジメントシステムの国際規格を作成しました。この規格は、AIシステムの開発、提供、使用に関するガイドラインを提供し、より安全で信頼性の高いAIシステムの普及を目指しています。日本からの専門家もこの規格の開発に大きく貢献し、国際的な議論に積極的に参加しました。

規格の概要

この規格は組織がAIシステムを開発、提供、使用する際に従うべき指針を定めており、リスクを管理し、信頼性、透明性、説明責任を持ってAIを運用するための方法を提供しています。公平性やプライバシーへの配慮も重要なポイントです。また、学習データや機械学習の特性を考慮する必要があります。

これは、世界的に認められた品質マネジメントシステムであるISO9001や情報セキュリティマネジメントシステムのISO/IEC27001といった既存の規格と同じアプローチを取り入れており、ユーザーが使いやすいように設計されています。

具体的にみていきましょう。

ISO/IEC 42001とは?

組織内での人工知能管理システム(AIMS)の確立、実施、維持、継続的な改善に関する要件を規定する国際規格です。AIベースの製品やサービスを提供または利用するエンティティを対象とし、AIシステムの責任ある開発と使用を保証するために設計されています。

この規格は、技術の急速な変化に対応するための貴重なガイダンスを提供し、AIがもたらす独特の課題、例えば倫理的考慮事項、透明性、継続的な学習などに対処します。組織にとっては、AIに関連するリスクと機会を管理するための構造化された方法を示し、イノベーションとガバナンスのバランスを取ります。メリット

ISO/IEC 42001の主な利点は、リスクと機会の管理フレームワーク、AIの責任ある使用の実証、追跡可能性、透明性、信頼性、コスト削減と効率向上です。対象

この規格は、AIベースの製品やサービスを開発、提供、または使用するあらゆる規模の組織に適用されます。すべての産業に関連し、公共部門の機関だけでなく、企業や非営利団体にも適用されます。

例えば、この規格に従うことで、病院がAIを利用して患者のデータを分析する場合、そのプロセス全体の信頼性を高め、患者のプライバシーを守りつつ、公平に行われるようにすることができるでしょう。

このように、AIシステムを安全かつ効果的に利用するための枠組みを提供し、組織がそれをどのように取り入れ、運用していくかの指針となります。これは、AIの持つ潜在的なリスクを理解し、適切に対処するための道しるべとなるものです。

期待される効果

事業者はこの規格を通じて国際規格に沿ったマネジメントシステムを構築することで、以前よりも安全で安心なAIシステムを提供できるようになることが期待されます。また、AI関係者間の理解が深まり、国際的な商取引が活発になることも見込まれます。

また、異なる国のAIシステム開発者が同じ規格に従っていると、相互の技術や製品について理解しやすくなり、海外の企業との商談がスムーズに進むでしょう。国際規格に基づいたしっかりとした根底を築くことで、事業者はAIの分野で大きく花開く可能性を秘めています。

AIシステム マネジメントシステム

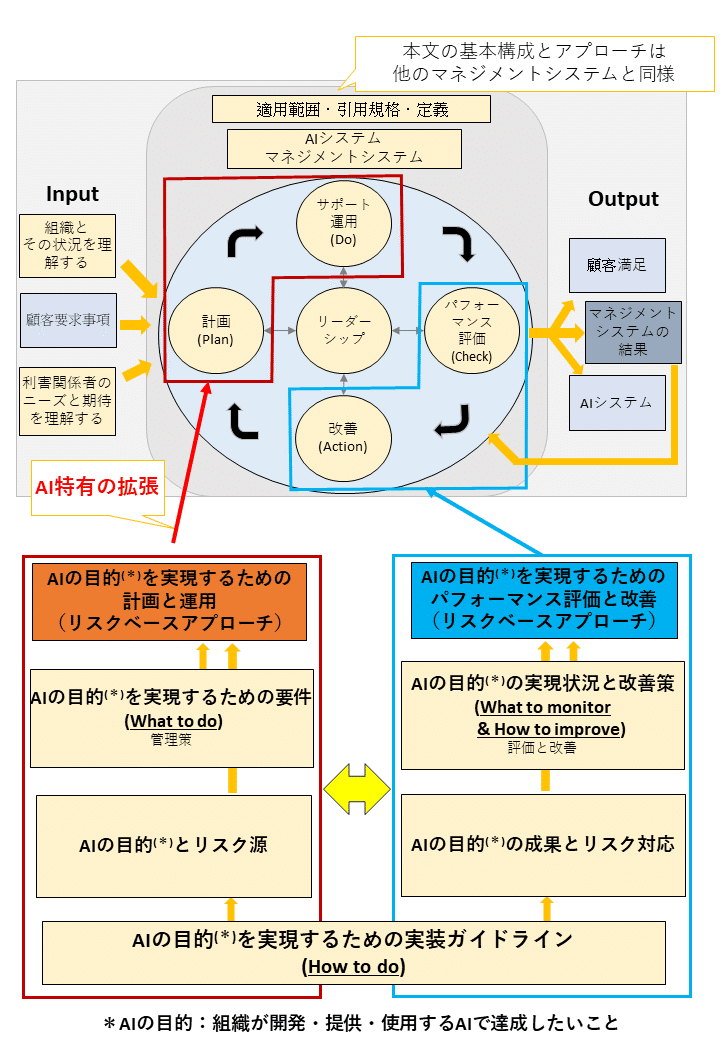

経済産業省の『ISO/IEC 42001』の発行のニュースリリースには以下の図も掲載されていました。

この図の解説をGPT-4にしてもらい、若干補足しましたので、以下は参考程度にご覧ください。

この図は、AIの意思決定プロセスを表しています。PDCA(Plan-Do-Check-Action)サイクルを基にAIの各段階で何をするべきか(What to do)、それを実現するための具体的なアクション(How to do)、そしてその実行と評価(What to monitor & How to improve)に分けて説明しています。さらに、各段階でAIシステムがどのように働くかも説明されています。

この図は、以下の4つの構成要素のサイクルから成り立っています。

1.理解(Plan)

目標を設定し、その達成を実現する戦略や計画を立てる。AIはこの段階で何を実現するかの意思決定を行う。

2.計画(Do)

計画に基づいて具体的なアクションを行う。AIはここでのアクション(行動)を実行する。

3.評価と改善(Check)

実行したアクションの結果を評価し、目標達成に向けた進捗を監視する。AIは行動の結果を監視し、改善点を評価する。

4.改善(Act)

評価結果を基に、次の計画に反映させるための改善を行う。AIはこの段階での実行とリスク対応、改善アクションを決める。

AIシステム マネジメントシステムの具体例

具体例として、製品の品質管理システムを考えてみましょう。初めに、AIはどのような品質が求められるかを理解し(Plan)、製品を製造する(Do)。次に、製造された製品が品質基準を満たしているかを評価(Check)、そして品質が不十分であれば製造プロセスを改善するための方法を考案し実施(Action)します。

この図のベースには「AIシステム」と「マネジメントシステム」が記されており、AIの意思決定が企業の大局的な目標とプロセスと連携していることを意味しています。

最後に、図の下部には注釈として、AIの意思決定が経験、推論、使用するAIに応じて変わることが述べられています。これは、AIの意思決定プロセスが静的なものではなく、絶えず変化し進化する動的なプロセスであることを示しています。

例えば、工場のロボットアームが製品の組み立てを行っている状況を想像してみましょう。最初に「Plan」では、ロボットは組み立ての目標と方法を計画します。次に「Do」で、ロボットは計画に基づき部品を組み立てます。その後「Check」で、組み立てられた製品が品質基準に合っているかを検証します。最後の「Action」で、検証結果に基づき組み立てプロセスを改善します。これがうまく行えば、製品の品質が向上し、生産効率も改善されるでしょう。

また、AIが対応するには、経験から学習し、推論して最適なアクションを選択し、使用するAI技術に応じてそのプロセスを調整する柔軟性が求められます。これにより、AIは単にタスクを実行するだけでなく、そのプロセス自体を改善し続けることができるのです。

全体として、この図はAIの意思決定プロセスが計画的かつ体系的に行われ、継続的な改善を通じて最終的な目標達成に寄与するというPDCAサイクルの原則を示しています。

あとがき

「ISO/IEC 42001」の発行は、AI技術の安全な利用という新たな時代の到来を告げるものです。この規格により、AIシステムの開発者から利用者まで、より安心してAI技術を活用できるようになることが期待されます。私たちの生活に深く関わるAI技術の進展を、安全かつ効果的に進めるための一歩として、この規格の動向に注目していきましょう。

参照サイト

ISO/IEC 42001:2023 - Artificial intelligence — Management system