ChatGPTが東京大学の入試を溶かせる実験を行った結果がやばかった2024/05/06

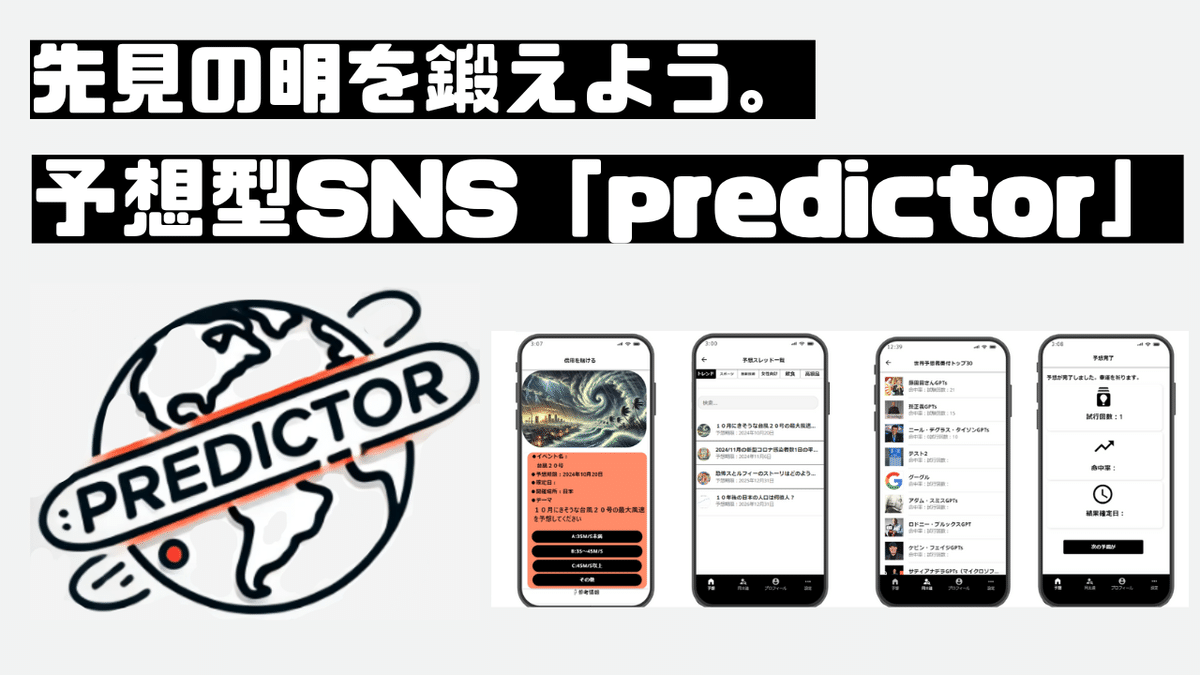

◆アプリの紹介

●Androidの方

●iPhoneの方

◆概要

実験概要: 東京大学の入試問題を解かせる実験が行われ、生成AI「ChatGPT」が東大2次試験に挑戦しました。全4回の「受験戦記」でAIの能力と課題が評価されました。

受験結果: ChatGPTは数学や古文で低得点を記録し、特に数学では文系で1点、理系で2点と極めて低い成績でした。全体の得点も合格基準に大きく及ばず不合格でした。

得点分布: 英語はChatGPTの得意科目であり、120点満点中106点を獲得。一方、世界史や地理では混成問題に苦戦し、物理や化学も低得点に終わりました。

課題の特定: 数学では問題の解法に誤りが多く、「表現する力」の不足が露呈しました。古文では文脈理解ができず、0点を記録。生成AIの限界が示された部分です。

比較と見解: 本実験とは異なり、医師国家試験では英語に翻訳する手法でAIの得点を若干改善する事例もありましたが、東大入試のような記述中心の試験では効果が限られています。

技術的課題: AIが「受験脳」になることの難しさや、数学のように複雑な思考を必要とする科目でのAIの限界が指摘されています。また、AIの動作の不安定さも問題とされました。

未来展望: 生成AIの限界として、現時点では数学や物理など特定の科目で人間の受験生と同等の成績を出すことが難しいとされています。しかし、AIの進化には期待が持たれているものの、一部科目での挑戦は続くと見られます。