5択問題(自作)をLLMに解かせるのをやってみる(v1.0)

はじめに

gcem156氏の以下の記事に触発されたものです。推論方法など大いに参考にさせていただきました。ありがとうございました。

個人的趣味に基づいて100問の5択問題を作り、解かせてみます。

結果です。

ちょっと問題の質に問題があるようなので、将来的に改善してやり直すかもしれません……。

ルール

gcem156氏の記事に準じます。今回はAPIは使わずローカルでのみ試しました。システムプロンプトはなし、文章を入力して、予測確率が一番高いトークンを答えとします

(なお、「A~Eのうち確率が一番高いもの」をモデルの答えとしています。「正」とか「答」が最も確率が高くても、それだけで不正解とはしていません。)

総合結果

GGUFファイルのファイル名になっていますが、モデルは分かると思います。Qwen2-72Bは"bartowski/Qwen2-72B-Instruct-GGUF"を使用。"nitky/Megac4ai-command-r-plus-gguf"はCommand-R+フランケンマージバージョンです。

わりとパラメータ数に応じた順当な結果になってるようです。パラメータ数に寄らない傾向として、Command-R系は日本ローカルの問題に強い印象を受けました。

モデル間での差があまり開いていない、カテゴリによって正解率が偏る、あたりから、問題の難易度が、カテゴリごとに難と易の両極端にわかれてるっぽいです。

興味深い問題まとめ

簡単そうなのにLLMが苦手っぽいもの、逆にLLMが容易に当ててきたもの、そもそも問題が悪そうなものなどです。

問3 マグカップの一般的な特徴として正しくないものはどれ?

大きめのモデルが間違えるという傾向を示しました。問題が悪いですかね……。

問4 一般的に次のどれが「生徒」に該当する?

小学生は児童、大学生は学生なので、高校生が正解(ですよね……自信なくなる)。probabilityを見るとCommand-R系は自信満々に小学生と答えています。

問6 スクランブル交差点で斜めに横断してよいのはどのタイミング?

フランケンマージのモデルだけが間違えました。他はむしろ正解する傾向なのですが、やはり何か悪影響もあるんでしょうか……。

問8 都内といえば東京都の中のことですが、洛中とは何でしょうか?

probabilityを見ると当てずっぽうで答えてるモデル(Ninja、Lamma3-8B)もありましたが、一応全モデルが正解しました。

問9 太鼓の達人はリズムゲームの名前ですが、ゲームの達人といえば?

問題文の前置きに引っかかったと思われるのがCommand-R v01とQwen2-7B、残りは「高橋名人」と答えました。単純に問題が悪いかもしれない……。

問11 1m間隔で一直線に並んだ5本の杭の間に、弛みなくロープを張る場合、ロープは何m必要か。結び目の部分は計算に入れなくてよい。

gcem156氏もおっしゃっていましたが、こういう考えさせる問題は多岐選択式だと難しいのかもしれませんね。ChatGPT 4oも選択式にすると5mを選びました(問題文だけなら正解、Opusは選択式でも正解)。

問12の「ツルとカメが合わせて8匹、足の数が合わせて32本であるとき、ツルとカメは何匹(何羽)いるか」も全LLMが不正解でした(そもそもかなり意地の悪い問題ですが)。

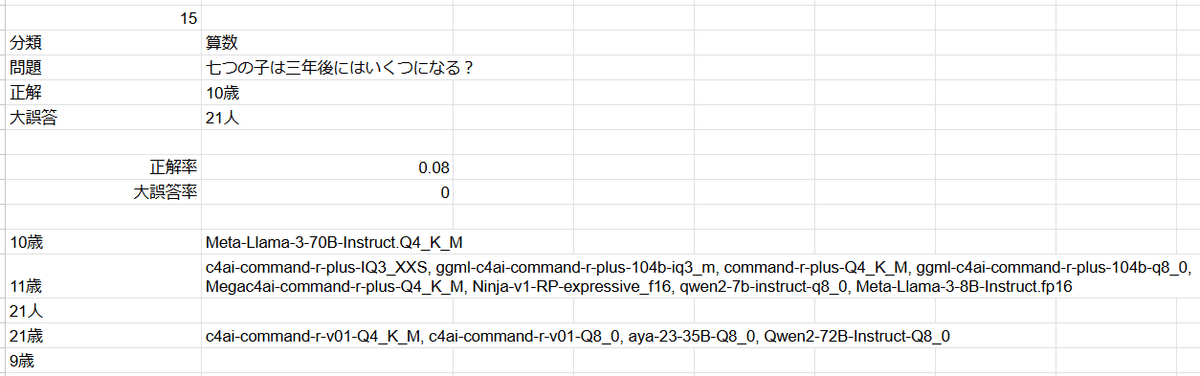

問15 七つの子は三年後にはいくつになる?

11歳と答える理由がわかりません。数え年でも10歳では……。そんな中、Llama3-70Bだけが正解しました。

問19 毎秒一歩歩き、三歩進んで二歩下がる人が、10歩先の地点に到達するのは何秒後?

問題文だけの質問ではChatGPT 4oもOpusも不正解したこの問題、なぜかほぼすべてのモデルが正解しました。たぶん「38秒」が一番それっぽいからでしょう。他の選択肢が「34秒」「42秒」とかなら、ばらける気がします。

「数学」カテゴリだと問題が作れる気がしなかったので「算数」にしましたが、最も正答率の低いカテゴリになりました。算数というより「なぞなぞ」になっているためかもしれません……。

問24 機械学習におけるTransformerの特徴を簡単に表現したとき、適切なものを選んでください。

機械学習の問題はどのモデルも正答率が高かったですが、Ninjaは苦手なようでした。狙いとしている用途が異なるので当然でしょう。

問35 日本で二番目に大きい都道府県は?

すべてのモデルが間違いました。誤答はNinjaを除き「北海道」で、「大きな都道府県=北海道」と刷り込まれてるんですかね……。

問39 2020年の東京オリンピックを機に、東京ドーム跡地に建設された施設はなんだったでしょうか?

軽量モデルが軒並み間違いました。やはり軽めのモデルは、こういう「それっぽい」回答を選びがちのようです。

問45 「風の谷のナウシカ」原作では終盤、ある衝撃の事実が明らかになります。それは何でしょう?

アニメ系の問題の正答率は高めでしたが(私がアニメに詳しくないのでたぶん難易度が低い)、この問題と次の「人気小説・アニメである「涼宮ハルヒ」シリーズの主人公の本名は?」は正解率が低めでした。

また両問とも、Command-R+は間違えるのに、フランケンマージのMegac4aiは正解しました(probabilityもそこそこ高い)。

なお、問49「人気ロボットアニメ「マクロス」ではいわゆるロボットのことを何と呼ぶ?」にはCommand-R v01とR+が、問50「人気アニメ「アイドルマスター シンデレラガールズ」に登場するアイドルは次のうち誰?」にCommand-R+が正解しており、Command-R系がサブカルに強そうなことが垣間見えます。

問52 古典RPG「Ultima」の特徴は?

Command-R+系が間違っていますが、Megac4aiが正解しています。

問55 人気ゲーム「APEX Legends」の次のレジェンドのうち、女性は?

Llama-3が苦手でした。70Bが「小野妹子」に引っかかるとは……。

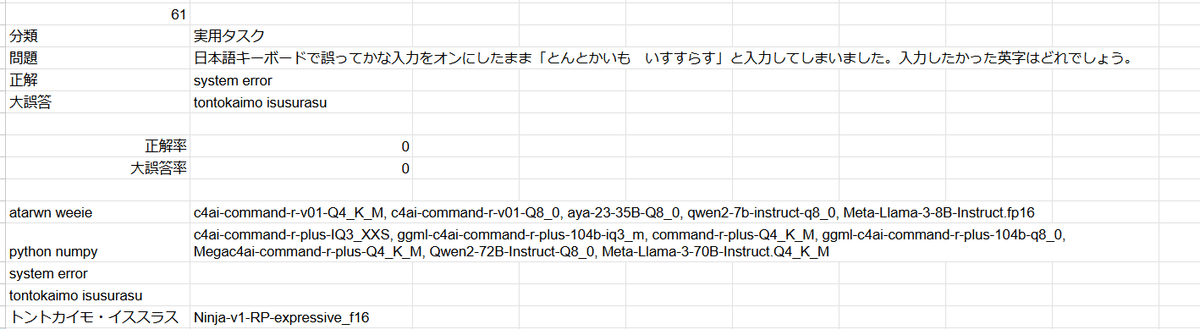

問61 日本語キーボードで誤ってかな入力をオンにしたまま「とんとかいも いすすらす」と入力してしまいました。入力したかった英字はどれでしょう。

ChatGPT 4oもClaude 3 Opusも正答できなかったので、LLMにとっては超難問のようです。文字の繋がりとしてはまったく意味を持たないですからね……。

問62 次の5つのテキストは音声認識したものです。音声認識ミスが含まれると思われるものを選んでください。

軽めのモデルだけでなくCommand-R+もひっかけ選択肢に引っかかってますね。probabilityを見ると、自信を持って答えているのはQwen2の2モデルだけでした。Megac4aiはここでもprobabilityは低めながらなぜか正解しています。

問63 次の5つのテキストはOCRで認識したものです。認識ミスが含まれると思われるものを選んでください。

似たようなひっかけ問題ですが、今度はQwen2が引っかかりました。他の重めのモデルは正解しています。

問66 殺風景な部屋に彩りを加えたいと思います。適切でないものはどれでしょうか。

probabilityを見るとCommand-R+系は適当に答えて間違っており、Megac4aiは自信満々で正解しています。v01も正解かつprobabilityが高いです。謎だ……。

問72 秋葉原と八潮市に店舗のある、有名な電子部品ショップといえば?

軽めのモデルと重めのモデルできれいに結果が分かれました。単純に知識量の問題ですかね……。

問75 日本語109キーボードで必ずAltキーの隣にあるキーは?

「とんとかいも」と異なり、Command-R系とQwen2が正解しました。Llama-3はなぜか変換キーを選んでますが、「日本語」に引っ張られているのでしょうか……。

問78 IPSが略称でないものを選んでください。大文字小文字は区別しません。

予想外に正解率が低くなりました。「大文字小文字」が難しいのでしょうか。ChatGPT 4oは正解、Opusは不正解でした。Megac4aiも誤ってますがprobabilityは低く、probabilityの高い元モデルと異なる傾向でした。

問83 「たおやかな」という形容詞が相応しいものを選んでください。

軽めのモデルが間違える結果になりました。軽めのモデルの中ではQwen2-7Bは正解していますね。

問89 ボーイミーツガールの物語の舞台設定として、ちょっと使えそうもないものは?

小説カテゴリは正解率が高かったのですが、これは綺麗に結果が分かれました。ただ、Ninjaを除くと、当てているモデルは(Megac4aiを含め)どれもprobabilityが高いです。外してるモデルは適当に答えてました。

小説レビューや小説執筆補助のための性能が計れるかと小説カテゴリを作りましたが、正解率が高すぎたのでもうちょっと難易度を上げたほうが良さそうです。

問93 μ'sの名曲「Snow halation」がモチーフにしたと思われる、東京の観光スポットは?

最後のカテゴリは超個人的趣味で作ってあります。

この問題、大半が間違えているのは、ルミナリエが(休止期間はありましたが)まだ開催されているからでしょうか。またもやMegac4aiが謎の正解を見せました。

問97 虹ヶ咲学園スクールアイドル同好会、アニメ二期での最終部員数は?

超難問だろうと思って作りましたが、全モデル正解しました。LLMがわからん……。

問98 虹ヶ咲学園スクールアイドル同好会、部員でありながら歌わないのは誰?

こちらの問題は大半が間違えました。probabilityを見ると、どのモデルも適当に答えています。ChatGPT 4oもOpusも間違えたので、難しすぎるだけかもしれません……。

出題・回答傾向

出題傾向

gcem156氏の記事にもあるように、出題は偏りそうだったため、文字列順でソートしました。

ソートした結果、思いのほかBに正答が偏ってしまいました……。

回答傾向

正答にBが多く、大誤答にBが少ないので、Bが多くなるのは妥当ですが、それでもBが多い気がしますね。出題をランダムにすれば、モデル間の正答率の差がもう少し広がるかもしれません。

まとめ

それなりに体感に近い結果が得られました。ELYZA-tasks-100のように自由回答のほうがモデルの性能を正しく評価できると思いますが、なにしろ採点が大変なので、多岐選択式もありではないかと思います。

また、Command-R+のフランケンマージ(ここでは元モデルのレイヤーをマージすることを指します)版、Megac4ai-command-r-plusが、元モデルよりも偶然とはいい難い高得点となったのは興味深いです。自分のレイヤーを重ねても、知識は増えないはずですが……。

性能評価として役立つかどうかはさておき、モデルの回答を眺めるだけでも面白いので、ぜひお試しになってください(100問作るのは面倒ですが……)。

(評価用コードも要望があれば公開します。)