数字の苦手なライターがデータドリブンになるまで身に付けたスキルと実践したトレーニング

こんにちは。弁護士ドットコム株式会社でデータサイエンティストをしているはやかわです。 普段はデータ分析や機械学習システムの開発をしています。

この記事では以下の内容を話します。

・数字の苦手なライターさんたちがデータドリブンになるためにどんなスキルを身に付けたのか

・そのスキルの習得のために、具体的にどんなトレーニングをしたか

この記事を書くきっかけ

同僚のライターの堤さんがこんな記事を出しました。数字が苦手だったライターさんたちのチームがかなりデータドリブンに改善できるようになった素晴らしい話です。

(この記事、とてもいい記事なのでぜひ読んでみてください)

ここで、どんなトレーニングをしてどんなスキルを身に付ければ、こんなデータドリブンになれるのかが気になるところですので、この記事を書こうと思いました。

身に付けたスキル一覧

❏ 自分たちのチームのKGI, KPIの数字のロジックを正確に理解している

・重要指標 KPI については、自らデータ分析をし更に細かい粒度で絞り込み施策のターゲットを詳細に詰めることができること

❏ データを用いた仮説検証のプロセスを理解し、実践できる

・仮説の根拠は定量的な証拠を示しながらその妥当性を主張できること

・相関関係と因果関係の違いを理解して、相関がある際も因果関係の証明を行う実験を行った

・検証の際には統計的な知識を用いて誰もが同じ水準で意思決定できるようになった(判断が属人化しない)

❏ データを元に施策のターゲット・優先順位を明確に決めることができる

・やるべきこと、しなくてもいいことの判断をメンバー全員が行えること

❏ 施策に対して実験計画を立案できる

・成功・失敗の基準が明確なのでPDCAのスピードが上がったこと

❏ SQL, 統計検定手法を身に付けた

・データ収集から集計・統計による判断まで一通りを自分たちだけで行えること

次に、これを身に付けるために実際にやったトレーニングを書き出します。

1. 毎日データを必ず見る

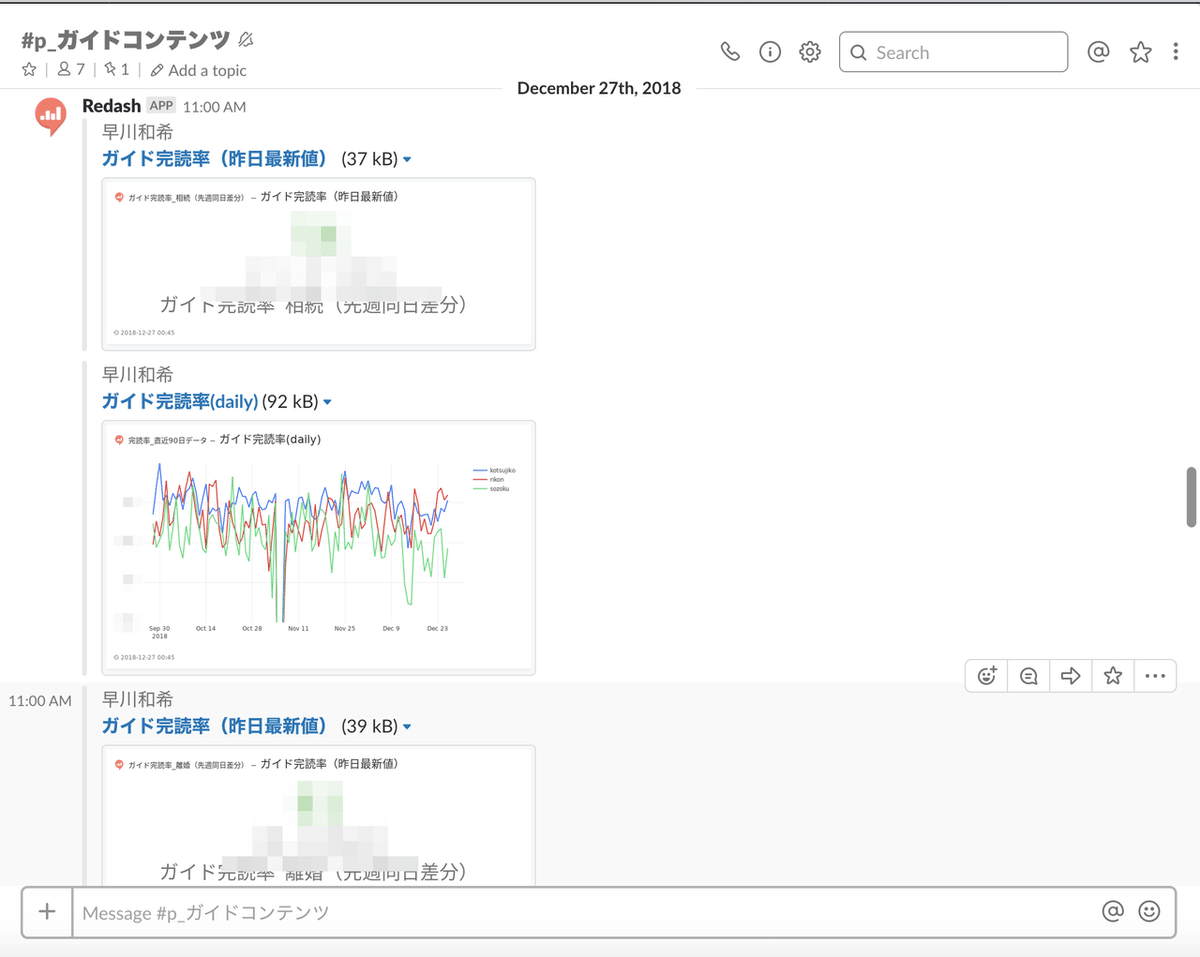

redash(BIツール)でKPIを可視化し、それをSlackに毎日botで投稿することで毎日必ずデータを見る習慣をつけました。

日々の数値の動きを見ることでユーザーの動きを敏感に察知することができるほか、データそのものをまず身近に感じるための手段として用いています。

2. Google Analyticsを用いてKPIを深掘り

このチームのKPIである、ガイドコンテンツ(記事)の完読率を上げたかったので、完読する人・しない人の属性でGoogle Analyticsを用いてユーザー行動を分析しました。

実際のデータから完読に影響の出そうな指標を絞り込んで、仮説とします。webページであれば、直帰率や滞在時間などのユーザー行動指標がよく挙げられます。

3. KPIのボトルネックとなっているであろう仮説のアイディア出し

いきなり広くアイディア出しをするのではなく、直帰率などの指標に絞ってボトルネックを考えることで、具体的なアイディアが出ました。また「直帰率に効かないならやらなくていいよね」という施策の取捨選択も容易でした。

仮説を出すときのポイントとしては「ユーザーは不満に思うだろう!」という気持ちの部分で終わらずに「ユーザーがここでイライラした結果、サイトを離脱してしまうだろう」と行動ベースで考えた点です。

これが良いのは、ユーザーの気持ちは知りようがないですが、ユーザーの行動は観測できるので、その仮説がそもそも妥当かどうかをデータで示すことが可能だからです。

4. 仮説の前提が事実かどうか確認する

出てきた意見の一つに「長文記事は読まれづらい(完読率が低い)から、記事を短くしてはどうか」というものがありました。

しかし、よく考えてみると「長文記事は完読率が低い」という前提は無条件に肯定しても良いのでしょうか? この前提が崩れていた場合、この仮説は説得力を失うことになります。

実際に記事の文字数と完読率の関係性を調査しました。

相関係数は -0.56 で弱い相関があり、確かに長文ほど完読率が下がる結果となり、この仮説は妥当であることが示されました。

しかし同時に、完読率が著しく下がる長文記事の文字数も調査すると、長文記事自体は全体のうちほんの僅かでしかないため、これを改善しても全体の完読率の改善にはほとんど影響しないことがわかりました。

結果として、「記事を短くする」というアイディアは効率がよく無さそうなので却下されることとなるのですが、意思決定を行う前にデータで根拠を示しておくことで必要性の有無を判断できるという好例でした。

5. 施策の優先順位を決めてABテストで実験した

ある程度確度の高い仮説が出揃ったら、施策の優先順位を決めて実験を行います。仮説を立証する一つの手段として、一部の記事を対象としてABテストを実施しました。

ABテストの結果はカイ二乗検定という統計検定の手法で定量的に判断が可能なので、redashにグラフを作成して毎日数値をチェックしながら有意差がでるまでテストを実施しました。

A(現状)とB(改善案)でBの方が有意に有利であることが確認できたので、全ての記事に対しても同様の施策を反映させました。このテストの実施時は、実験の開始から全記事に展開するという施策の意思決定までわずか10日ほどで、非常に判断がスピーディーでした。

このようにスモールスタートで実験を行うことで施策のPDCAを早めることが可能です。

6. SQLを実際に書き、カイ二乗検定を実際にやってみた

データを用いて意思決定を行う以上、自分たちだけである程度はデータを扱うことが必須です。データの収集・集計の手段としてSQLを用います。統計に基づいて判断するためにカイ二乗検定の手法も学びました。

以下のような練習用の資料を作成し、SQLの練習をしてもらいました。

また、実際に自分で抽出したデータから、Google Spreadsheet 上で関数を用いてカイ二乗検定も実施してもらいました。

自分でデータを扱えるようになることで、この場限りではなくその後も自分たちだけで改善を回し続けることができるようになります。

思い込みに惑わされず、事実をベースに仮説検証を繰り返すことで着実に成果を生み出すことのできる体制を作れるようになったのが、この方法の最大の成果だと思っています。この記事を閲覧した方にとってもなにかの参考になれば幸いです。

良いな!と思ったらスキもお願いします!