TensorflowのNST(画風変換AI)を実装してみた

やったこと

Deep Learningの基礎の基礎、Tensorflowを学び直そうと、チュートリアル内の、NSTを実装してみた。

https://www.tensorflow.org/tutorials/generative/style_transfer

作成したコードはこちら↓

https://github.com/Kansuke-Kotsu/ML-learning/tree/main/NST工夫した点

基本チュートリアルと同じだが、丸コピだと芸がないので、ある程度関数化して、別ファイルに。

main.py内では、"2つの画像、学習の回数、各重み"を指定しさえすれば機械学習し、画像生成してくれるようにしました。その他

色々学習の仕方を変えて試してみました。

スタイルの重みを増やして、学習回数を増やした方がそれっぽいですね(当たり前)

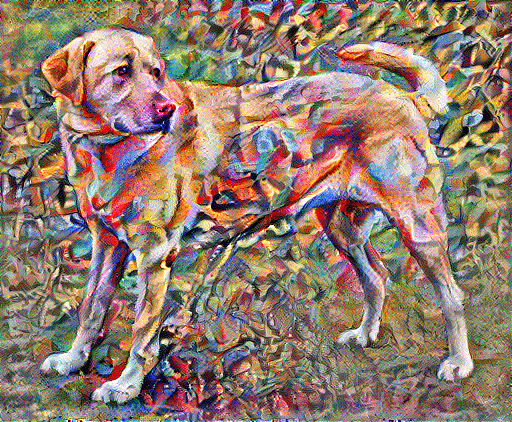

結論:色々試した結果、結局デフォルトの重みでたくさん学習を回すのが一番っぽかった

全体的に投射しているわけではなく、ちゃんとそれっぽくなってるの凄いですよね。

ただ人によって感じ方は違うと思うので、いい感じの画像を何枚か出せるようなロジックにするのが、サービス化するならいいのかなと。

明日以降は、画像を変えて色々試してみる&モデルを保存できるようにしたいです。