OpenAI o3/o3-mini: 人間を超える推論力と安全性を備えた最新AI

こんにちは、スクーティーという会社の代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

米国時間2024年12月20日、OpenAI社が最新推論モデル「o3」と「o3-mini」を発表し、AI業界に大きな衝撃を与えています。ARC-AGIベンチマークで、o3は87.5%という驚異的なスコアを達成し、人間の平均スコアである85%を上回りました。さらに、o3-miniは、コーディングに最適化され、低コストで高速なパフォーマンスを実現しています。これらのモデルは、複雑な推論タスクにおいて従来のAIモデルを凌駕し、安全性においても新たな基準を打ち立てています。

この記事では、OpenAI o3とo3-miniの性能、安全性、そして従来のAIモデルとの違いについて、詳細に解説し、そういった疑問を解消します。

OpenAI o3/o3-miniの驚異的な性能

OpenAI o3/o3-miniの発表

o3/o3-miniは、OpenAI社が12日連続でリリースするという「12 Days of OpenAI」の最終日に発表されました。本記事執筆時点では、Day 12の以下の動画でのみの発表になっています。

ちなみにDay 1はo1/o1 pro modeの発表で、その内容もモデルの能力も十分驚きでした。。。o1/o1 pro modeについては以下の記事にまとめていますので、ぜひご覧ください!

関連記事:OpenAIが最新推論モデルのo1とo1 pro modeをリリース!

ARC-AGIベンチマークで人間を超える

OpenAIのo3は、ARC-AGI(Abstraction and Reasoning Corpus)ベンチマークにおいて、人間の平均スコアを超える87.5%を達成しました。このベンチマークは、AIモデルの汎用的な知能を評価するために設計されており、これまで5年間、どのAIモデルも人間の平均スコアを超えることができませんでした。o3は、このベンチマークで人間レベルのパフォーマンスを上回った初めてのAIモデルとなりました。

これは、o3が非常に高い推論能力を持っていることを示しています。o3は、単に過去のデータからパターンを学習するだけでなく、新しい問題に対して、その場で推論し解決策を導き出す能力を備えているのです。この能力は、従来のAIモデルにはない、o3の大きな特徴と言えるでしょう。

各分野のベンチマークにおける性能

o3は、様々な分野のベンチマークにおいても、優れた性能を発揮しています。

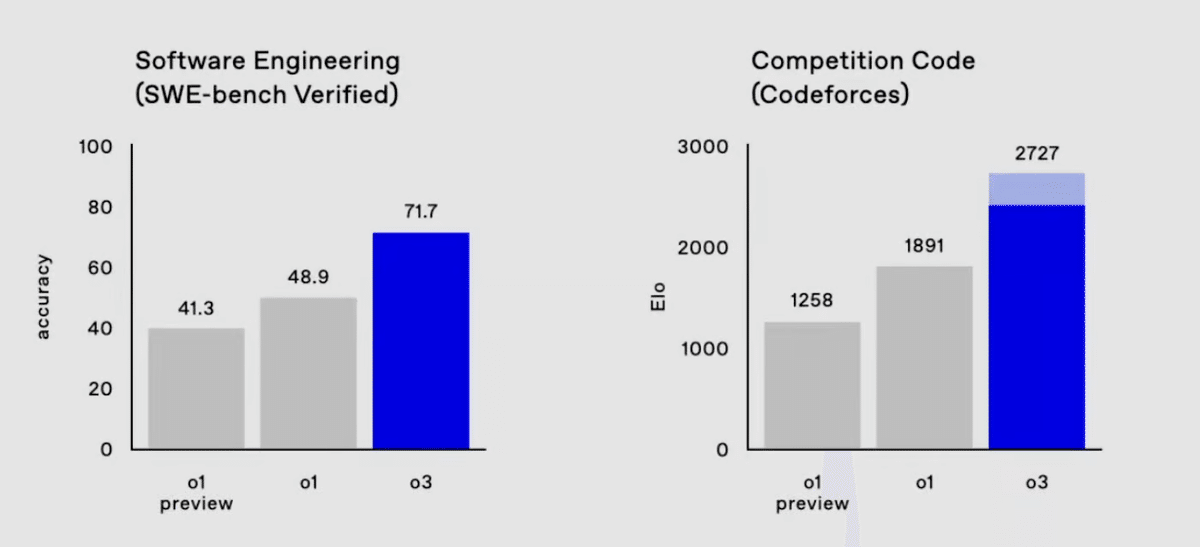

具体的には、SWE-bench Verifiedで71.7%、Codeforcesで2,727、AIME 2024で96.7%、GPQA Diamondで87.7%という、高いスコアを記録しています。これらのベンチマークは、ソフトウェア開発、競技プログラミング、数学、科学といった、様々な分野におけるモデルの能力を測定するものです。

特に、ソフトウェア開発のベンチマークであるSWE-bench Verifiedでは、従来のモデルであるo1のスコアを20%以上上回る71.7%を達成し、競技プログラミングのベンチマークであるCodeforcesでは、人間のトッププログラマーに匹敵する2,727のレーティングを獲得しました。これらの結果は、o3が、コーディングやソフトウェア開発といったタスクにおいても、高い能力を発揮することを示しています。

また、数学のベンチマークであるAIME 2024では、96.7%の正解率を達成し、わずか1問しか間違えませんでした。これは、o3が高度な数学的問題解決能力を持っていることを示しています。科学分野のベンチマークであるGPQA Diamondでは、博士レベルの科学問題において、o1の78%から87.7%へと、10%以上の性能向上を達成しました。

さらに、専門家でも数時間から数日かかるような非常に難しい問題で構成されるEpochAI Frontier Mathベンチマークでは、他のAIモデルが2%未満の正解率しか達成できない中、o3は25.2%という驚異的なスコアを記録しました。これは従来の最高記録である2.0%を大幅に上回るものです。

これらの結果から、o3は従来のAIモデルと比較して、幅広い分野において、より高度な問題解決能力を備えていることがわかります。

o3-mini: コスト効率に優れた推論モデル

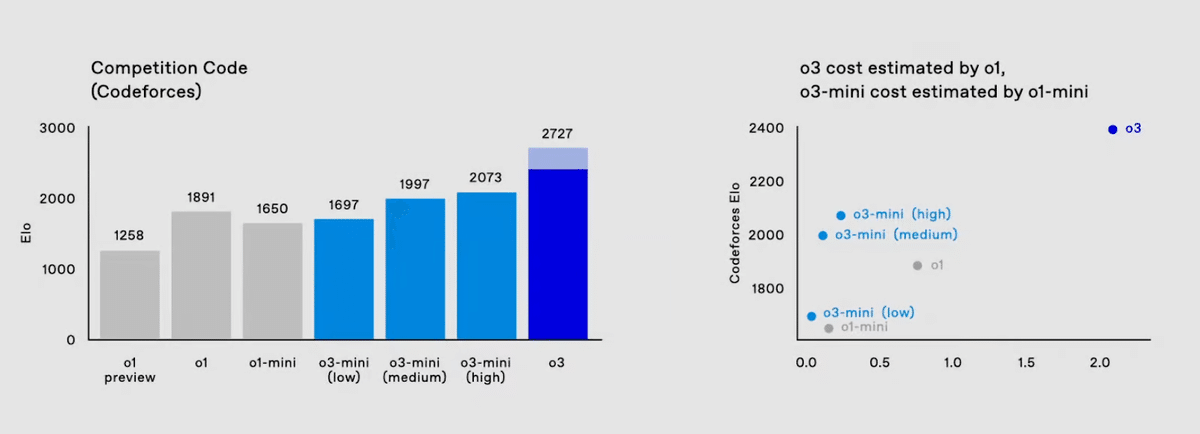

o3-miniは、o3をベースに開発された、コスト効率に優れた推論モデルです。o3-miniの大きな特徴は、推論時間(計算量)を低、中、高の3段階に調整できることです。これにより、タスクの複雑さに応じて、最適な推論時間を選択することができます。

o3-miniは、中程度の推論時間設定でも、o1を上回る性能を発揮し、さらに、推論時間設定を高くすると、o1と同等かそれ以上の性能を発揮します。この柔軟性は特に、多様なユースケースに取り組む開発者や研究者にとって魅力的なものです。

単純な問題: 低推論時間設定で迅速かつ効率的に答えを得ることが可能。

複雑な問題: 高い推論時間設定で、o3と同等の高い精度で答えを得ることが可能。

さらに、o3-miniはAPIを介して利用することが想定されており、ユーザーはAPI経由でモデルにアクセスし、利用することができます。これにより、ユーザーは、自分のアプリケーションやサービスにo3-miniの機能を簡単に統合することができます。OpenAIは、o3-miniのAPIを通じて、低、中、高の3つの異なる推論時間オプションを提供する予定です。そしてこのAPIを、安全性とセキュリティの研究者に公開することを発表しています。これにより、研究者は、異なる推論時間設定でのモデルの性能を評価し、安全性やセキュリティに関する潜在的なリスクを特定することが可能になります。

o3-miniは、特にコーディングタスクにおいて優れた性能を発揮します。中程度の推論時間設定でもo1を上回り、高い推論時間設定では、さらに高いパフォーマンスを発揮します。例えば、競技プログラミングのベンチマークであるCodeforcesでは、高い推論時間設定で2727という高いレーティングを達成し、これは人間のトッププログラマーに匹敵するレベルです。また、推論時間もo1より短縮されており、効率的な処理が可能です。

実際に、OpenAIは、o3-miniを使用して、ローカルサーバーとそれとやり取りするためのUIを作成するデモを行いました。具体的には、以下の手順でデモが行われました。

o3-miniのAPIに、Pythonを使用してコードジェネレーターとエグゼキューターを実装するコードを書くようにリクエスト。

実行すると、ローカルにサーバーが起動し、テキストボックスを含むUIが表示。

UIのテキストボックスにコーディングのリクエストを入力すると、そのリクエストがo3-miniのAPIに送信。

o3-mini APIはリクエストを解析してタスクを解決し、コードを生成。

生成されたコードは、ローカルのデスクトップに保存され、ターミナルを開いて自動的に実行。

このデモでは、o3-miniが複雑なコーディングタスクを効率的に処理し、ユーザーの要求に迅速に応答する能力を実証しました。さらに、o3-miniは、評価タスク自体も自動化しました。具体的には、o3-miniが、o3-miniの低推論時間設定で、GPQAデータセットに対する自己評価スクリプトを生成するというものです。このスクリプトは、

GPQAデータセットをダウンロード

質問と選択肢を抽出

o3-miniに質問を投げかけ

回答を解析し、正答率を計算する

という一連の処理を自動的に実行します。このタスクは、モデル自身が生成したコードを自動的に実行するという、複雑かつ高度なタスクと言えます。o3-miniは、わずか1分でこのタスクを完了し、61.6%の正解率を達成しました。

これらの結果から、o3-miniは、コスト効率と推論時間のバランスに優れたモデルであり、様々なアプリケーションへの応用が期待されます。

o3とo3-miniの推論能力

o3とo3-miniは、推論モデルとして、従来のAIモデルとは一線を画す特徴を備えています。これらのモデルは、与えられたプロンプトに対して、関連するポリシーを参照しながら、段階的に推論を進めることができます。具体的には、以下のステップで推論を行います。

プロンプトの分析: まず、プロンプトを分析し、そこに潜む問題の構造や、適用すべきルール・制約を特定します。

ポリシーに基づく推論: 次に、ポリシーの内容に基づいて、プロンプトに対する適切な応答を生成するための推論を、段階的かつ論理的に展開します。

安全な応答の出力: 最終的に、ポリシーに準拠した、安全な応答を出力します。

この推論プロセスは、人間の思考プロセスに似ており、モデルがより論理的で安全な応答を生成することを可能にします。特に、o3とo3-miniは、事前学習された知識だけでなく、与えられたポリシーに基づいて推論を行うことができるため、未知の状況や複雑な問題に対しても、柔軟に対応することができます。

例えば、以下の図のように、ユーザーが悪意を持ってROT13暗号化されたリクエストを送ってきた場合、o3はまずそのリクエストを復号化し、その内容がOpenAIのポリシーに違反していることを検知します。そして、ポリシーに基づいて、「申し訳ありませんが、それについてはお手伝いできません」と、明確に、かつ丁寧にリクエストを拒否します。この一連の推論プロセスは、モデルの「思考」の過程を示しており、人間が問題を解決する際の思考プロセスと類似しています。

o3とo3-miniは、単にパターンを認識して応答を生成するのではなく、与えられた情報とポリシーに基づいて、論理的に推論を進めることで、より安全で信頼性の高い応答を生成することができるのです。さらに、o3とo3-miniは、推論の過程で、関連するポリシーを明示的に参照します。これにより、モデルの応答の根拠が明確になり、透明性と説明可能性が向上します。例えば、「申し訳ありませんが、それについてはお手伝いできません」という応答を生成する際に、モデルは「ユーザーは違法行為を助長するような指示を求めています。これはポリシーで禁止されています」といった推論過程を示すことができます。これにより、ユーザーはモデルの判断の理由を理解し、納得することができます。

このように、o3とo3-miniは、高度な推論能力と、ポリシーに基づく判断能力を兼ね備えた、革新的なAIモデルと言えるでしょう。o3とo3-miniは、ポリシーに基づいた推論能力を獲得したことで、より安全で説明可能なAIモデルへと進化しました。この技術は、AIの安全性と信頼性を高める上で、重要な役割を果たすことが期待されます。

OpenAI o3/o3-miniの今後の展開と社会への影響

限定的な公開と安全性テスト

OpenAIは、o3とo3-miniの一般公開に先立ち、安全性研究者やセキュリティ研究者向けに限定的なアクセスを提供しています。これは、モデルの潜在的なリスクを事前に特定し、対策を講じるための措置です。具体的には、2024年12月20日から、安全性研究者およびセキュリティ研究者を対象に、o3-miniへの早期アクセス申請の受付を開始しました。申請は2025年1月10日まで受け付けられ、選考を通過した研究者は、モデルの安全性評価に協力することになります。このプロセスを通じて、OpenAIはモデルの安全性に関するフィードバックを収集し、一般公開前に必要な調整を行うことができます。

o3-miniは2025年1月末頃、o3はその後間もなくのリリースが予定されているそうですが、具体的な時期は、安全性テストの結果や規制当局の承認状況によって、今後変更される可能性があります。OpenAIは、モデルのリリース前に十分な安全性テストを実施し、社会に悪影響を与えるリスクを最小限に抑えることを重視しています。

o3/o3-miniの社会への影響

o3とo3-miniは、その高度な推論能力と安全性により、社会に大きな影響を与える可能性があります。

例えば、教育分野では、生徒一人ひとりの学習進度に合わせた個別指導や、複雑な問題解決を支援するツールとして活用されることが期待されます。医療分野では、患者の症状や検査結果から、最適な治療法を提案する診断支援システムや、新薬開発の加速に貢献する可能性があります。

また、ビジネス分野では、データ分析や意思決定の自動化、顧客対応の効率化など、様々な業務の効率化と高度化に貢献することが期待されます。これらのモデルは、従来のAIモデルでは対応が難しかった、複雑なタスクや創造的なタスクにおいても、人間を支援し、生産性を向上させることができるでしょう。

しかし、これらのモデルが悪用されるリスクも存在します。例えば、偽情報の拡散、詐欺行為、プライバシー侵害などの問題が発生する可能性があります。そのため、OpenAIは、モデルの安全性向上に継続的に取り組むとともに、倫理的な利用を促進するためのガイドラインを策定し、社会全体で責任あるAIの利用を推進していくことが重要です。具体的には、モデルの出力を監視し、悪意のある利用を検知するシステムの開発や、ユーザーに対する教育や啓発活動などが挙げられます。

OpenAIの今後の展望

OpenAIは、o3およびo3-miniの開発を通じて得られた知見を活かし、今後もAIモデルの研究開発を進めていく予定です。特に、以下の分野に注力していくことが予想されます。

汎用人工知能(AGI)の研究: OpenAIは、人間と同等かそれ以上の知能を持つ汎用人工知能(AGI)の実現を最終目標として掲げています。o3およびo3-miniは、AGI実現に向けた重要な一歩となることが期待されています。今後、より高度な推論能力や汎用性を持つモデルの開発が進められていくでしょう。

安全性と倫理: OpenAIは、AIモデルの安全性と倫理的な利用を重視しており、今後もこの分野の研究開発に注力していくと考えられます。具体的には、モデルの意図しない動作を防ぐための技術開発や、AIの倫理的な利用に関するガイドラインの策定などが挙げられます。Deliberative Alignmentのような新しい技術は、AIモデルの安全性を確保する上で重要な役割を果たすと考えられます。

オープンソース化: OpenAIは、一部のモデルをオープンソース化することで、AI技術の民主化に貢献しています。今後も、安全性や倫理的な問題を考慮しながら、オープンソース化の可能性を検討していくと考えられます。オープンソース化によって、より多くの研究者や開発者がAI技術に触れ、その発展に貢献することが期待されます。

OpenAIは、o3およびo3-miniの開発を通じて、AI技術の可能性を大きく広げました。今後も、OpenAIの動向から目が離せません。これらのモデルが社会にどのような影響を与え、どのように活用されていくのか、その展開に注目していく必要があるでしょう。

最後に

最後までお読みいただき、ありがとうございます!

ぜひ スキ と フォロー をお願いします!

弊社では、LLM(大規模言語モデル)やアーキテクチャの選定、技術検証、生成AIを使用したプロトタイピングやシステム開発、お客様社内での啓蒙活動等を対応させていただく「生成AIコンサルティング」サービスを提供しています。

また、業務利用できるChatGPTのような仕組みである「セキュアGAI」や、生成AIとOCRを組み合わせた「AI文書読み取りサービス」といったAIソリューションも提供しています。

ぜひお気軽にお問い合わせください!

この記事は私が経営する株式会社スクーティーのコーポレートブログの下記記事を焼き直したものです。