Gemini 2.0 全モデル完全解説: Flash, Lite, Proを比較

こんにちは、スクーティーという会社の代表のかけやと申します。

弊社は生成AIを強みとするベトナムオフショア開発・ラボ型開発や、生成AIコンサルティングなどのサービスを提供しており、最近はありがたいことに生成AIと連携したシステム開発のご依頼を数多く頂いています。

進化し続けるAIの世界で、Googleから新たに Gemini 2.0 シリーズが登場しました。「Gemini 2.0 Flash」「Gemini 2.0 Flash-Lite」「Gemini 2.0 Pro」「Gemini 2.0 Pro Experimental」、それぞれ何が違うの?どんなことができるの?と疑問に思っていませんか?

この記事を読めば、それぞれのモデルの違いや特徴、得意なこと、そして、あなたのニーズにぴったりのモデルはどれかが一目瞭然です!Googleの最新AIモデル「Gemini 2.0 Flash」「Gemini 2.0 Flash-Lite」「Gemini 2.0 Pro」、そして「Gemini 2.0 Pro Experimental」の全貌を、誰にでもわかるように徹底的に解説します。

Gemini 2.0シリーズの概要:4つのモデルの違いを理解しよう

Gemini 2.0 Flash, Lite, Pro, Experimentalって何?それぞれの特徴は?

Googleが開発したGemini 2.0シリーズは、まるで4つ子の兄弟のように、それぞれ異なる個性を持ったAIモデルです。一言でいうと、Gemini 2.0シリーズは、テキストだけでなく、画像、音声、動画まで理解し、文章を生成できる、超高性能なAIなんです。特に、新しく追加されたExperimentalバージョンは、これまでのモデルの性能をさらに向上させた、注目のモデルとなっています。

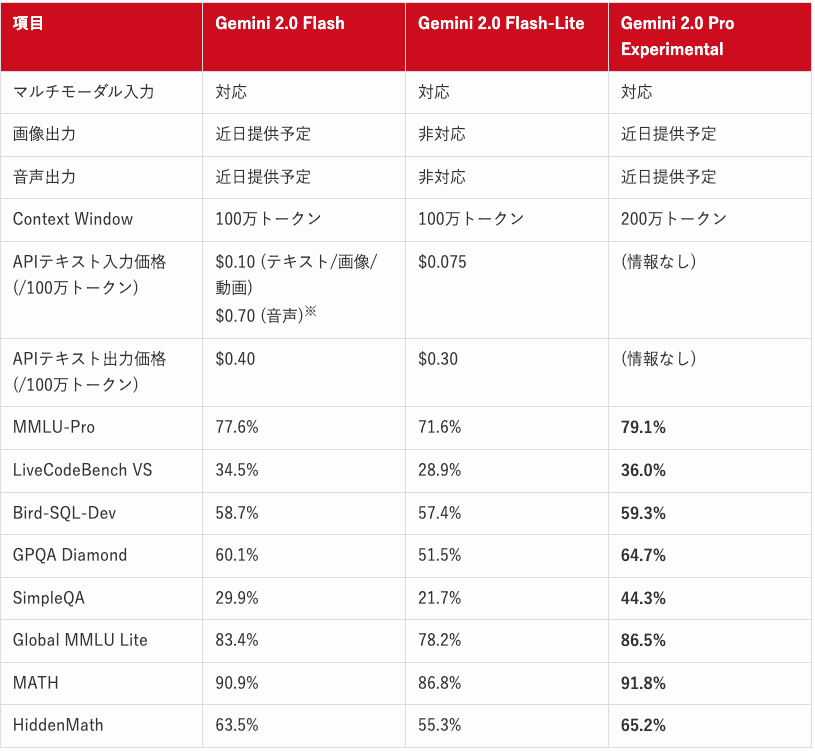

具体的に、4つのモデルの違いを見ていきましょう。

Gemini 2.0 Flash: スピードとパワーを兼ね備えた万能モデル。複雑な処理も高速にこなせるので、例えば、プログラムのコードを生成したり、大量のデータを分析したりするのが得意です。

Gemini 2.0 Flash-Lite: コストパフォーマンスに優れた軽量モデル。Flash譲りのスピードはそのままに、より手軽に利用できます。例えば、大量の画像に短い説明文を自動で生成する、といったタスクに向いています。

Gemini 2.0 Pro: 複雑な推論やコーディングに特化した上位モデル。他のモデルよりもさらに高度な処理能力を持ち、専門的な知識が必要なタスクもこなせます。例えば、長文のレポートを分析して要約を作成したり、高度なプログラミングのコードを生成したりするのが得意です。

Gemini 2.0 Pro Experimental: Gemini 2.0 Proをさらに進化させた実験的なモデル。特にコーディング性能と複雑なプロンプトへの対応能力が強化されています。

上記の表に出てきたベンチマークは、AIモデルの性能を測るためのテストのことです。

MMLU-Pro: AIが、さまざまな分野の専門知識をどれくらい持っているかを測るテストです。大学レベルの問題が出題されます。

LiveCodeBench VS: AIが、プログラミングのコードをどれくらい正確に書けるかを測るテストです。

Bird-SQL-Dev: AIが、人間の言葉で書かれた質問を、データベースを操作するためのSQLという言語に変換できるかを測るテストです。

GPQA Diamond: AIが、生物学、物理学、化学などの専門的な質問に答えられるかを測るテストです。

SimpleQA: AIが、一般的な知識に関する質問に、事実に基づいて答えられるかを測るテストです。

Global MMLU Lite: AIが、さまざまな言語で、専門知識をどれくらい持っているかを測るテストです。

MATH: AIが、数学の問題を解けるかを測るテストです。

HiddenMath: AIが、高度な数学の問題を解けるかを測るテストです。

これらのベンチマークのスコアが高いほど、AIモデルの性能が良いということになります。ただし、これはあくまでも目安であり、実際の使い勝手は、使う人や目的によって異なる場合があります。

ちなみに、以前Googleが最初にGemini 2.0を発表した際の記事と、当時の最新モデルだったGemini-exp-1206の記事も是非ご覧ください!

関連記事:Gemini 2.0: Google最新AIの速報

関連記事:GoogleがGemini-exp-1206を発表:200万トークンのコンテキストウィンドウとマルチモーダルAI

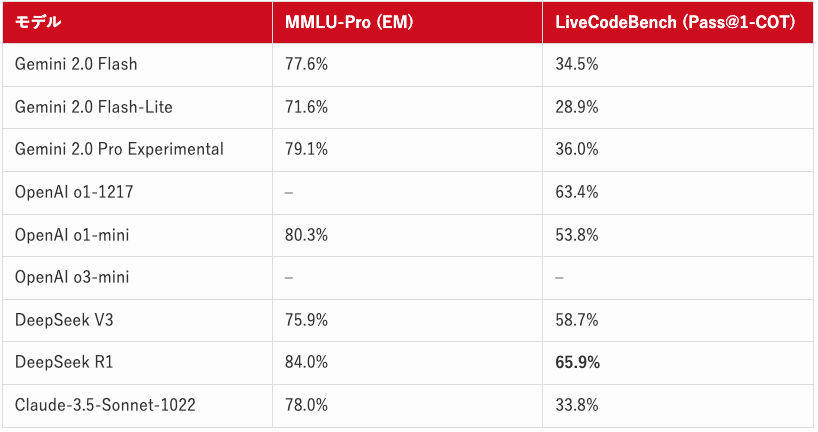

Gemini 2.0シリーズと競合モデルのベンチマーク比較

ここでは、Gemini 2.0シリーズ (Flash, Flash-Lite, Pro Experimental) と、競合するAIモデル (DeepSeek V3, DeepSeek R1, OpenAI o1-mini, OpenAI o1) の性能と価格を比較します。これらの比較を通じて、各モデルがどのようなタスクに適しているのか、コストパフォーマンスはどうか、といった点を明らかにします。

性能比較表

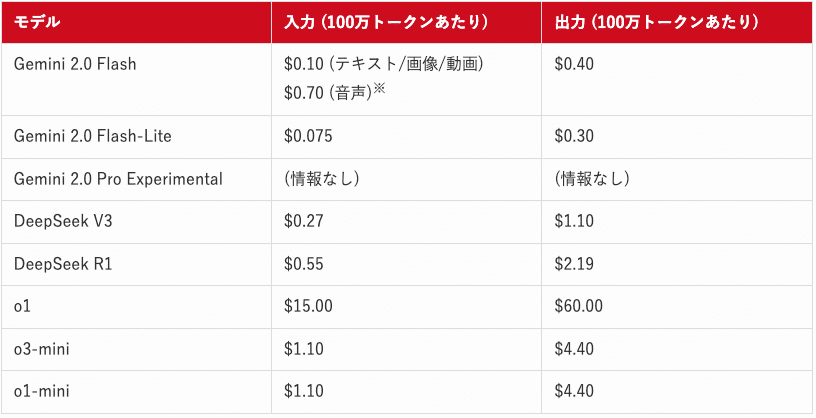

APIの価格比較表

DeepSeekは格安ということで話題になりましたが、実はGeminiのほうが安いです。

参照:

https://platform.openai.com/docs/pricing

https://api-docs.deepseek.com/quick_start/pricing

ここで比較しているDeepSeek、o1/o1-mini、o3-miniの記事もありますので、ぜひご覧ください!

Gemini 2.0 Flash, Flash-Lite, Proの強みと弱み

上記の性能比較表と価格比較表、そしてこれまでの情報を総合的に考慮すると、Gemini 2.0 Flash, Flash-Lite, Proには以下のような強みと弱みがあると言えます。

Gemini 2.0 Flash:

強み: 速度とパワーのバランスが良い。幅広いタスクに対応できる汎用性。比較的安価。MMLU-Proでは、77.6%と、o1-mini(80.3%)に迫る性能。

弱み: コーディング能力を示すLiveCodeBenchでは、DeepSeek R1やOpenAIのモデルに及ばない。

Gemini 2.0 Flash-Lite:

強み: コストパフォーマンスが高い。大量のテキストや画像処理に向いている。

弱み: より高度な推論や複雑なタスクでは、ProやExperimentalに劣る。LiveCodeBenchのスコアは最も低い。

Gemini 2.0 Pro (Experimental含む):

強み: 非常に長いコンテキストウィンドウ(200万トークン)。複雑なタスクや高度な推論、コーディングに強い。MMLU-Proでは79.1%。

弱み: 現時点では、Experimental版は利用できる場所やAPIが限られている。LiveCodeBenchのスコアは、他のモデルに比べて高くない。

課題: 過剰に抽象的なコードを生成する傾向やセキュリティ上の制約が報告されている。

全体的な傾向:

OpenAIのモデル(o1, o1-mini, o3-mini)は、MMLU-Proで高い性能を示している。

DeepSeekのモデルは、LiveCodeBenchで非常に高い性能を示している。

Gemini 2.0シリーズは、マルチモーダルな入力に対応している点が大きな特徴。

価格面では、Gemini 2.0 Flash-Liteが最も安価であり、大量のデータを処理する際にコストメリットがある。

Gemini 2.0 Pro Experimentalは、今後の性能向上に期待。

どのモデルを選ぶべきかは、用途や予算、求める性能によって異なります。高速な処理とコスト効率を重視するならFlash-Lite、バランスの取れた性能を求めるならFlash、高度な推論や複雑なタスクにはPro、そして最新の実験的な機能を試したい場合はPro Experimentalを選ぶと良いでしょう。

Geminiモデルのバージョンについて

Geminiモデルには、"latest"、"stable"、そして"experimental"といったバージョンがあります。これらは、モデルの更新頻度や安定性を示しています。開発の初期段階や、最新機能をいち早く試したい場合は"latest"、安定した動作を求める場合は"stable"を選択すると良いでしょう。"experimental"は、その名の通り実験的なバージョンであり、新機能が先行して搭載される一方、予期せぬ動作をする可能性もあります。自身の用途やリスク許容度に合わせて、適切なバージョンを選択することが重要です。

latest: 最新版を指し、頻繁に更新される可能性があります。新機能や改善が迅速に反映されるため、最新の技術を試したい場合に適しています。ただし、頻繁な更新により、動作が不安定になる可能性も考慮する必要があります。

stable: 安定版を指し、信頼性が求められる場合に適しています。一定期間テストされ、安定した動作が確認されたバージョンであるため、本番環境での利用に適しています。

experimental: 実験的な機能を試すことができるバージョンで、頻繁な変更が加えられる可能性があります。最新技術の早期試用や、フィードバックの提供を目的とする場合に適しています。ただし、予期せぬバグや動作の不安定さが発生する可能性があることを理解しておく必要があります。

例えば、Gemini 2.0 Flashの場合、"gemini-2.0-flash"は最新版、"gemini-2.0-flash-001"は特定の安定版を指します。このように、バージョン番号を確認することで、モデルの特性を把握し、適切に使い分けることができます。

Gemini 2.0 Flash:スピードとパワーを両立した万能モデル

Gemini 2.0 Flashってどんなモデル?得意なことは?

Gemini 2.0 Flashは、スピードとパワーを兼ね備えた、まさに「万能選手」と呼ぶにふさわしいモデルです。テキスト、画像、音声、動画の入力に対応し、テキストでの応答に加えて、将来的には画像や音声での出力も可能になる予定です。100万トークンという長いコンテキストウィンドウも特徴の一つです。この長いコンテキストウィンドウにより、大量の情報を一度に処理できるため、長文のドキュメントの要約や、複雑なコードの解析など、より高度なタスクに対応できます。

Gemini 2.0 Flashは、特に以下のようなタスクを得意としています。

コード生成: 自然言語での指示に基づいて、さまざまなプログラミング言語のコードを生成できます。例えば、「Pythonでリストの要素を逆順にする関数を書いて」と指示すると、適切なコードを生成してくれます。

データ抽出: 大量のテキストや画像から、必要な情報を効率的に抽出できます。例えば、ニュース記事のリストから、特定のキーワードを含む記事だけを抽出する、といったことが可能です。

ファイル分析: ドキュメント、スプレッドシート、プレゼンテーションなどのファイルを分析し、内容を要約したり、質問に答えたりできます。例えば、PDFファイルの内容を要約したり、スプレッドシートのデータに関する質問に答えたりすることができます。

グラフ生成: データに基づいて、さまざまな種類のグラフを生成できます。例えば、売上データの推移をグラフで表示したり、アンケート結果を円グラフで表示したりすることが可能です。

ネイティブツールの利用: 外部ツールとの連携がスムーズに行えます。これにより、Gemini 2.0 Flashの機能を、他のアプリケーションやサービスと組み合わせて利用することができます。

また、Gemini 2.0 Flashは、100万トークンという長いコンテキストウィンドウを持っているため、長文のレポートやドキュメントの内容も正確に把握し、それに基づいた応答が可能です。これにより、従来のAIモデルでは難しかった、文脈を踏まえた応答や、より複雑なタスクの処理が可能になっています。

Gemini 2.0 Flashの性能を詳しく見てみよう

Gemini 2.0 Flashは、さまざまなベンチマークテストで高い性能を示しています。特に、以下の点で優れています。

マルチモーダル性能:画像、音声、動画の入力に対応し、それらを組み合わせた複雑な処理も可能です。例えば、動画の内容を説明する文章を生成したり、音声データからテキストを書き起こしたりすることができます。

推論能力: 大量の情報を基に論理的に推論し、複雑な問題を解決する能力に優れています。例えば、複数の文書を比較して、共通点や相違点を見つけ出したり、ある事象の原因を推測したりすることができます。

具体的な数値で見てみると、Gemini 1.5 Flashと比較して、様々なベンチマークで性能が向上していることがわかります。これは、Gemini 2.0 Flashが、より効率的なアルゴリズムを採用し、より多くのデータで学習しているためです。

この表からも、Gemini 2.0 Flashが、前バージョンのGemini 1.5 Flashと比較して、多くの分野で性能が向上していることがわかります。特に、推論能力や多言語理解能力の向上が顕著です。

Gemini 2.0 Flashの料金体系は?

Gemini 2.0 Flashには、無料枠と有料枠(従量課金制)があります。

無料枠:

1分あたり15リクエスト(RPM)

1分あたり100万トークン(TPM)

1日あたり1,500リクエスト(RPD)

有料枠(従量課金制):

Tier 1: 1分あたり2,000リクエスト(RPM)/ 1分あたり400万トークン(TPM)

Tier 2: 1分あたり10,000リクエスト(RPM)/ 1分あたり1,000万トークン(TPM)

入力料金: 100万トークンあたり0.10ドル(テキスト/画像/動画)、100万トークンあたり0.70ドル(音声)

出力料金: 100万トークンあたり0.40ドル(テキスト)

例えば、100万トークンのテキストを入力し、50万トークンのテキストを出力した場合、料金は以下のようになります。

入力料金: 0.10ドル

出力料金: 0.40ドル * 0.5 = 0.20ドル

合計: 0.30ドル

無料枠でも、個人利用や小規模なプロジェクトであれば十分なリクエスト数が提供されています。しかし、より大規模なプロジェクトや、商用利用を検討している場合は、有料枠を利用することで、より多くのリクエストを処理できます。詳細な料金体系については、Google AI Studioの料金ページを参照してください。

Gemini 2.0 Flash-Lite:より手軽に使える軽量モデル

Gemini 2.0 Flash-Liteってどんなモデル?

Gemini 2.0 Flash-Liteは、Gemini 2.0 Flashの性能を維持しつつ、よりコスト効率を高めたモデルです。大量のテキストデータを処理するのに適しており、例えば、大量の画像に短いキャプションを自動生成するようなタスクに最適です。100万トークンコンテキストウィンドウと、マルチモーダル入力に対応しているため、多様な使い方が可能です。無料枠と有料枠が用意されており、無料枠でも十分な機能が利用できますが、より大量のデータを処理したい場合は有料枠がおすすめです。例えば、大量の製品レビューを分析して、肯定的な意見と否定的な意見を分類したり、複数のニュース記事から特定のトピックに関する情報を抽出したりするなど、さまざまな用途に活用できます。また、画像認識能力も高く、写真に写っている物体を認識し、それに関連する情報を抽出することも可能です。

Gemini 2.0 Flash-Liteの性能は?

Gemini 2.0 Flash-Liteは、1.5 Flashよりも多くのベンチマークで優れた性能を発揮します。100万トークンのコンテキストウィンドウとマルチモーダル入力を備え、例えば、Google AI Studioの有料プランでは、約4万枚のユニークな写真に関連する1行のキャプションを1ドル未満で生成できます。これは、大量の画像にタグ付けをしたり、商品説明文を自動生成したりする際に非常に役立ちます。また、テキストだけでなく、画像、音声、動画を組み合わせた複雑な処理も可能です。例えば、動画の内容を要約したり、音声データから感情を分析したりすることもできます。これらの機能により、Gemini 2.0 Flash-Liteは、さまざまなビジネスシーンやクリエイティブな活動をサポートします。さらに、Gemini 2.0 Flash-Liteは、API経由で利用できるため、既存のシステムやアプリケーションに簡単に組み込むことができます。

Gemini 2.0 Flash-Liteの料金体系は?

Gemini 2.0 Flash-Liteにも、無料枠と有料枠(従量課金制)があります。

無料枠:

1分あたり30リクエスト(RPM)

1分あたり100万トークン(TPM)

1日あたり1,500リクエスト(RPD)

有料枠(従量課金制):

Tier 1: 1分あたり4,000リクエスト(RPM)/ 1分あたり400万トークン(TPM)

Tier 2: 1分あたり60,000リクエスト(RPM)/ 1分あたり1000万トークン(TPM)

入力料金: 100万トークンあたり0.075ドル(テキスト/画像/動画/音声)

出力料金: 100万トークンあたり0.30ドル(テキスト)

無料枠でも十分な機能が利用できますが、大量のテキストや画像データを処理する場合は、有料枠を利用することで、より高速かつ効率的に処理できます。例えば、大量の顧客からの問い合わせメールを分析し、自動応答システムを構築したり、SNSの投稿を分析して、トレンドを把握したりするなど、ビジネスのさまざまな場面で活用できます。また、有料枠では、より高いレート制限が適用されるため、大量のリクエストを短時間で処理する必要がある場合にも対応できます。詳細な料金体系については、Google AI Studioの料金ページを参照してください。

Gemini 2.0 Pro:複雑なタスクもこなせる最上位モデル

Gemini 2.0 Proってどんなモデル?

Gemini 2.0 Proは、Gemini 2.0シリーズの中で最も高度なモデルです。特に、複雑な推論やコーディングタスクに優れており、これまでリリースされたモデルの中で最高のコーディング性能と複雑なプロンプト処理能力を持っています。

200万トークンという非常に大きなコンテキストウィンドウを持ち、Google Searchやコード実行などのツールを呼び出す機能も備えています。この大きなコンテキストウィンドウにより、Gemini 2.0 Proは、長大なソースコードや、複数のドキュメント、長時間の動画や音声ファイルなどを一度に処理し、それらの情報を総合的に理解した上で、高度な推論や問題解決を行うことができます。

これにより、例えば、長文の技術文書を理解し、それに基づいて新しいコードを生成したり、複雑な問題を複数のステップに分解して解決したりすることが可能です。また、Gemini 2.0 Proは、Google AI Studio、Vertex AI、そしてGeminiアプリ(Gemini Advancedユーザー向け)で利用できます。

これらのプラットフォームを通じて、開発者はGemini 2.0 Proの強力な機能を、さまざまなアプリケーションやサービスに組み込むことができます。例えば、高度なチャットボットを開発したり、複雑なデータ分析ツールを作成したり、新しいプログラミング言語の学習ツールを開発したりすることが可能です。さらに、Gemini 2.0 Proは、API経由で利用できるため、既存のシステムやアプリケーションに簡単に組み込むことができます。

Gemini 2.0 Proの性能は?

Gemini 2.0 Proは、他のモデルと比較して、世界知識の理解と推論能力が向上しています。これにより、より複雑な問題解決や、専門的な知識を必要とするタスクにも対応できます。例えば、科学論文を読ませて、その内容に関する質問に答えさせたり、特定の分野の専門知識を必要とするコードを生成させたりすることが可能です。

また、Gemini 2.0 Proは、特にコーディングタスクにおいて高い性能を発揮し、複雑なアルゴリズムの実装や、大規模なコードベースの解析などを得意とします。さらに、Gemini 2.0 Proは、マルチモーダルな入力にも対応しており、テキストだけでなく、画像、音声、動画を組み合わせた複雑なタスクも処理できます。

例えば、動画の内容を分析して、要約を作成したり、音声データから特定のキーワードを抽出したりすることも可能です。これらの機能は、Gemini 2.0 Proが、より多くのパラメータを持ち、より多くのデータで学習していること、そして、より高度なアルゴリズムを採用していることによって実現されています。

Gemini 2.0 Proはどこで使えるの?

Gemini 2.0 Proは、以下のプラットフォームで利用可能です。

Google AI Studio: Webベースのインターフェースで、Gemini 2.0 Proの機能を試したり、アプリケーションを開発したりできます。直感的な操作で、Gemini 2.0 Proの機能を簡単に試すことができます。例えば、プロンプトを入力して、Gemini 2.0 Proがどのように応答するかを確認したり、生成されたコードをコピーして、自分のプロジェクトに利用したりすることができます。

Vertex AI: Google CloudのAIプラットフォームで、Gemini 2.0 ProをAPI経由で利用できます。これにより、既存のシステムやアプリケーションにGemini 2.0 Proの機能を組み込むことができます。例えば、自社のWebサイトにチャットボットを導入したり、顧客からの問い合わせメールを自動的に分類したりすることができます。

Geminiアプリ: Gemini Advancedユーザーは、デスクトップやモバイルのGeminiアプリでGemini 2.0 Proを利用できます。これにより、外出先でもGemini 2.0 Proの機能を利用できます。例えば、移動中にアイデアをメモしたり、調べ物をしたり、メールを作成したりすることができます。

これらのプラットフォームを通じて、Gemini 2.0 Proの高度な機能を、さまざまなアプリケーションやサービスに組み込むことができます。例えば、高度なチャットボットを開発したり、複雑なデータ分析ツールを作成したり、新しいプログラミング言語の学習ツールを開発したりすることが可能です。また、これらのプラットフォームは、開発者だけでなく、一般のユーザーにも利用しやすいように設計されており、AI技術をより身近なものにしています。さらに、Googleは、Gemini 2.0 Proの機能をより多くの人に利用してもらうために、さまざまな開発者向けのツールやリソースを提供しています。

Gemini 2.0 Pro Experimental:更なる高みを目指す実験的モデル

Gemini 2.0 Pro Experimentalとは?

Gemini 2.0 Pro Experimentalは、Gemini 2.0 Proをさらに進化させた実験的なモデルです。特にコーディング性能と、複雑なプロンプトへの対応能力が強化されています。他のモデルと比較して、より高度な問題解決能力や、専門的な知識を必要とするタスクへの対応能力が向上しています。例えば、より複雑なプログラミングの問題を解決したり、専門的な知識を必要とする質問に答えたり、より自然で人間らしい文章を作成したりすることができます。

このモデルは、Google AI Studio、Vertex AI、およびGemini Advancedユーザー向けのGeminiアプリで利用可能です。実験的なモデルであるため、常に最新の機能が追加され、性能が向上していくことが期待されます。また、このモデルは、開発者や研究者が、AIの最先端技術を試し、新しいアプリケーションやサービスを開発するためのプラットフォームとしての役割も担っています。

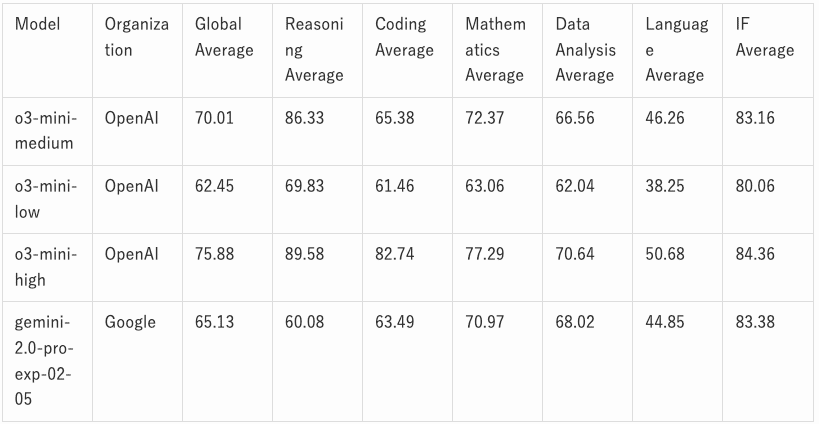

Gemini 2.0 Pro Experimentalの性能を比較

Gemini 2.0 Pro ExperimentalとOpenAIのo3-mini、そしてDeepSeek R1との比較を見てみましょう。以下の表は、LiveBench Leaderboardにおける各モデルのベンチマーク結果です。

この表から、Gemini 2.0 Pro Experimentalは、特にデータ分析の分野でo3-miniに匹敵する性能を示していることがわかります。一方、o3-miniは推論とコーディングの分野で高いスコアを記録しています。しかし、Gemini 2.0 Pro Experimentalは、全体的にバランスの取れた性能を示しており、特に複雑なタスクや専門的な知識を必要とするタスクにおいて、その真価を発揮します。また、この表はあくまでもベンチマークテストの結果であり、実際の使用感や性能は、タスクの種類やプロンプトの内容によって異なる可能性があることに注意が必要です。

表から、o3-miniのhighバージョンは推論とコーディングの能力でGemini 2.0 Pro Experimentalを上回っていることがわかります。しかしながら、データ分析の平均スコアでは、Gemini 2.0 Pro Experimentalがわずかに上回っています。Global Averageではo3-miniが高いものの、IF Averageでは両モデルが近い数値を示しており、タスクの種類によって得意不得意があることが示唆されます。総合的に見ると、o3-miniは推論とコーディングに特化しているのに対し、Gemini 2.0 Pro Experimentalはより幅広いタスクに対応できる汎用性を持っていると言えるでしょう。例えば、o3-miniは、高度なアルゴリズムの設計や、複雑なコードの生成において優れた性能を発揮する一方、Gemini 2.0 Pro Experimentalは、データ分析、レポート作成、専門的な知識を必要とする質問応答など、より幅広いタスクに対応できます。

Gemini 2.0シリーズの安全性と責任あるAI開発

Googleは、Gemini 2.0シリーズの開発において、安全性と責任あるAI利用を最優先事項としています。Gemini 2.0モデルは、Gemini自身が応答を批評する新しい強化学習技術を用いて構築されており、より正確で的を絞ったフィードバックと、機密性の高いプロンプトを処理する能力が向上しています。この技術により、Gemini 2.0モデルは、より安全で信頼性の高い応答を生成することができます。例えば、差別的な表現や、暴力的な表現、誤った情報などを含む応答を抑制することができます。具体的には、モデルの学習データから、偏見や差別、誤情報などを排除し、さらに、モデルの出力結果を常に監視し、問題のある応答を検出した場合は、速やかに修正するなどの対策を講じています。

また、自動化されたレッドチームによる安全性とセキュリティリスクの評価も実施されています。これには、間接プロンプトインジェクション(攻撃者がAIシステムによって取得される可能性のあるデータに悪意のある指示を隠すサイバーセキュリティ攻撃の一種)などのリスクも含まれます。レッドチームは、専門のセキュリティエンジニアで構成され、Gemini 2.0モデルの脆弱性を特定し、対策を講じる役割を担っています。具体的には、さまざまな攻撃シナリオを想定し、モデルがどのように応答するかをテストします。そして、もし脆弱性が見つかった場合は、開発チームにフィードバックし、修正を促します。このような取り組みにより、Gemini 2.0モデルは、より安全で信頼性の高いシステムとして提供されています。さらに、Googleは、AIの安全性に関する研究開発にも積極的に取り組んでおり、AIの倫理的な利用に関するガイドラインを策定し、公開しています。

しかしながら、Gemini 2.0 Proには、まだいくつかの課題も存在します。具体的には、過度に抽象的なコードを生成してしまう傾向や、セキュリティ上の制約から、DevOpsツールに必要な低レベルのシステム操作が実行できないといった問題が報告されています。これらの問題は、今後のモデルの改善によって解決されることが期待されます。例えば、より具体的な指示をプロンプトに含めることで、過度に抽象的なコードの生成を抑制したり、セキュリティ上の制約を緩和することで、より多くのシステム操作を実行できるようにしたりすることが考えられます。Googleは、ユーザーからのフィードバックを積極的に収集し、モデルの改善に役立てています。具体的には、ユーザーからのフィードバックを分析し、問題の原因を特定し、モデルの学習データやアルゴリズムを改善することで、より安全で使いやすいモデルの開発を目指しています。また、Googleは、AIの安全性に関する情報を積極的に公開し、ユーザーが安心してAIを利用できる環境づくりにも取り組んでいます。

まとめ:Gemini 2.0シリーズでAIの可能性を広げよう

Gemini 2.0シリーズは、従来のAIモデルの限界を超え、より高度で多様なタスクに対応できるAIモデルです。Gemini 2.0 Flash、Flash-Lite、Pro、そしてExperimentalの4つのモデルは、それぞれ異なる特徴と強みを持ち、さまざまなニーズに対応できます。 Gemini 2.0シリーズを活用することで、あなたの仕事や創造性を、これまで以上に拡張できるでしょう。

例えば、Gemini 2.0 Flashを使えば、大量のデータを高速に処理し、効率的に作業を進めることができます。Gemini 2.0 Flash-Liteを使えば、コストを抑えながら、AIの機能を活用できます。Gemini 2.0 Proを使えば、複雑な問題解決や、専門的な知識を必要とするタスクを、AIの力を借りて行うことができます。

そして、Gemini 2.0 Pro Experimentalを使えば、最新のAI技術を駆使して、未来の可能性を切り開くことができます。さらに、これらのモデルは、APIを通じて利用できるため、既存のシステムやアプリケーションに簡単に組み込むことができます。これにより、AIの機能を、より多くの人々に、より身近なものにすることができます。Googleは、Gemini 2.0シリーズを通じて、AIの可能性を広げ、社会に貢献することを目指しています。

最後に

最後までお読みいただき、ありがとうございます!

ぜひ スキ と フォロー をお願いします!

弊社では、LLM(大規模言語モデル)やアーキテクチャの選定、技術検証、生成AIを使用したプロトタイピングやシステム開発、お客様社内での啓蒙活動等を対応させていただく「生成AIコンサルティング」サービスを提供しています。

また、業務利用できるChatGPTのような仕組みである「セキュアGAI」や、生成AIとOCRを組み合わせた「AI文書読み取りサービス」といったAIソリューションも提供しています。

ぜひお気軽にお問い合わせください!

この記事は私が経営する株式会社スクーティーのコーポレートブログの下記記事を焼き直したものです。