Google I/O 2018から見えるAR/VRが当たり前になった未来

先日MESONのメンバーで合宿に行ってきました。

テーマは「XRが当たり前になった未来を想像し、MESONが創造すべきものを考える」。

各自XRの未来を考える上で参考になる動画を考察とともに持ち寄って共有し合い、みんなの頭を未来志向に揃えてからバックキャスティングという手法でXRの未来と自分たちはその未来を作るために何をすべきかを徹底的に議論してきました。

持ち寄る動画として自分が選んだのは、今年5月にあったGoogle I/Oの主要な発表をまとめた動画。

一見、AR/VRの未来を想像する上では関係ないように思える発表ですが、AR/VRは未来のパーソナル情報端末、つまり今のスマホやPCのような位置づけのデバイスになるので、機械学習・AI・コンピュータービジョン・ブロックチェーンなど他のテクノロジーの進化と密接に絡みながら進化していきます。

今回は自分がGoogle I/O 2018の動画を見て、AR/VRの未来はこうなっていくんだろうな、と思った内容をシェアできればと思います。

Google I/O 2018

そもそもGoogle I/OとはGoogleが年に1回、世界中からプレス、デベロッパーを集めて行う一大カンファレンスです。

Googleが近々リリース予定のデバイスや機能、研究開発中で一定の成果を挙げている技術をお披露目する場で、Googleが作る未来がインターネットの未来の一部を形作っていくので、ITに関わる人は必ずウォッチすべきイベントになっています。

動画を観なくても記事の内容は楽しめますが、もしまだ観たことがない方はお時間あるときに是非観ることをオススメします。

以下で、自分が重要だなと思った箇所をピックアップしながら、AR/VRの未来を予想していこうと思います。

※ 解説がしやすいように適宜順番をいじっています。

TPUが前世代(去年)の8倍の処理能力に

TPUとは、Googleが作っている機械学習に特化したGPUのようなもので、これが去年の全世代のものから8倍の処理能力に進化したそうです。

1年で8倍の意味するところはかなり大きいです。

仮に固めに5倍の進化と見積もっても、それを10年続ければ、5の10乗でおよそ976万倍の進化率となります。

976万倍に処理能力が進化した世界では、現状不可能だと言われているものも、人間が想像できることはほとんどが実現できる進化のペースです。

レイ・カーツワイルも言っていますが、人間は技術の進化を予測するときに直線状の進化スピードでしか予測できませんが、実際の技術の進化スピードは上に書いたように指数関数的に進化していきます。

この後の自分の予想ではかなりSFチックな、現実離れをした予想をしていますが、処理能力が976万倍になっている10年後を考える際にはそれくらいストレッチした未来予測の方が妥当なのではと思っています。

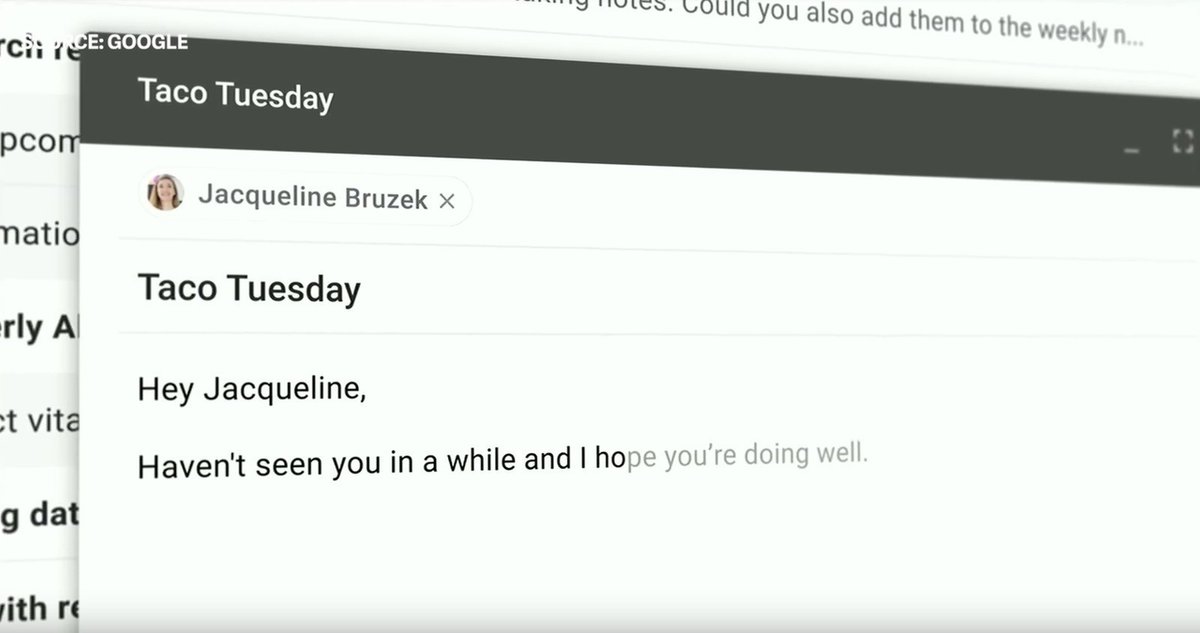

機械学習による文字入力予測

メールの文面を途中まで書くと、機械学習によってGoogleのメールアプリ側が入力内容を先回りして提示してくれるというもの。

ARの文脈で何を意味するか

この技術トレンドはARデバイスの入力インターフェイスの観点と、ARグラス着用のモチベーションの観点で面白いなと思いました。

入力インターフェイスの観点で言うと、正しいインプットをクラウドに上げ続けていれば、文字入力がほとんど要らなくなる世界が来るかもしれない、という可能性を示唆しています。

つまり自分が置かれている状況と過去取った行動パターンを、ARデバイスを通じてクラウドに共有していれば、何を書くかを考えなくてもARデバイス側が環境をインプットにして先回りしてアウトプット、すなわち文字入力してくれる。

ARデバイスのボトルネックの大きな一つが入力インターフェイスの不便さなので、これは大きな意味を持つかなと思います。

次にARグラス着用モチベーションの観点でいくと、単純に考えれば人々がメガネ型デバイスを常時着けることは考えにくいです。

しかし、上記のように常に着用し常に行動/環境データをクラウドに同期させることに強力なユーザーインセンティブが生まれれば、コンタクトレンズ型の登場を待たずして人々は常にARデバイスを着用したまま生活するかもしれません。

自分もメガネを1日中着けて生活するだなんてありえないと思っていましたが、1800年ごろにコンタクトレンズのアイデアが生まれた頃には人間が一日中ガラス版を眼球に入れて生活するとは誰と思っていませんでした。

同様の既成概念に現代の自分たちもハマってしまっているのかもしれません。

ヘルスケア

機械学習によって患者が再入院するかどうかを76%の精度で予測できたというもの。

ARの文脈で何を意味するか

ARデバイスが普及すると、常に着けるのではなく必要な時にのみ装着する形になるでしょうが、それでも以下の3種類の情報が取れるようになります。

1)目の周りの生体データ(脈拍、眼圧、姿勢など)

2)視界データ(食べたもの、行った場所、喫煙や飲酒行為の頻度など)

3)待機型の音声認識機能が付くはずなので音声/会話データ(うつの発症と相関のある特定の発言をどれくらい言ったか、逆に回りから言われたかなど)

ここで特に重要なのは2と3で、1の生体データはウォッチ型などの他のウェアラブルデバイスでも取れますが、視界データと音声/会話データは目に装着するデバイスであり、かつメインのインターフェイスが音声になるARデバイスでしか取得できない情報になってきます。

こうして今まで全く取れていなかったが非常に価値のあるヘルケアデータが増えるようになり、それと機械学習とを組み合わせて自分の健康変化を現在の医師や検査よりも正確に予測できるようになる未来が来ることが予測できます。

機械学習による画像加工

1枚の画像から人物と背景を自動で識別し、背景のみを暗くすることが可能に。また、白黒の写真を機械学習によって自動でカラー写真にすることが可能に。

AR/VRの文脈で何を意味するか

1)グリーンバックがなくても対象物と背景を分離することができる

現状のVRの大きなボトルネックはVR使用者と鑑賞者の体験の断絶です。つまりVR使用者は広大なVR空間を見ながらプレイできていますが、鑑賞者はそれをPCのモニターで観ることしかできず、大きな体験のギャップが生じています。

下の写真のようなグリーンバック空間であればVR使用者にVR内の風景をリアルタイム合成して右のスクリーンのような形でVR内でプレイしている様子を楽しめるのですが、グリーンバック空間を用意するのは非常に面倒です。

今回のGoogleの発表のすごいところは、人物を明確に分離できるので、グリーンバックがなくてもスマホやメガネ型デバイスを通してVR使用者を見れば下のスクリーンのような形でVR体験を共有することができるのです。

これに合せて現実世界のオブジェクトのリアルタイム認識能力が高まれば「Augmented Virtuality」、LeapMotionが言うところのミラーワールドも可能になる。

ミラーワールドとは、現実世界と仮想空間がシームレスにつながっていて、VR空間を立ち上げると、現実世界の机や道路、通行者などがVR世界内でそれに合ったオブジェクトに変換されて表示されるというものです。

※ この記事を書いたあとに見つけたのですが、LIVというところがKinectなどの深度センサーを使ってグリーンバックなしのクロマキー合成に成功していました。

2)いづれ現実世界をリアルタイムで加工できるようになる

白黒写真をカラーに変換するデモを見て、ARグラスによって人々が好きな時間帯、好きな気候で生活できるようになる世界は近いなと思いました。こちらはGoogleではありませんが以下の動画の研究のように昼間の運転風景の動画を夜のドライブの動画に変換したり、雪の日の運転動画を晴れの日のドライブ動画に変換することは既に可能になっています。

これがリアルタイム処理が可能になり、かつそれがパーソナルデバイス程度のマシンスペックで可能になれば、ARグラスを着けることで曇りの日でも晴れの日のような気持ちよさを味わえたり、夜でも昼間のような視界の良さで生活することができたりする世界は近いのではないかと思います。

人間と自然に対話できる音声アシスタント

Googleの音声アシスタントが、タスク志向型の会話(≠雑談)において人間と自然に対話をすることが可能になり、電話で美容院でヘアカットの予約をする様子を公開していました。

美容院のスタッフに「ちょっと待ってね」と言われると、「Mm-hmm」と返すほど自然なやり取り。

ARの文脈で何を意味するか

シンプルにアイアンマンのジャービスが可能になるなと思いました。ARデバイスのメインの操作インターフェスは音声になるはずなので、会話の文脈を踏まえながら対話できる音声アシスタントは必須なのですが、それが今回のGoogle I/Oの発表で大きく現実味を持ったのかなと思います。

ディスプレイ付き音声アシスタント

これは未来予測ではないのですが、ARがグラスが提供していく価値や、ユーザー体験を考える上でディスプレイ付き音声アシスタントデバイスはウォッチしていくべきかなと思いました。

なぜならメインのインターフェイスが音声である、マシンが能動的にユーザーに情報を視覚+音声で提示する、という2つの意味でARグラスが提供する価値の先行研究として非常に参考になるからです。

次に何のアプリを開くかを60%の精度で予測できるように

Androidの最新OSでは、アプリ一覧を開いた際に、ユーザーの行動パターンと直前の行動から、次に開きそうなアプリをレコメンドするようになったのですが、その予測精度が現段階でも60%出ているそうです。

これをARの文脈と組み合わせて考えた時に、ARグラスの時代はアプリを立ち上げるという行為自体がなくなっているかもしれないなと思いました。

つまりマシン側が環境に合わせてアプリの立ち上げとそれに合わせたオブジェクトの表示を自動で行う。

ユーザーが環境に合せて自分でアプリを立ち上げるという面倒なことを行うとは思えず、一方でネイティブアプリのリッチな体験を放棄するかといえばそうならないと思うので、ARグラスではマシン側が環境を読み取ってのアプリ自動起動がデフォルトの世界になっていくのではと思っています。

スマホ使いすぎ問題を解決するための機能

スマホのOSをやっているGoogleがスマホ利用を控えるための機能を提供し始めました。

これがARにおいて意味するところはかなり大きいと思っています。

スマホ中毒は深刻な社会問題です。USではスマホの1日の平均利用時間で3.3時間。あくまで平均なので、5時間以上スマホを使っている人は相当な数いるはず。

そしてARデバイスが普及するとと、デジタル中毒の問題は必ず議論になるはずです。なぜなら着用することで常にデジタル情報に触れることになるからです。

AR時代のデジタル中毒を考える上で改めてスマホ中毒を考えてみたいと思います。

スマホ中毒が問題になっているということは、人はスマホを使いすぎることに後ろめたさを感じているということです。

では、なぜスマホを使い続けることに後ろめたさを感じているかといえば、スマホを使っている間、人は現実世界との断絶を感じるからだと思います。家族や友人と会話する時間が減ったり、趣味や読書、出かける時間が減ったり。

翻って、ARの美点の一つは現実世界とデジタル情報の統合です。

ARデバイスがデジタル中毒を生まないためには上記のような後ろめたさを感じさせないことが必要で、そのためにはARデバイスが提供するデジタル情報が現実世界とのつながりをより強固にするものでなければなりません。ARで表示される情報を使って家族や友人との会話をより有意義なものにしたり、趣味をより楽しめるようにしたり、外に出かけるのがより楽しくなるようにしたり。

スマホでデジタル中毒の問題を深く認識しており、新たにARデバイスを作ろうとしているGoogleやAppleはここの意識が強くあると思うので、ARアプリケーションを作ろうとしている自分たちもこの視点は忘れずに持つべきだなと思っています。

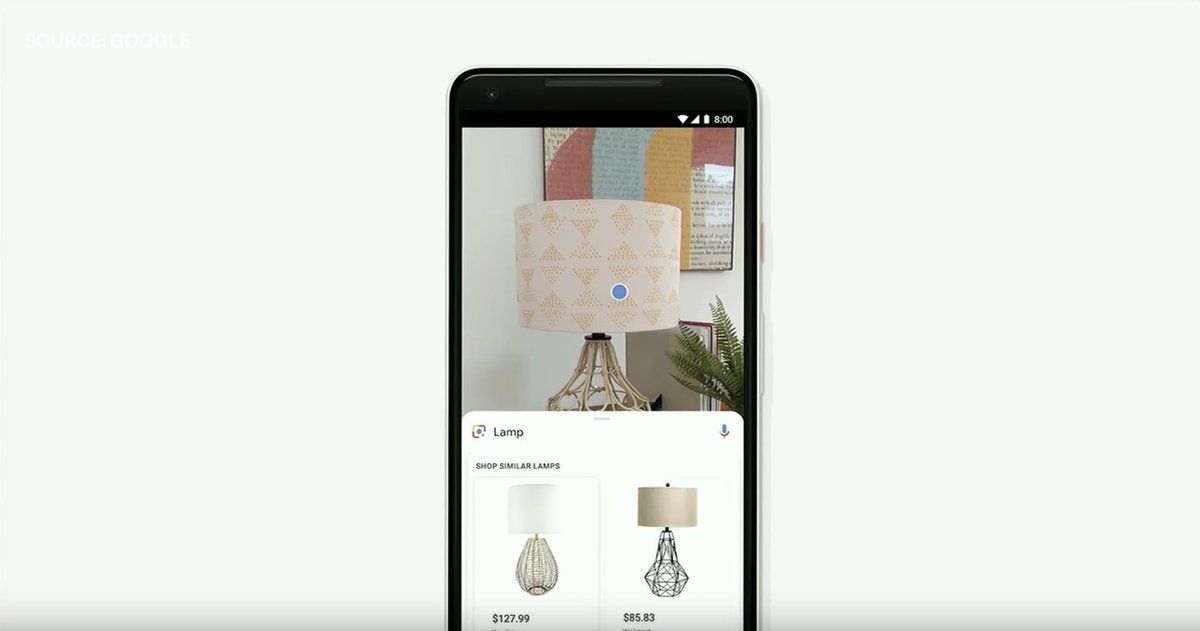

Google Lensの物体認識、そしてGoogle MapのFor You機能

画像から物体を認識する機能であるGoogle Lensがリアルタイム処理に対応したという発表と、Google mapがFor You機能をリリースしたという発表は、GoogleがAR時代の検索体験を獲ろうとしている一連の流れの中で捉えることができ、それらの先にAR時代の検索エンジンサービスの姿を予測できるなと思いました。

AR時代の検索エンジンサービスのポジションを取るためには以下3つが必要です。

1. 現実世界の視覚情報/位置情報を適切なクエリに変換する

2. 予めインデックスしてある情報からクエリに紐づく情報を引き出す

3. 引き出した情報を、クエリとユーザーデータに基づいてスコアリング&ランク付けして表示

まずGoogleがGoogle Lensでやろうとしていることは上記の1と2に当たります。まだ機能的に十分とは言えないGoogle Lensを早期にユーザーに開放することで、まずは視覚情報をクエリに変換する精度を高めようとしており、今回のリアルタイム処理はその正統進化と言えます。

そしてGoogle MapのFor You機能は明らかに3を意識した動きです。

例えばニューヨークのある通りの景色をARグラスで見たときに、Googleであれば1と2の達成、すなわち景色と位置情報からお店のデータをピックアップすることは容易。

ただそれらの情報を全て表示してしまうと明らかに情報過多になってしまうので、選定して表示してあげる必要がある。今回のFor You機能はそれに繋がる動きだと捉えることができます。

また、Google Lensの発表の中にARショッピングの解の一つがあるなと思いました。

それは街で見たものそのもの、もしくはそれに似た安いものをワンクリックで買うという体験。すなわちARグラスを通じて現実世界全体がショールーム化するというのがARショッピングの本質的な解の一つなのではと思います。

自動運転/コネクテッドカー

コネクテッドカーの文脈でもARデバイスが重要な役割を果たすと思っています。なぜなら車間通信だけでは角から出てくる人間に気づきづらく、近くを歩いている人が付けているARグラスが角から出てくる人を認識し、それを車に通信するのが本質的に正しいからです。

その意味でARデバイスの勝者と、自動運転戦争の勝者は一致する可能性が高く、その意味でトヨタ・テスラ・UberよりもGoogle・Appleが遥かに強いと思います。

テスラはブランドで残る可能性はありますが、自動運転のOS部分は全てGoogleとAppleが取り、トヨタや他の自動車メーカーはスマホでいうHUAWEIのようなハードだけ製造するメーカーになる未来が自分としては一番イメージできます。

上記のように考えると 、ARの未来を考える際にも自動運転の動向はきちんと注視していこうと改めて思いました。

まとめ

完全に自分の主観での解釈、未来予想なので間違っているところも多分にあると思います。

自分としてもこれはあくまで議論のネタで、色んな方とAR/VRの未来についてディスカッションしていきたいので是非Twitterで意見を頂ければ幸いです。

AIやXRなどの先端テック、プロダクト戦略などについてのトレンド解説や考察をTwitterで日々発信しています。 👉 https://twitter.com/kajikent