「データはExcelにしかありません」はなぜ問題か?

どうも、エンジニアのgamiです。

最近、『Excel依存がDXを遅らせる3つのワケ』という記事を読みました。

僕としても、Excelはもっとモダンなツールに早く置き換えられるべきだと思っているので、記事の内容にも納得感がありました。以前にも、このnoteマガジンでExcelとスプレッドシートの比較記事を書きました。

以前書いた比較記事では「デスクトップアプリケーション+ファイル」v.s.「クラウドサービス+DB」という対比について考えました。今回は、「データを価値に変える」という観点でExcelの功罪について考えてみたいと思います。

Excelという万能ソフトウェアの功罪

「リープフロッグ現象」という言葉があります。固定電話も無かった通信環境の遅れた地域に、一足飛びにいきなりスマートフォンが普及するような現象のことです。

リープフロッグ型発展(リープフロッグがたはってん、英:Leapfrogging)とは、既存の社会インフラが整備されていない新興国において、新しいサービス等が先進国が歩んできた技術進展を飛び越えて一気に広まること。リープフロッグ現象ともいう。

リープフロッグは、中途半端にテクノロジーが普及していることが新しいテクノロジーの社会実装を妨げてしまうということを示しています。より優れたテクノロジーやソリューションの受容は、爆発的なニーズに後押しされることで加速します。逆に、なまじ課題解決が上手く回っている状況だと、変革のスピードが上がりにくいというわけです。

Excelについても、これと同じことが言えると思っています。最近では、大量のデータを高速に処理するためのテクノロジーやサービスが多く登場しています。しかし、「Excelで十分」と思い込んでいる人が多ければ多いほど、こうした新しいテクノロジーの受容は進みにくくなります。

『Excel依存がDXを遅らせる3つのワケ』という記事では、Excelのデメリットとして「データと表現形式が切り離されていない」ことが挙げられています。

同じデジタルデータでも「扱いやすさ」には違いがあります。例えば、紙の印刷物に近いPDFファイルはプログラムによる処理が難しく、人間には見やすい一方で、まとめて処理をする用途には向きません。むしろデータの墓場だと言っていいくらい、PDFはデータ形式と呼ぶのにふさわしくありません。

Excelも同様です。シンプルなカラムでデータをまとめただけのものであれば問題ないのですが、見やすさのためにセルが結合されていたりします。

人間に見やすくする機能を入れれば入れるほど当然それを使いますから、自然と機械では処理しづらくなる関係というのはあると思います。

ここで指摘されているように、「データと表現形式が切り離されていない」ことの最大の問題は、機械的に処理しにくいということです。現在、データを扱う上では、いかにコンピュータの力でデータ処理を自動化するかが重要になってきます。扱うデータの量や種類が爆発的に増えていく中で、人間がそれを手動で処理することには限界が来ているからです。

Excelフォーマットのファイルには、表データ以外にも、見た目を整えるための不純物がたくさん混ざっています。実際、テキストエディタでExcelファイルを開こうとすると、そのままでは開くことができません。

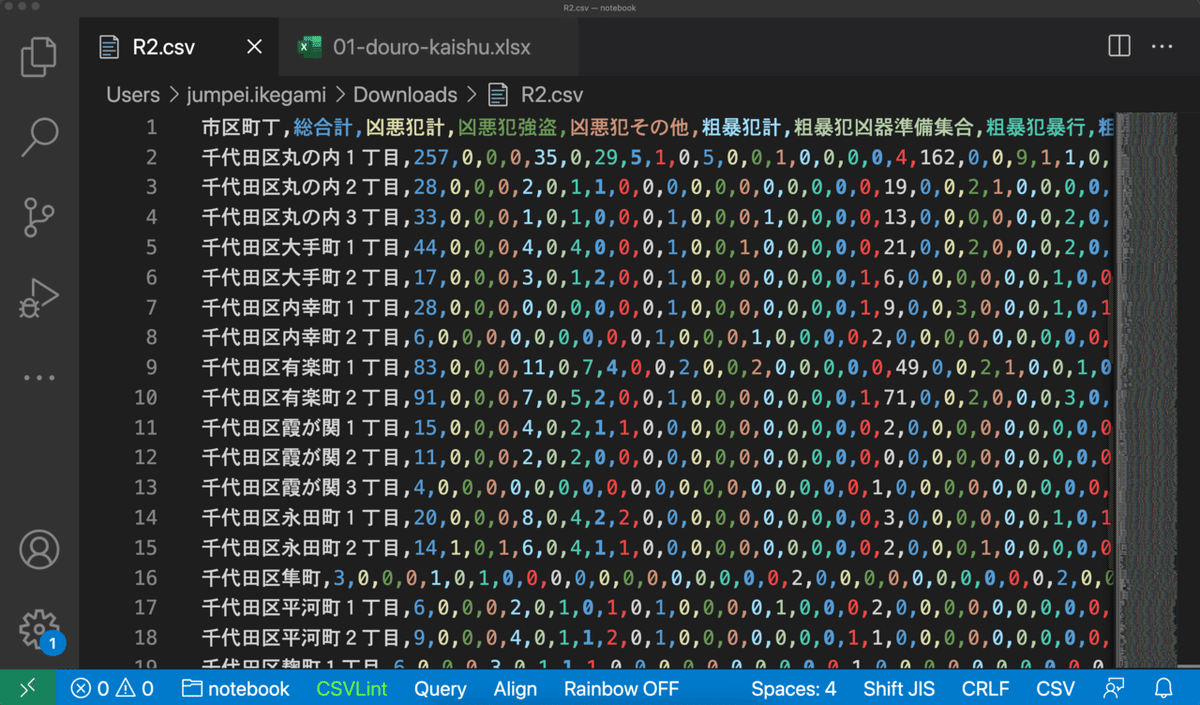

CSVファイルは、純粋に表データだけを含んでいるため、機械的な処理がしやすくなっています。

(サンプルデータ)

Excelを使うとデータが複製され続ける

「データと表現形式が切り離されていない」ことのもう一つの問題は、データがコピーされやすいということです。データと表現形式が分離されていない以上、データの見せ方を変えたいときも、データ自体を複製する必要があります。実際、他人が作ったExcelファイルやデータが入ったシートをコピーしてカスタマイズするようなことは、Excelを使っていると自然と発生します。

作業者それぞれのExcelファイル上でデータが複製・加工されることは、様々な問題を引き起こします。加工元のデータが更新されても、最新のデータを全てのExcelファイルに反映させることは普通できません。複数人が似たようなデータ加工をすることは、全体の作業効率も悪いです。セキュリティ上のリスクも上がるかもしれません。

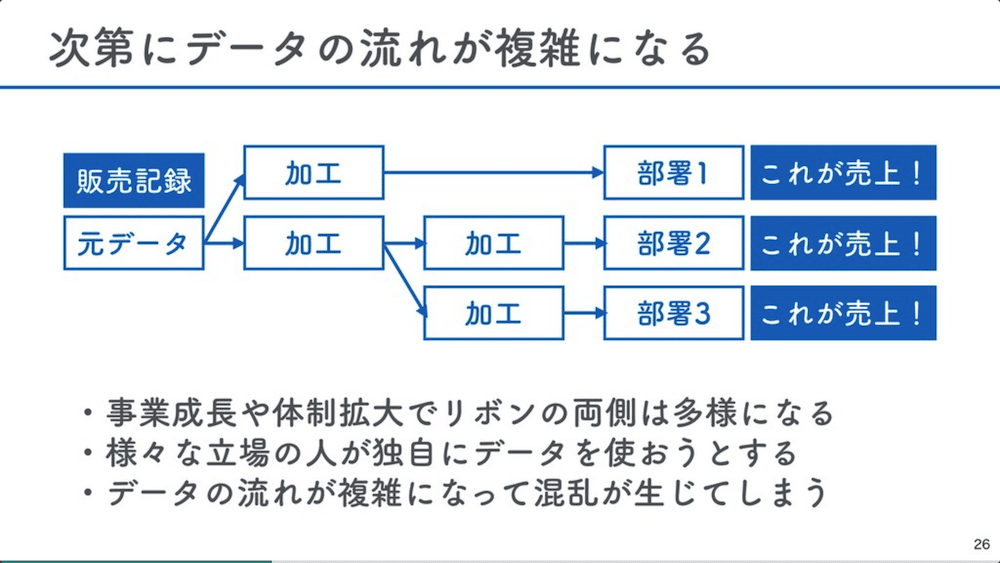

もちろん、扱っているデータが単純で種類が少なければ問題も軽くなります。しかし、事業が続いていけば、大抵は扱うべきデータや処理の内容はどんどん複雑化します。

(Data Platform Guide - 事業を成長させるデータ基盤を作るには - Speaker Deck p26)

このように、継続的に扱うデータや処理の複雑化が進むような状況下では、Excelファイルベースのデータ管理にはいずれ限界が来てしまいます。

データの管理と活用を分離するシステム

とはいえ、いきなりExcelに依存しないデータ管理システムを作れと言われてもよくわかりません。まずは、データを効率よく価値に変換できている企業の事例を見てみましょう。

メルカリのデータ分析基盤に関する発表スライドを見つけたので、眺めてみます。

特にp30を見ると、データの管理と活用が上手く分離されていることがわかります。

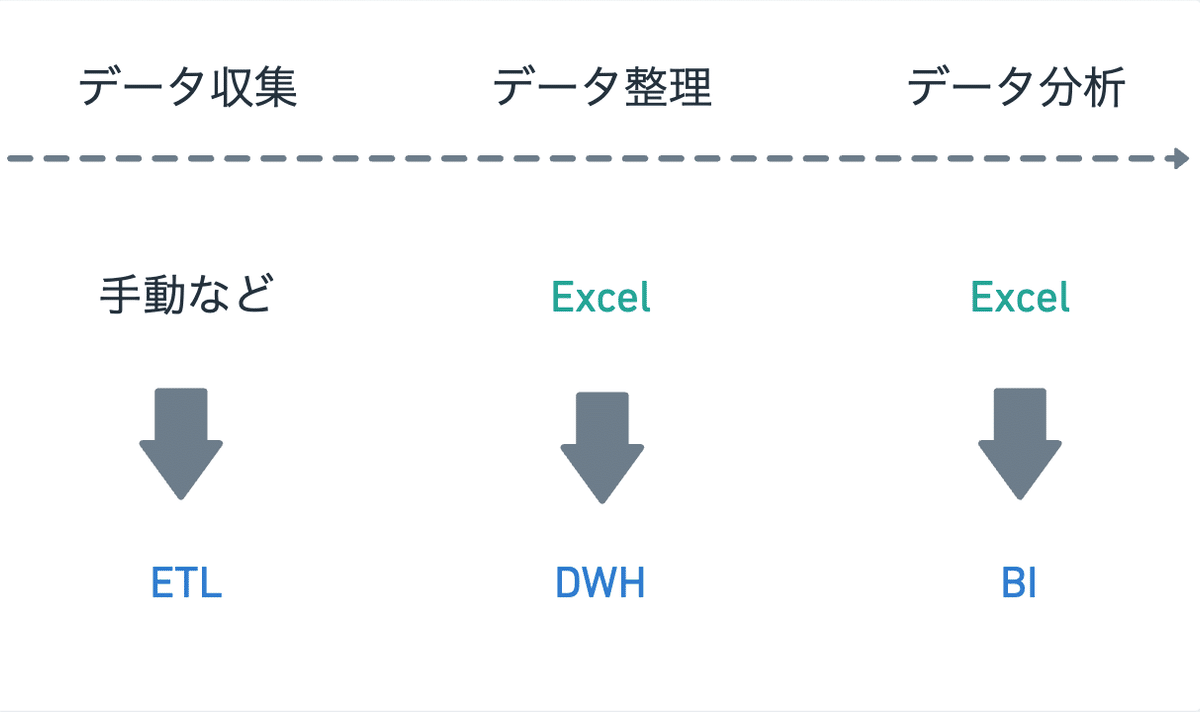

データを価値に変えるためのステップには大きく3つあります。

1. データを収集する

2. 1で集めたデータを整理する

3. 2で整理したデータを使って分析や可視化をする

このスライドでは、これら3つのステップが1. ETL、2. DWH(データウェアハウス)、3. BIに対応し、別々のツールが担っていることがわかります。

この資料で重要な点は2つあります。

1つは、誰でもデータ分析ができるような環境が作られているということです。Excelが流行っている理由は、データ分析の専門スキルが無い営業やマーケティングなどの社員であっても簡単に使えることです。どんなに高度なデータ分析基盤を構築しても、現場の社員が自由に使えなければ価値にはつながりません。ユーザーフレンドリーなETLやBIの導入によって、エンジニアじゃなくても新しいデータを連携したり自分なりのクエリやチャートを作ったりできるようになっています。

もう1つは、全員が共通の最新データを使って分析ができるという点です。Excelの大きなデメリットの1つは、データが複製され続け作業効率が悪くなるということでした。1つのデータウェアハウスに様々なデータを整理し保管することで、分析するときにはそのデータウェアハウス上のデータだけを見ればよくなります。また、ETLでデータウェアハウス上のデータを常に更新んし続けることで、「データが最新じゃなかった」というミスを無くすことができます。

ということで、脱Excelの先に目指すべき方向は、データの管理と活用を分離するシステムの構築ということになります。より具体的に言えば、データ収集部分をETLで自動化できるようにしつつ、データを整理・保存するDWHとデータを分析・活用するBIとを独立させる。これが、現状のベストプラクティスです。

実際、僕が働いている会社でも、同じような構成になっています。手元のデータをちょっと加工する目的でExcelやGoogleスプレッドシートを使うことはありますが、使いたいデータはほぼ全てBigQueryというデータベースに格納されています。誰もがその共通のデータを使って分析を回し、それを元にしたBI上のダッシュボードを見て意思決定をしています。

データを価値に変えるための変革

データ活用に関するよくある失敗の事例として、「トップダウンで導入したツールが全然使われない」というものがあります。莫大なコストをかけてツール刷新やデータ統合を進めたのに、現場の運用につながらず実際に価値を生むに至らないケースです。

上記のベストプラクティスにあるようなデータ基盤構築用のツールを導入するのは簡単です。しかし本当に難しいのは、それらを使って実際に生きたデータ分析基盤を構築することです。

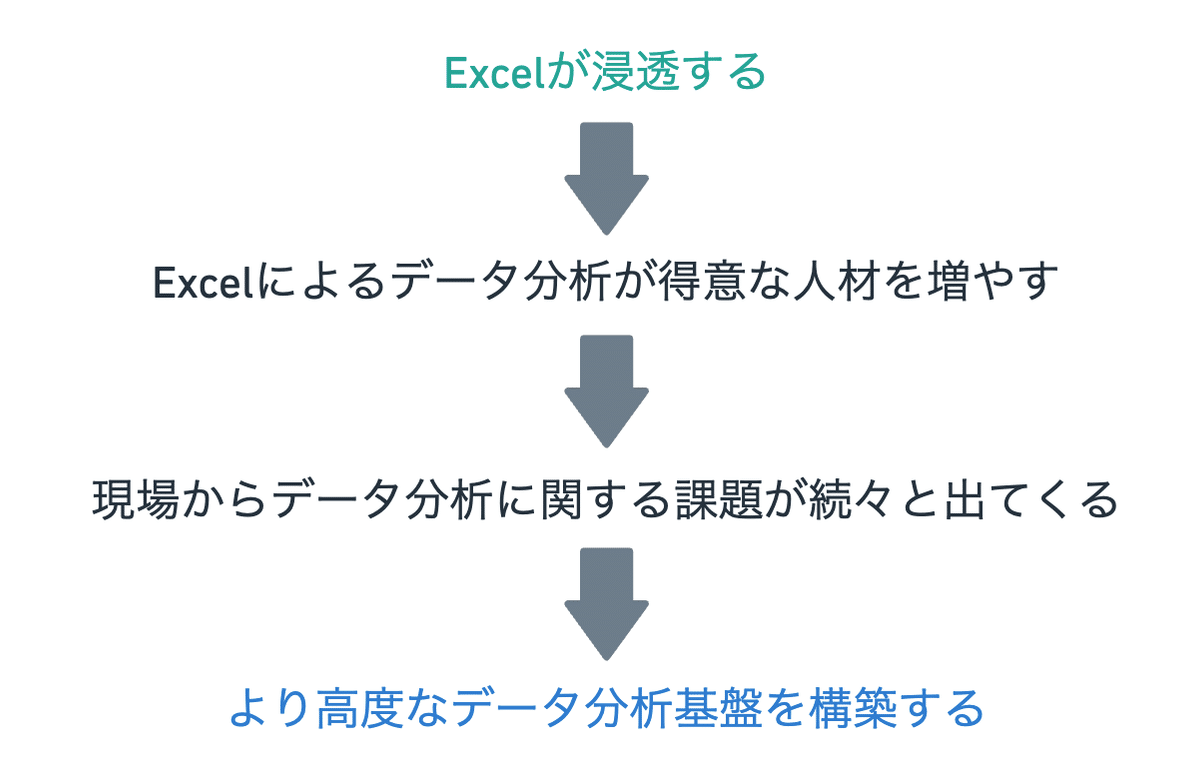

僕自身は、ボトムアップでのデータ分析基盤の刷新に関わったことがあるわけではありません。ただし、ワークマンがExcelをフル活用してデータ経営を推し進めた事例などを見ていると、まずは「Excelで徹底的にデータ分析できるようにする」ところから始めるのがよいのかもしれないと思い始めています。

データで話せるようになると、人は大きく変わります。自信のなかった人や、頼りなかった人が貴重な人材へと生まれ変わります。データは社員の人生を変える力があり、それは難しいことではなく、Excelから始めることができるのです。

「Excelで徹底的にデータ分析できるようにする」というと、ここまで紹介したExcelのデメリットと矛盾するように聞こえるかもしれません。しかし、Excelには「すでに現場に浸透している」という代えがたい強みがあります。同時に、多くの現場社員がExcelを使っていたとしても、「データ分析ができてる」とまでは言えない会社がほとんどだと思います。

ツールも文化も同時に変えるのは、とても難易度が高い。であれば、まずは使い慣れたツールでデータ分析文化を醸成し、その後でより適したツールに置き換えていくのがいいのかなあと、今は思っています。

DXにせよDWH構築にせよ、この手の話は言葉や理念だけが先行し、最も大事な現場が無視されがちです。僕としては、現場から徐々に変わっていくような、地に足のついた変革のためのステップが広く共有されると良いなと思います。

ここから先は

仕事を楽しくするデジタルリテラシー読本

【初月無料】デジタル時代の歩き方について考えたことを発信します。ソフトウェアの時代とは何か。エンジニアの頭の中はどうなっているのか。NoC…

サポートをいただけると、喜びドリブンで発信量が増えます!初月無料のマガジン『仕事を楽しくするデジタルリテラシー読本』もおすすめです!