世界最大規模のAIトップカンファレンス「NeurIPS 2023」参加報告

三菱UFJフィナンシャル・グループ(以下MUFG)の戦略子会社であるJapan Digital Design(以下JDD)にて、MUFG AI Studio(以下M-AIS)に所属し、データサイエンティストをしている山田です。

12月10日から16日にかけて米国・ニューオーリンズで開催されたAIカンファレンス「NeurIPS 2023」に参加しました。

NeurIPSでは様々な領域の機械学習の研究発表が行われていましたが、本投稿では、特に大規模言語モデル(以下LLM)を中心とした研究紹介をします。

本記事を読んで、研究内容や弊社への興味を持っていただけたら幸いです。

NeurIPS 2023について

NeurIPSは、AI(ニューラルネット)系の学会で最大規模の学会で、Fact Sheetを参照すると、参加登録者数は16,382人(内In-personが13,307, virtual: 3,075)と記載されており、非常に盛況でした。

7日間のスケジュールは以下のようになっています。

12/10: Expo

12/11: Workshop/Tutorial

12/12-14 本会議

12/15-16 Workshop

プログラムは7つトラックから構成されており以下の通りです。

7 Invited Talks

6 keynotes

1 panel

58 Workshops

14 Tutorials

20 Competitions

77 Orals

9 Socials

9 Affinity Group Workshops

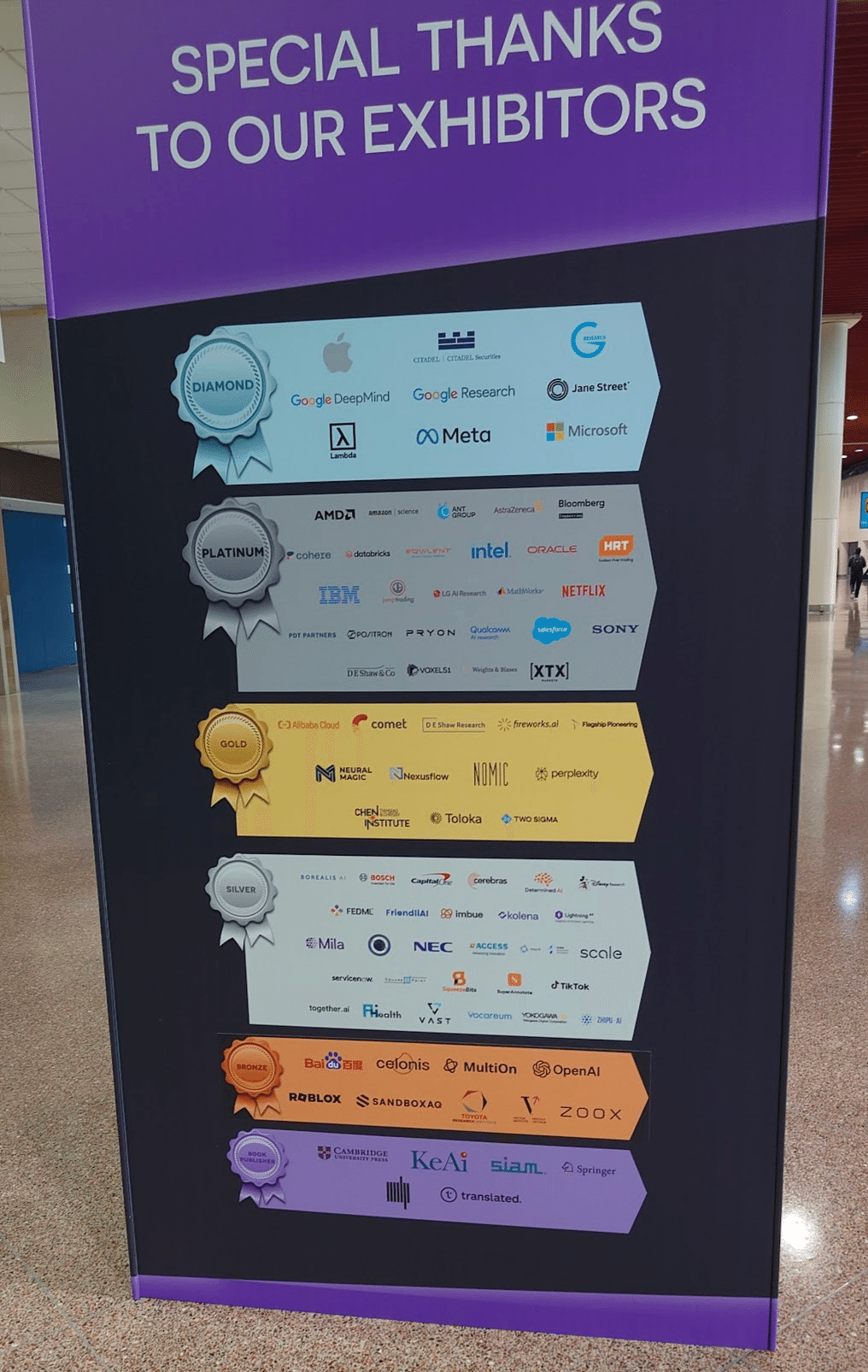

NeurIPSのスポンサーは企業も名だたる企業が勢揃いしておりますが、金融関連企業も参加していました。

次に、採択された論文のタイトルやアブストラクト中の頻出キーワードを見ると、ニューラルネット(neural network)、拡散モデル(diffusion model)、強化学習(reinforcement learning)、言語モデル(language model)といったものが出てきています。また、real world(実世界)というキーワードからもあるように、実データを利用するだけでなく、大規模言語モデル(large language model, LLM)を実世界に対応するための発表などもあり、こちらも印象に残っています。

また、LLM関連で特に興味深かった発表は以下の通りです。

効率よく学習させる方法

QLoRA (Dettmers et al.)

Direct Preference Optimization (Rafailov et al)

推論の工夫

Tree of Thoughts (Yao et al.)

ツールと組み合わせる

LLMを学習させる場合、大量のGPUが必要になります。しかし、QLoRAなどの手法が提案されたことによって大量のGPUを用意しなくても、700億パラメータの大規模言語モデルでさえ、市販のハイエンドGPUを複数枚用意すれば、精度をそれほど落とさずにファインチューニングが行えるようになっています。

ポスター発表では、開会式のスライド中に拡散モデルや強化学習といったキーワードが出ている通り、会場を見て回った時もこれらのキーワードは多く見られ、理論的な側面から研究されている発表が多い印象を受けました。

金融領域の発表

NeurIPSでは、金融領域の発表は例年少ないものの、今回は金融領域の発表が複数ありました。イントロでは、LLMに関する論文を載せましたが、今回の記事では、金融領域の発表内容にフォーカスを当てて、Datasets and Benchmarksのポスターに採択されていた研究内容とワークショップに採択された論文の発表内容を紹介しようと思います。

PIXIU: A Large Language Model, Instruction Data and Evaluation Benchmark for Finance (Xie et al., 2023)

https://openreview.net/forum?id=vTrRq6vCQH

こちらの発表では、オープンソースの金融特化LLMがないという課題を解決するために、金融特化LLMを作るための金融指示データセット(Financial Instruction Dataset, FIT)や金融評価ベンチマーク(Financial Language Understanding And PRediction Evaluation Benchmark, FLARE)を作成しています。そして、FITを使ってLLaMaを学習させることで、金融特化モデル(FinMA)を作成したという論文になっています。

引用元:https://openreview.net/forum?id=vTrRq6vCQH

公開されている金融特化モデルは以下の通りです。

(ここには記載されていませんが、後述するようにFinGPTと呼ばれるものもあります)

引用元:https://openreview.net/forum?id=vTrRq6vCQH

この表には、様々な金融特化言語モデルと、ベースとなるモデルやそのサイズなどが記載されています。

金融のための大規模な事前学習モデルにはBloombergGPT (Wu et al., 2023)があり、BLOOM (BigScience Large Open-science Open-access Multilingual Language Model)をベースとしたモデルです。Bloombergの研究者らは、どのようなデータを用いたかやモデルを構築する方法等について論文を公開しておりますが、BloombergGPT自体はクローズソースになっているため、一般には利用できません。

一方、FinMAでは、オープンソースであることに加え、指示データセットも用意されているため、金融特化モデルを利用するだけなく、構築することができるようになっています。

論文内で報告されている指示データセットは以下のようになっています。

引用元:https://openreview.net/forum?id=vTrRq6vCQH

こちらに載っているデータセットを簡単に解説していこうと思います。なお、Huggingfaceを見ると、上記に記載されているデータ以外にも、要約データセットや他言語のデータも用意されています。

Financial Sentiment Analysis

金融センチメント分析は、金融ニュース記事内の本文が、ポジティブやネガティブを判定する問題です。一般的なセンチメント分析と異なるのは、金融の文脈で判断をしなければならないということです。

例えば、以下のような文章についてポジネガ判定をしていきます。

### 指示: 金融ニュース記事から抜粋したこの文の感情を分析しなさい。ネガティブ、ポジティブ、ニュートラルのいずれかに答えなさい。

### テキスト: 世界最大の雑誌用紙メーカーである同社は、効率改善プログラムには競争力の低い工場の閉鎖も含まれ、同社の全事業が対象となるため、年間約2億ユーロ、2億4000万米ドルの節約になると述べた。

### 回答: ポジティブセンチメント分析では、LLMにこのような問題を答えさせるタスクになります。

FITで用意されているセンチメント分析のための指示データセットは、FLUE (Shah et al., 2022)に従っており、2つのデータセットを用意しています。

Financial Phrase Bank (FPB) (Malo et al., 2014), n=4,845

金融ニュース文章のセンチメント分析

ポジティブ・ネガティブ・ニュートラル

FiQA-SA (Maia et al.,2018), n=1,173

金融ニュースとマイクロブログポストのセンチメント予測

[-1, 1]のスケールで、1が最もポジティブ

News Headline Classification

テキスト中に価格動向などが含まれているか識別するためのデータセットです。

例えば以下のような文章です。

### 指示: 金価格が上昇している兆候を探す。ニュースの見出しの中で、金に関する「価格」か「価格でない」かを識別できますか?「Yes」または「No」で回答してください。

### テキスト: 12 月、金は 2.50 ドル高の 1,053.10 ドル/オンス、グロベックス

### 回答: YesGold news headline (Sinha and Khandait, 2021), n=11,412

金価格について2000年から2019年までのニュースヘッドラインです。

9つのラベルが用意がされています:

Price or Not

Price Up

Price Constant/Stable

Price Down

Past Price News

Future Price News

Past general News

Future General News

Asset Comparison

指示データセットでは、価格に関するニュースを識別するタスクになっています。

Named Entity Recognition(固有表現抽出)

固有表現抽出(NER)では、人(PER)、組織(ORG)、場所(LOC)といった金融のエンティティを検出するタスクになっています。ナレッジグラフを構築する場合などに用いられます。

FIN dataset (Alvarado et al., 2015), n=1,366

米国証券取引委員会(U.S. Security and Exchange Commission, SEC) 提出書類からの同意書

人手でLOCATION (LOC), ORGANISATION (ORG), PERSON (PER)がアノテーションされています

Question Answering

与えられた情報に基づき金融の質問に答えるタスクです。

PIXIUでは、2つのデータセットを用意されています。

FinQA (Chen et al., 2021), n=8,281

QAペアとS&P 500からの収益レポート(earning reports, 非構造ドキュメントやテーブル含む)

ConvFinQA (Chen et al., 2022), n=3,892

FinQAの拡張で,複数回にわたる質問(multi-turn question)の会話と収益レポートとの答え

例えば、ConvFinQAの問題は複雑で、LLMが回答するには、文脈(コンテクスト)も考慮する必要があります。

Stock Movement Prediction

Soun et al. (2022)に従い、2値分類問題としてタスクを定義しています。与えられた過去の株価データとツイートから株価のバイナリを予測するタスクです。回答するラベルとしては、価格動向において

0.55%よりも高い場合はポジティブ

-0.5%以下であればネガティブ

としており、3つのデータセットが用意されています。

BigData22 (Soun et al., 2022), n=7,164

CIKM18 (Wu et al., 2018), n=4,967

実験結果

どのようにLLaMAを学習してFinMAを作成したかに興味がある方は論文をご参照ください。

ここでは、結果について見ていきます。

引用元:https://openreview.net/forum?id=vTrRq6vCQH

先ほど紹介したデータセット以外に要約データやFOMCのタカハト分析といったタスクに関しても評価しています。

ここで注目すべき点は、左表のセンチメント分析(FPB・FiQA-SA)や識別タスク(Headlines)において、FinMA 7BがGPT-4の性能を上回っている点です。この結果が示すように小型のLLMにおいても適切に学習を行ってあげればGPT-4の性能を上回ることができます。

一方で、GPT-4では、汎用的に性能が高いことも注目すべき点です。全ての結果は3回行われており、”-”は結果が得られていない、”*”は以前の論文からの結果を引用しています。右表では株価動向予測についての結果になりますが、小型金融特化モデルでは、工夫された機械学習モデルの性能には及ばないことが示されています。

FinGPT

FinGPTは、オープンソースの金融LLMです。AI4Financeのグループによって開発されています。

FinGPT: Open-Source Financial Large Language Models

International Conference on AI for Finance (ICAIF’2023)でもこちらのグループらの発表はありましたが、NeurIPS 2023のInstruction Tuning and Instruction Following Workshopでも発表されていましたので、こちらも簡単に紹介したいと思います。

FinGPTの目的は、AI4Finance-Foundation/FinGPTから引用すると以下のように記載されていました。要約すると以下の通りです。

金融データは非定常性があり、過去と現在との傾向が変わるが、継続的なLLMの学習が非常に困難

BloombergGPTは、学習に64ノードのp4d.24xlargeで約53日

ファインチューニングならば数百ドル

インターネット・スケールの金融データを民主化を目指している。そのために自動データ・キュレーション・パイプラインを使用してタイムリーな更新(月次または週次更新)を可能とする

RLHF (Reinforcement learning for human feedback)を利用して、LLMが個人の嗜好(リスク回避レベル、投資習慣、パーソナライズされたロボアドバイザーなど)を学習することができる

上記にもあるように、金融領域に汎化させたLLMは、インハウスで作るとした場合、大量のコストがかかってしまいます。厳選された豊富なニュースソースをもつBloombergであるからこそできたのかとも感じます。金融LLMが、多くの人に利用できるように、自動データ・キュレーションパイプラインを作成し、ファインチューニングを行うというアプローチは理にかなっているかと思います。FinGPTでは、どのようにデータを集め、ファインチューニングを行うかなども全てOSSで公開されているため、利用する側としても非常に有用です。

さて、NeurIPSでは、以下の論文がInstruction Workshopにアクセプトされていました。

1. FinGPT: Instruction Tuning Benchmark for Open-Source Large Language Models in Financial Datasets

こちらの論文では、金融LLMのための指示チューニングのパラダイムや費用対効果のあるベンチマークスキームなどを提唱しています。

提唱されたパラダイムは次のように行っていきます。

タスク特有の指示チューニング(Task-Specific Instraction Tuning)固有表現抽出(NER)やセンチメント分析(SA)などの基本的な能力と基本的なタスクを評価し、専門性を高める。

マルチタスク指示チューニング(Multi-Task Instraction Tuning)包括的なモデルを掘り下げ、すべての指示チューニングを統合してマルチタスク演算を実行し、汎用性を検証する。

ゼロショットのための指示チューニング(Instruction Tuning for Zero-shot Ability)未知の領域における適応性を理解するために、未知のタスクをマークし、新しいデータセットを取り入れることにより、ゼロショット能力を探求する。

これら3つの指示チューニングを行って金融特化LLMを構築することができるか検討を行っています。利用したモデルは7B級で、キャパシティが限界であるためか、汎化させるよりもStep 1だけの指示チューニングをさせてタスク特化させたLLMで十分のように感じました。金融タスクによって複雑性や特殊性が大きく異なってしまうため、MMLU(Massive Multitask Language Understanding)のような汎化性能を測るためのベンチマークがないのも課題かもしれません。金融特化させた場合のMMLUの性能がどうなったのかについても気になりました。

2. Data-centric FinGPT: Democratizing Internet-scale Data for Financial Large Language Models

OpenReviewでのタイトルとPDFのタイトルが異なっているため、PDFに表示されているタイトルを記載しています。オープンソースかつデータセントリックなフレームワークである、Financial Generative Pre-trained Transformer (FinGPT)と、インターネット上の34以上の多様なソースからリアルタイムの金融データを集めてキュレーションの紹介になっています。また、これらのデータを使って、マーケットからのフィードバックを使ったReinforcement Learning with Stock Prices (RLSP)という、ファインチューニングされたFinLLMも提案しています。

多くの場合、金融時系列データは、S/N比が低く、データは非定常であることが多いです。特定の期間を学習したモデルが未来では使い物にならないということはよくあることです。このように刻一刻と変わるデータに適応できるかを確認しています。

Can we facilitate the democratization of financial data access and enable the efficient adaptation of FinLLMs to the evolving market landscape?

(金融データへのアクセスの民主化を促進し、進化する市場環境にFinLLMを効率的に適応させることができるだろうか?)

本論文で考えられているFinGPTのフレームワークは以下の通りになっています。

引用元:FinGPT: Democratizing Internet-scale Data for Financial Large Language Models" (Liu et al.)

この論文で紹介されているように、ニュースといったデータを自動で取得し、クリーニングするためのフレームワークを提供しています。

データセットが得られてしまえば、様々なLLMをファインチューニングすることで、ロボアドバイザーや定量トレードに特化したLLMを得ることができるようになります。

無償・有償を含めデータソースも複数利用できるようになっています。

複数のアプリケーションで、LLMをファインチューニングした結果を載せています。PIXIUのものと同様のセンチメント分析(FPB, FiQA-SAなど)だけでなく、センチメント分析の結果を定量トレードに利用した場合やロボアドバイザーなどの適用の実験も行っています。

FinGPTが生成したロボアドバイザーの部分を要約すると以下のようになっています。

2023年3月3日にAAPL株(アップル社)のニュース分析を行うために、工夫されたプロンプトを使用し、潜在的な傾向と将来の動向に焦点を当てています。

ニュースのプロンプト:

ニュースの簡単な要約と、アップル社の株価の動向について分析してください。様々な可能性を仮定した上で、トレンドの結果を出してください。

FinGPTの回答:

要約すると以下のようなことを生成していました:

アップル社(AAPL)に関する市場のニュースは多岐に渡り、そのファンダメンタルズ、クラウド事業への取り組み、インドでの新規投資などが話題。アナリストたちは、アップルが見落としている可能性のあるカタリストや、同社の主要な成長ドライバーとしてのサブスクリプションサービスに注目しています。

ポジティブな面:

モルガン・スタンレーはアップルを強く推奨し、株価目標を引き上げている

株価を押し上げる可能性のある5つの過小評価されたカタリストを指摘

ネガティブな面:

クラウド事業の責任者の退任

ChatGPTを利用したアプリ更新の拒否などのネガティブな報道も存在します。

総評

アップルの株価はポジティブなカタリストによって上昇する可能性があるものの、ネガティブなニュースによる影響も考慮する必要がある

株価の動向は不安定になり、多くの要因に左右される可能性があると言える。

このように既存のニュースから特定の銘柄に対して、株価に良い影響を与えるニュースと、そうでないニュースの要約が行えているように思えます。これらの結果は、GPT-4と比較しているわけではありませんが、ファインチューニングされたLLM(FinGPT)もある程度機能することが見て取れます。

まとめ

本稿では、NeurIPSで発表された金融領域の研究内容を紹介しました。LLMに関しては、紙面の都合上で全てを紹介はできませんでしたが、内容的にも面白いため、興味のある方はぜひご覧になってください。NeurIPSにアクセプトされた論文はOpen Reviewを通して確認することができますし、どのようなレビューがなされていたかも見ることでき参考になります。

NeurIPSは、AI研究の中でもトップ会議の1つです。久しぶりに現地で参加し、全体感を見ると、非常に洗練された内容が多く、多くの研究者らの熱量を再認識しました。今後の業務やR&Dに活かしていきたいと感じました。

一緒に働きませんか

M-AISでは、AI技術を軸に、顧客&データ起点で金融体験をアップデートすることに挑戦してくださる仲間を募集しております。

ご興味ございましたら、ぜひ採用情報をご覧ください。

免責事項

こちらに記載した内容は、NeurIPSで発表されていた「学術研究」に関するものであり、金融アドバイスではなく、実際の金融取引を推奨するものでありません。今後、予告なしに内容を変更または廃止する場合があります。なお、当該情報の欠落・誤謬等につきましてもその責を負いかねますのでご了承ください。

Japan Digital Design 株式会社

M-AIS

Researcher

Masatsugu Yamada