Google NotebookLMを使ってみた - もしかしたらかなり使えるかも!

昨年の12月に発表されたGoogleのNotebookLMというツール、自分が提供したデータのみを使って生成AIシステムを作ってくれる、という見た目はとても便利そうなツールです。

次のサイトからGoogleのアカウントで登録してすぐに使えるようになります。

今のところ、あんまり詳しいデータはネット上にないんですが、次のブログだけ、そこそに使い込んでいる人が自分の使いご事を解説してくれています。

早速、使い始めました。

Google Gemini 1.5の新しい機能として、LLMの性能向上に非常に寄与している Ring Attention というトランスフォーマ機能の紹介をしている記事を一つアップしました。

見ての通り、自動的に要約を作ってくれて(上の青い部分)、割と中身がしっかりしているしていることに感心。

さらに、もうちょっと長く、1000文字以内で要約をしてほしい、と要求したらこんな内容に。

結構しっかりしている内容です。ChatGPTと違って、指定したドキュメントのみを参照しているので、データの拠り所がしっかりしてます。

さらに、文書のどこから参照しているのか、ということも、Citationという機能で見つけることができます。

これは今まであまりみたことがない機能で、データの正確性を保証するのに非常に重要な機能だと感じました。ChatGPTは時々かなり変な答えを出してきてくるし、そのデータ、一体誰から学んだのか、トレースすることが全くできないので、結果的に信用のできないAIという状況、最近特に増えてきてます。

データのトレーサビリティ、非常に大事だと思います。

また、データの抽出を質問形式でできます。

質問1:LLM(Large Language Models)における埋め込み(embedding)プロセスと従来のトークン化(tokenization)アプローチの基本的な違いについて説明してください (What is the fundamental difference between the embedding process used in LLMs and the traditional tokenization approach?)

質問2:Ring Attentionアーキテクチャはどのようにして複数GPU間にわたってTransformer処理を分散化しているのか? (How does the ring attention architecture distribute the computation of transformers across GPUs?)

言うまでもなく、どの質問に対しても指定した文書の中から答えを見つけてきます。ChatGPTのようにインターネットから収集した知識ベースを使いません。

質問から来た答えをメモ形式で保存することができます。こういうノートをいっぱい作って、自分の好きなフォーマットでブログ記事やレポートを作成することができる、という点が新鮮です。

データの収集はAIにやらせて、最終的に作る文章の構成は人間がちゃんとコントロールできる、いい使い方の一例になるかな、と期待してます。

そんな感じで、ノートブックをいっぱい作っちゃいました。

最近はAIのプロジェクトばかりなので、生成AIのキーワードばかりですが、どれも興味深い分析をすることができていい感じでライブラリができて、キーワードごとにデータソースを整理しながら、それぞれのキーワードに対して深堀した記事やブログを書くことができるプラットホームのようなものができました。

今日のキーワードはKnowledge Graphです。グラフデータベースの技術を使って、LLMの精度向上、ハルシネーション防止、意味的検索の質的向上、など現在のベクトルデータベース主体のLLMの課題を解決する魅力を持っている手法の一つです。

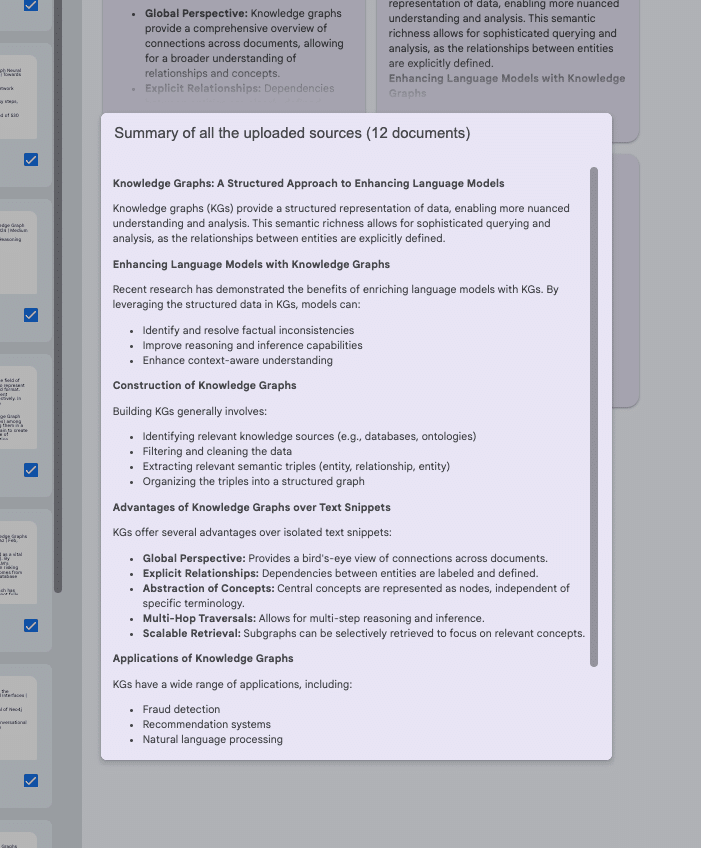

データソースはいろんなブログ、12個集めて全てアップロードしました。Gemini-1.0-Proでのグラフの採用について、Mistral-7bでのグラフ使い方、ハルシーネーションの検知手法、Causal Graph(データの因果関係をグラフで表記する手法)の使い方、など、多方面に及びます。

全部(12個)のデータソースの要約を100文字以内に書かせるとこんな感じ

これでブログを書こうとした場合のアウトラインを要求したらこれ

それぞれの項目については文字数制限をつけて要求をすれば、ちょっと手間はかかるけどかなり立派なレポートが書けます。

どういう質問をしたらいいのか、よくわからなかったら、下の方にサンプルの質問がいくつか出てきます。よく見ると結構ディープな質問例があります。明らかにアップした文書を読み込んで、想定される質問をあらかじめ作成しているのがわかります。

ボタンを押せば答えがててきます。

まだ触り始めたばかりですが、かなり使えそうな印象を受けたので、これからのブログ記事もこのツールを活用しようかな、と思ってます。

ちなみに、日本語は全くダメみたいなので、英語で全部操作して、出来上がったレポートを日本語訳する、とう段取りです。

果たして楽になるのか、さらに沼ってしまうのか、まだわかりませんが、頑張ってみます!