Save The Metro Compilations Day2ライブの配信システム

2020.06.27にオンライン&オフラインで開催された「Save The Metro Compilations」イベント、3日間にわたる2日目にSPEKTRAとして出演した。いつもお世話になっているKen'ichi Itoiさんにお声がけいただいた形。ありがとうございます。その際のシステムについて書き残そうと思う。

以下文章の流れによって適宜敬称略。

こんなイベント

【明日6/27 開催!】

— 京都メトロ (@metro_kyoto) June 26, 2020

『Save The Metro Compilations』

curated by Ken'ichi Itoi

20:00~24:00(JST)@Metro

LIVE:

Ken'ichi Itoi

Sawa Angstrom

Junichi Akagawa

HIRAMATSU TOSHIYUKI

Naohiro Tomisawa

VJ:

SPEKTRA

配信URLhttps://t.co/x2e9OhxJoT

入場は要事前予約:1000yen+1d(限定20人) pic.twitter.com/UhtPQYLBVU

junichiakagawa!!! pic.twitter.com/Glk6hMtqYZ

— Kousei Ikeda (@ikekou) June 27, 2020

昨日のVJで1番良かったと思ってるところ.#touchdesigner #glsl pic.twitter.com/NmCuHZnFGo

— 𝙎𝙖𝙣𝙩𝙖 (@santa_sukitoku) June 28, 2020

Ken'ichi Itoiキュレーション、ライブはKen'ichi Itoi、Sawa Angstrom、Junichi Akagawa、HIRAMATSU TOSHIYUKI、Naohiro Tomisawaが出演。

ライティング、現場の映像、配信に乗せる映像、システム全体、をSPEKTRAが担当した。カメラオペとストリーミングはCLUB METRO。

あと転換時に使う用の画像作ったりなんだり。なんか色々やった。

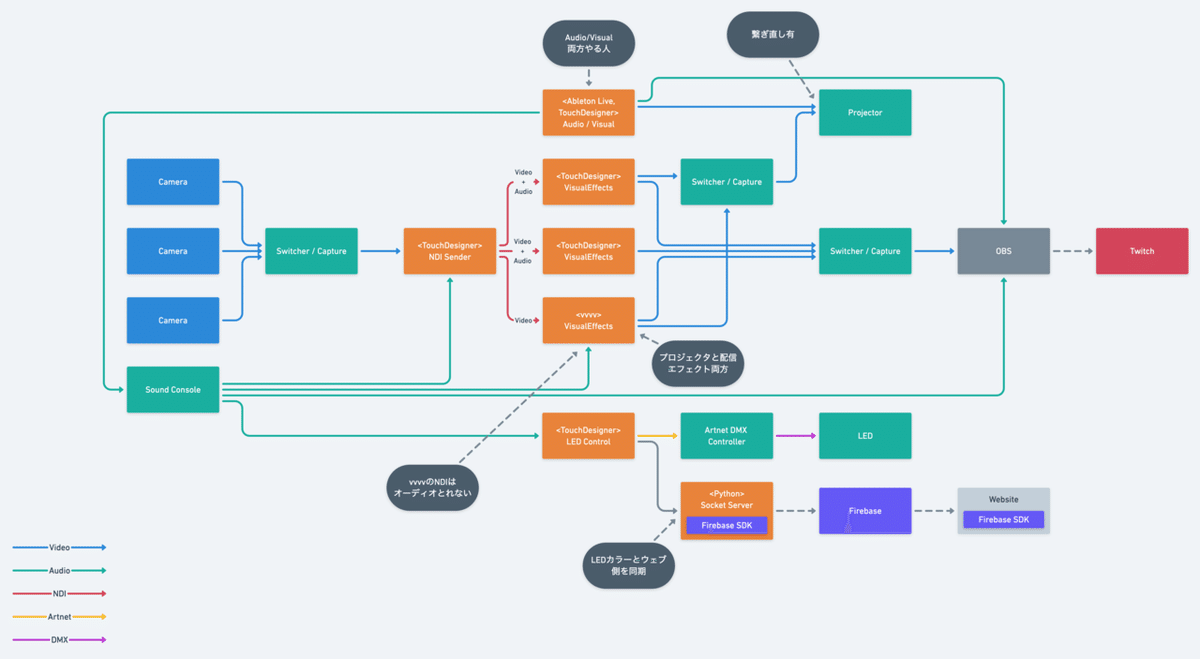

システム構成

Nippon Connection 2020でのSawa Angstromライブの配信システム|kousei ikeda|note とそんなに大きくは変わらないが。

- カメラ x3

- カメラオーバーレイ映像 x3

- プロジェクションも同時にやる人 x2

- オーディオビジュアル両方やる人 x1(Junichi Akagawa、この日はSPEKTRAとしてではない、アーティスト個人としての出演だがシステムには含んだので書いている)

- 配信はTwitch

- LEDシステムあり

- ウェブ連携のギミックあり

システム全体は、今回は僕イケダがベース作って、その後細かくまとめだり段取りしてくれたりをSaccoが担当した。

データフロー

カメラ3台を1台のスイッチャで受けてPCでさらに受けてNDIでネットワークに流す。

↓

各映像担当のPCからはストリーミング用の1出力、またはそれプラスプロジェクションの2出力。

↓

配信用のPCが受け取ってTwitchへ。

映像はAMAGI 、Yuta Inada、Santa の3人が担当。

カメラのスイッチも重要で、そのあたりはSaccoとToyoshi Moriokaがいい感じに。

LEDとウェブ

かっちょいい〜@santa_sukitoku @ikekou @spktrjp https://t.co/76B9UgRJtZ pic.twitter.com/xUHmuTX0nT

— asaco/sacco (@nomnommorn) June 27, 2020

映像システム以外にも、今回もLEDシステムがあり。そこは

60LED/60pxのLEDバー Super ScenografixをTouchDesignerから使う|kousei ikeda|note https://note.com/ikekou/n/n5d0c258e794a

Nippon Connection 2020でのSawa Angstromライブの配信システム|kousei ikeda|note https://note.com/ikekou/n/nd3576cad9918

この辺りを詳しくはみてもらうとして。

今回の試みとして、特設のウェブサイトを作って、そこにTwitchを埋め込み、そのウェブサイトの背景と現場のLEDと同期させてみる、というものを作ってみた。

同期にはFirebase Realtime Databaseを使っている。

今回、配信twitchみれつつ現場のLEDと背景色をシンクするサイトをひとネタ作りました。メイン構築は @santa_sukitoku 、あと @nomnommorn もやってくれて、僕もちょっと。部屋を暗くして画面広げて観るとメトロにいる気分になれるハズ…!

— Kousei Ikeda (@ikekou) June 27, 2020

SaveTheMetroDAY2 https://t.co/Fiwp2ObCow pic.twitter.com/CRC4JUQKMo

データフローとしてはこんな感じ。

TouchDesigner

↓

(TouchDesigner外に立てた)ローカルPythonサーバ

↓

Firebase Realtime Database

↓

ウェブサイト

見ての通りまあ当然遅延はあるんだけど、そこはどうせ配信の遅延もあるし、そしてそれを同期するのはちょっとつらかったので、ウェブサイトの背景色をふんわり同期させるっていうピッタリあってなくてもいい表現にした。変化もパっと変えるのではなくフェードさせてる。

現地でも色をすごい変えるというよりは、色はしばらく一緒でパターンや動きで変化を付けてた感じ。現地でも色はフェードさせてる。

家を暗くして画面を開くとなんとなく画面/背景色が照明の代わりになって部屋がその色になるといいなって思った。

僕イケダがなんかこういうことできるんちゃうかな〜って言って、主に作ってくれたのはSanta、あとSacco が見た目整えたりテストとかしてくれて、僕もちょっと実装の手直しとかした。

現場と配信同時にやる難しさ

配信だけ、現場だけ、というより両方やるのはなかなか課題が大きいなと思った。

どっちも大事、っていうのはもちろんそうだし理念を掲げるだけは簡単なんだけど、そのどっちもをどう実現するのか。どういう表現にするのか。

単純計算すると、リソースは倍必要で、そうすると複雑性は4倍になる。お金も時間もあるプロジェクトはそうしましょうでいいんだけど、実際には色々な制約もある。

配信のみのライブでは、当たり前だが現場がいい感じである必要はなく、配信映像がいい感じであればよい。プロジェクションは必要ではない。もちろん使ってもいいし、背景に映像を出したければクロマキーしてもいいし。まあ色々ある。と同時にオーバーレイしたりっていう映像エフェクトも概ねやることになる。

これが配信+現地だと、単純に、プロジェクション出力と、映像エフェクトの二系統になる。素材作りのコストは上がる。

そういうシステムや物量の面だけでなら頑張って乗り越えれば良いのだが、まだ悩ましい問題もあって。会場の暗さや、照明の明るさ、などだ。

普段のクラブだと会場はかなりくらい。そこに明るい映像やパキっとした照明でもメリハリがつく。だけど、配信だと、カメラを通してしか見れないので、そして普通のカメラは人間の目より明暗の差をいい感じには処理してくれないので、会場は概ね明るめにしているものが多いだろう。

配信の場合は、明るめにして、そこに映像エフェクトを乗せる、のは一つの正解だろうと思う。

だけどそんなにあんまり明るいと、現場の客としてはちょっとなんかやっぱり違うのである。

照明も、色が、カメラ上ではかなり飛んでしまう。乗せようとすると輝度を結構下げないといけない。だけど現地だとそれだとなんだか結構くらい。

とかで、完全に両方に最高、となるパラメータは自分の中でまだ見つかってなくて。単に高いカメラを使えばダイナミックレンジが足りるからそれでいいみたいな話なのか・・・?

さらにいうと、倍以上のコストかけて両方に良い体験にしたとしても、個々人の体験としてはそのどちらかでしかない。ウェブサイトのブラウザ対応のコストみたいだ。笑

となると、もし有料だとしてもそこに倍の価格にするわけにはいかない。となると、価格は据え置きだと仮定すると倍以上に集客しないといけない。もちろん、ウェブでの客入れには上限が(会場に比べれば)ないので、集客できれば、うまくそれはみんなハッピーである。でもでも、今一部の大物アーティストがすごい集客してハッピーみたくなってるけど、あれは同じようなものを何度もやってもリアルライブのようには集客は続かないと僕は思っている。

過渡期だから両方やってるという気もするし、でも多くの人にみてもらえるという意味では両方やるのはいいことだし、これは継続してそういうスタイルにもなるような気もしていて、何かもう少し自分の中にしっくりくるスタイルというかシステムにたどり着きたい気持ちがある。

まあそんな感じで。ありがとうございました!

泣けるほどみんなかっこよかった

— asaco/sacco (@nomnommorn) June 27, 2020

ここに今これてよかった pic.twitter.com/fgHECIT6Bx

Visual Hacker @amagitakayosi x @SawaAngstrom @metro_kyoto pic.twitter.com/WiSWp1jvnl

— 𝙎𝙖𝙣𝙩𝙖 (@santa_sukitoku) June 27, 2020

VJ3人照明1人配信周り2人の体制でやっております pic.twitter.com/n5N2eYjcbZ

— 𝘼𝙈𝘼𝙂𝙄 (@amagitakayosi) June 27, 2020

はてなブログに投稿しました #はてなブログ

— 𝘼𝙈𝘼𝙂𝙄 (@amagitakayosi) July 3, 2020

京都メトロで配信VJをした - マルシテイアhttps://t.co/WEVdIObqgb

昨日のVJで1番良かったと思ってるところ.#touchdesigner #glsl pic.twitter.com/NmCuHZnFGo

— 𝙎𝙖𝙣𝙩𝙖 (@santa_sukitoku) June 28, 2020

クレジット

Curation :

Ken'ichi Itoi (https://twitter.com/KenichiItoi)

Live performance :

Ken'ichi Itoi (https://twitter.com/KenichiItoi)

Sawa Angstrom (https://twitter.com/sawaangstrom)

Junichi Akagawa (https://twitter.com/junichiakagawa)

HIRAMATSU TOSHIYUKI (https://twitter.com/hi_ramatt)

Naohiro Tomisawa (https://twitter.com/NaohiroTomisawa)

Lighting Design & Visual Effects : SPEKTRA (https://twitter.com/spktrjp)

SPEKTRA are (A-Z)

Lighting & Progress Management & System Design & Web : Kousei Ikeda (https://twitter.com/ikekou)

Visual Effects : AMAGI (https://twitter.com/amagitakayosi)

Visual Effects : Yuta Inada (https://twitter.com/inada_yuta)

Visual Effects & Web : Santa (https://twitter.com/santa_sukitoku)

Progress Management & Switching & System Design & Web : Sacco (https://twitter.com/nomnommorn)

Switching & Technical support : Toyoshi Morioka (https://twitter.com/mogamogamachine)