【人為的なリスクにどのように対処すべきか】人類の絶滅

こんにちは。いつもお越しくださる方も、初めての方もご訪問ありがとうございます。

今回はwikipedia英語版「Human extinction」の記事を翻訳をします。

翻訳は主にChatGPTもしくはXのGrokなどの生成AI、補完的にDeepLやGoogle翻訳などの翻訳ツールを活用しています。

部分的な補正や修正のみを行っています。翻訳のプロではありませんので、機械翻訳による誤訳などを上手く訂正できていないと思います。翻訳論争はしませんのであしからず。

日々向上する翻訳機能には感謝しかありません。

英語をはじめとする外国語の情報には一般の日本人が全く知らないものが数多くあります。少々仰々しいですが「海外の常識を日本人の常識に」ということを目標に、特に歴史的流れや概念の意味を掴めるようにすることを第一優先課題としています。

注意事項:当サイトで掲載されている翻訳記事は、私個人の見解や意見を代表するものではありません。

人類の絶滅

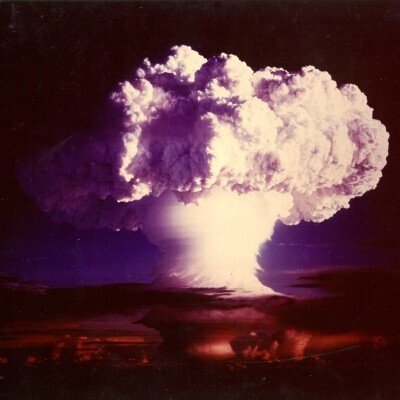

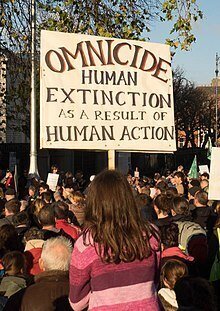

人類の絶滅、またはオムニサイドは、人類という種の仮説上の終焉を指し、隕石衝突や大規模な火山活動といった外的な自然要因による人口減少、あるいは人為的な破壊(自己絶滅)によって引き起こされる可能性がある。

人為的な危険の要因として考えられるものには、気候変動、世界規模の核戦争、生物兵器、大量破壊兵器、そして生態系の崩壊などがある。また、先端的な人工知能、バイオテクノロジー、自己複製するナノボットといった新興技術に関するシナリオも存在する。

科学的なコンセンサスとして、自然要因による近い将来の人類絶滅のリスクは比較的低いとされている。しかし、人類自身の活動による絶滅の可能性については、現在も研究と議論が続いている。

思想史

初期の歴史

18~19世紀以前、人間や他の生物が絶滅する可能性は懐疑的に見られていた。これは「充足の原理」に反するものであり、この原理は「あらゆる可能なものが存在する」という教義だった。この考え方はアリストテレスにさかのぼり、キリスト教神学において重要な要素となっていた。プラトン、アリストテレス、ルクレティウスといった古代の哲学者たちは、人類の終焉を単なる再生のサイクルの一部として論じていた。シノペのマルキオンは反出生主義を唱え、人類の絶滅につながる可能性のある思想を提唱した。

ギリシアの哲学者プラトン

その後、アル=ガザーリー、ウィリアム・オッカム、ジェロラモ・カルダーノといった哲学者たちは、論理学や確率の研究を発展させ、抽象的な世界、例えば人類のいない世界が存在しうるのかを考察し始めた。物理学者エドモンド・ハレーは、人類の絶滅が世界の未来にとって有益かもしれないと述べている。

イタリアの医師・哲学者・数学者ジェロラモ・カルダーノ

イギリスの天文学者エドモンド・ハレー

種が絶滅するという概念が科学的に受け入れられるようになったのは、17~18世紀の啓蒙時代になってからだった。1800年までにジョルジュ・キュヴィエは23種の絶滅した先史時代の生物を特定していた。この教義は、特に化石の発見によって、かつて存在したが今は見られない種の証拠が明らかになるにつれて、徐々に崩れていった。また、進化論の発展も影響を与えた。

ダーウィンは『種の起源』の中で、絶滅を自然のプロセスであり、自然選択の核心的な要素であると論じた。ただし、ダーウィンは突然の絶滅の可能性には懐疑的であり、それを緩やかな過程と見なしていた。化石記録から種が急に消える現象についても、それが壊滅的な絶滅の証拠ではなく、記録の未発見の空白にすぎないと考えていた。

科学の分野で絶滅の可能性が広く受け入れられるようになるにつれて、人類の絶滅の可能性もまた考察されるようになった。19世紀には、人類の絶滅は科学(例:トマス・ロバート・マルサスの『人口論』)や文学(例:ジャン=バティスト・クザン・ド・グランヴィルの『最後の人間』)で取り上げられる人気のテーマとなった。ダーウィンが『種の起源』を発表してから数年後の1863年には、ウィリアム・キングがネアンデルタール人をヒト属の絶滅種であると提唱した。

アイルランド系イギリス人地質学者ウィリアム・キング

ロマン派の作家や詩人たちは、このテーマに特に関心を持っていた。バイロン卿は1816年の詩「暗黒」で地球上の生命の絶滅について描き、1824年には彗星衝突による人類の危機と、それに対抗するミサイル防衛システムを想像した。メアリー・シェリーの1826年の小説『最後の人間』では、人類が謎の疫病によってほぼ滅亡した世界が描かれている。20世紀初頭には、ロシア宇宙主義が登場し、人類の宇宙進出によって絶滅を回避すべきだと主張した。この思想は後のトランスヒューマニズムの先駆けとなった。

イギリスの小説家メアリー・シェリー

『月世界到着!』 (1893)の挿絵

原子の時代

原子爆弾の発明は、科学者や知識人、そして一般の人々の間で、人類絶滅のリスクについての議論を引き起こした。1945年のエッセイで、バートランド・ラッセルはこう書いている。

人類の未来は、これまでにないほど暗いものとなっている。我々は明確な選択を迫られている。すなわち、全員が滅びるか、あるいはわずかばかりの良識を身につけるかのどちらかだ。

1950年、レオ・シラードは、地球を居住不可能にするコバルト爆弾を技術的に製造できる可能性を示唆した。同年に行われたギャラップ世論調査では、アメリカ人の19%が「次の世界大戦は人類の終焉を意味する」と考えていた。1962年、レイチェル・カーソンの著書『沈黙の春』は、環境破壊による大惨事の危険性を広く認識させるきっかけとなった。1983年には、ブランドン・カーターが「終末論的論証」を提唱し、ベイズ確率を用いて「人類がこれまでに何人存在するのか」を予測しようとした。

アメリカの生物学者レイチェル・カーソン

オーストラリアの理論物理学者ブランドン・カーター

1980年代初頭には、「核の冬」という概念が発見され、核戦争によって人類が絶滅する具体的なメカニズムが明らかになったことで、この問題が再び注目を集めた。1983年、カール・セーガンはこの研究に関連して、「絶滅の深刻さを単に死者の数で測ることは、その本当の影響を覆い隠してしまう」と指摘し、さらに「核戦争は、未来のすべての人類を危険にさらす」と警告した。

冷戦後

ジョン・レスリーの1996年の著書『世界の終焉』は、人類絶滅の科学と倫理を学術的に論じたものだった。この中でレスリーは、人類に対するさまざまな脅威と、それらに共通する要素について考察した。

2003年には、イギリス王室天文学者のマーティン・リース卿が『われわれの最後の時』を発表し、特定の技術の進歩が人類存続の新たな脅威を生み出していると主張した。リースは、21世紀が人類の運命を決する歴史的な転換点になる可能性があると警告している。

2008年には、ニック・ボストロムとミラン・M・ツィルコヴィッチが編集した『地球規模の破滅的リスク』が出版された。この書籍は26人の学者による論文をまとめたもので、地球規模の破滅的リスクや実存的リスクについて論じている。

2020年には、トビー・オードが『崖っぷち――実存的リスクと人類の未来』を発表し、実存的リスクの防止が現代における最も重要な道徳的課題の一つであると主張した。オードは、さまざまな実存的リスクを分析・比較し、最大の脅威は制御されていない人工知能とバイオテクノロジーにあると結論づけている。

原因

人類絶滅の可能性がある人為的要因には、世界規模の熱核戦争、高度な生物兵器の使用、生態系の崩壊、暴走する人工知能、暴走するナノテクノロジー(グレイグー・シナリオなど)、過剰な人口増加と消費による資源枯渇とそれに伴う人口崩壊、出生率の低下による人口減少、さらには遺伝子操作や技術的強化によって生み出された新たな種が自然進化した人類を置き換えることなどが含まれる。

グレイグー(もしくはグレイ・グー。英語: gray goo; 「灰色のどろどろ」といった意味)とは、自己増殖性を有するナノマシンが、全てのバイオマスを使って無限に増殖することによって地球上を覆う世界の終焉を想定した架空の事象。エコファジー(「環境(生命維持環境)を食べる」の意)という事象の一種である。

自然または外的要因による絶滅のリスクには、高致死率のパンデミック、スーパー火山の噴火、小惑星衝突、近傍の超新星爆発やガンマ線バースト、極端な太陽フレア、異星人による侵略などが挙げられる。

人類(ホモ・サピエンス・サピエンス)という種は、直接絶滅しなくても、進化の結果として遠い子孫によって置き換えられることで「絶滅した」とみなされる可能性もある。

予想外の外的要因が介在しない限り、太陽の恒星進化によって地球はやがて居住不可能となり、最終的には破壊されると考えられている。その後の宇宙の運命次第では、やがて宇宙全体が居住不可能になる可能性もある。

確率

自然要因と人為的要因

専門家の間では、自然要因による絶滅リスクよりも人為的要因による実存的リスクのほうが(はるかに)高いと考えられている。これらのリスクの大きな違いは、自然リスクについては経験的証拠によって上限を推定できる点にある。人類は少なくとも20万年間存続しており、その間、自然リスクのレベルはおおよそ一定だったと考えられる。もし自然リスクが非常に高ければ、人類がこれほど長く生き延びることはほぼ不可能だったはずだ。この議論を定式化した研究によれば、自然リスクの確率は年間1/14,000(世紀あたり平均1/140)以下であると自信をもって推測できるという結論が出されている。

自然リスクの確率を調査するもう一つの方法は、地質記録を分析することだ。たとえば、人類を絶滅させるほどの「衝突の冬」を引き起こす規模の彗星や小惑星衝突が2100年までに発生する確率は100万分の1と推定されている。また、大規模なスーパー火山の噴火も、火山の冬を引き起こし、人類の生存を脅かす可能性がある。地質記録によると、スーパー火山の噴火は平均して5万年に1回程度の頻度で発生しているが、その多くは人類を絶滅させるほどの規模には達しないと考えられている。有名な例として、トバ火山の大噴火が過去に人類をほぼ絶滅させた可能性があるが、この説には異論もある。

一方で、人為的リスクは比較的最近になって現れたものであるため、これまでの人類の生存実績は、同じような保証を与えてはくれない。人類は核兵器が生まれてからわずか79年間しか生き延びておらず、今後登場する新たな技術に関しては、過去の実績がまったくない。このことから、カール・セーガンのような思想家は、現在の人類が「危機の時代」にあると結論づけている。つまり、人類が自らの行動によって存亡の危機に晒されるようになった時点から、これまでにないレベルのリスクに直面しているという考え方だ。

古生物学者のオレヴ・ヴィンは、人類が進化の過程で受け継いできた行動パターンの多くは、技術文明の条件に適合していない可能性が高いと指摘している。むしろ、一部の行動パターンは技術文明と著しく相性が悪く、人類の自己破壊を引き起こす要因となりうる。例えば、他の個体を支配しようとする行動や、エネルギーの収集・消費に関する欲求が、そのようなリスクをもたらす可能性がある。ただし、こうした遺伝的な行動パターンに対処する方法も存在すると考えられている。

リスクの推定

通常の観察やモデリングには限界があるため、確率の推定には専門家の意見を引き出す手法がよく用いられる。

J・リチャード・ゴットによる論争の的となっている終末論的議論(doomsday argument)の考え方に基づけば、人類は780万年以内に95%の確率で絶滅する。この理論では、人類の歴史の半分はすでに経過している可能性が高いとされる。

終末論的議論(Doomsday Argument)は、統計的推論を用いて人類の未来を予測しようとする哲学的議論の一つ。J・リチャード・ゴットが提唱し、ジョン・A・レスリーなどが発展させた。終末論と翻訳されることもあるが、一般的に使用される終末論(Eschatology)とは意味が異なる。

1996年、ジョン・A・レスリーは今後500年の間に30%の絶滅リスクがあると推定した(1世紀あたり平均6%)。

2003年、マーティン・リースは21世紀中に文明が崩壊する確率を50%と見積もった。

2016年のグローバル・チャレンジ財団の年次報告書では、人類が年間0.05%以上の確率で絶滅する可能性があるとされており、これは1世紀あたり5%に相当する。

2025年2月20日時点で、Metaculusのユーザーは2100年までに人類が絶滅する確率を0.5%と推定している。

2020年に『Scientific Reports』に掲載された研究によると、現在のペースで森林破壊と資源消費が進めば、今後20~40年で「人類の人口が壊滅的に減少」し、さらには「文明が不可逆的に崩壊」する可能性がある。この研究の最も楽観的なシナリオでも、人類文明が存続する確率は10%未満とされている。この崩壊を防ぐには、経済中心の文明から「生態系の利益を個々の利益よりも優先し、最終的には共同体全体の利益と調和する文化社会」へと移行する必要があると研究は指摘している。

オックスフォード大学の哲学者で、実存的リスク研究で知られるニック・ボストロムは、近い将来の絶滅確率を25%未満と仮定するのは「誤った考え」だとし、「人類が一度で完全な予防策を整えるのは非常に難しい」と述べている。実存的リスクは、一度でも失敗すれば学習の機会がないからだ。

哲学者ジョン・A・レスリーは、今後500年間に人類が生存する確率を70%と見積もっている。その根拠の一部は、レスリーが支持する終末論に基づいている。彼の主張はある程度頻度論的であり、「人類の絶滅はこれまで観測されたことがない」という点に依拠しているが、主観的な人間原理的議論も必要とする。レスリーはまた、人類の存続に関する観測選択バイアス(p.139で「観測選択効果」と呼ぶ)についても論じ、「破滅的な過去を観測することができないという先験的な確実性があるため、『これまで何も起きていないから安全である』という主張は成立しにくい」と指摘している。彼はホルガー・ベック・ニールセンの言葉を引用し、「たとえば陽子の崩壊が地球を消滅させるほどの危険な現象だったとしても、それが起これば私たちはもはや観測できないし、起こらなければ何も観測されない」と述べている。

ジャン=マルク・サロッティは、巨大な小惑星衝突による人類絶滅の確率を計算した。それによれば、今後10億年以内に0.03~0.3の確率で発生するとされる(ただし、他の惑星への植民が行われなかった場合)。この研究では、最も危険なのは長周期彗星であり、警告期間が数年しかないため、宇宙での対策や月・火星への移住が間に合わない可能性がある。次の100年間で巨大彗星が衝突する確率は2.2×10⁻¹²とされている。

アメリカン・エンタープライズ研究所は、今後100年間に直径3kmの小惑星が衝突する確率を10万分の1と推定している。また、超巨大噴火(火山爆発指数VEI-8)が発生する年間確率を0.0067%と見積もっており、次の超巨大噴火は紀元16940年5月1日までに発生すると予測されている。

核兵器によるリスク

2024年11月13日、アメリカン・エンタープライズ研究所は、21世紀中に核戦争が起こる確率を0%から80%の範囲で推定し、その中央値を40%とした。

2023年の『エコノミスト』の記事では、核戦争によって世界的な大惨事が起こる確率を8%、人類が絶滅する確率を0.5625%と見積もっている。

人工知能によるリスク

2008年、フューチャー・オブ・ヒューマニティ研究所の調査では、2100年までに超知能によって人類が絶滅する確率を5%と推定した。

2016年のAI専門家調査では、「極めて悪い結果(例: 人類絶滅)」を引き起こす確率の中央値が5%とされた。2019年にはこのリスクは2%に引き下げられたが、2022年には再び5%に上昇し、2023年には10%、2024年には15%へと増加した。

2020年、トビー・オードは著書『崖っぷち: 人類の未来と実存的リスク(The Precipice: Existential Risk and the Future of Humanity)』の中で、今後100年間の実存的リスクを「6分の1」と推定し、制御不能なAIによる絶滅のリスクを「10分の1」と見積もった。

2023年7月10日の『エコノミスト』の記事によると、科学者たちはAIによる大惨事の確率を12%、AIによる人類絶滅の確率を3%と推定している。

2023年5月1日、AI安全・協力条約(TAISC)は、2200年までにAIが大惨事を引き起こす確率を30.5%と推定した。また、6カ月間の開発停止措置がなければ、2026年までにAIが大惨事を引き起こす確率を32.2%と見積もった。

2024年12月27日、ジェフリー・ヒントンは、今後30年以内にAIが人類を絶滅させる確率を10~20%(中央値15%)、今後150年以内にAIが人類を絶滅させる確率を50~100%(中央値75%)と推定した。

気候変動から

2010年の『オーストラリアン』のインタビューで、故オーストラリア人科学者フランク・フェナーは、主に人口過剰、環境悪化、気候変動の結果として、1世紀以内に人類が絶滅すると予測した。

世界的な大災害リスクの重要性について議論している経済学者もいる。例えば、マーティン・ワイツマンは、気候変動による経済的損害の大部分は、温暖化が中間的な予測値を大幅に超え、壊滅的な被害をもたらす可能性が小さいながらも存在することに起因すると主張している。リチャード・ポズナーは、大規模災害のリスクが小さく、正確に見積もるのが難しいからといって、人類はそれに対してあまりにも無策であると批判している。

アメリカの法学者リチャード・ポズナー(ユダヤ人)

個人のリスクと種としてのリスク

実存的リスクは、健康リスクなどと比べて個人が対処するのが難しいが、ケン・オルム、ジョシュア・ノーブ、アレクサンダー・ヴィレンキンによれば、人類絶滅の可能性には実際的な意味がある。例えば、「普遍的」終末論的議論を受け入れるならば、最もあり得る災害の原因が変わり、それに応じて最も効率的な予防策も変わる。

彼らは次のように述べている。「・・・それぞれの小惑星の軌道を気にするよりも、まだ発見されていない大量の小惑星が存在することを懸念すべきだ。特定の近くの恒星が超新星爆発を起こす確率を特に心配するのではなく、超新星が我々の考えているよりも生命にとって致命的である可能性のほうを警戒すべきだ。」

困難さ

地球上のあらゆる居住地を完全に消滅させるのは難しいと主張する学者もいる。例えば、全面的な核戦争のようなシナリオでも、人類を完全に根絶するのは困難だという指摘がある。

物理学者ウィラード・ウェルズは、信頼できる絶滅シナリオは多様な地域に影響を及ぼす必要があると述べている。それには、大都市の地下鉄、チベットの山岳地帯、南太平洋の最果ての島々、そして長期の孤立に備えた物資を備蓄している南極のマクマード基地まで含まれる。また、核戦争時に政府指導者が避難できる精巧な地下シェルターも存在する。

さらに、核潜水艦は海中数百メートルの深さに何年も留まることが可能であり、その存在も考慮する必要がある。多くの出来事が大量の死者を出す可能性はあるが、最低存続可能個体群 に該当する少数の最も適応力のある人々が生き延びる可能性が高いならば、その絶滅シナリオは信憑性に欠けるかもしれない。

倫理

人命の価値

「実存的リスク」とは、人類の絶滅を引き起こすか、あるいは人類の進歩を永久に阻害することで、人類の未来全体を脅かすリスクのことを指す。複数の学者は、「宇宙的資産(cosmic endowment)」の規模を考慮し、想像を絶するほど多くの潜在的な未来の命が危険にさらされている以上、実存的リスクをわずかに減らすだけでも極めて大きな価値があると主張している。

人類絶滅の倫理についての最も初期の議論の一つで、デレク・パーフィットは次のような思考実験を提示した。

「私たちは今や人類を滅ぼすことが可能になっているが、もしそれが起こった場合、その結果はほとんどの人が考えるよりもはるかに悪いものになると思う。次の三つの結果を比較してみよう。」

(1) 平和。

(2) 核戦争によって世界人口の99%が死亡する。

(3) 核戦争によって世界人口の100%が死亡する。

「(2) は (1) よりも悪い。そして (3) は (2) よりも悪い。しかし、この二つの差のどちらが大きいだろうか?多くの人は (1) と (2) の差の方が大きいと考える。だが私は、(2) と (3) の差の方がはるかに大きいと信じている。」

実存的な破局によって失われるものの規模は、人類の長期的な可能性——つまり、人類が生存し続けた場合に成し遂げられるであろうこと——によって決まる。功利主義的な観点では、人類を守る価値は「存続期間(人類がどれだけ長く生き延びるか)」「規模(時間とともにどれだけ多くの人が存在するか)」「質(未来の人々の生活が平均してどれほど良いものか)」の積によって決まる。

一般的に、種は絶滅するまでにおよそ100万年存続する。しかし、パーフィットは地球が生命を維持できる期間は約10億年であると指摘している。そして、これは人類の可能性の下限かもしれない。もし人類が地球を超えて拡張できれば、人口は大幅に増え、存続期間も数兆年に及ぶ可能性がある。

したがって、人類が絶滅した場合に失われる可能性のある未来の規模は極めて大きい。このため、実存的リスクをわずかに減らすことでも、非常に大きな道徳的価値があると考えられる。

カール・セーガンは1983年に次のように書いている。

「もし絶滅を数値で評価しなければならないとしたら、私は未来世代に生まれるはずだった人々の数を必ず考慮に入れるだろう。(ある計算によれば)絶滅のリスクは、"わずか" 数億人を殺すに過ぎない比較的小規模な核戦争と比べて、100万倍も深刻である。他にも、失われる可能性のあるものとして、文化や科学、地球の進化の歴史、そして未来の子孫のために生きてきたすべての祖先たちの人生の意義といった要素を挙げることができる。絶滅とは、人類という営みそのものの終焉なのだ。」

哲学者ロバート・アダムズは1989年に、パーフィットの「非人格的」な見解を否定し、代わりに「人類の未来という壮大なプロジェクトへの忠誠と責任」という道徳的義務について語った。「より公正で、より充実し、より平和な社会を目指す志・・・子供や孫の人生に対する関心、そして彼らがまた自分の子供や孫の人生を築いていけるよう願う気持ち。」

哲学者ニック・ボストロムは2013年に、選好充足主義、民主主義的観点、管理者的視点、直観主義的議論がすべて「実存的リスクの回避が道徳的に優先されるべき課題である」という常識的な結論に収束する、と主張した。たとえ人類絶滅の「悪さの度合い」が哲学によって異なるとしても、この結論は変わらないという。

パーフィットは「宇宙的資産」の規模を次のように計算できると主張した。「もし地球があと10億年住める状態を維持し、その間、10億人以上の人口を持続的に支えられるなら、人類は最大で 10の16乗(10,000兆)人分の人生を生きることが可能だ。」 ボストロムはさらに踏み込み、「もし宇宙がまだ未開拓なら、利用可能な宇宙は少なくとも 10の34乗 人・年の生物的な人間の生存を支えられるし、もし人類がコンピューターにアップロードされた場合、その値は 10の54乗 人・年にまで増える可能性がある」と述べた。

一方で、一部の経済学者や哲学者は、「未来の人々は道徳的に重要でない(あるいは、現在の人々に比べて重要性がはるかに低い)」とする見解を擁護している。これは、指数割引(exponential discounting)や個人影響主義(person-affecting views)に基づく人口倫理の立場である。これらの見解は論争を呼ぶが、少なくとも実存的破局が想像しうる最悪の事態の一つであることには同意するだろう。なぜなら、それは現在存在する80億人の命を奪い、彼らの人生の価値をすべて破壊し、多くの人々を深刻な苦しみに追いやることになるからだ。つまり、未来世代の価値を考慮しなくても、現在生きている人々への配慮だけで、実存的リスクを減らす強い理由があるといえる。

功利主義以外の倫理的視点からも、実存的リスクの削減が重要であることを示す議論は多い。実存的破局は単に人類を滅ぼすだけではなく、すべての文化的遺産、言語、伝統、そして私たちが価値を置く多くのものを破壊する。したがって、「価値あるものを守る義務」を認める倫理観から見ても、これは回避すべき大きな損失となる。

また、過去の世代に対する義務という観点からも、実存的リスクの削減は重要だと考えられる。エドマンド・バークは「生者、死者、そしてこれから生まれる者たちの間の契約」について述べた。もし人類が過去の世代に対して何らかの負債を負っていると考えるなら、トビー・オードは「それを返す最良の方法は未来へと引き継ぐことだ」と主張している。つまり、人類が受け継いだ遺産を未来の世代に引き継ぐことこそが、過去への恩返しとなるのかもしれない。

自発的絶滅

一部の哲学者は反出生主義の立場をとり、人類の絶滅は悪いことではなく、むしろ良いことだと考えている。デイヴィッド・ベナターは、「生まれてくること自体が常に深刻な害であるため、将来の人間が存在しない方がよい」と主張する。

さらに、ベナターや動物権活動家のスティーブン・ベスト、無政府主義者のトッド・メイは、「人類の絶滅は地球上の他の生物や地球そのものにとってプラスになる」と考えている。その理由として、人類文明の全滅的(オムニサイダル)な性質などが挙げられる。

人類の絶滅を支持する環境的視点は、「自主的人類絶滅運動(Voluntary Human Extinction Movement)」や「安楽死教会(Church of Euthanasia)」のメンバーにも共有されている。彼らは、繁殖を控えることで人類が平和的に絶滅し、さらなる環境破壊を防ぐべきだと主張している。

フィクションにおいて

ジャン=バティスト・クザン・ド・グランヴィルの1805年のサイエンス・ファンタジー小説『最後の人間(Le dernier homme)』は、不妊による人類の絶滅を描いており、最初の近代的な終末小説と見なされ、このジャンルの始まりとされている。ほかの初期の代表的な作品には、メアリー・シェリーの1826年の小説『最後の人間』があり、これはパンデミックによる人類の絶滅を描いている。また、オラフ・ステープルドンの1937年の『スター・メーカー』は「全滅行為(オムニサイド)の比較研究」とされる。

21世紀のポピュラー・サイエンスの作品には、アラン・ワイズマンの『人類が消えた世界(The World Without Us)』や、テレビ番組『Life After People』『Aftermath: Population Zero』があり、「もし人類が突然消えたら地球はどうなるのか?」という思考実験を提示している。

技術的特異点(インテリジェンス・エクスプロージョンとも呼ばれる)による人類絶滅の脅威は、無数のSF作品のプロットを動かす要素となっている。影響力のある初期の例としては、1951年の映画『When Worlds Collide(地球最後の日)』の映画化がある。通常、絶滅の危機は間一髪で回避されるが、『R.U.R.』やスティーヴン・スピルバーグの『A.I.』のように、そうならない例も存在する。

関連記事

最後に

最後までお付き合いいただきありがとうございました。もし記事を読んで面白かったなと思った方はスキをクリックしていただけますと励みになります。

今度も引き続き読んでみたいなと感じましたらフォローも是非お願いします。何かご感想・ご要望などありましたら気軽にコメントお願いいたします。

Twitterの方も興味がありましたら覗いてみてください。https://twitter.com/Fant_Mch

今回はここまでになります。またのご訪問をお待ちしております。

それでは良い一日をお過ごしください。