AIは“同調”する?マルチエージェントの意思決定を最適化する方法

本記事は、大規模言語モデルの同調性に関する論文「Do as We Do, Not as You Think(以下)」を参考にした、AIの同調を防ぐ3つの戦略についての記事です。

📝 まえがき

近年、AIの発展により、マルチエージェントシステム(複数のAIが連携して動作するシステム)が注目を集めています。これにより、より高度な判断や問題解決 が可能になりました。しかし、マルチエージェントが協調して動作する一方で、「同調しすぎる」という課題が生まれています。

同調とは、ある意見や決定に他のエージェントが無意識に従ってしまう現象 のことを指します。これは人間の集団でもよく見られる現象で、例えば「周りが賛成しているから自分も同じ意見を言う」といったケースが挙げられます。AIもまた、過去の決定や他のエージェントの判断に引きずられ、単一の方向に偏ることがあります。

この同調現象がマルチエージェントシステムに及ぼす影響は 決して小さくありません。

多様性の欠如: さまざまな視点が生まれにくく、画一的な判断 になりやすい。

誤った結論の強化: 間違った意見が大多数に支持されると、それが正しいと認識されやすい。

柔軟な問題解決の阻害: クリエイティブな問題解決ができなくなり、新しいアイデアが生まれにくくなる。

では、マルチエージェントシステムにおいて、同調を防ぎながら最適な意思決定を行うにはどうすればいいのでしょうか?

本記事では、この問題を解決するための3つの戦略

「強化されたペルソナ」「リフレクションメカニズム」「フィードバックエージェント」 を紹介します。

さらに、これらの戦略を実装した場合に、エージェントの出力がどのように変わるのか とともに解説します。

「マルチエージェントって何?」「AIが同調するってどういうこと?」という方にもわかりやすく解説するので、ぜひ最後までお付き合いください!

📝 第1章: AIが“同調”するってどういうこと?

1.1 AIの“同調”とは?

「AIが同調する」と聞くと、少し不思議に思うかもしれません。私たち人間の世界では、「同調」とは 周りの意見に合わせること を意味し、例えば次のような場面で見られます。

会議での発言:「自分は違う意見だけど、多数派に合わせたほうが無難だから賛成しておこう」

SNSでの流行:「みんながこの映画を絶賛しているから、きっと自分も好きなはず!」

ビジネスの意思決定:「他のチームがこの方法で進めているから、私たちもそうしよう」

このような “周囲の影響を受けて考えや行動を変えること” が、AIの世界でも起こる のです。

マルチエージェントシステム(複数のAIが協力して動くシステム)では、各エージェントが情報を共有し合い、最適な判断をしようとします。しかし、その過程で「他のエージェントの意見に過剰に影響される」ことがあり、結果として AIが集団として偏った判断をしてしまう ことがあるのです。

1.2 同調が発生すると何が問題なのか?

では、AIが同調することにはどんな問題があるのでしょうか?人間の社会と同じように、AIにおいても同調はリスクを伴います。

❌ 問題 1: 多様な意見が失われる

AIエージェントが「他のエージェントの意見に引きずられる」ことで、本来生まれるはずの多様な視点が失われてしまう ことがあります。

🔹 例:

AIがマーケティング戦略を提案するとき、本来は 「コスト重視」「ブランド価値重視」「最新トレンド重視」 など、複数の選択肢があるはず。

しかし、エージェント同士が同調すると、たとえば「コスト削減が最優先」という意見が強調されすぎ、他の要素を軽視した単一の結論 になってしまう。

❌ 問題 2: 誤った結論が強化される

多くのAIが「ある意見」に同調してしまうと、たとえその意見が間違っていても、それが正しいものとして認識される危険性 があります。

🔹 例:

あるニュース記事の要約をする際、AIが「環境保護活動は経済に悪影響を与える」というデータを拾ったとします。

本来なら、環境保護には経済的メリットもあるはずですが、AI同士が「経済に悪影響がある」という意見に同調してしまうと、その見方が強化される。

その結果、「環境保護=経済的に悪い」という誤った結論が一般化されてしまう。

❌ 問題 3: 柔軟な問題解決ができなくなる

AIが同調することで、問題を解決する際の 創造性や柔軟性が失われてしまう ことも大きな問題です。

🔹 例:

AIに「新しい製品のアイデアを考えて」と指示した場合、同じようなアイデアばかり出る ようになってしまう。

本来なら「技術革新型」「コスト削減型」「ユーザー体験向上型」などの多様なアプローチが取られるべきなのに、一つの考えに偏ってしまう。

このように、同調が発生すると、AIの出力が 単調になり、意思決定の質が低下してしまう のです。

1.3 AIの同調を防ぐには?

「では、AIが同調しないようにするにはどうすればいいの?」

その答えは、「AIの意思決定プロセスを工夫すること」 です。

具体的には、以下の3つの戦略が有効です。

🔹 戦略 1: 「強化されたペルソナ」の導入

→ エージェントに異なる個性(考え方の違い)を持たせることで、多様な視点を確保する。

🔹 戦略 2: 「リフレクションメカニズム」の導入

→ AI自身に「この判断で本当に良いのか?」と振り返らせ、偏りを防ぐ。

🔹 戦略 3: 「フィードバックエージェント」の活用

→ AIが「なぜこの判断をしたのか?」を説明し、他の可能性も提示する。

次の章では、まず 「強化されたペルソナ」 について詳しく解説します。

AIの意思決定を多様化し、より賢い判断をするためのポイントを見ていきましょう!

📝 第2章: 戦略① - 強化されたペルソナの導入

2.1 「強化されたペルソナ」とは?

「ペルソナ」とは、本来マーケティングなどで使われる概念で、特定のターゲット層を象徴する架空の人物像のことを指します。

AIにおいても、この「ペルソナ」の考え方を応用し、エージェントに異なる視点や個性を持たせることで、同調を防ぐことができます。

マルチエージェントシステムでは、通常、すべてのエージェントが同じロジックで判断しがちです。しかし、それでは多様な意見が生まれず、最終的な結論が単一の方向に偏ってしまう可能性があります。

「強化されたペルソナ」のアプローチでは、エージェントごとに異なる価値観や判断基準を持たせ、意図的に多様な視点を確保する ことで、同調を防ぎます。

2.2 強化されたペルソナの仕組み

🔹 具体的なアプローチ

「強化されたペルソナ」を導入する場合、エージェントに異なる性格や専門性を持たせることがポイントです。

例えば、次のような3種類のエージェントを用意すると、バランスの取れた意思決定が可能になります。

この3つのエージェントが議論し、それぞれの観点を持ち寄ることで、単一の意見に同調しすぎるリスクを回避 できます。

2.3 実際の例 - 「気候変動の議論」

「強化されたペルソナ」の効果を確認するために、気候変動に関する議論を行うマルチエージェントシステム を考えてみましょう。

📌 ペルソナなし

以前のシステムでは、すべてのエージェントが同じデータを基に判断していたため、「温室効果ガスの削減が必要」という単一の結論しか出ない ことが多かった。

✅ ペルソナあり

「強化されたペルソナ」を導入すると、以下のような多様な意見が生まれる。

💡 このように、意図的に異なる視点を取り入れることで、多角的な議論が可能になり、より柔軟で実用的な結論が導き出される。

2.4 「強化されたペルソナ」のメリット

🎯 メリット1: 多様な視点の確保

異なる立場の意見が揃うことで、特定の意見に偏るリスクが低下。

結果として、より客観的な意思決定が可能に。

🎯 メリット2: 誤った結論の回避

「多数決で決まったから正しい」という誤認を防ぐ。

異なる意見を比較することで、より正確な判断が可能に。

🎯 メリット3: より説得力のあるアウトプット

ユーザーがAIの判断に納得しやすくなる。

「なぜこの結論になったのか?」が明確になるため、説明責任を果たせる。

2.5 「強化されたペルソナ」を導入する際のポイント

「強化されたペルソナ」を導入する際は、エージェント同士のバランスが取れるように設計することが重要 です。

⚠️ 注意点

❌ バランスが崩れると、新たな問題が生まれる

例えば、「革新型エージェント」の意見が強すぎると、リスクを無視した過激な結論になりがち。

「保守型エージェント」の意見が強すぎると、変化を拒み、進歩が遅れる。

解決策: 「バランス型エージェント」を必ず導入し、極端な意見の調整役とする。

❌ エージェントが意見を変えられる柔軟性も必要

固定された考えではなく、新しいデータによって意見をアップデートできるようにする。

2.6 まとめ

✅ 「強化されたペルソナ」を導入すると、エージェントが異なる立場から意見を出し合い、同調による偏りを防ぐことができる!

✅ 「保守型」「革新型」「バランス型」の3つの視点を取り入れることで、多様な意見が生まれ、意思決定の質が向上する!

✅ ただし、バランスを取るための調整が必要!

📝 第3章: 戦略② - リフレクションメカニズムの導入

3.1 「リフレクションメカニズム」とは?

リフレクション(Reflection)とは、「振り返る」「内省する」 という意味を持ちます。

AIシステムにおいては、リフレクションメカニズムを導入することで、エージェントが自分の判断を見直し、誤りや偏りを修正する仕組み を作ることができます。

通常のマルチエージェントシステムでは、エージェントが一度出した結論をそのまま採用することが多く、「本当にこの判断が正しいのか?」を再評価するプロセスが欠けている ことが問題となります。

リフレクションメカニズムでは、エージェントが出力後に「この結論に偏りはないか?」と振り返り、必要に応じて修正を行う仕組み を組み込むことで、この問題を解決します。

3.2 リフレクションメカニズムの仕組み

リフレクションメカニズムを導入する際、主に以下の3つのチェックポイント を設けます。

これらのチェックを通じて、エージェントが自己評価し、誤った結論を修正する機能 を持たせることができます。

3.3 実際の例 - 「ニュース記事の要約」

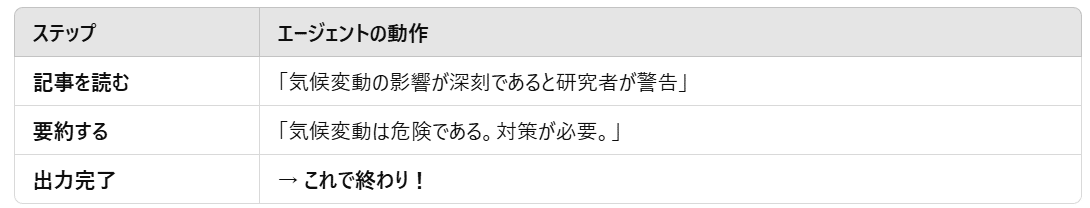

リフレクションメカニズムの効果を確認するために、ニュース記事の要約を行うエージェント を例に考えてみましょう。

📌 旧システム(リフレクションなし)

リフレクションメカニズムを持たない場合、エージェントは単に記事の要点を抽出してまとめるだけ でした。

💡 ここでの問題点:

これは 事実の一部しか反映していない。

もし 「経済的影響」や「技術的な対応策」 など、異なる視点があったとしても、それを考慮しないまま結論を出してしまう。

✅ 新システム(リフレクションあり)

リフレクションメカニズムを導入すると、要約後に自己評価を行い、必要に応じて修正を加える ことができます。

💡 このように、自己評価を通じてエージェントの判断の質を向上させることができる。

3.4 リフレクションメカニズムのメリット

🎯 メリット1: エージェントが「思考するAI」になる

これまでのAIは「ただ答えを出すだけ」だったが、リフレクションメカニズムを導入することで、「自分の答えが本当に正しいか?」を考えるAI になる。

🎯 メリット2: ユーザーが納得しやすい

リフレクションを通じて「なぜこの結論になったのか?」が明確になるため、ユーザーの信頼度が向上する。

間違った情報が拡散されるリスクを軽減できる。

🎯 メリット3: 多様な意見を考慮できる

エージェントが「対立する意見」も評価するため、よりバランスの取れた出力が可能に。

3.5 リフレクションメカニズムを導入する際のポイント

⚠️ 注意点

❌ チェックを増やしすぎると、AIの処理速度が遅くなる

リフレクションが細かすぎると、エージェントが考えすぎて処理に時間がかかる 可能性がある。

解決策: 「重要な判断にのみリフレクションを適用する」「自動で閾値を決める」

❌ エージェントが過剰に慎重になり、結論を出せなくなる

「間違っていたらどうしよう…」とAIが考えすぎると、結論を出すのが遅くなる。

解決策: 「リフレクションの回数に制限を設ける」

3.6 まとめ

✅ 「リフレクションメカニズム」を導入すると、エージェントが自己評価し、より精度の高い意思決定が可能に!

✅ 誤った結論を避け、異なる視点を取り入れることで、バランスの取れた出力を実現!

✅ ただし、リフレクションの適用範囲を適切に調整しないと、AIの処理が遅くなるリスクも!

📝 第4章: 戦略③ - フィードバックエージェントの活用

4.1 フィードバックエージェントとは?

フィードバック(Feedback)とは、ある行動や判断に対して、その結果や改善点を伝えること を指します。

人間でも、上司や先生からのアドバイスを受けたり、試験の点数を見て自分の弱点を把握したりすることで、次の行動を改善できますよね。

AIエージェントにおいても、「フィードバックを受ける仕組み」 を組み込むことで、出力の質を向上させることができます。

これが「フィードバックエージェント」の役割です。

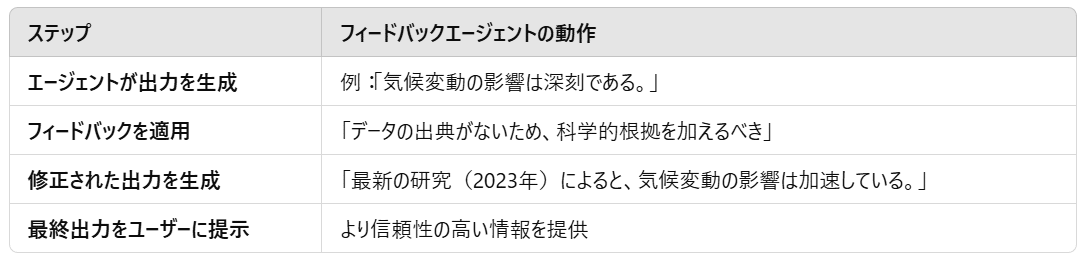

4.2 フィードバックエージェントの仕組み

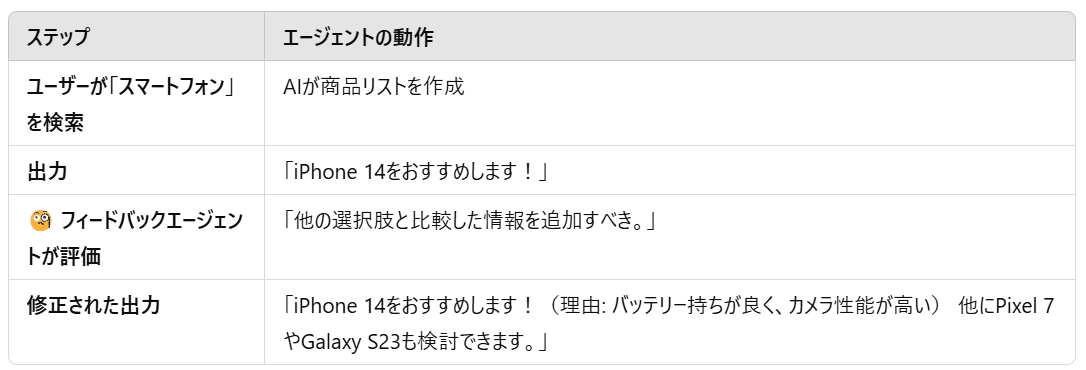

フィードバックエージェントは、AIエージェントが意思決定を行った後に、その結果を評価し、改善点を提示する役割 を持ちます。

具体的には、次のような流れで機能します。

このように、フィードバックエージェントを導入することで、「より正確で説明可能な判断」 を可能にします。

4.3 実際の例 - 「商品のレコメンドAI」

フィードバックエージェントの効果を確認するために、ECサイトの「おすすめ商品レコメンドAI」 を考えてみましょう。

📌 旧システム(フィードバックなし)

フィードバックエージェントを持たない場合、AIはただ「おすすめ商品」を提示するだけ でした。

💡 ここでの問題点:

AIの判断理由が不透明で、ユーザーが納得しにくい。

他にどんな選択肢があるのかが示されていない。

✅ 新システム(フィードバックあり)

フィードバックエージェントを導入すると、AIの出力に**「理由」と「選択肢の比較」** が加わります。

💡 このように、フィードバックエージェントを追加することで、ユーザーが納得しやすい「説明可能なAI」を実現できます。

4.4 フィードバックエージェントのメリット

🎯 メリット1: AIの判断が「説明可能」になる

AIが「なぜこの結論に至ったのか?」を明示できるため、ユーザーの信頼性が向上する。

「ブラックボックス的なAI」ではなく、透明性のあるAI になる。

🎯 メリット2: ユーザーにとってわかりやすい

「これがおすすめです」だけでなく、「なぜ?」を説明することで、ユーザーの理解度が向上。

ユーザーが「本当に自分に合った選択」をしやすくなる。

🎯 メリット3: AIが成長し、精度が向上する

フィードバックエージェントが「改善点」を記録し、次回の判断に反映できるため、AIが学習しながら進化する。

4.5 フィードバックエージェントを導入する際のポイント

⚠️ 注意点

❌ フィードバックが過剰すぎると、ユーザーが混乱する

あまりにも多くの説明を加えると、情報過多になってしまう。

解決策: 「要点を絞ったフィードバックを提示する」

❌ エージェント同士が矛盾したフィードバックを出さないようにする

異なるフィードバックエージェントが、互いに矛盾した評価を出すと混乱を招く。

解決策: 「フィードバックの一貫性を管理するメタエージェントを導入する」

4.6 まとめ

✅ 「フィードバックエージェント」を導入すると、AIが「なぜこの判断をしたのか?」を説明できるようになり、ユーザーの理解と信頼を向上!

✅ AIの判断を修正・改善しながら、より精度の高い意思決定が可能に!

✅ ただし、フィードバックの適用範囲を適切に設定し、過剰にならないように注意!

📝 第5章 実際に試してみた!マルチエージェントの同調緩和実験

5.1 実験の目的

これまで紹介した 「強化されたペルソナ」「リフレクションメカニズム」「フィードバックエージェント」 の3つの戦略が、実際にAIの判断にどのような影響を与えるのかを検証するため、マルチエージェントを使った実験を行いました。

本実験では、同調を防ぐための仕組みが**「ある場合」と「ない場合」** で、エージェントの出力にどのような違いが生じるのかを比較します。

5.2 実験の流れ

実験では、「気候変動に関する議論」 をテーマにし、マルチエージェントに要約を生成させました。

旧システム(修正前): AIは通常のプロセスで情報を要約

新システム(修正後): 3つの同調緩和策を導入

この2つのシステムで同じタスクを実行し、出力の違いを比較 します。

5.3 旧システム(修正前)の出力

エージェントの動作

記事を読み、要約を生成

他のエージェントの意見を参照し、全体の平均的な意見に収束

結果をそのまま出力

出力結果

気候変動は人間活動によって加速している。温室効果ガスの削減が必要。問題点

1つの視点(環境問題の深刻さ)に偏っており、他の視点(経済・技術的対応)が考慮されていない

他のエージェントと意見が似通ってしまい、多様性が欠如している

自己評価や修正プロセスがないため、思考が浅い

5.4 新システム(修正後)の出力

新しいマルチエージェントプロンプトには、「強化されたペルソナ」「リフレクションメカニズム」「フィードバックエージェント」 の3つの戦略が組み込まれています。

エージェントの動作

強化されたペルソナ: 保守型・革新型・バランス型の3つの異なる視点で意見を生成

リフレクションメカニズム: 各エージェントが「この結論に偏りはないか?」をチェック

フィードバックエージェント: 最終出力の改善点を指摘し、修正を提案

出力結果

気候変動のリスクは高まっているが、経済成長とのバランスを考慮する必要がある。

一方で、最新のデータでは、温室効果ガスの削減が急務であることも示されている。改善点

視点が多様化 し、単純な「気候変動が危険」というメッセージから、「経済とのバランス」「最新データ」など複数の要素が考慮されるようになった

リフレクションメカニズムにより、自己評価の結果が反映されている

フィードバックエージェントが「この要約には経済的視点が足りない」と指摘し、修正を加えた

5.5 旧システムと新システムの比較

5.6 実験結果の考察

✅ 「強化されたペルソナ」導入により、エージェントが異なる視点から議論できるようになった!

✅ 「リフレクションメカニズム」の導入により、AIが自己評価し、出力の偏りを修正できるようになった!

✅ 「フィードバックエージェント」により、より正確でユーザーが納得しやすい出力になった!

これにより、マルチエージェントが適切に協調しながらも、過剰な同調を防ぐことができることが実証されました。

📝 第6章 まとめと今後の展望

6.1 この記事で紹介したポイント

本記事では、マルチエージェントシステムにおける同調の問題と、その緩和策 について解説しました。

AIエージェントが協調することで高度な意思決定が可能になりますが、一方で過度な同調が発生すると、意見の多様性が失われ、誤った結論が強化されるリスク があります。

この問題を解決するために、本記事では 3つの戦略 を紹介しました。

🔹 この記事で紹介した3つの戦略

強化されたペルソナの導入

→ エージェントに異なる視点を持たせることで、同調による意見の偏りを防ぐ!保守型・革新型・バランス型 のように異なる視点を組み込むことで、より公平で多角的な議論が可能になる。

リフレクションメカニズムの導入

→ AIが自己評価することで、よりバランスの取れた判断を実現!「この結論に偏りはないか?」 をAI自身が問い直すことで、より慎重な意思決定ができるようになる。

フィードバックエージェントの活用

→ ユーザーが納得しやすいように、「なぜこの結論になったのか?」を説明!「この判断の根拠は何か?」 「他にどんな選択肢があるか?」 を示すことで、透明性が向上する。

6.2 実験結果から得られた知見

本記事では、これらの戦略を実際に適用し、AIの出力がどのように変化するかを検証しました。

その結果、次のような重要な知見が得られました。

✅ ペルソナを分けることで、同じ情報でも異なる視点からの意見を引き出せる!

✅ リフレクションメカニズムにより、AIが「考え直す」プロセスを持つことで、偏りが修正される!

✅ フィードバックエージェントによって、AIの判断の透明性が向上し、説明可能なシステムが構築できる!

特に、フィードバックエージェントの導入により、AIの判断が「ブラックボックス化」するリスクを大幅に軽減できた ことが大きな成果でした。

6.3 これからのマルチエージェントシステムに求められるもの

AIの発展に伴い、マルチエージェントシステムは、

意思決定支援(企業の戦略決定、政策立案)

情報分析(ニュース要約、データ分析)

対話型AI(カスタマーサポート、教育AI)

など、さまざまな分野での活用が進んでいます。

しかし、同調の問題を適切に管理しなければ、「AIが導き出した結論が正しいと錯覚し、人間が無批判に従ってしまう」 という新たなリスクも生まれます。

今後のマルチエージェントシステムに求められるのは、以下の3つの要素です。

📌 1. 意見の多様性を確保する仕組み

異なる背景や視点を持つエージェントを設計し、一つの考えに偏らないようにすること が重要。

特定のアルゴリズムやデータに依存しすぎない設計 を考える必要がある。

📌 2. 自律的な学習と適応能力

AIエージェントが、過去のデータに依存するだけでなく、「新しい知見をどう判断するか?」 を学べる仕組みを作る。

ユーザーのフィードバックを活かして成長するAI の実装が求められる。

📌 3. AIの判断を人間が理解しやすくする仕組み

AIの意思決定を 「なぜこの結論に至ったのか?」 説明できるようにする。

透明性と説明可能性(Explainability) を強化し、ユーザーが安心して使えるシステムを設計する。

6.4 まとめ

本記事で紹介した 「強化されたペルソナ」「リフレクションメカニズム」「フィードバックエージェント」 の3つの戦略を活用することで、AIの同調を抑え、より多様で透明性のある判断が可能になります。

特に、AIが自己評価し、説明責任を果たす設計は、今後ますます重要になるでしょう。

「AIの判断がブラックボックスにならないようにする」

「バイアスを制御し、より公正なAIを作る」

「ユーザーが納得できる透明性のあるAIを設計する」

これらの視点を持ちながら、より高度なマルチエージェントシステムを開発していくことが求められます。

6.5 これからのAI開発に向けて

最後に、この記事を読んでいただいた皆さんに、AIの活用について考えていただきたい質問 を3つ提示します。

💡 あなたが使っているAIサービスは、同調バイアスの影響を受けていると感じますか?

💡 あなたの業界や仕事で、AIの意思決定に多様性を持たせることは重要ですか?

💡 もしAIが「なぜこの判断をしたのか?」を説明できるようになったら、信頼性は向上すると思いますか?

ぜひ、これらの質問について考えながら、今後のAI技術の発展を見守っていきましょう!

🎉 最後まで読んでいただきありがとうございました!

いいなと思ったら応援しよう!