Copilot+PCのNPUが利用できないので、外付けGPUで生成AIを使ってみた

LM Studioで、DeepSeekなど、いろいろな言語生成AIモデルを、手軽に試すことができるのですが、残念なことに、40TOPS以上の性能があるCopilot+PCのNPUは、まだほとんど利用されていません(利用できません)。

手ごろな外付けGPUの、AI推論性能はCopilot+PCのNPUと同じくらいだろうと推察できるので、一足お先にパソコンの未来に触れたい人には、面白いかもしれません。

LM Studioは、GPUオフロードが利用できるのですが、Copilot+PCなどのノートPC、あるいは、ミニPCのGPUは、あまり性能が高くないので、外付けGPU(eGPU)を試してみました。

使用したパソコン

次の、Copilot+PCが2台、ミニPCを1台使って比較してみました。

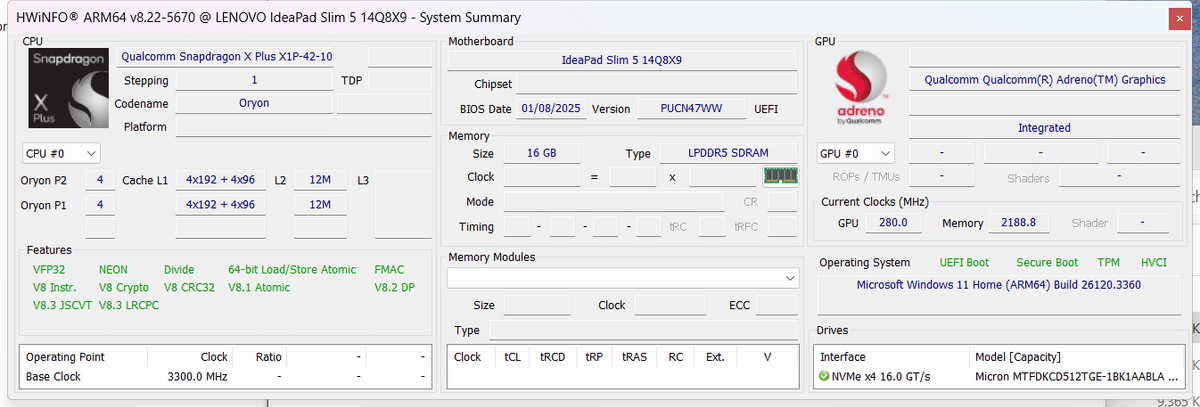

Lenovo IdeaPad Slim 5 14.0インチ SnapdragonR X Plus X1P-42-100 16GB

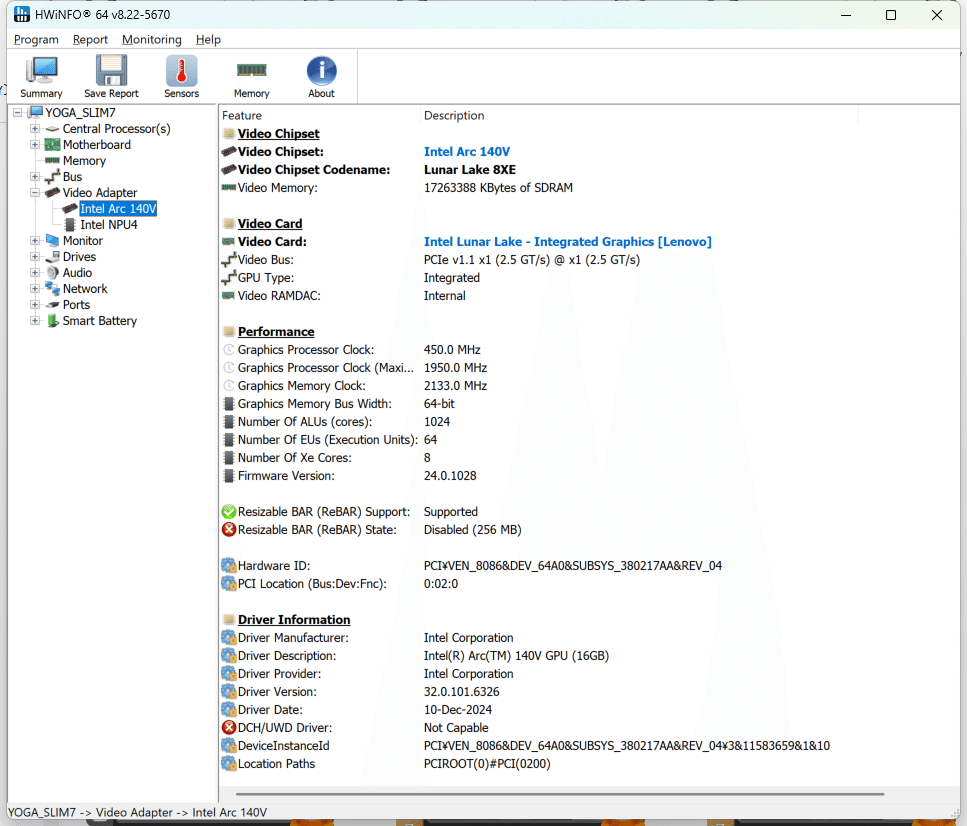

Lenovo Yoga Slim 7i Aura Edition Gen 9 15.3インチ Core Ultra 7 258V 32GB

GMKtek Nucbox M7 AMD Ryzen 7 PRO 6850H 64GB

Apple M2 Mac mini 8GB

今回使用した外付けGPUは、ARMアーキテクチャーの IdeaPad Slim 5 と Apple M2 Mac mini で使用できるドライバーがなかったので、外付けGPU無しで試した結果を比較しています。

Lenovo IdeaPad Slim 5 14.0インチ SnapdragonR X Plus X1P-42-100 16GB

CPUに ARM64アーキテクチャの Snapdragon X Plus X1P-42-100 を使用した、メモリ16GBの Copilot+PCです。

バッテリー駆動時間が長く、実際の消費電力は使用状況によって変動しますが、一般的な使用では10W〜30W程度の範囲内と推測されます。

Lenovo Yoga Slim 7i Aura Edition Gen 9 15.3インチ Core Ultra 7 258V 32GB

CPUに Intel Core Ultra 7 258V を使用した、メモリ32GBの Copilot+PCです。

長時間のバッテリー駆動を可能で、一般的なタスク(ウェブブラウジングなど)では約18W~23Wの消費電力、また、最大消費電力も約65Wと、性能の割に低消費電力です。

GMKtek Nucbox M7 AMD Ryzen 7 PRO 6850H 64GB

CPUに AMD Ryzen 7 PRO 6850H を使用したミニPCです。メモリーを 64GBに増設してあります。

最大70WのTDPで、ゲーミング愛好家向けに設計されています。

Apple M2 Mac mini 8GB

M2チップを搭載:8コアCPU(4高性能コア+4高効率コア)、10コアGPU、16コアNeural Engineを備え、高速な処理能力が売りでした。

消費電力は、待機時: 約7W、CPU最大稼働時: 最大50W です。

使用した外付けGPU(eGPU)

GPUに AMD RX 7600M XT 8GB を使用した、外付けGPU(eGPU)です。OCulink あるいは USB4 で パソコンと接続することができます。

AMD Radeon RX 7600M XTは、GeForce RTX 4060 Laptop GPUと比較して同等かやや劣る性能を持った、ノートPC向けのミッドレンジグラフィックスカードです。

消費電力(TDP)は75Wから120Wの範囲で設定されているので、大型の電源を必要とせず、大変コンパクトな外付けGPUです。

使用した生成AIモデル

Qwen2.5 7B Instruct 1M の Q8_0 を使用しました。

Qwen2.5 7B Instruct 1Mは、Alibabaが開発した大規模言語モデル(LLM)「Qwen2.5」シリーズの一部で、7B(70億)パラメータを持つ命令調整版(Instruct)モデルで、最大100万トークンの長文コンテキストを処理可能です。

Q8_0 は、FP8(8ビット浮動小数点)量子化を採用し、メモリ効率を向上させることで、大規模モデルの実行コストを削減しています。

Lenovo IdeaPad Slim 5 14.0インチ SnapdragonR X Plus X1P-42-100 16GB では、メモリが不足するので、Q8_0 ではなく Q4_K_M を使用しました。

Q4_K_Mは、attention.wvとfeed_forward.w2テンソルの半分にQ6_K(6ビット量子化)を使用し、残りの部分にQ4_K(4ビット量子化)を適用します。

Q4_K_Mは、精度ではQ8_0に劣りますが、性能とリソース効率のバランスが取れており、多くの場合、推奨モデルとして選ばれることが多いです。

比較に使用した例題

次の例のように、Youtubeの Transcriptを要約するプロンプトを実行させました。

次の内容を5〜10個の箇条書きで要約してください。文字起こしの場合はタイムスタンプを付けてください:

Title:

【新作】パン屋紙袋風バッグ「マルシェ」をレザーマニアの間で大人気のバダラッシ・カルロ社「ミネルバボックス」で製作! - YouTube

Transcript:

(00:00) クラッチバックで結局荷物が入らないと 思っていませんかうんこんなことあると 思います一般的なクラッチバックは街が なくてえ財布とスマホ入れたもうパンパン と結局え持ちも減らすかえ別のバック持つ しかないとでこな会見ございませんかうん うんこんな感じです今回我開発いたしまし たこのバックな ※以下略

例題としてトランスクリプトを使用した Youtube ビデオ

ChatGPT 4o の出力結果

### 要約(箇条書き)

1. **パン屋の紙袋風バッグ「マルシェ」**

- クラッチバッグの収納不足問題を解決する大容量設計。

- 見た目はスマートながら実用的なデザイン。

2. **高級レザー「ミネルバボックス」使用**

- イタリアのバダラッシ・カルロ社製の高級牛革。

- 伝統的なベジタブルタンニンなめしで約2か月かけて製造。

- 経年変化により美しい風合いを楽しめる。

3. **デザインの特徴**

- シンプルながら丸みを帯びた洗練されたフォルム。

- 皮の継ぎ目を減らし、高級感と耐久性を向上。

- 本革ながら軽量で、内装も見やすい明るめの色を採用。

4. **機能性の高さ**

- クラッチバッグながら大容量で、A5ノートや500mlペットボトルも収納可能。

- 着脱可能なショルダーベルトで2WAY仕様。

- 内外に整理しやすいポケット付き。

5. **品質と耐久性**

- 強度を増すための補強テープを使用。

- 590gと軽量ながら耐久性の高い本革を採用。

- 長年使える設計で、無料修理対応もあり。

6. **価格と販売情報**

- 通常価格5万6185円 → クラファン限定価格3万9800円。

- 数量限定販売で、LINE登録者に先行通知。

7. **クラウドファンディングの成功**

- すでにクラウドファンディングで5億円以上の支援を獲得。

- 修理保証の手厚さが支持されている理由の一つ。

8. **今後の展開**

- ブランド名を「新身工房」から「潜入」に変更予定(海外進出を視野に)。

- YouTube登録者数10万人を目標。

9. **イベント・コラボ情報**

- 3月28〜29日に姫路の革祭りで公開収録を実施予定。

- 2月29日にラジオ放送出演予定。

10. **有名人とのコラボ計画**

- YouTuber深田萌とのコラボで注目を集める。

- 今後、千原ジュニアや関西出身の有名人との対談を検討。

こんな感じで要点をまとめました!

実際に LM Studioで試した結果

Lenovo IdeaPad Slim 5 14.0インチ SnapdragonR X Plus X1P-42-100 16GB

ARMアーキテクチャー用のドライバーがないため、今回は外付けGPU(eGPU)が使用できませんでした。

また、メモリが少ないため、生成AIモデルは、Q8_0 が利用できず、代わりに Q4_K_M を使用しました。

回答を開始するまで4分20秒ほどかかり、回答終了までに5分24秒ほど要しました。

驚いたことに、GPUオフロードを指定していたにも関わらず、NPUはおろかGPUも利用せず、CPUのみ利用して処理が行われていました。

実行の様子は次のビデオをご覧ください。

Apple M2 Mac mini 8GB

Appleは、外付けGPUをサポートしていませんが、他に利用できるドライバーもないため、今回は外付けGPU(eGPU)が使用できませんでした。

メモリ容量は少ないのですが、生成AIモデルは、Q8_0を使用することができました。

回答を開始するまで1分24秒ほど、回答終了までに2分25秒ほど要しました。

先ほどの SnapdragonR X Plus X1P-42-100 と比べると、三分の一の時間で回答が開始され、半分以下の時間で回答終了しています。

実行の様子は次のビデオをご覧ください。

Lenovo Yoga Slim 7i Aura Edition Gen 9 15.3インチ Core Ultra 7 258V 32GB

内蔵GPUでは、回答を開始するまで2分26秒ほど、回答終了までに3分44秒ほど要しました。

外付けGPUの AMD RX 7600M XT 8GBは、Thunderbolt4ポートを使用して接続することができました。

しかしながら、インサイダープレビューのグリーンスクリーンが出たり、内蔵GPUよりも時間がかかったりして、動作があまり安定しませんでした。

プレビュー版のWindows 11や、AMDのドライバーが不安定だったのかもしれません。

参考までに、Q8_0 と Q4_K_M の動作の様子を載せておきます。

まず、Q8_0で試した結果です。回答を開始するまで3分30秒もかかっています。回答終了までに4分41秒ほど要しました。

Q8_0実行の様子のビデオです。

しょうがないので、Q4_K_Mで試した結果です。こちらは、回答を開始するまで34秒と速く、回答終了までに1分33秒と、期待通りの動作でした。

Q4_K_M実行の様子のビデオです。

GMKtek Nucbox M7 AMD Ryzen 7 PRO 6850H 64GB

内蔵GPUでは、回答を開始するまで41秒ほど、回答終了までに2分52秒ほど要しました。

実行の様子は次のビデオをご覧ください。

外付けGPUの AMD RX 7600M XT 8GBとは、Thunderbolt4よりも高速のOCulinkを使用して接続することができました。

こちらの方は、CPUも内蔵GPUもAMD製だからでしょうか、動作も安定していました。

試してみると、わずか9秒で回答を開始して、32秒で終了しました。

実行の様子は次のビデオをご覧ください。

比較のために、外付けGPU(eGPU)を、OCulinkの代わりに USB4で接続した場合も試してみました。

USB4接続では、回答を開始するまで19秒ほどかかり、回答終了までに41秒ほど要しました。

実行の様子は次のビデオをご覧ください。

まとめ

ローカルな生成AIの速度

それぞれの実行にかかった時間をまとめると、次のようになります。

Oculink で接続した外付けGPUの回答の早さは目覚ましいものがあります。分単位の処理が秒単位で終わるのは、実用上のメリットも大きく感じられます。

ノートパソコンでは 残念ながらOculinkが使用できないので、ThunderboltもしくはUSB4接続となりますが、Oculinkとの差が大きく、費用対効果を考えるとあまりメリットは感じられないような気がします。

外付けGPUのAI推論性能

今回試してみた外付けGPU(eGPU)AMD RX 7600M XT 8GB の AI推論性能を調べてみましたが、公式のデータはないようです。Deep researchなどを使いながら、各種GPUのFP16とAI推論性能を概算でまとめてみました。

推論に推論を重ねた概算なので、極めて大雑把な数字ですが、Copilot+PCのNPUがフルに利用できるようになると、今回試した外付けGPUのベストの状態と同じくらいのAI推論性能を発揮してくれるのかなぁと思っています。

ところで、現時点で7Bクラスよりも、もっと大きな生成AIモデルを動かすには、もっとメモリーと推論パワーが必要です。

外付けGPUドッキングステーションを買って、Oculinkで、16GB以上の専用メモリを持ったデスクトップ用のグラボを接続するかどうか思案中です(笑)

また、代案としては、ユニファイドメモリでGPUが大量のメモリを使用できる、M4 Mac miniも良いのかなと思っています。

今回試した M2 Mac miniも、かなり良い数字を出していたので、高価で大型の電源を必要とするデスクトップ用のグラボを増設するよりも、メモリ容量の多い M4 Mac miniを使うほうがスマートかもしれません。

メモリ超大容量モデルは、アップルストアでしか買えないようですね。

(続く)

当Noteは、Amazon.co.jpを宣伝しリンクすることによって紹介料を獲得できる手段を提供するアフィリエイトプログラムであるAmazonアソシエイト・プログラムの参加者です。