iFacialMocap Powered by NVIDIA Broadcastをバーチャルモーションキャプチャーに連動させる使い方

最近、iFacialMocap Powered by NVIDIA Broadcast というソフトがリリースされました。

iPhoneで顔表情を認識して、PCでアバターを動かせるiFacialMocapというソフトのPC版に相当するソフトです。

以下からダウンロードできます。

従来のソフトウェアと異なり、RTXシリーズを搭載しているPCでは、Webカメラを使うだけで利用でき、速度も軽快で、非常に便利なのですが、使い方の説明が公式に特にないようだったので、書いてみます。

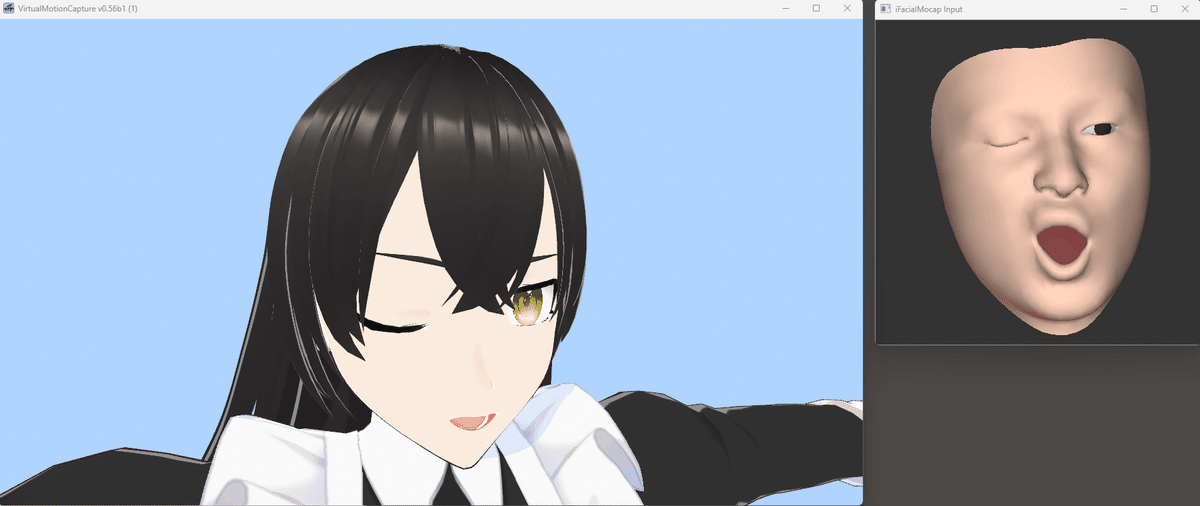

今回は、特にVMCProtocolに対応しているということで、バーチャルモーションキャプチャーと連動させてみます。一部ソフトウェアとは正常に連携できない場合もありますが、とりあえずバーチャルモーションキャプチャーでは正常に動くようです。

まず、Microsoft Storeからダウンロードします。期間限定で無料のようですが、有料の場合はMicrosoft Storeにクレジットカード情報を登録したりする必要があると思います。

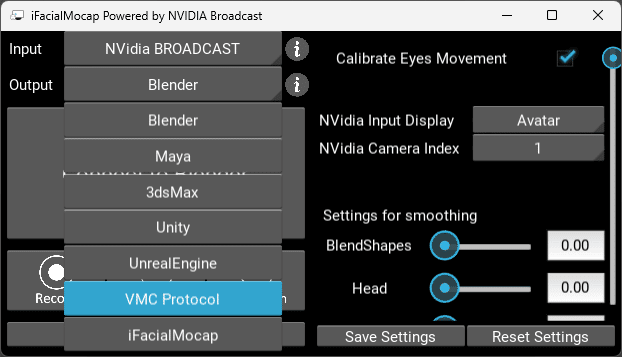

起動すると、このような画面になると思います。

Inputが、NVidia BROADCASTになっていない場合、選択肢から選択し直しておいてください。

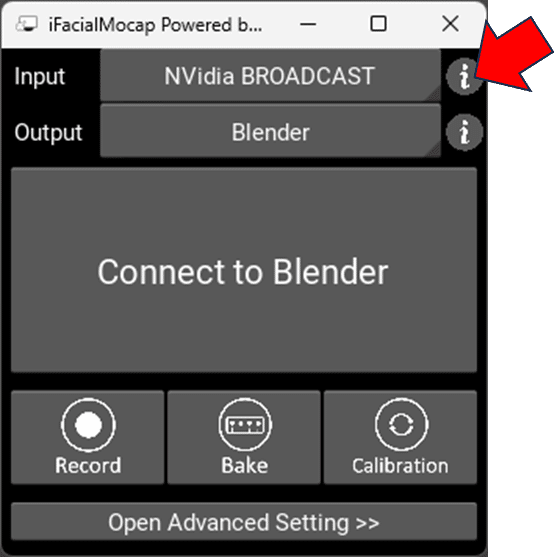

この状態で、ここのiマークを押します。

するとブラウザが立ち上がり、NVidiaのサイトが開くはずです。

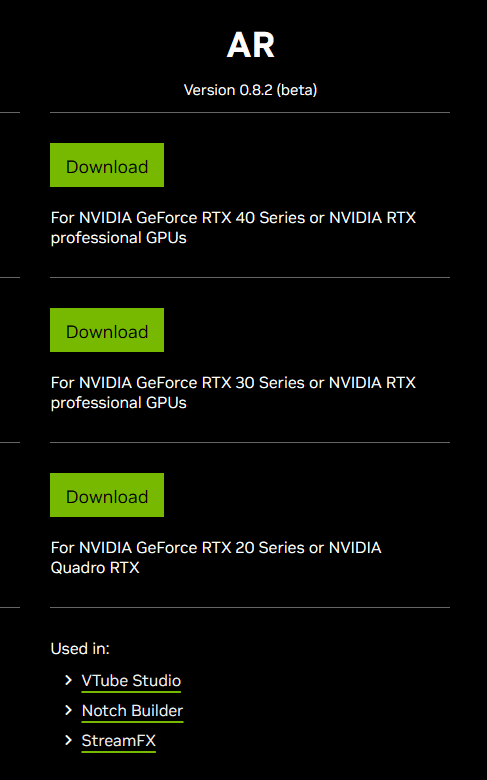

下にスクロールし、ARの項目の、お手持ちのグラフィックボードにあったものをダウンロードし、NVidia AR SDKをインストールしてください。(RTX40シリーズ、30シリーズ、20シリーズでそれぞれ異なるようです。)

インストールが終わったら、iFacialMocap Powered by NVIDIA Broadcastを再起動します。すると、ウィンドウが増えるはずです。

適切なWebカメラがPCに接続されているにも関わらず、iFacialMocap Inputウィンドウに何も写っていない場合は、「Open Advanced Setting >>」をクリックし、NVidia Camera Indexを変更します。

肌色の男性の顔のようなものが映れば成功です。

もし、万が一、実写映像のほうがお好みの場合は、NVidia Input DisplayをCameraに切り替えることで実写映像になります。

次に、バーチャルモーションキャプチャーと接続します。

バーチャルモーションキャプチャーのセットアップ方法については、別のサイト等をご確認ください。

iFacialMocap Powered by NVIDIA Broadcastの、Outputを、VMC Protocolに変更します。

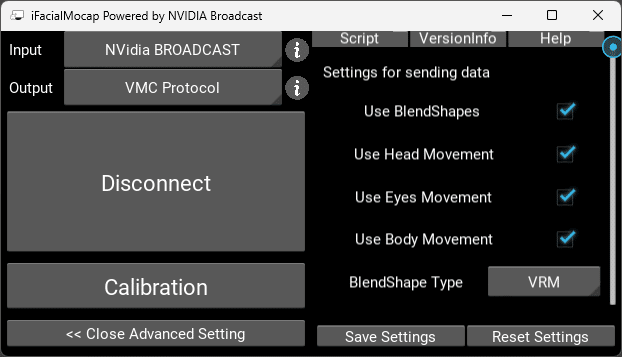

BlendShape Typeを、VRMに変更します。

Connect to VMC Protocolボタンを押します。

Disconnect表示になればOKです。

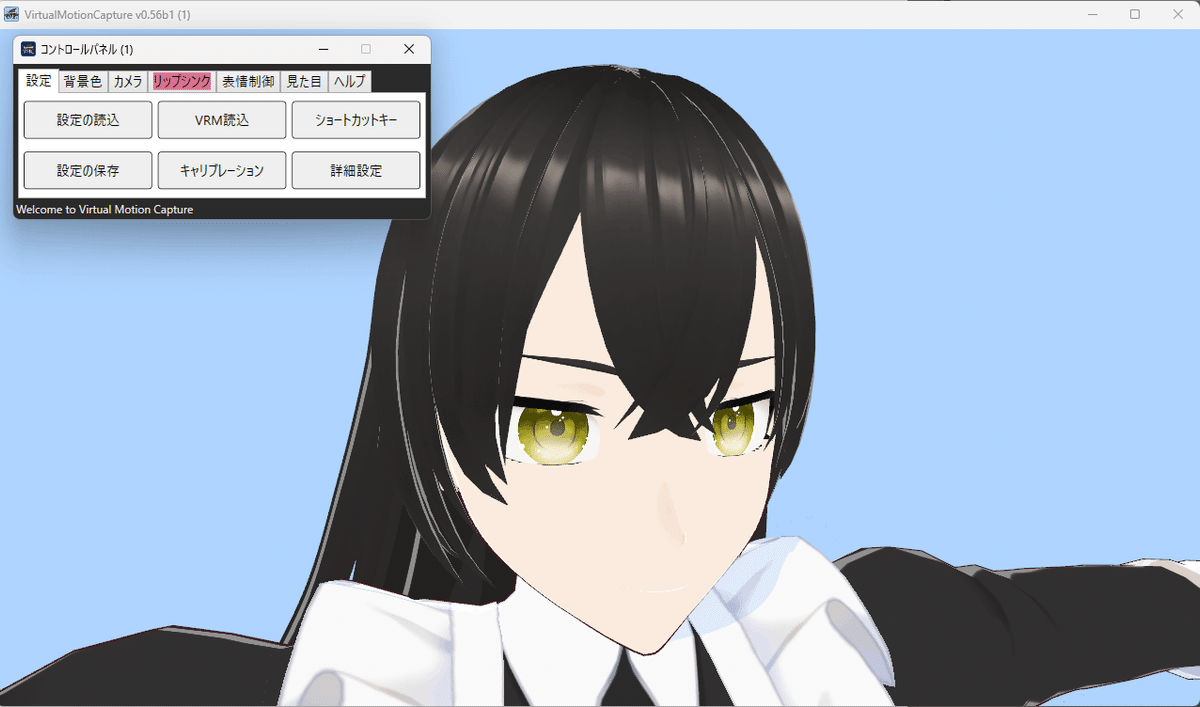

バーチャルモーションキャプチャーを起動し、アバターを読み込みます。

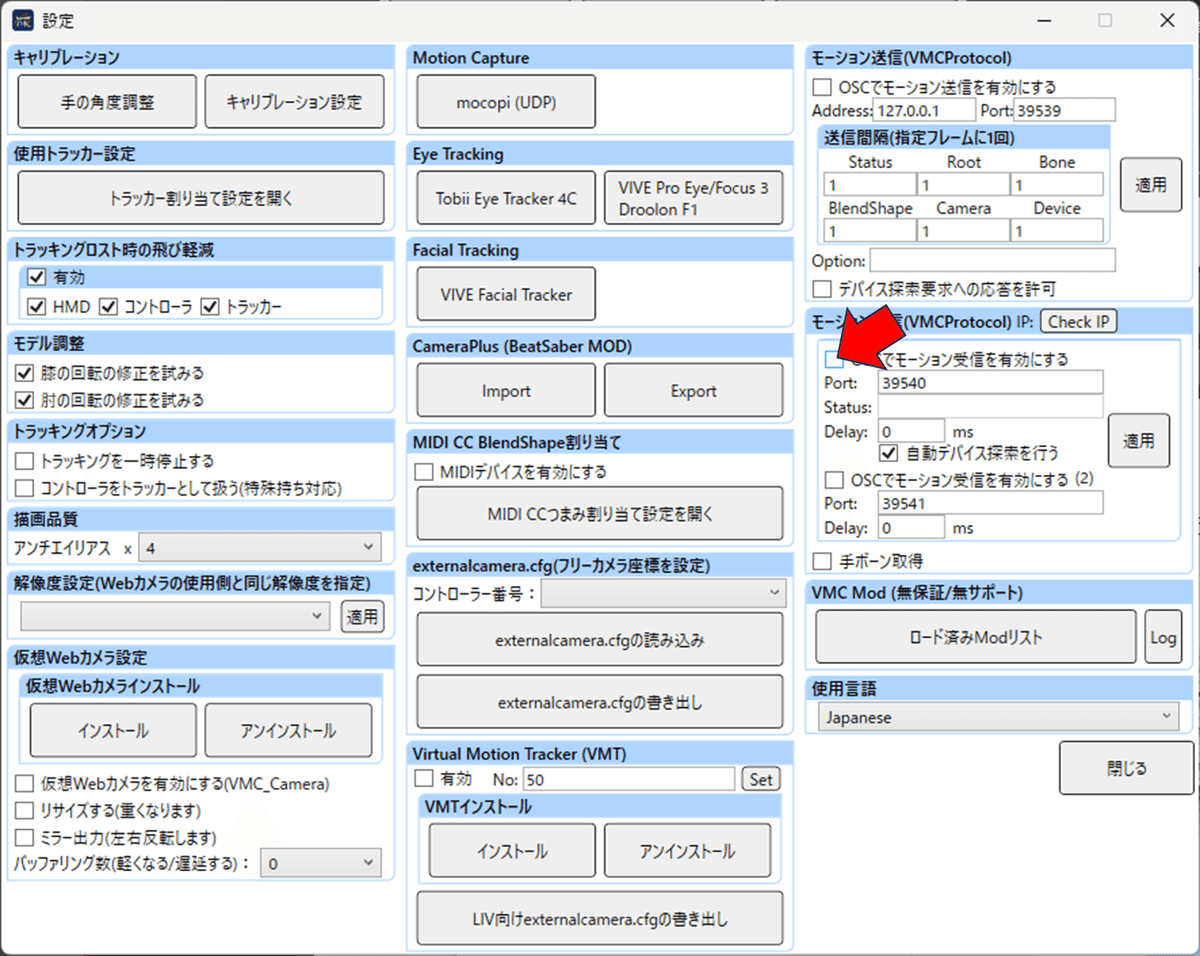

詳細設定を開き、「OSCでモーション受信を有効にする」にチェックを入れ、閉じます。

顔が連動します。

顔の表情のプルプル具合がダイレクトに反映されて具合が悪い場合は、

Settings for smoothing のBlendShapesの値を変更するとスムーズになります。

なお、この値の微調整は一度Disconectを押してからもう一度、Connect to VMC Protocolを押さないと反映されないようです。

バーチャルモーションキャプチャーを除く、ほとんどのアプリケーションでは、顔が壊れたり首が壊れたりすると思いますので、その場合は、Use BlendShaples以外のチェック(Head, Eye, Body)を外すとうまくいくと思います。

また、BlendShaple Type: ARKitも、動くアプリケーションが限られるようです。(表情の大文字小文字を厳密にチェックするアプリでは動きません。バーチャルモーションキャプチャー v0.56b1など。EVMC4U系では動きます。)