Segment Anything Model という論文の存在を知った

昨夜、チームメンバーがこんなデモ画像とともに、論文を貼ってくれました。

とてもカラフルな弊社のWebサイト、かと思いきや、画像をセグメンテーションしているではありませんか!

画面中央の文字、「個性をかき集めて、驚きの角度から世の中をアップデートしつづける。」の後ろにある木のエリアは木のエリアとしてグルーピングされていて、白い壁は白い壁としてグルーピングされている。すごい!

デモを触る

こちらのページがプロジェクトページです。demoも用意されています。そして、デモには自分で任意の画像をアップロードすることもできます。

本日のアイキャッチ画像は、自分のGoogle Photoから適当に探してきた天神の風景を、デモページでセグメンテーションしてみた例です。

ChatPDFに聞いてみる

このモデル、何がそんなにすごいのか?が気になりました。論文を読むに当たり、ChatPDFを使ってみることにします。

聞いた質問はこんな感じ。回答に応じて質問も変わっていくので一見よくわからないですが、疑問に思ったことを問いかけられるのはとても面白い体験です!

ゼロショット性能が高い理由は、学習データの量?それとも、モデルの構造?

ベースモデルには、何が使われているの?

§3の中身を要約して

この論文の構成を教えて欲しい

SAMの今後の展望は、どんな感じなの?

prompt encoder には、 何が使われている?

CLIPも使われてるんだ。

140文字でこの論文をまとめると、どんな感じになる?

このモデルに、人間をセグメントしてなどという、ラベルを指定したセグメンテーションを依頼することもできるの?

自由形式のテキストプロンプトの例を上げて。日本語で。

論文中で示されてる例を知りたい

それは、論文の中の、どこにある?

一部正確でない回答も帰ってきましたが、日本語で質問してこんなに回答してくれるなら全く問題なし!素晴らしいの一言です。

気になった内容を質問して、論文中のどこにそれがあるかを聞いて、論文をDeepL で翻訳しながら読んでみる。とても便利だなと思いました。

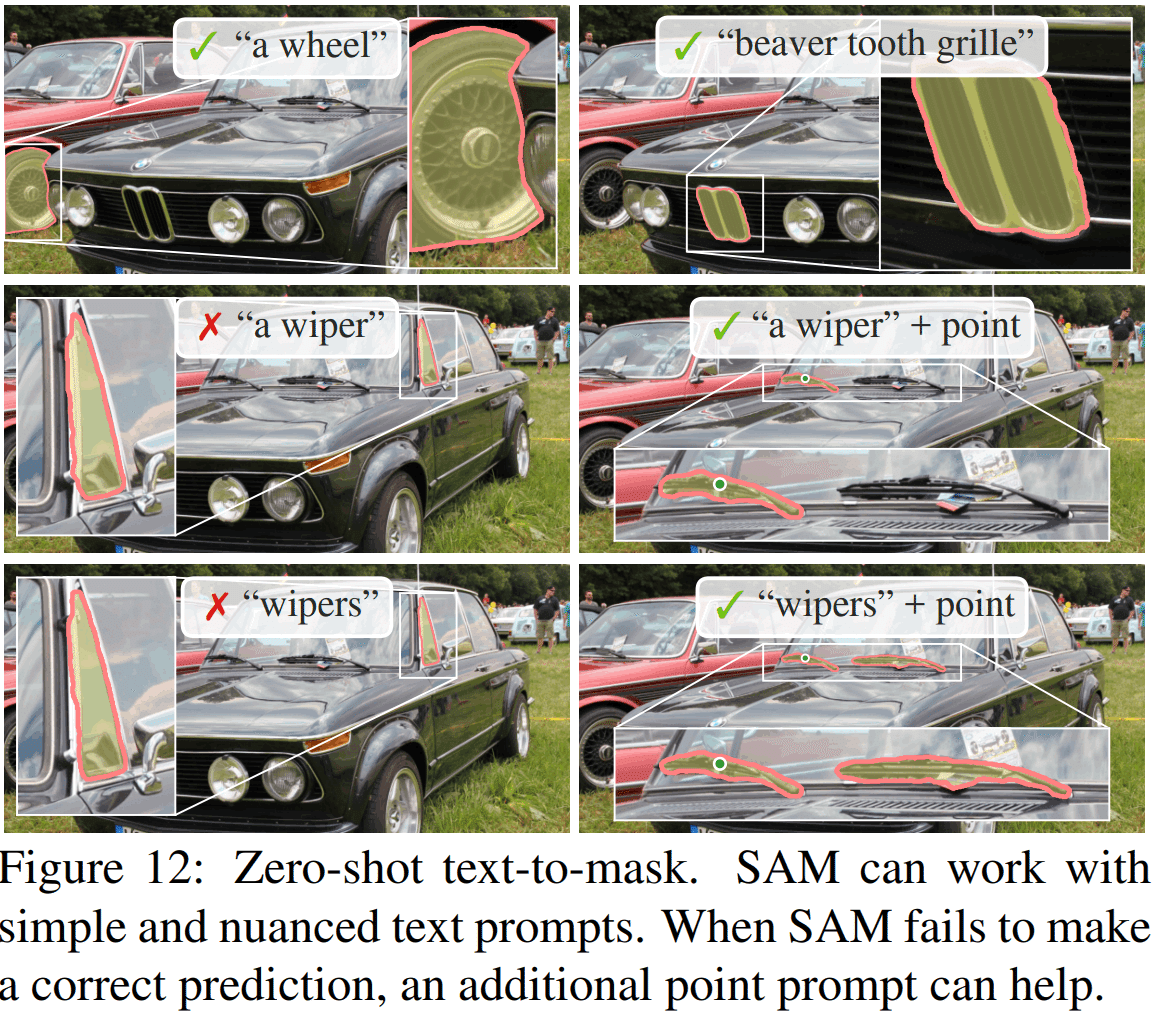

ちなみに、ChatPDF が示してくれた「論文の中の、どこにある?」に関する質問に対する回答は、完璧でした。p.11 7.5 に書いてあるよ!と回答が帰ってきて、7.5 の中で使われていたのが以下の Fig.12 です。

Segment Anything の今後

Segment Anything は、モデル、データセットともに公開されていますが、研究用途以外の使用は一切認められていないようです。なので、今すぐこれを商用利用することはできません。

1100万枚のデータに11億個のアノテーションがつけられたとのことなので、到底すぐに用意できる量ではないです。また、アノテーションをする人の教育にも力を入れたと書かれており、アノテーターは平均1週間程度の訓練期間があり、それを卒業してから本番データのアノテーションを行ったとのことです。ものすごい力の入れようです。

当分、この性能に匹敵するものが出てくることはないでしょう。

と、思っていました。少し前までは。

翻訳アプリでGoogle に勝てる会社なんて出るわけがないと思っていました。もうすぐ、DeepL への課金が3年目になろうとしています。

GPTの学習なんて、必要となるデータ量が多すぎて現実的ではない。LLMなんて、結局誰も使いこなせない。と思っていました。今は、どこもかしこもChatGPTです。

なので、Segment Anything も近い将来デファクトとして使われるようになっているかもしれません。

とてつもないことができるようになっているのは事実なので、目が話せません。

今日のランチ

キャベツとネギと小麦粉と卵とかつおだしと水を練り合わせて焼いたお好み焼き

明日は出社するから、いいもの食べるぞ。。。

宣伝

機械学習でビジネスの成長を加速するために、Fusicの機械学習チームがお手伝いしています。機械学習のPoCから運用まで、すべての場面でサポートした実績があります。もし、困っている方がいましたら、ぜひFusicにご相談ください。お問い合わせから気軽にご連絡いただけますが、TwitterのDMからでも大歓迎です!