WD1.4 Taggerの結果を実際のdanbooruタグと比較してみた。

画像からdanbooruのタグを予測するWD14 Taggerとかいうのがあるみたいなのでどんなもんか試してみました。下のgit リポジトリはwebuiのextensionであり元のモデルやコードとかはでぃすこからもってくるようです。アストルフォの画像を渡して1girlとか出てくるのを見て馬鹿にしてやろうとおもって試したのですが、1boyとかotoko_no_koと返してきてびっくり仰天しました。danbooruのタグは人間が入れているので正確ですが、画像によってどこまで詳細にタグ付けするかはまちまちです。AIによる一貫性を持った基準でタグ付けしたほうが学習用にはいいのかもしれませんね。

比較

比較用のデータはたまたま持ってたfate_(series) soloで検索した10000枚ちょっとの画像です。taggerの閾値はデフォルトの0.35です。とりあえず難しいことは考えず、両方あるとか片方しかない、とかそういうのを数え上げてみます。

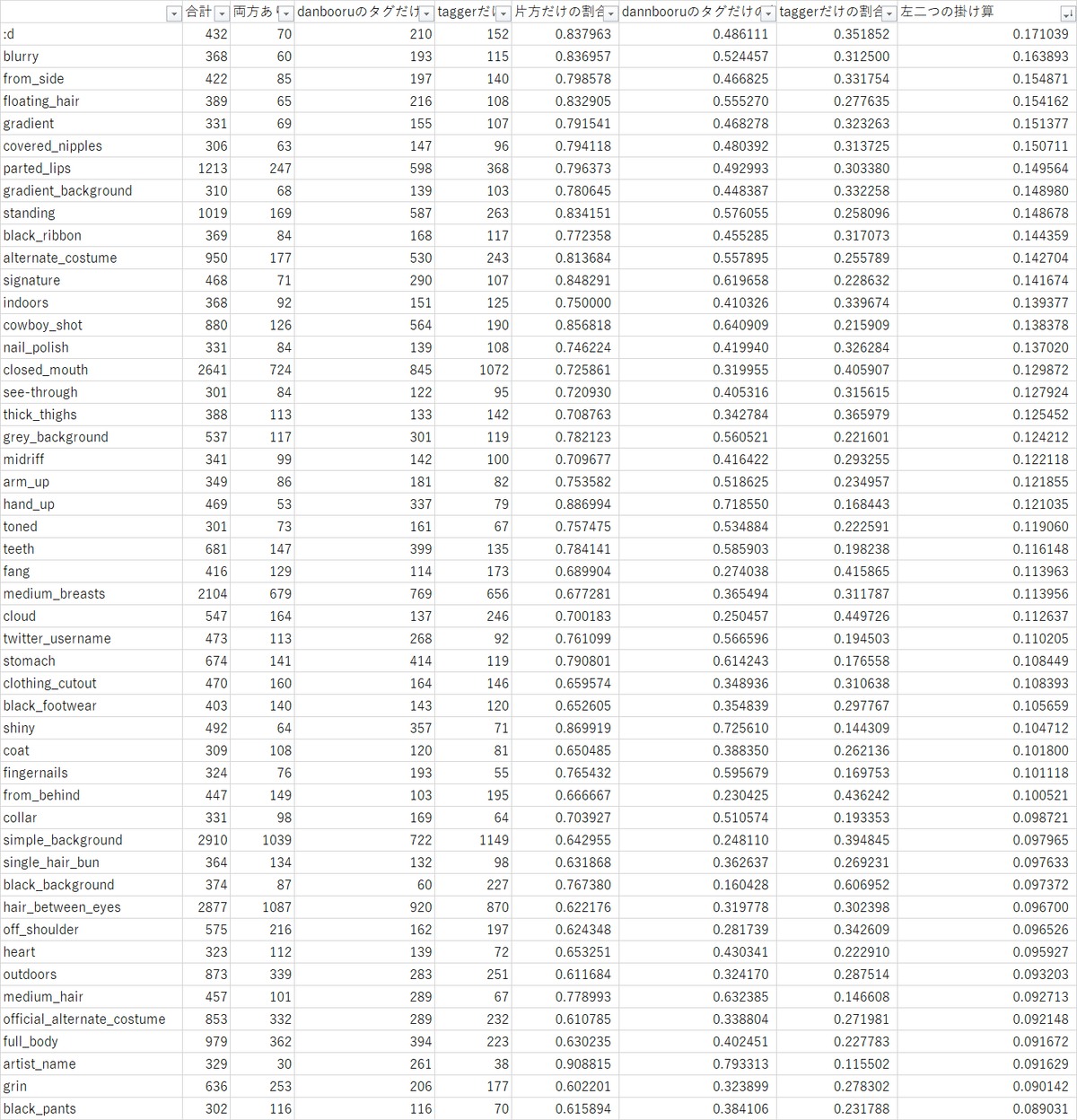

結果(300回以上出現したタグのみ)

※想像つくと思いますが、R-18な単語が含まれます。

左二つの掛け算って何だという感じですが、数値が小さいほどおそらくいいです。まず片方だけにつく割合が低いタグはこの数値も小さくなります。さらに片方だけの割合が同じでも、danbooruタグだけの割合と、taggerだけの割合が離れていればいるほど数値が低くなります。0.1×0.9 < 0.5×0.5 みたいな感じです。どちらか一方にだけ付けられるタグはあまり問題ではないです。それより両方均等にタグが付くにもかかわらず結果がバラバラなのが一番よくないですよね。理論的裏付けはないですけど導出が分かりやすいOPSみたいなもんです。

うまくいってそうなタグ

というわけで上の仮説をもとに左二つの掛け算ランキング~

soloが1位ですが、そもそも検索に使ったタグなのでノーカンです。というわけで1位は1girlです。体の特徴(というか動物の特徴?)を表すタグが多いですね。服の中でも確かに水着や着物は識別しやすそうなので、割といい指標なんじゃないか?(taggerの性能を確認するための指標を、taggerによる統計データで評価したら本末転倒やないかい!)

うまくいってなさそうなタグ

上の昇順

1位は:dです。いや:dってなんだよって感じなのでこの結果には納得です。alternate_costumeといった、画像そのものではなくキャラクターの知識が必要なタグが上にくるのもやっぱりかーという感じではないでしょうか。問題になりそうなのは、standingやclosed_mouthでしょうか。この辺りは画像生成するときも頻繁に使うタグなので、結果がばらばらなのはよくなさそうです。simple_backgroundやblack_backgroundは、Taggerの推論時に正方形にするために、画像をパディングしてるからでしょうね。medium_breastsみたいな人間の主観に依存するようなタグもありますね。みなさんはどれくらいからどれくらいがmediumだと思いますか。私ははさめるけどうまらないくら;@「;r

Danbooru(人間によるタグ付け)に偏ったタグ

danbooruのタグだけの割合降順

画角に関するタグがワンツーです。4位5位については、AIは光沢が理解できていないんですかね。あとはartist_nameやtwitter_usernameといった人間にしか分からないような概念が上位に来てますね。でもこんなタグ誰が得するの。

Taggerによるタグ付けに偏ったタグ

taggerだけの割合降順

1位のletter_boxedなどの背景タグは、先ほど述べた通りTaggerの推論時だけ画像をパディングしているので、そらそうなるだろうという感じです。学習にはあまり関係なさそうなタグですが、消しておいた方がいいかもしれません。他はちょっと数字だけでは、人間によるタグ付けが漏れているのか、AIが間違っているのか分かりませんね。画像を1枚1枚みていかないとだめですかね。

まとめ

結果が割と納得いく内容でした。うまくいってないタグを外して学習するのもありかもしれません。もっといい比較方法があれば教えてください。