15分で分かる人工知能と計算機科学の歴史<前編>

1.はじめに

私が機械学習の研究を始めたのは2002年でした。各家庭にブロードバンドが普及し始めたインターネットの黎明期です。そのブルーオーシャンを一気に手中に収めようと、ソフトバンクが街中でADSLモデムをバラまいていました。

当然、計算機科学の花形は、インターネットやその基盤を支えるデータベースに関する研究です。当時は、機械学習など誰にも振り向いてもらえない不毛の研究分野でした。すごい勢いでモデムをバラまくソフトバンク社長の頭より不毛だったのは、よくできた皮肉だと思います。

なぜそこまで不毛だったのか?

詳細は後編で説明しますが、軽く先走ると、数学の素養が高いレベルで求められるにもかかわらず、社会的なインパクトなど皆無の基礎研究でしかなかったからです。

ザ・キング・オブ・地味。三国志で言えば東北の公孫瓚、信長の野望で言えば飛騨の姉小路のような泡沫ポジションだったのです。各社が札束を抱えて「AI人材」なる非実在青少年を追い求める現代にあって、若い人には信じられないかもしれませんが、本当です。

そして、ぺんぺん草すら生えない不毛の研究分野においてさえ見捨てられた研究トピックがありました。そう、現代の我らが大正義「にゅーらる☆ねっとわーく」です。

当時は「あんなブラックボックスに何ができるんだ」などと、異端審問にかけられた魔女のように白い目が向けられていたのです。

その魔女が「機械学習こそ最強の学問である」「ディープラーニングにあらずんばAIにあらず」などの極論を、産業界にして言わしめるほどの下克上を成し遂げたわけですから、私にしてみれば西から日が昇るほどの大事件です。

このように、短期間で価値観が180度転回する業界をクロスレンジで観察しても、目が回るばかりでその動向を把握することは難しいでしょう。そこで、「人工知能と計算機科学の歴史を学んでロングレンジからその全体像を眺めようぜ!」という野心的な魂胆が、ふと思い浮かぶわけです。

歴史を知れば未来が見える。嗚呼、温故知新。いまこそ皆で歴史を振り返り、人工知能と計算機科学の進歩に思いを馳せようではありませんか!(拳を握りしめながら)

2.人工知能研究のはじまりとニューラルネットワークの誕生

1936年にチューリングが「計算の原理」を数学的に明らかにした後、1944年にノイマンがその原理を電子回路で実現する近代的な計算機アーキテクチャを確立しました。

1950年代にトランジスタを用いたコンピュータが実現されると、世界の科学者はその計算能力に驚嘆したそうです。当時の科学者界隈でネットスラングが流通していれば、「コンピュータ速すぎワロタwwww」などとテンション爆上げだったに違いありません。

チューリングが予言したとおり、今後コンピュータの性能が順調に上がれば、本当に人間の知能を実現できるかもしれない——計算機科学者のマッカーシーとミンスキーはそう考え、1955年から「思考する機械」の研究を始めました。コンピュータ誕生のインパクトを考えれば、ごく自然な野心だったと言えるでしょう。

そして、翌年の1956年に、彼らは当時の主要な計算機科学者をダートマス大学に集めて会議を開きました。「人工知能(Artificial Intelligence)」という用語は、会議参加を促すためにマッカーシーらが書いた会議開催の提案書で初めて用いられた……本当かどうかは分かりませんが、このあたりのドラマはうまく脳内補完してください。

この会議で「人工知能」と呼ばれる新しい分野がめでたくキックオフされ「探索」を軸にしたアプローチで第一次人工知能ブームが盛り上がっていきます。例えば、1956年に開催された国際数学者会議では、計算機科学者のダイクストラが最短経路を探索するアルゴリズムを「人工知能」として発表しました。

このアルゴリズムによれば、出発地から目的地まで到達可能な経路選択の組み合わせが多数あり、距離がそれぞれ異なるという制約のもとで、コンピュータが人間より高速に最短経路を計算できました。

これは、人間の思考過程をシミュレーションしている!いや、高速エミュレーションとまで言っていいのではないか!?なんたって、機械が最短経路を「考える」んだから!すごい!すごいよ!人工知能バンザイ!!

ダイクストラのアルゴリズムは、現代ではカーナビや乗り換え案内を実現する基本としてよく知られています。当時の研究者たちは、この基本アルゴリズムを「人工知能」と呼んで大はしゃぎしたわけですが、これをピュアすぎると言って笑うのは後知恵です。

現在最先端のディープラーニングも、すでに大はしゃぎがひと段落して「単なるシステム」になってますよね。各時代において「先端の情報処理」が人工知能と呼ばれ、それが社会に浸透するほど「単なるシステム」としてそう呼ばれなくなるというのが、人工知能でお決まりのパターンです。

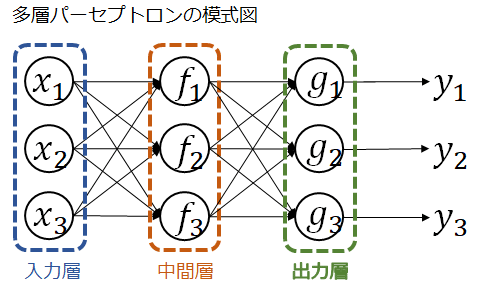

計算機科学者がさまざまなアルゴリズムを競って考案する一方で、心理学者のローゼンブラッドは、1958年に「パーセプトロン」を発表しました。これは脳の神経細胞をモデル化した「形式ニューロン」を多数組み合わせ、それらの重み付き多数決で結果を出力する数理モデルです。

簡単なパターンを認識できただけでなく、正解データから重みの一部を学習することでその認識精度を改善できました。これが世界初のニューラルネットワークです。

パーセプトロンは世界中から多くの注目を集め、その後は様々な種類のニューラルネットワークが考案されるようになります。ディープラーニング大正義の現代では、多層パーセプトロンがニューラルネットワーク界のセンターアイドルですが、実は地下アイドルがたくさんいます。

さて、第一次人工知能ブームと日本の高度成長とは、だいたい時期が同じです。日本が国民総生産で西ドイツを抜いてアメリカに次ぐ世界第二の経済大国となり、1回目の東京オリンピックが開催された時期です。もはや戦後ではない。団塊の世代の目頭が熱くなる三丁目の夕日です。

画像出典:NIKKEI STYLE「東京五輪は「大転換」の象徴 半世紀前の再現なるか」

この時期のブームは、計算機に対する期待が大きかっただけに、それが外れたと知れ渡ったときの揺り戻しも大きかったようです。「結局大したことできねーじゃん」と、皆で一斉にガッカリしたのです。

なぜショボかったのか?

理由は簡単、ハードウェアがショボかったからです。

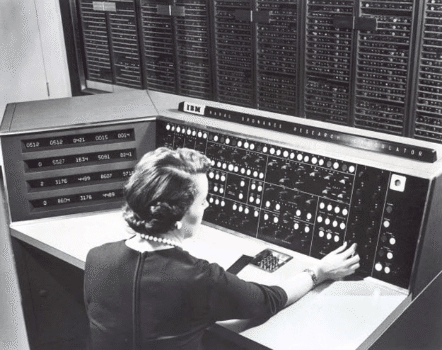

(下の写真は、1954年に開発された「IBM NORC」)

当時のコンピュータは、現代の子ども向け携帯ゲーム機にもまったく及ばない性能しか持っていませんでした。そのため、本当に解きたい現実の複雑なタスクには全然対応できなかったのです。アムロがいくら優秀なパイロットでも、モビルスーツの性能がショボければどうしようもありません。

その失望から、1960年代の後半から研究資金が削減され始め、ほどなく人工知能の研究全体が下火になります。いわゆる「冬の時代」の到来です。

けれども、分野全体が滅びたわけではありませんでした。コンピュータと人工知能の可能性に魅せられた科学者たちは、資金が少なくとも地道に研究を続けました。

人間に知性が宿る限り、いかなる逆境にあろうとも、技巧の限りを尽くして坂の上の雲を!いや、はるか彼方のアンドロメダを目指そうではないか!!

すごい執念ですね。一流の科学者たちが持つこのマインドには頭が下がります。そして、これが次のブームを生み出す原動力となるのです。

3.知識工学の進歩と第五世代コンピュータプロジェクト

1958年に集積回路が発明され、1960年代の前半にその量産化が始まると、コンピュータの計算能力はすさまじい勢いで向上し始めました。

インテル創業者のムーアは、1965年に発表した論文で「同じ面積を持つCPUに組み込まれるトランジスタの数は18ヶ月ごとに2倍になる」と予言しました。これが有名な「ムーアの法則」です。

トップが大胆にブチ上げた以上、インテル開発陣は頑張るしかありません。会社の威信にかけて、予言を妄言で終わらせるわけにはいかないのです。過酷なノルマを課された営業社員のような状況に当惑したエンジニアは多数いたと思います。しらんけど。

そして……開発陣はよくがんばった!感動した!!

トップのムチャ振りを本当に実現したのです。予言どおり、CPU内のトランジスタ数は爆発的に増加し、その計算能力は驚異的なスピードで伸び続けました。

画像出典:情報処理概論

さて、ムーアの法則にしたがってコンピュータが進歩すれば、今度こそ知能を持たせられるに違いないと、また多くの科学者が期待し始めました。だって、前回はハードウェアがショボすぎたことがうまくいかなかった原因だったわけですから。

例えば、パーセプトロンのように学習を覚えた高性能コンピュータが、人間と同じように知能を進歩させるかもしれない——そう素朴に信じる人もいました……あれ?なんだか最近も似たような言説をチラホラ見た気がしますが……きっと気のせいでしょう。

その気運に乗って、1970年代の後半から80年代に入る時期に、再び人工知能にスポットライトが当てられます。第二次人工知能ブームの幕開けです。

この時代のブームのキーワードは「知識表現と推論」でした。人間が問題解決の能力を持つのは、経験から学び取った「知識」に基づいて、結果を予測したり原因を推測したりするなど、何らかの「推論」を行えるからだと科学者たちは考えました。だから、コンピュータに現実の複雑なタスクを処理させるためには、同じように知識と推論を実装すればいいだろう。

そのために、人間が経験的に蓄えた知識を、まずコンピュータに体系化しておこう。そして、人間がデータを入力すると、人工知能はそのデータと知識を照合し、マッチすればその知識をロジカルな規則に当てはめて結果を推論すればいい。実にシンプルですね。

1970年代の前半に計算機科学者のファイゲンバウムによって考案されたこの枠組みを、「エキスパート・システム」と呼びます。また、条件・結果などを知識として体系化したデータベースを「知識ベース」と呼び、その知識を当てはめて最適な結果を推論する仕組みを「推論エンジン」と呼びました。

画像出典:そうだ!研究しよう「第2次AIブームで盛り上がりを見せた「知識表現」に関して:エキスパートシステムとは!?」

知識ベースに依存しない推論エンジンが商用化され、知識(ナレッジ)を差し替えるだけで新しい分野で簡単にシステムを作れるようになると、エキスパート・システムは多様な分野に応用されました。

例えば、新薬の開発、地層の解析、機関車の故障修理、航空機の離着陸管制などなど。人間の意思決定をコンピュータに補助させようという発想はこの時期に生まれ、その実用化はある程度実現されたと言えるでしょう。「コンピュータが人間の仕事を奪う」と囁かれたのは、最近の話ではないのです。

知識表現と推論がメインテーマとなったこの時代では「知識工学」が発達しました。優れたナレッジを体系化するための手法とそれを蓄えるデータベースを追求する学問です。そして、これからは「ナレッジ・エンジニア」が大量に必要になると声高に叫ばれました。

しかし、祇園精舎の鐘が鳴ると、知識工学は尻に敷かれたポテトチップのように粉々になり、ナレッジ・エンジニアも雲散霧消しました。昨今はデータサイエンティストが大量に必要だと言われていますが、いまゼロからデータサイエンスを学んで年収アップを狙うくらいなら、「バーニラバニラ高収入」を選ぶ方が賢明かもしれません。

さて、第二次人工知能ブームが盛り上がった時期も、日本経済は絶好調でした。オイルショックとプラザ合意による円高を乗り越えて貿易黒字を積み上げ、「ジャパン・アズ・ナンバーワン」の黄金期を迎えます。

日本は、繊維、重工業、自動車、電機、半導体と、次々に国内産業を育てることに成功してきました。一方で、当時のコンピュータ産業は、IBMをはじめとする米国企業が圧倒的な主導権を握っていました。

そこで、従来型のコンピュータとは設計思想が異なる次世代のコンピュータを実現し、アメリカから主導権を奪って次の基幹産業に育てるために、野心的な国家プロジェクトを進めようとしたのです。

このプロジェクトは「第五世代コンピュータプロジェクト」と名付けられました。つまり、コンピュータに実装される論理回路として、

・真空管を使う→第一世代

・トランジスタを使う→第二世代

・集積回路を使う→第三世代

・超集積回路を使う→第四世代

と位置づけ、その先を行く高度なアーキテクチャを持ったコンピュータによる情報処理——すなわち、人工知能の実現を目指すプロジェクトだったのです(ちなみに、そのアーキテクチャは「非ノイマン型コンピュータ」という触れ込みだったのですが、ここでは割愛)。

理論的な裏付けが何もない状態から「独自に新型モビルスーツを作ろうぜ!」などとコンセプトだけが先行するこのノリに、すでに地雷臭しかしないのは後知恵でしょうか。

通産省(現在の経済産業省)主導のもので産学連携の体制が整えられ、プロジェクトが滑り出します。日本のプロジェクト開始を皮切りにして先進各国も大型の国家予算を付け、似たような研究開発に乗り出しました。世界中で多額の資金が人工知能の研究に投下されたため、第二次人工知能ブームは一気に過熱します。

この壮大な国家プロジェクトの構想を簡単に要約すると、現代の「スマートスピーカ」の実現と言えるかもしれません。音声などの自然な方法(「マン・マシン・インターフェース」と呼びます)でコンピュータに所望の結果を伝えれば、コンピュータがその結果を知識から推論し、ユーザに理解しやすい形式で応答する大規模な並列計算システムを作り上げるという一大構想でした。

役所が一枚噛んでる時点ですでに失敗は確定してるわけで、プロジェクトは当然のごとく失敗に終わってしまいます。人間が暗黙に持つ知識を網羅的に形式化し、それらを推論規則に完璧に当てはめることなど、ほとんど不可能だったからです。

要するに、実世界に対する人間の働きかけはもっと柔軟であり、コンピュータによるトップダウンの機械的な計算アプローチのみでは対応しきれないことが多すぎるんですね。結局、プロジェクトはバブル経済の崩壊とともに座礁してしまいます。

1990年代に入ると、ハードウェアの進歩に伴うダウンサイジングの流れが強まり、コンピュータの構成は大規模なメインフレームを中心とする集中型から、各ユーザが用いる小型端末とそれらを相互接続するネットワークとで構成される分散型へ移行していきます。

エキスパート・システムは、「コンピュータで人間の作業が省力化される」というポジティブな認識を社会に残しました。ただし、このシステムも分散型への移行に伴って、「知識表現と推論」という大がかりな仕組みでなくとも同等以上の結果が得られるようになり、人工知能とは呼ばれなくなりました。ああ、諸行無常の響きあり。人工知能って本当に闇が深いですね。

一方で、大きく飛躍した研究テーマがあります。そうです、我らが大正義「にゅーらる☆ねっとわーく」です。

ローゼンブラッドが提案した初期のパーセプトロンは、数学的な制約によりその「一部」しか学習できず、ミンスキーらによって数理モデルとしての限界が指摘されていました。そのため、このパーセプトロンは「単純パーセプトロン」と呼ばれます。

これに対して、日本が誇るスーパー科学者・甘利俊一先生(現在は理化学研究所脳科学総合研究センター特別顧問)が1967年に巧妙な工夫で制約を取り払い、パーセプトロンの「全体」を学習できるように拡張しました。

「確率降下学習法」と呼ばれるこのアルゴリズムは、1979年にヒントンらによって再発見され、「バックプロパゲーション(誤差逆伝播法)」とカッコいい名前が付けられました。そして、拡張された単純パーセプトロンは「多層パーセプトロン」として広く認知されます。これが後年のディープラーニングの基礎となります。

ちなみに、甘利先生はそのご著書のなかで、「温泉に入ってたら思いついちゃった☆」とブレイクスルーなアルゴリズム誕生の瞬間を述懐されており、我ら凡百の徒には計り知れない何かが宿っているとしか思えません。

第五世代コンピュータが失敗に終わる頃、第二次人工知能ブームは収束を迎えます。人工知能は、また「冬の時代」に入ってしまいました。

続く。

待て!後編!

→ 後編を書きました。

====

・この記事を書いた藤田の Twitter は、こちら

・本稿は、「面白い文章を書けるようにするクラブ」のレビュアの皆さまからアドバイスをいただいて執筆しました。ありがとうございます。

クラブ楽しいよ!レッツ・ジョイン!