Vtube Studio使い方ガイド - 製作者向け

※追記案内 (2021/03/13)

Vtube StudioがSteamに移動しました!

伴って、ウェブカメラによるトラッキング、音声ベースのリップシンク機能が開発・追加されました。また、以降の更新はSteam上で行われます。さらなる新機能がリリースされましたら随時追記します。

※追記案内2(2022/11/17)

当記事を修正・追記いっぱいしました。

モデルの調整方法も書いたのでこちらも合わせてご一読ください。

アイテム機能についてはこちらをどうぞ。

※追記案内 (2023/12/20)

・音声リップシンクの項目を修正しました。

・アプリケーションのFPS設定項目を追加しました。

0. VTube Studio ってどんなソフト?

VTube Studio(VTS)は、ドイツ在住のアーティスト・開発者である Denchi さんによって開発された、LIVE2D専用のリアルタイムフェイストラッキングソフトです。

日本国外のVtuber(ENVtuberなどと呼ばれる)の間では、最もメジャーなソフトです。したがって、国外のVtuber関連のコミッションを受けると、たいていはVTSに対応している前提で話が進められます。

PC版(後述)は、こちらよりダウンロードが可能です。

上記リンクの [ Documentation ]は英語のpdfマニュアルとなっています。

かわいい説明書なのでぜひ目を通してみてください。

*追記(21/03/13) : 近いうちに日本語訳した最新版が公開される予定です。 追記2(22/11/17) 日本語訳はまだ無いです。自分がnoteでちまちま執筆していくので、ゆるりとお待ちください。

過去の記事でも紹介しています。他のソフトウェアとの差別化はこちらを読んでいただければなんとなくわかるかと思われます。

本記事では過去記事と重複している内容があります。ご了承ください。

1. 使用環境 - 使い方ガイド

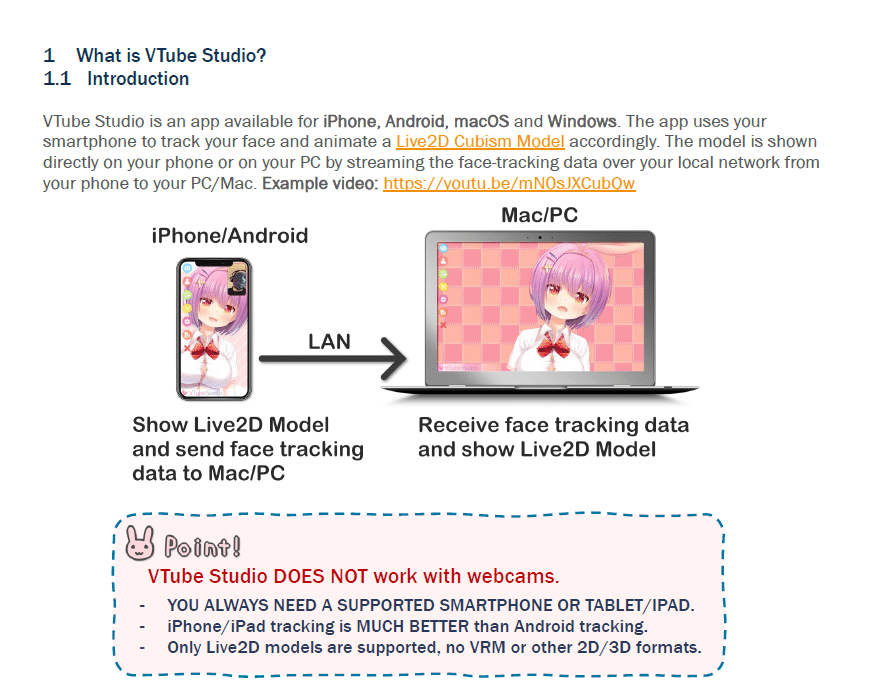

VTSはFaceRigやAnimazeとは異なり、Webカメラを使いません(~ver1.6.0未満)。

代わりにスマートフォンかタブレット端末(以下スマホ)のカメラ機能を使って、表情を認識させ、認識した表情をUSB接続経由でパソコンと同期させます。(Wi-fiを使って無線接続も可能ですが、少々不安定です)

実際にモデルを顔認識に合わせて動かすためには、パソコンとスマホの両方が必要になります(Webカメラを使用する場合はPCのみでOKです)。また、スマホが iOS なのか Android なのかで仕様が大きく異なります。

そのため、VtubeStudio の アプリ と パソコン側のソフトウェア の2つが必要になります。Windows, Mac に対応しています。

スマホだけで活動する場合はアプリのみの使用で完結できます。YouTube, Twitch等での配信や動画制作を視野に入れるのなら、パソコンもあったほうが良いです。

ダウンロードはスマホ用アプリ、パソコン用ソフト ともに無料です。

連続して1分以上パソコンと同期するためにはPro版にする必要があります。~25-30USD(3,000円前後)くらいでスマホのアプリ内購入をすることでアップグレードが可能です。Pro版にすると商用利用も解禁されます。

1分だけ同期できるのは、動作確認などのためですね。実際に動作するのを確認してからPro版にしても良いかと思われます。

スマートフォンを介したトラッキングは、物理的にちょっと不便というデメリットを遥かに凌駕する圧倒的なメリットがあります。それはマシンスペックを圧迫しないことです。ノートパソコンでも快適に配信ができます(スペック次第だけどね)。

前回の記事でも記述しましたが、これはとんでもないメリットです。要求されるマシンスペックが低くなるということは、配信の敷居が下がり、多くのユーザーがVtuberやったり配信やったりできるようになるということです。すなわち、Vtuber作ってる人への仕事もバンバン回ってくるようになります。なりました。おかげで国外の市場は大賑わいを見せています。

*1 : ver1.6.0よりWebカメラに対応しました。

2. iOS版とandroid版の違い

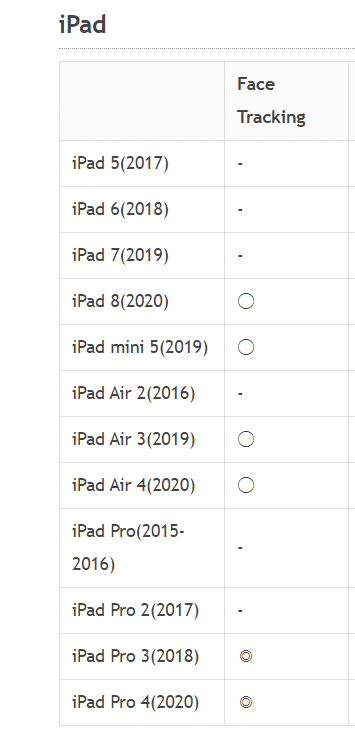

結論から述べると、 iOS機器を持っていれば、現時点で最も高精度なトラッキングを反映させることができるソフトとなっています。

一方、androidは残念な感じです。現時点では、iOS機器を持っていなければわざわざ買わなくてもいいのかな?というのが正直な感想です。

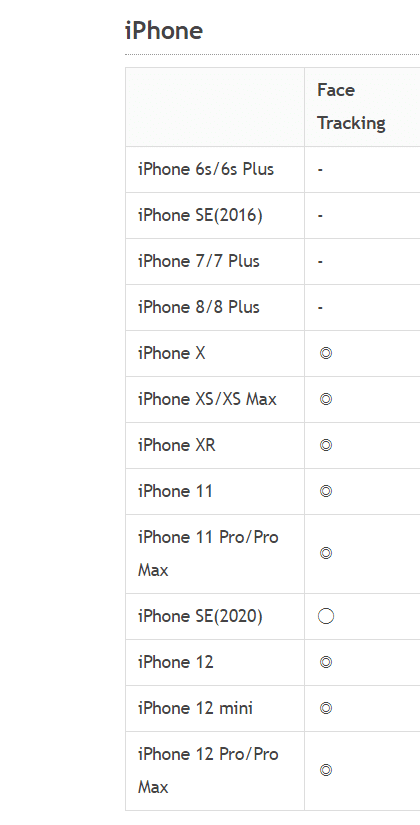

なぜandroid版は残念なのかというと、ARKitという超高精度のフェイストラッキングをする拡張現実機能を使えるのがiOS機器のみだからです。なお、フェイストラッキングを使うためには FaceID対応またはApple A12チップ以上を搭載している機器が必要です。

対応機器はこちらを参照させていただきました。(21/02/09 記事修正)

Androidは「ARCore」という機能を使っていますが、開発途中といった具合で高精度とは言い難いです。まばたきのトラッキングすらできません。もちろん、高精度にアップグレードされる可能性は超有ります。

そのため、LIVE2DモデルをVTSに組み込む際の設定方法も、iOS版とAndroid版で大きく異なります。インポート時に選ぶ項目が出て、自動でセットアップをしてくれるのであまり考えなくても良いです。

とりあえず、iOSのほうが圧倒的に高精度であることを理解しておけば良いと思われます。

サポートしてる入力値の違いです。LIVE2Dのパラメータ名ではありません

Android版では目や眼球の検出ができないため、自動目パチをしてくれます。口変形なんかもビミョーな感じです。

一方、iOS版では「舌を出す」「頬を膨らます」「怒り顔」なんかも検知します。どう使うかは技量と工夫次第ですね。

私はAndroid機器しか持っていないため、iOS用に調整したモデルを自分で試すことができませんが、パソコン上でiOS用の設定はできます。VTS用にモデルの調整をするときは、まず顧客がiOSなのかAndroidなのかを聞いて、細かく設定しています。

細かい設定をするなら機器が手元にあったほうが良いです。私も近いうちに買おうかな。← 中古のiPad買いました!圧倒的にiOS機器がおすすめ!

3. FaceRig用に制作したモデル導入時の注意点

FaceRig使ってない人は読み飛ばしてOKです!

ちょっとむずかしい話になります。

さて、本記事を読んでいる人の多くはLIVE2Dモデルを試したことがあるかと思われます。FaceRigで今まで使っていたモデルを使いたい!という方もたくさんいらっしゃるかと思われます。

FaceRigで使っていたモデルはたいてい使えますが、少し挙動が異なる部分があります。

例えばZXCVなどのキーバインドは、Cubism Viewer で再設定が必要になり、表情ファイル(.exp3)というものに書き出す必要があります(後述)。モーションは挙動が異なり、最終値が維持されません。変身モーションなどは使えません。(VTS 1.6.0 現在) 使えるようになりました。

モーション(.motion3.json)の取り扱いには注意しなければなりません。

アイドルモーションは普通に使えます。それどころかアイドルモーションを複数設定、キーで切り替えなんかも可能です。

「私のLIVE2Dモデル、依頼したものだから元データ持っていないよ!」という方でもご安心ください。ご自身で再設定できます。

モデルファイル(.moc3)があれば、編集ファイル(.cmo3)を持っていない場合でもZXCVなどのキーバインドを再設定することが可能です。モーションはできる場合とできない場合があります。やり方は後述します。

4. 画面の見方

メニュー画面等の見方は以下の通りです。

一般設定

終了ボタンを押すとVtubeStudioが閉じます。

音声リップシンクもここに含まれます。カメラ, シーンライト設定

トラッキング、バーチャルウェブカメラの設定はこちらで可能です。シーンライトを使用するとモデル全体の色をゲーム画面に馴染ませることができます。モデル設定

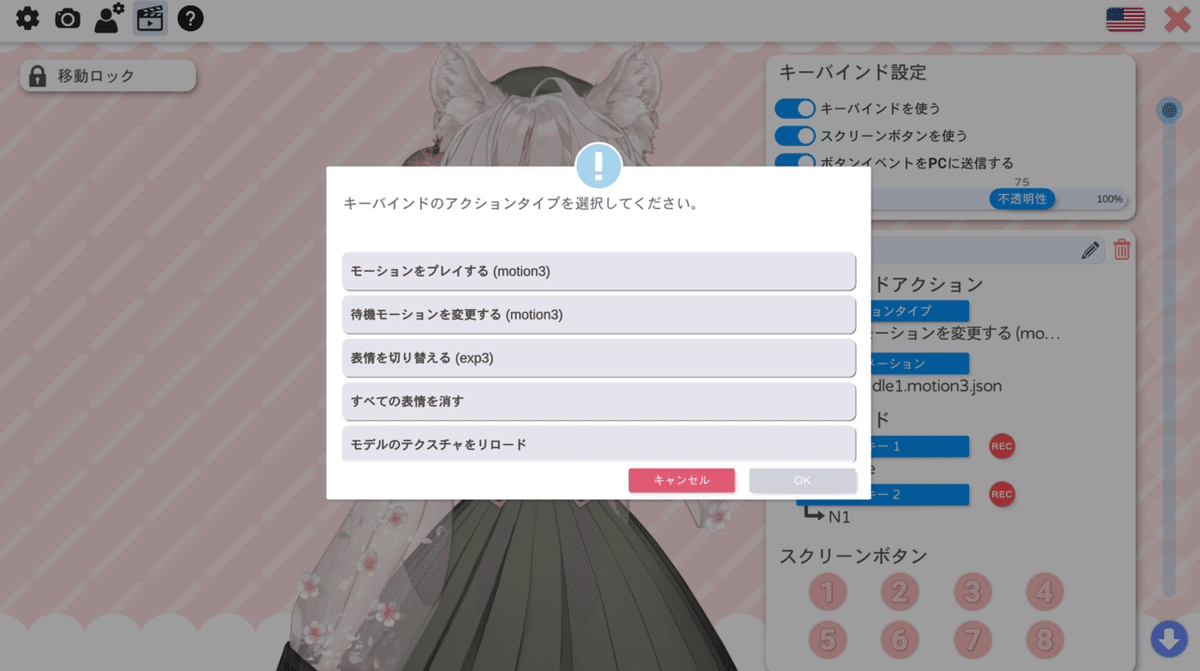

パラメータ、物理演算(揺れもの)、モデルの色変えやシーンライト周りの設定などができます。キーバインドの設定

キー押し差分とスクリーンボタンの設定、表情ファイル(.exp3)の作成ができます。手をトラッキングさせれば、手の形でモデルを操作することもできます。フルスクリーン/ウィンドウの切り替え

言語設定

有志による翻訳でさまざまな言語に対応しています。スクリーンボタン

クリックでキー押しと同様の再生ができるボタンです。アプリ版VtubeStudioにも反映され、アプリでも紐づけたアクションを実行できるようになります。

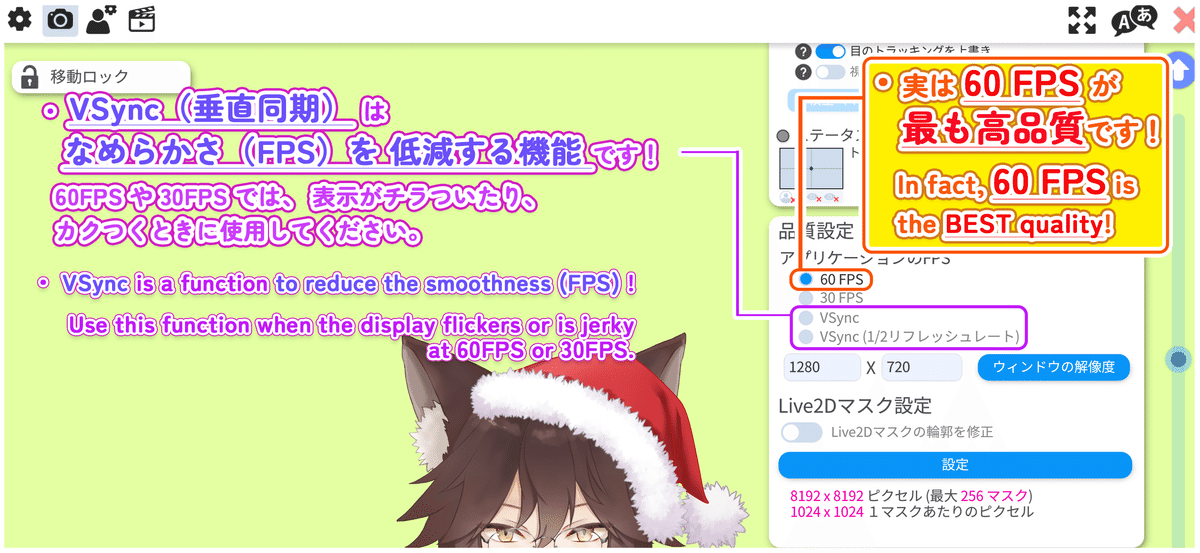

アプリケーションのFPS

・60FPSにしてください。重い場合は30FPSにしてください。

・表示に問題がある場合のみ、VSyncを使ってください。

(※ 23/12/20追記)

5. 細かいパラメータの設定

VTSでは、FaceRigで扱えた一部のパラメータの挙動がデフォルトでは異なります。FaceRigで使わなかったパラメータをトラッキングすることもあります。特に大切なパラメータの設定方法をいくつかご紹介します。

以下、iOS版もしくはWebカメラ版を想定した調整です。

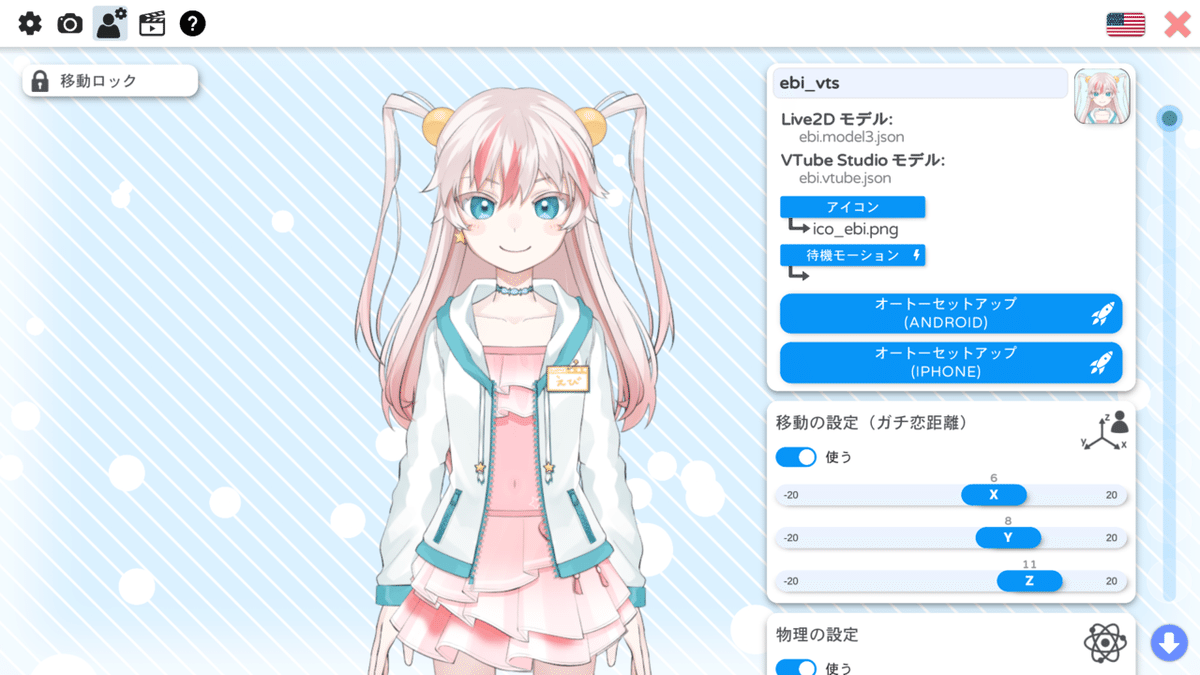

潮えび(Ushio Ebi)さんにご協力していただきましょう。

名前やアイコンや待機モーション(アイドルモーション)もここでセットできます。

まず、移動の設定(ガチ恋距離)の項目ですが、XYZを有効にすると重心がふわふわとした感じになるのでお好みで設定してください。特にZはトラッキングが外れたときに意図しない拡縮が発生します。

個人的にはオフにするのがオススメ。

・呼吸(ParamBreath)

自動セットアップしただけでは、呼吸が自動で動きません。

+ボタンを押して、このような出力を追加しましょう。

入力(IN)は必要ありません。

出力(OUT)にParamBreathを追加し、自動呼吸をオンにすればOKです。

これでFaceRigのように自動で呼吸が動いてくれます。

・笑顔による紅潮(ParamCheek)*追記:21/03/13

たいてい必要ないので削除しましょう。ほとんどはキー押し前提のパラメーターとして使われるため、意図しない動作をしてしまいます。

モデルによってはいい感じの挙動をするので、必須ではありません。

悪い競合の例として、青ざめのキー押しをしているのに笑顔時に紅潮が入ってしまい、意図していない表情になる等があります。

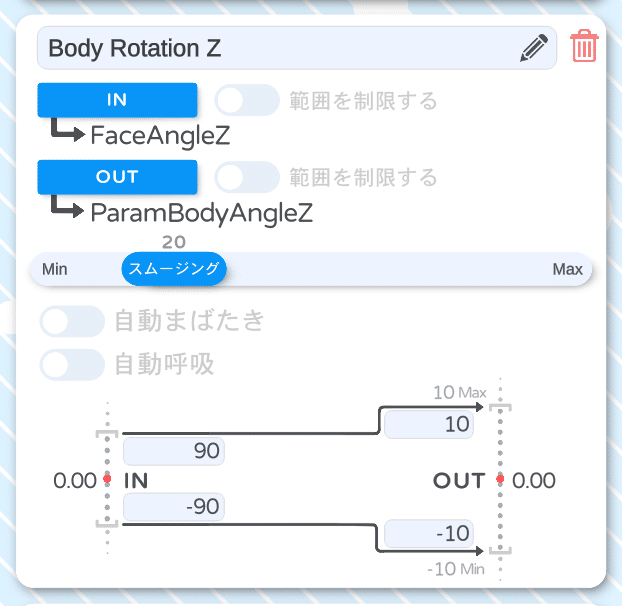

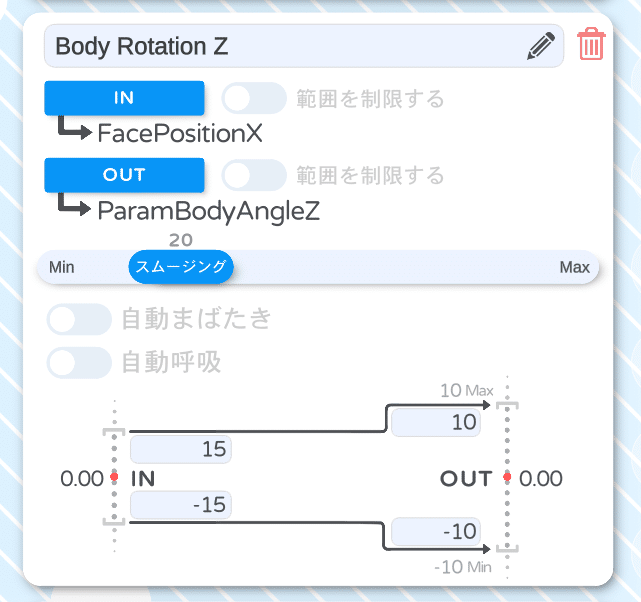

・体の回転Z(ParamBodyAngleZ)

デフォルトでは画像のように FaceAngleZ 入力になっています。

これは 角度Z(ParamAngleZ)と同じ入力であり、FaceRigと異なる挙動です。FaceRigでは 体の回転Z(ParamBodyAngleZ)がどのように動いているかというと、カメラに対する顔の位置が入力値になっています。

FaceRigの動作に近づけるには、入力を FacePositionX にします。

モデルによってはFaceAngleZを想定していることもあるため、お好みで設定してください。

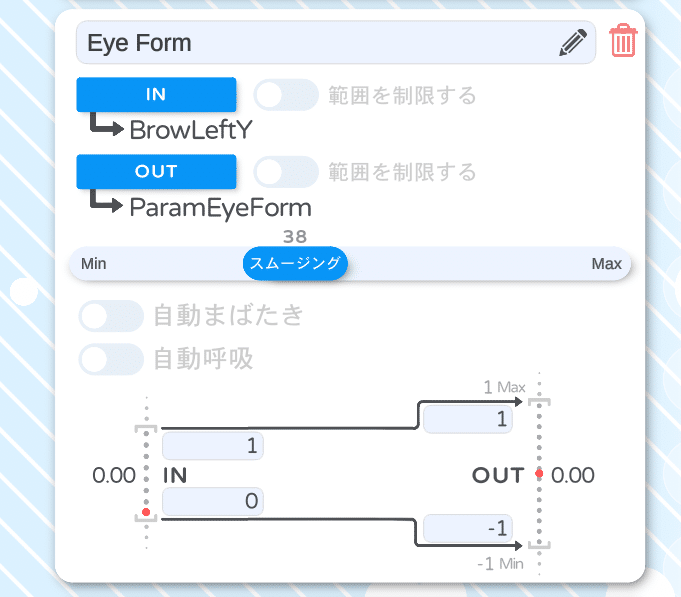

・目変形(ParamEyeForm)

FaceRigではびっくりしたときの目などで設定するパラメータです。必須のパラメータではないため、使っていないモデルも多く存在します。

VTSでは標準で出力されません。FaceRigでは左右の眉の上下の平均値に対応しています。なので、どちらかの眉に紐づけてしまいましょう。Brows入力でもOKです。

これで細かい設定はおしまいです。

ご協力ありがとうございました。

追記(2021/01/31)

上記の内容を含む、調整についての記事を青次さんが共有しています。

VtubeStudioでオートセットアップ後に設定すると良さそうなところをまとめました!

— 青次 青次 (@aotugi_seiji) January 31, 2021

設定内容は…呼吸、半目、口が微妙に開く、体の回転Z、頬紅が勝手にオンになる…です

主にモデルのパラメータ部分の設定なので、他の部分の設定は他の方の設定を参考にすると良いと思います

#VtubeStudio #Live2D pic.twitter.com/wdekLD5MXh

追記2(2022/11/17)

より詳しく解説した、最新版の記事を公開しました。

LIVE2Dを使っていない人でもわかる内容となっているため、Vtuber本人様へ共有する際などにもご使用いただけます。

6. キーバインドの再設定

FaceRigで ZXCV, Shift+ZXCV などで動いていたキーバインドは、そのままだと使うことができません。これを使えるようにするためには表情ファイル(.exp3.json)というものを書き出しする必要があります。

LIVE2D公式マニュアルはこちら

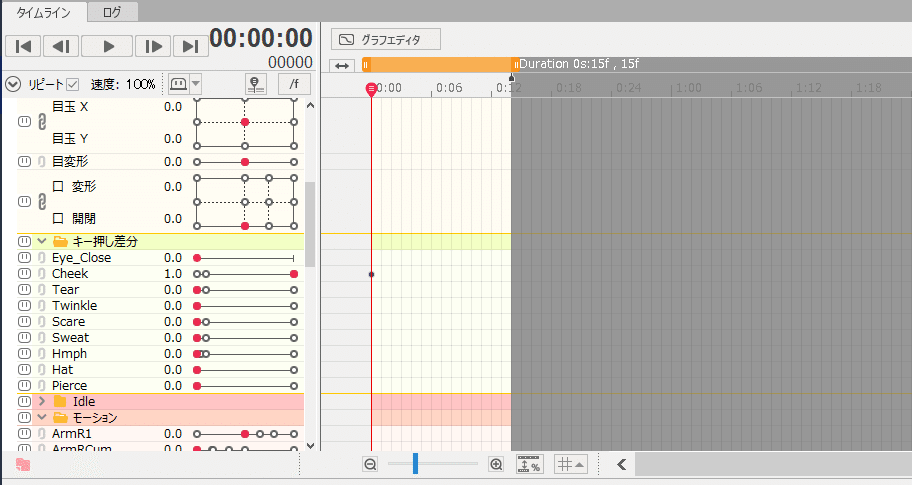

1つめのマニュアルにあるように、Animatorを起動して1フレームのモーションを必要な数だけ作り、LIVE2D Viewerで表情ファイルとして読み込み→書き出しするのが一番早いです。

↑ このように、1フレーム目に必要なパラメータのキーを設定します。

↑ シーンを複数作り「全シーンを出力」で motion3.json を書き出します。

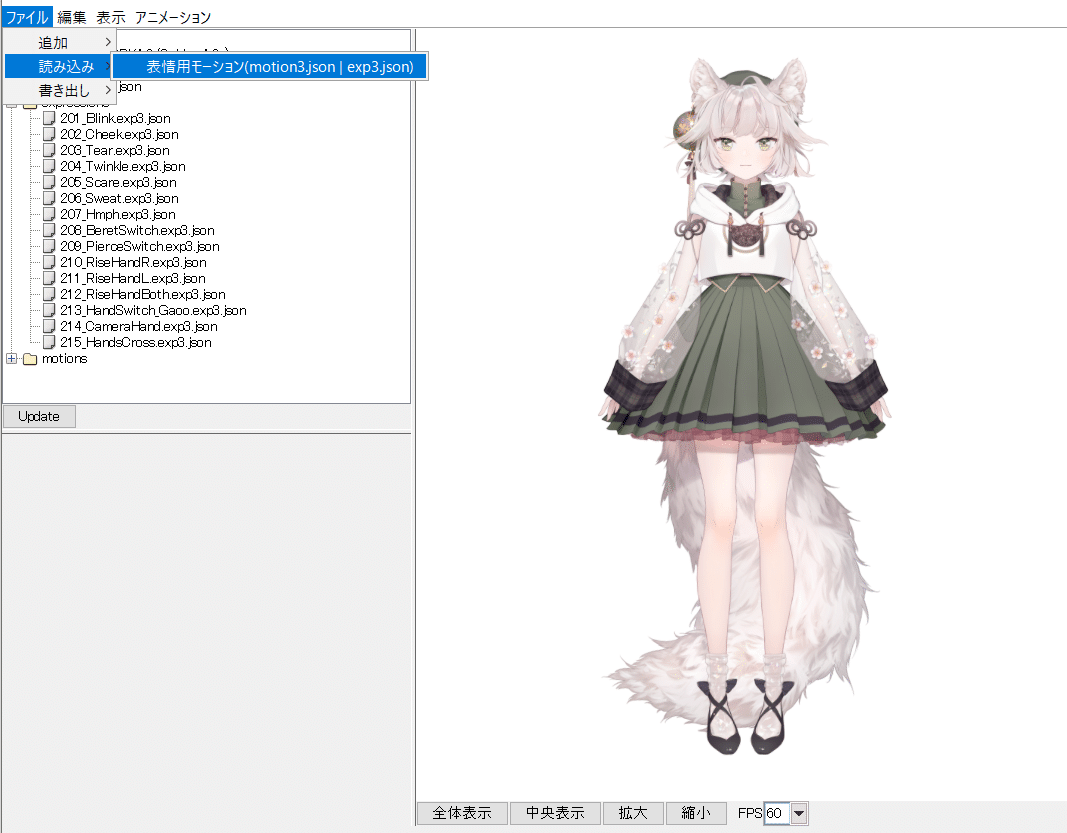

↑ 書き出したものをまとめて「表情用モーション」として読み込みます。

Shiftキーを押しながらで一括選択ができます。

↑ .exp3.jsonが作られたのを確認したら、フェードイン/アウトをお好みに調整し、書き出しから「全ての表情モーション」を選択して終了です!

元データ(.cmo3)を持っていない場合、Animatorからモーションファイルを作成することができませんが、表情ファイルは設定が可能です。

モデルファイル(.moc3)のみで作成する方法をお教えします。

用意するもの:

1. Cubism Viewer (for OW)

2. 任意の.cmo3ファイル

Cubism Viewer は Cubism Editor をフリー版とかダウンロードすればついてくる検証ソフトです。詳しくはこちら。

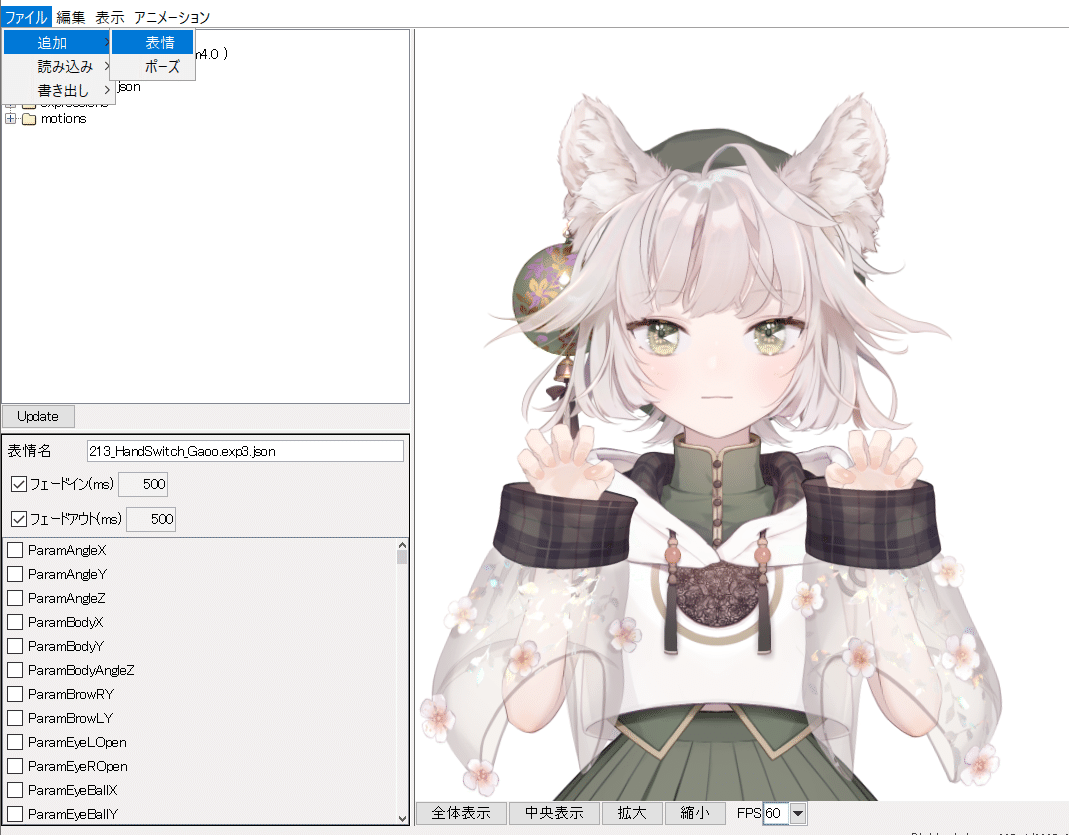

.cmo3ファイルを開き、ファイル→追加→表情 を選択します。

お好きな名前と表示名を設定します。今回はウインク。

設定したいパラメータにチェックを入れて、バーを動かせばこのとおり。

今回は ParamEyeROpen(右目開閉)と、ParamMouthForm(口変形)にチェックを入れています。

また、VTSでは演算方式がOverwriteであるため、表情ファイルが最優先されます。すなわち、表情ファイル(.exp3.json)がトラッキングより優先されます。

目を閉じた表情を作るときなど、わざわざ新しいパラメータを作る必要がないということですね。

生成された表情ファイルをまとめてVTSのモデルと同じフォルダに入れておきます。すると、VTS側でこのように選択可能になります。

あとは好きなキーに設定すればOKです。

FaceRigと異なり、自動でconfigファイルが生成されるので、文字を入力する必要はありません。入力しても動きます。

今回協力してくれたのは Feyさんでした。

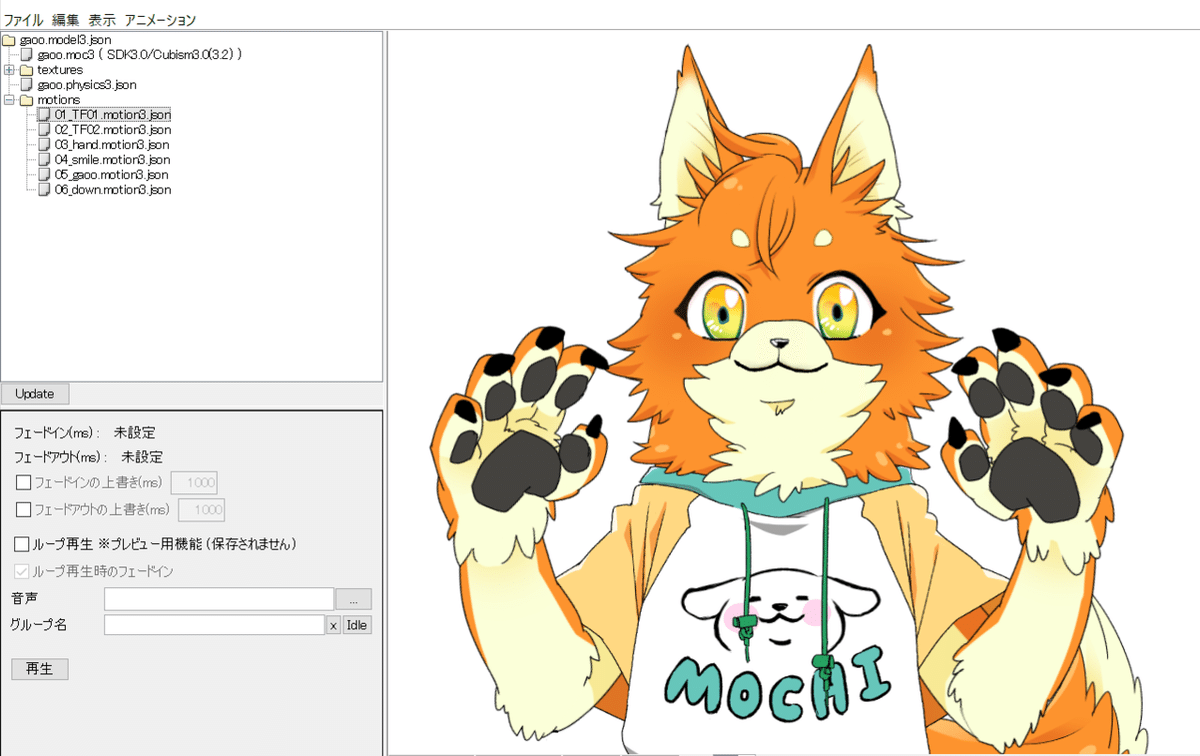

7. モーションファイルの挙動

モーションはFaceRigと大きく異なる点があります。最終値が維持されないという点です。

FaceRigサンプルモデルのgaooのような変身モーションを再生しても、すぐにもとの値に戻ってしまいます。

変身維持されません。かわいそうに。

ただ、これに関しては公式Discordの方で要望を出しており、「多くの意見をもらっており、前向きに検討している」とのことでした。こういう柔軟な対応が個人開発の良いところですよね。 モーションの最終値を維持できるようになりました!

現在は変身モーションも使えますよ~~!

それと、アイドルモーション(待機モーション)が1種類トラッキング消失時を含めて2種類設定可能であり、任意のキーでアイドルモーションを切り替えることも可能です。先ほどのモデルFeyさんでは3パターンにしっぽが動かせるようになっています。

8. バックグラウンドでの挙動

地球マークを押すとバックグランドでキー押しの反応をオフにできます。

【ののん。が教える Live2D講座17】

— ののん。nonon. @Live2Dモデラー (@nonon_yuno) October 11, 2022

VTubeStudioを使っていて

画面外で表情切替が反応してしまう方へ

ココを押すと解決します

How to disable the switching keys off-screen.#Live2D #Live2DWIP #Live2D講座 pic.twitter.com/Z0h1qJgpuP

現在は3種類のキーを組み合わせ可能です。

VTubeStudioは左右のCtrlキー/Shiftキーを別々に認識するため、右Shift+1~0や、右Ctrl+1~0などをショートカットキーとして設定するのがおすすめです。マウスのミドルクリック(スクロールするホイールを押し込む)+キーもオススメ。

MMORPGなどをプレイする方でも安心してモデルの制御が可能になります。

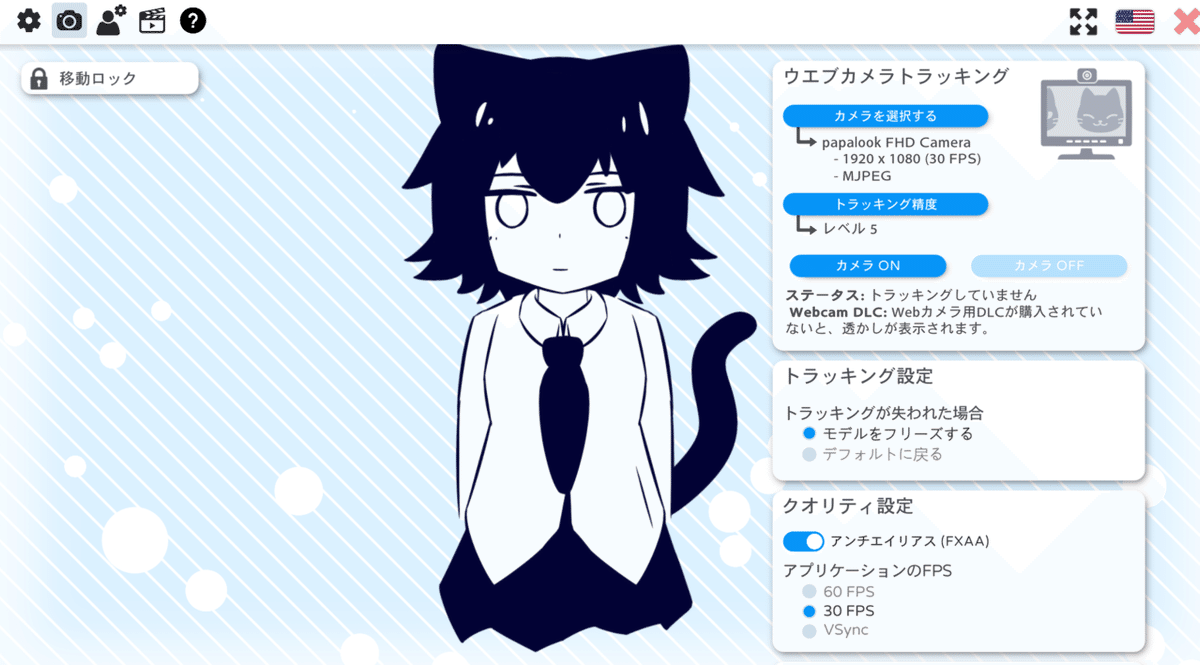

9. Webカメラの使用方法

Steam版からWebカメラによるトラッキングがサポートされました。基本無料は変わらず、透かしを削除するにはDLCの購入が必要になります。

動作確認して、支援してくれるならDLCを購入してねという意図ですね。

OpenSeeFace Webcam Tracking というものを使っているらしいです。このへんはさっぱりわかりませんが…

ここから購入できます。

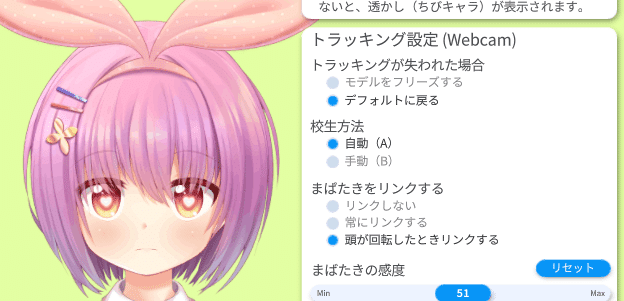

使用方法の解説、今回は過去に制作したモデルを使います。

設定を開いて、カメラマークをクリックします。

カメラはあなたが使うデバイスを選択してください。(MacOSだとカメラが使えないかも?要確認)

最初は「解像度」「フレームレート(FPS値)」「カラーフォーマット」の設定が要求されます。これらは使用するWebカメラの性能によって選択幅が異なります。詳しく見ていきましょう。

ⅰ. 解像度

高いほうが良いとされます。目やウインクのトラッキングをいい感じにするためには、1280x720以上である必要があります。

ⅱ. フレームレート(FPS)

15fpsあれば問題なく動きます。30fps以上だとより良いです。

CPU使用率と相談してください。

ⅲ. カラーフォーマット

XRGB:CPUパフォーマンスが最優先されます。

YUV/I420: CPU を使用しますが、普通のフレームレートで動きます。

MJPEG:CPUを最も使用しますが、最高のフレームレートで動きます。

さて、次はトラッキング精度のレベルを見ていきましょう。

レベル0からレベル5まであります。高精度なほどCPUに負荷がかかるらしいです。とりあえずレベル5にしておきます。重かったら下げてみてね。

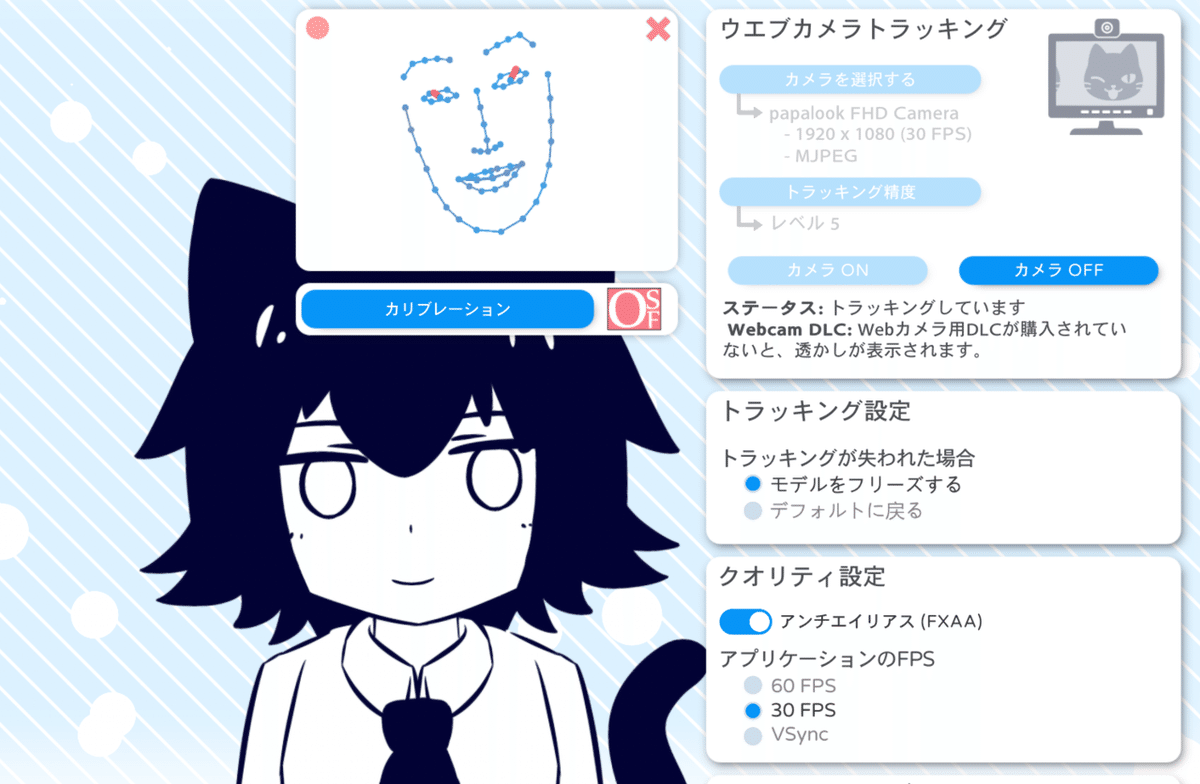

それでは、カメラをONにしてみましょう。

えっ、こわ……となる画面ですが、実写は映りません。ちょっと安心ですね。

手動(B)が推奨モードです

※追記 以下は校生方法 自動(A)の場合です。

手動(B)ならば、以下の手順は必要ありません。

すぐに閉じたくなるかもしれませんが、5秒以上顔を動かしてください。目パチや口パク、眉上下、口角の変形などを意識してください。

それから校生(キャリブレーション)を押して、画面を閉じます。

これをやるとかなり高精度になるらしいです。すると…

なんということでしょう、いとも簡単にウインクができました!なんという精度でしょうか。

Webカメラでのトラッキングはこれで完了です。簡単ですね。

姿勢や視線が変なときは、再度キャリブレーションを押してください。

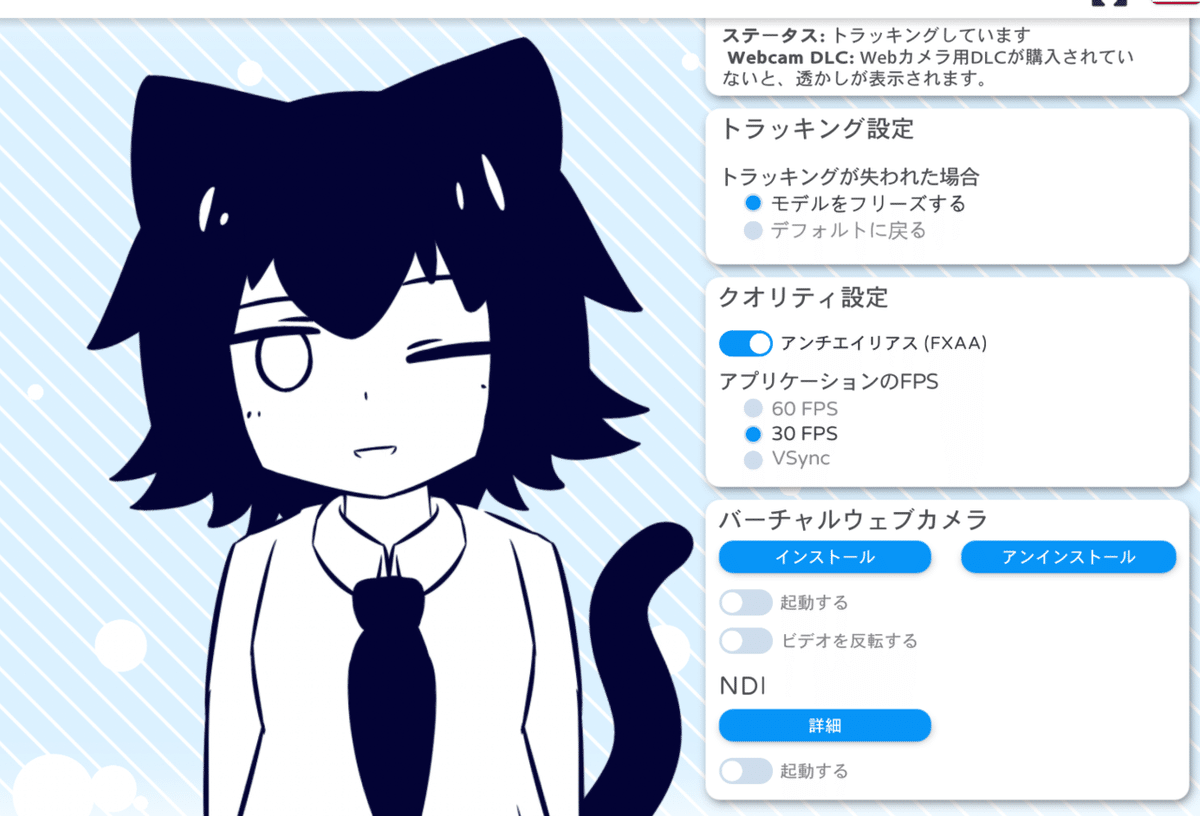

アプリケーションのFPSは60が望ましいですが、うちのパソコンだと熱暴走するので30FPSにしてあります。バーチャルウェブカメラはビデオ会議とかにカメラとして認識させて使えるやつです。NDIはスマホと連動させるときに使うため、Webカメラの使用時は必要ありません。

ちなみに、透過をするときは背景の「カラーピッカー」を使用し、「ゲームキャプチャ」で透過を許可する必要があります。

ビミョーに背景色が縁取りされるので、透過するなら暗めの背景色がおすすめ。

10. 音声リップシンクの使用方法

※追記(2022/11/17)

一部、間違った情報を記載していたため、修正しました。

嘘書いてごめんなさい!

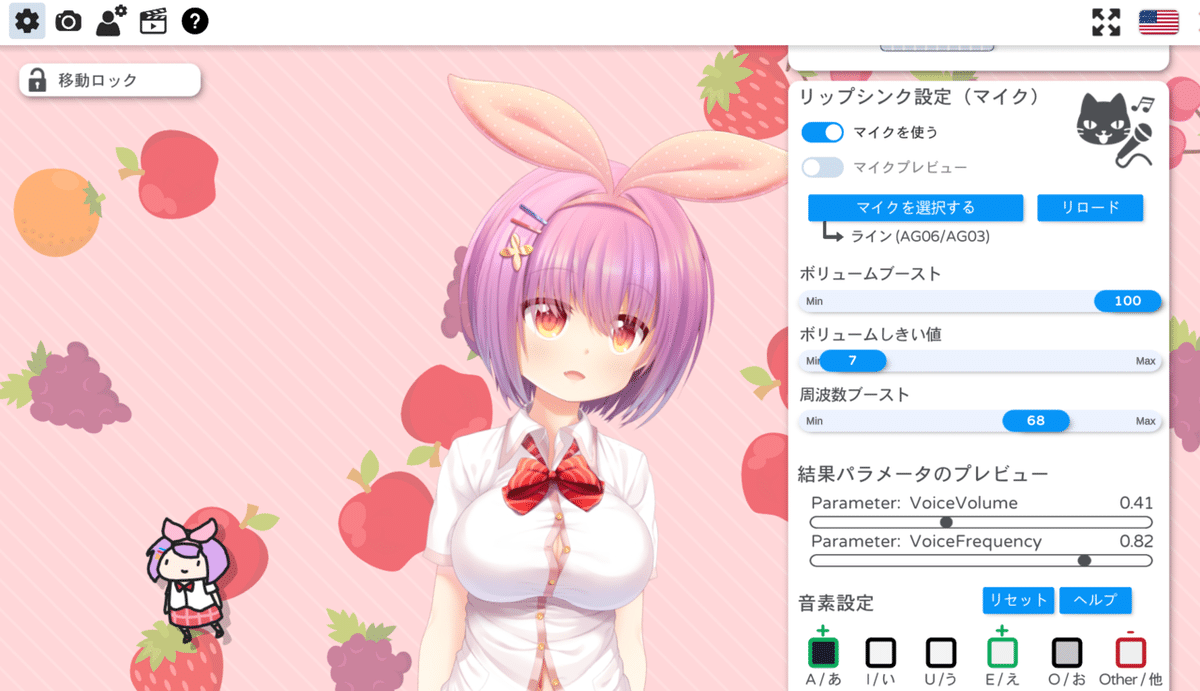

音声によるリップシンクという新機能が追加されました。

設定マークの下の方にスクロールするとあります。

VoiceVolumeは「音声の大きさ」、VoiceFrequencyは「音声周波数」を意味します。「ボリュームしきい値」はノイズカットのようなものです。「ボリュームブースト」「周波数ブースト」は、プレビューを見ながらお好みで設定してください。

音素設定の「緑の+マーク」や「赤の-マーク」は、口変形(ParamMouthForm)のプラスorマイナス に対応させるための機能です。

日本人の場合、「A/あ」「え/E」をプラス、「O/お」「U/う」をマイナス にするといい感じになります。可能ならば、モデルの口形状に合わせて調整してあげるともっといい感じになります。(※ 23/12/20修正)

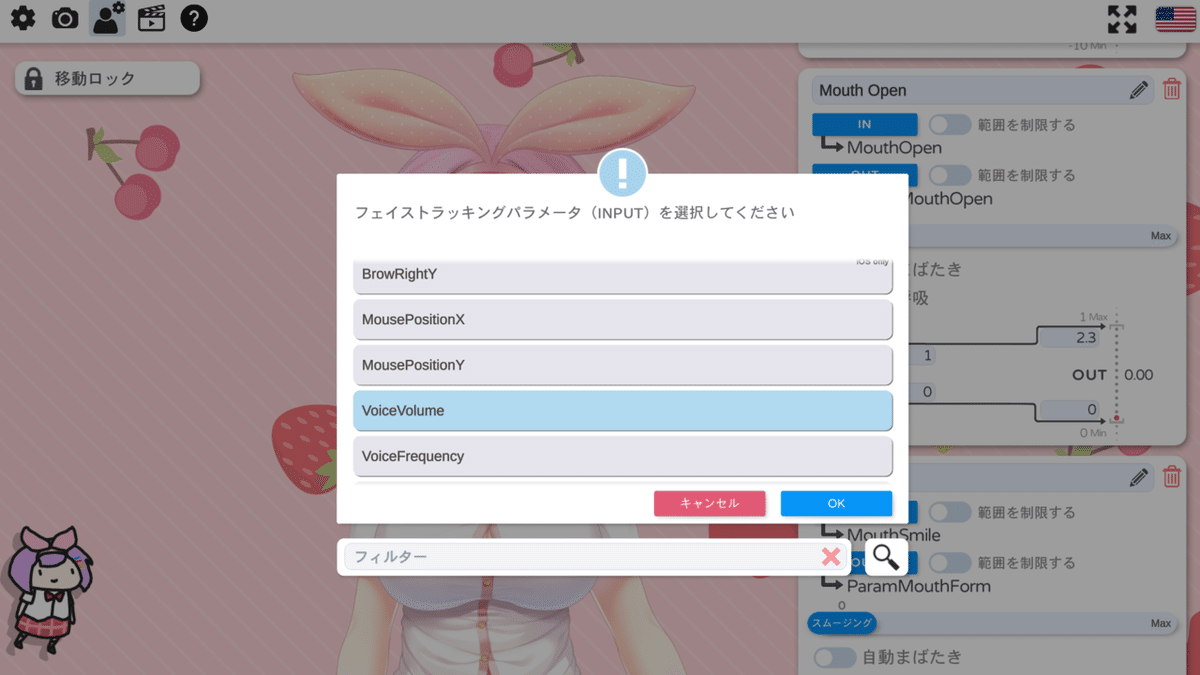

リップシンクは、マイクをONにしただけでは動きません。パラメータの設定をする必要があります。

まずはベーシックなやり方をご紹介します。

パラメータの設定を開いて、入力値を変えます。

これでOK。モデルの相性はありますが、基本はこれで音声ベースのリップシンクを行えます。

重要な点として、出力値の重複は使用できないため、リップシンクに使うパラメータをフェイストラッキングで使用することができません。 ←入力値を "VoiceVolumePlusMouthOpen" "VoiceFrequencyPlusMouthSmile" に設定することでトラッキング+音声入力が実装できます。

これを逆手に取れば、リップシンクとトラッキングを併用することで、口の形状を制御する追加のパラメータ(例:口の横幅)などをVoiceFrequency入力にすることや、口パーツを置換する追加のパラメータを特定の入力範囲でのみVoiceVolumeで入力して、叫んだときだけ表情が変わるなどの工夫ができます。このへんは応用次第でいろいろ使いみちがあるかと思われます。

さいごに.

本記事では紹介しきれませんでしたが、最近のアップデート(1.5.0)ではアイテムを選べるようになったりしております。LIVE2Dモデルに取り付けたりできるのでなおかわいい。自作のアイテムも追加できます。

日本で急に認知度が広まったきっかけとして、結構な人気を誇るクリエイターさんが使い始めたのがあります。良い傾向ですね。

このような個人開発ソフトがリリースされ使用されているのはとてもとても貴重なので、製作者様への応援や支援の気持ちを込めてPro版にするのもオススメです。本当にすごいことなので。拝みながらPro版にしましょう。ついでにSteam版DLCも購入しましょう。

Denchiさん、および VtubeStudio の開発・広報に携わってくださった皆様、本当にありがとうございます。

いちユーザーとしてこれからも応援しております。

※追記(2022/11/17)

新しい記事書いたらTwitterでお知らせするので、チェックしてくれたらうれしいです。

Twitchメインで活動するVtuberがじわじわ増えています。VtubeStudioとTwitchが連携するプラグインが充実しており、リスナーがアイテム投げたり表情差分を操作したり、アニメーション再生したりできます。プラグインの解説記事も書きたいですね。

自分もVtuberモデル作っていろいろプラグイン使って配信してるので、どんなものか遊びに来てみてください。

つくった!

— Frusumi フルスミ🧡🦊@Twitch (@FruEnji) August 21, 2022

視聴者が好きなタイミングでフユセをツンツンできます! #VtubeStudio #おやすみVtuber #FruArts pic.twitter.com/PL4nH53EbU

この記事が気に入ったらサポートをしてみませんか?