#2【Dify挑戦編】Difyとdeepseek連携!セキュアなAIチャットボット開発挑戦

昨今、サイバー攻撃や情報漏洩のリスクが高まる中、企業や組織にとってセキュアなAIチャットボットの導入は喫緊の課題となっています。

クラウド環境に依存せず、ローカル環境での運用を実現することで、機密情報の取り扱いにおける安心感が格段に向上します。

本記事では、ollmaを活用し、Deepseekをローカルにデプロイする手法を通じて、情報漏洩に強い安全なAIチャットボットの構築方法を解説します!

記事書いた人:https://x.com/1205malumalu

DeepSeekとは?

DeepSeekは、中国の人工知能研究所が開発する大規模言語モデル(LLM)です。

オープンソースで、低価格と高性能を両立することを目指しています。

DeepSeekの特徴

以下は、DeepSeekの開発者目線での特徴になります。

▪️ 1. 安価に利用できる

コストパフォーマンスが高い: DeepSeekはライセンス料や利用料金が低く、あるいは不要な場合が多いため、初期投資や運用コストを大幅に削減できます。

導入しやすさ: 少ないコストで導入できるため、スタートアップや中小企業、個人プロジェクトでも気軽に利用可能です。

▪️ 2. オープンソースである

透明性: ソースコードが公開されているため、内部処理やアルゴリズムの動作を確認でき、信頼性が高まります。

カスタマイズ可能: 開発者は自由にコードを改良・拡張できるので、自社のニーズに合わせたカスタマイズが可能です。

▪️ 3. 商用利用可能

ライセンスの自由度: 商用利用が許可されているため、企業が自社サービスや製品に組み込む際の法的制約が少なく、ビジネス展開がスムーズです。

高性能なOpenAIに比べて、コストパフォーマンスが良いのがDeepSeekになります。

Ollamaとは?

Ollamaは、DeepSeek、Llam a、Mistralなどの大規模言語モデルをシームレスにデプロイできるクロスプラットフォームのLLM管理クライアント(MacOS、Windows、Linux)です。

以下は、Ollamaの開発者目線での特徴になります。

▪️ 1. オープンソースウェアである

透明性と信頼性 : OllamaはDeepSeek同様にオープンソースで提供されているため、誰でもソースコードを確認できます。これにより、コードの品質やセキュリティについて透明性が確保され、信頼性が向上します。

カスタマイズと拡張性: 開発者はソースコードを自由に修正・改善できるため、特定のニーズに合わせたカスタマイズが可能です。また、コミュニティ全体で新機能の追加やバグ修正などの共同開発が促進されます。

▪️ 2. ローカルLLM開発が可能

データプライバシー: ローカル環境で開発・テストを行うため、外部のクラウドサービスにデータを送信する必要がなく、機密性の高い情報を扱う場合でも安心です。

Ollamaはオープンソースとしての自由度と、ローカル環境での効率的なLLM開発の両面から、開発者にとって非常に魅力的なプラットフォームになります。

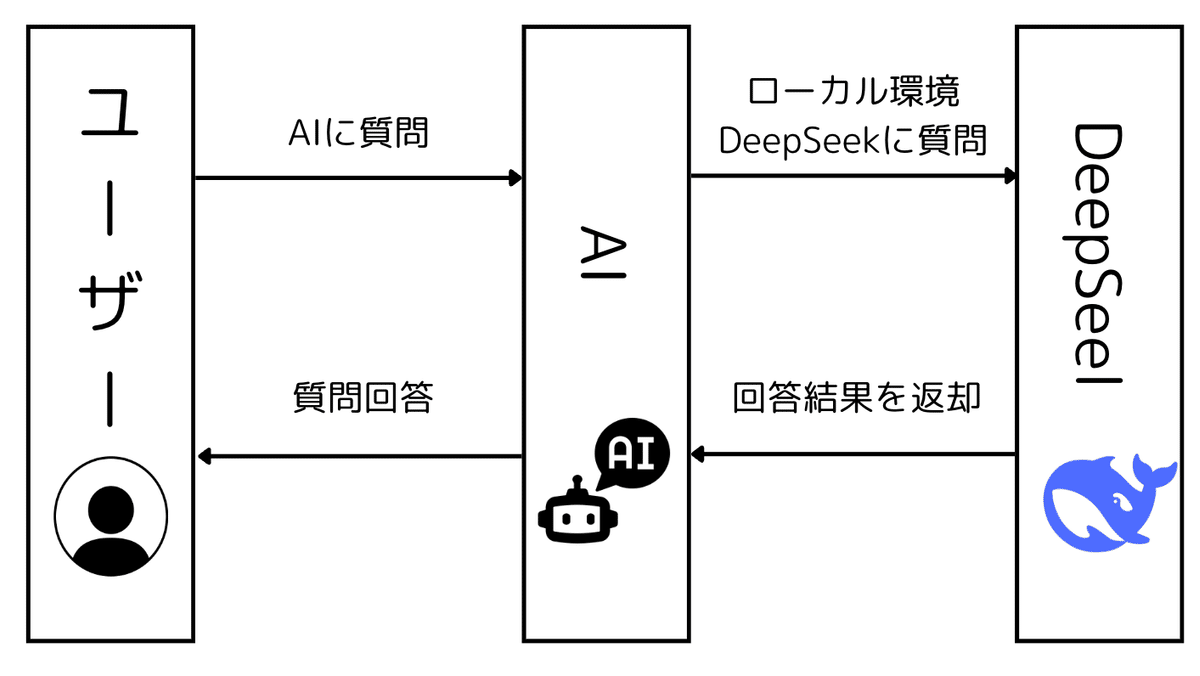

アプリケーション説明

ユーザーがAIに質問する

ユーザーは、Difyチャットボットを通じて、AIに対して質問を行います。AIがローカル環境のDeepSeekに問い合わせる

AIは、ユーザーから受け取った質問をローカル環境で稼働しているDeepSeekに送ります。

ここでのポイントは、Ollamaのようなローカル実行ツールを利用しているため、クラウドにデータを送らずに手元の環境だけでモデルを動かせることです。

機密性の高いデータや大規模なやり取りでも、外部に情報が流出しにくいというメリットがあります。DeepSeekが質問を処理し、回答結果を返す

DeepSeekは、大規模言語モデルとしてユーザーの質問に対する回答を生成します。DeepSeekが生成した回答結果はAIへと返却されます。AIがユーザーへ回答を返す

AIは、DeepSeekから受け取った回答結果をユーザーに返信します。

ユーザーは最終的に、AIから得られた回答を見ることになります。

プライベートデプロイのメリット

▪️ 1. コスト削減

プライベートデプロイであれば、DeepSeekやOllamaをローカル環境に導入開発するのでクラウドAPIのコストを回避しながらLLMを使用できます。自社サーバーやローカルマシンで直接LLMを実行するため、コストパフォーマンスを最大化できます。

▪️2.機密情報の漏洩リスクを軽減

ローカル開発を前提としているため、データを外部のサーバーに送る必要がありません。その結果、機密性の高いデータを扱う際の漏洩リスクを大幅に低減でき、プライバシーやセキュリティの観点でも安心です。

プライベートデプロイのデメリット

▪️ スペックが高いPCが必要

大規模言語モデルをローカル環境で動かす場合、GPUをはじめとする高性能なハードウェアが求められます。

ですので、スペックの高いPCで開発する必要があります。

ここから先は

この記事が気に入ったらチップで応援してみませんか?