【読んでみた】AISI:AIセーフティに関するレッドチーミング手法ガイド(1.0.0版)

前回に引き続き、AISIのガイド文書をしっかり読んでみたので、ご紹介していきます。

本資料の目的

AIシステムの利用が拡大している中で、当然ながらその悪用や不正確な出力による影響なども大きくなることから、AIセーフティに関する重要性に注目が集まっています。その中で、AIセーフティを担保するための評価手法の一つとして、AIレッドチーミングがあり、本資料はその観点をガイドしている文書になります。

AIレッドチーミングとは

そもそもレッドチーミングとは何か。本資料では次のように定義されています。

レッドチーミング

攻撃者がどのように AI システムを攻撃するかの観点で、AI セーフティへの対応体制及び対策の有効性を確認する評価手法。

レッドチーミングは、サイバーセキュリティ界隈では一般的な用語となり、サイバー攻撃者視点でのテストとして認知されています。AIレッドチーミングは、このAI版と考えてよいと思いますが、AIシステムへの攻撃をシミュレートして、AIセーフティ対策が有効に機能しているのかを評価します。

本資料の想定読者

ガイドでは、レッドチーミングの企画・実施に関わる開発・提供管理者や責任者を読者として想定していると記載されています。

また、AI利用者がAI調達のために利用することも想定されているようです。

本資料の対象のAIシステム

これは、生成AIのうちLLMを対象として想定しているようです。

レッドチーミングの実施理由と効果

本書におけるレッドチーミング手法を参照することで、実運用環境に対する悪意をもったエンドユーザーなどの攻撃者からの攻撃耐性を評価することができる。攻撃者による攻撃は、巧妙な手口によって実施されることも多く、被害が甚大となる可能性が高い。これらを踏まえたレッドチーミングを継続的に実施することで、見落としがちな対策不備等に対処することも可能となる。

と記載されており、対策の十分性を確認するうえで、重要な手法になるととともに、攻撃手法や技術トレンドの変化に応じて適宜評価していくことで、継続的なAIシステムの安全性を確保することができると解釈できます。

レッドチーミングの前提となるシステム構成

レッドチーミングのテスト手法を検討するうえで、どのようなシステム構成パターンであるのかが、大きな検討要素になります。

ガイド文書では、そのパターンとして、次のものが挙げられています。

⚫ 自組織で独自開発した LLM を使用するケース

⚫ 他組織が提供する事前学習済の LLM にファインチューニングを施して使用するケース

⚫ オープンソースのソフトウェア(以下、「OSS」という。)等として公開されている LLM を AI システムに組み込んで使用するケース

⚫ OSS 等として公開されている LLM をファインチューニングした上で AI システムに組み込んで使用するケース

⚫ 外部 API を経由して LLM を利用し、AI システムには組み込まないケース

レッドチーミングの種類

ここは、ITのテストと似た分類がされており、ブラックボックス・ホワイトボックス・グレーボックスが定義されています。また、実施環境の分類も記載されていますが、サイバー系のテストの考え方と同じと理解して良いと思います。

AIのレッドチーミングの特徴

ガイド文書ではいくつか照会されていますが、重要なのは次の2点。

網羅的なレッドチーミングは困難なので、ドメインエキスパートが必須

自然言語をINPUTとするAIシステムですので、ITテストのようなINPUTデータの網羅性は確保できません。そのため、網羅性ではなくAIシステムの特性(用途やAIシステムの特徴)を踏まえたINPUTを用意してテストします。ガイド文書では、ドメインエキスパート(つまり、用途の業務に精通した人)が関与する必要があるとされています。

AIシステムは再現性が欠如する

AIシステムは、同じ入力に対して毎回同じ結果を返すわけではありません。そのため、一度のテスト実行ではその特性を把握できない可能性がある点が特徴として挙げられます。

対応としては、実行回数を定義してテストを実施することや、その際の環境条件や結果、各種ログを取得して総合的に判断していくことが挙げられます。

なお、この総合的な判断は、必ずしも人である必要はなく、実務ではAIレッドチーミングのツールにて定義し、自動的にスコアリングして合否判断をすることが可能になってきます。

LLMシステムへの攻撃手法

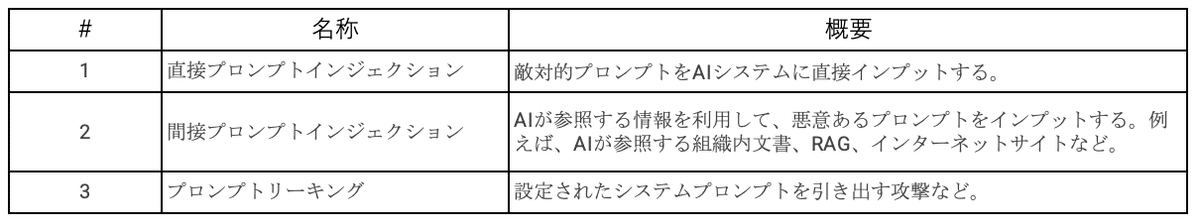

ガイド文書では、代表的な攻撃手法を紹介しています。これらは基本的な知識として重要になりますので、一度ガイド文書を読むことをお勧めいたします。

なお、ガイド文書では、保護すべき資産として、LLMシステムやそれを構成する要素に分解して、攻撃手法を整理していますので、ざっと概観を把握するのにわかりやすい内容となっています。

比較的テストにおいて、難しいのは、間接プロンプトインジェクションで、このあたりは今後いろいろとノウハウが登場してくるのだろうと推察しています。

AIシステムへの攻撃手法

ガイド文書では、上述のLLMのほか、AIシステム全般に対する攻撃手法も紹介しています。なお、こちらは生成AI登場以前から知られた手法であり、MLモデルやLLM以外の生成AIでも参考になる整理となります。

レッドチーミングの実施体制

組織内やサードパーティによるレッドチームがテストを担います。レッドチームは、次のように説明がされています。

レッドチームは、レッドチーミングの実施対象となる AI システムの開発・提供に携わるプロジェクトチームと連携する形で設置し、リーダまたは責任者を任命し編成する。これにより、組織全体の管理体制や開発・調達等の規程の他、事業上のリスクを適切に理解した上でレッドチーミング実施を検討・推進できるようにする。

レッドチームには、対象のAIシステムやその業務に関連する有識者やリスクを分析し攻撃シナリオを計画し実施する担当などにより構成されます。また、テスト実施に向けて環境準備や検知した問題への対応に向け対象のAIシステムの開発・提供者もレッドチームと連携をとりレッドチーミングを実行していきます。

レッドチーミングの実施タイミング

レッドチーミングを実施するタイミングについて、ガイド文書では、「リリース運用開始前」と「運用開始後」の2つで解説されています。とりわけ、運用開始後は定期的あるいは必要に応じて随時実施することが望ましいとされ、セキュリティのテストと同様に対象を分割して複数回で一巡するような実施方法も紹介されています。

レッドチーミングの実施工程

一般的なレッドチーミングの実施工程は次のように紹介されています。

⚫ 実施計画の策定と実施準備 (第 1 工程)

➢ (STEP 1)実施を決定後、レッドチームを発足する

➢ (STEP 2)予算及びリソースの識別・確保を行い、必要に応じてサードパーティの選定・契約を行う

➢ (STEP 3)対象となる AI システムの概要や利用形態などを把握し、実施範囲の決定、スケジュール作成、実施計画の策定を行う

➢ (STEP 4)実施環境を準備する

➢ (STEP 5)エスカレーションフローの確認などを行う

詳細は第 6 章を参照すること。

⚫ 攻撃計画・実施 (第 2 工程)

➢ (STEP 6)リスク分析及び想定されるリスクシナリオを作成する

➢ (STEP 7)リスクシナリオに基づき、攻撃シナリオを作成する

➢ (STEP 8)攻撃シナリオを実施する

➢ (STEP 9)攻撃シナリオの実施中に記録を取得する

➢ (STEP 10)攻撃シナリオの実施後の処理を行う

詳細は第 7 章を参照すること。

⚫ 結果のとりまとめと改善計画の策定 (第3工程)

➢ (STEP 11)レッドチーミングの実施結果を分析する

➢ (STEP 12)結果報告書を作成し関係者レビューを行う

➢ (STEP 13)最終報告書としてとりまとめて報告を行う

➢ (STEP 14)改善策について検討し、改善計画としてとりまとめた後、改善を行う

➢ (STEP 15)改善後のフォローアップとして改善状況の進捗を確認し、必要に応じて再度レッドチーミングを実施する

詳細は第 8 章を参照すること。

ガイド文書では、この各STEPについての詳細が解説されており、非常に有用な内容となっています。必要な検討事項が端的にまとめられており、素晴らしい内容だと思いました。

そもそもレッドチーミングを実施する対象のAIは?

実務としては、企業における様々なAIシステムが存在する中、レッドチーミングが必要なAIシステムをどのように識別するのか、その重要度をどう測るのかが肝となります。この管理スキームについては、このガイド文書では触れられていません。そのため、AIシステム管理フレームワーク、レッドチーミングに関する対象や実施のルール作りは、専門家を活用して整備することがまずは必要になります。

最近、この整備に関するお問い合わせが多く、AIガバナンス・マネジメント整備が急拡大している印象です。自社におけるAI活用の進捗を鑑みながら、これらの検討も並行して進めることが有益ではないかと思っている次第です。

今回はここまで。