5, 6月【ChatGPT】関連ニュース9選

はじめまして、駄作AIと申します。

しがないデータサイエンティストをしており、5, 6月に起こった注目すべきニュースを振り返り、選りすぐり主観の9選を自分自身の忘備録としてまとめました。それぞれのニュースについて、興味深いポイントや自分の感想を綴りますので、どなたかの助けになれば幸いです。

※自分用にまとめているとはいえ、もし間違いなどありましたら申し訳ございません。事実と違うことなどがありましたら修正いたしますので、お伝えいただけると幸いです。

1.ChatGPT pluginスタート(5/17~)

【超訳】「フリック入力」から「対話」へ

まずはpluginのニュースから。

これは正確には6月のニュースではないのですが、最近ホットなので。

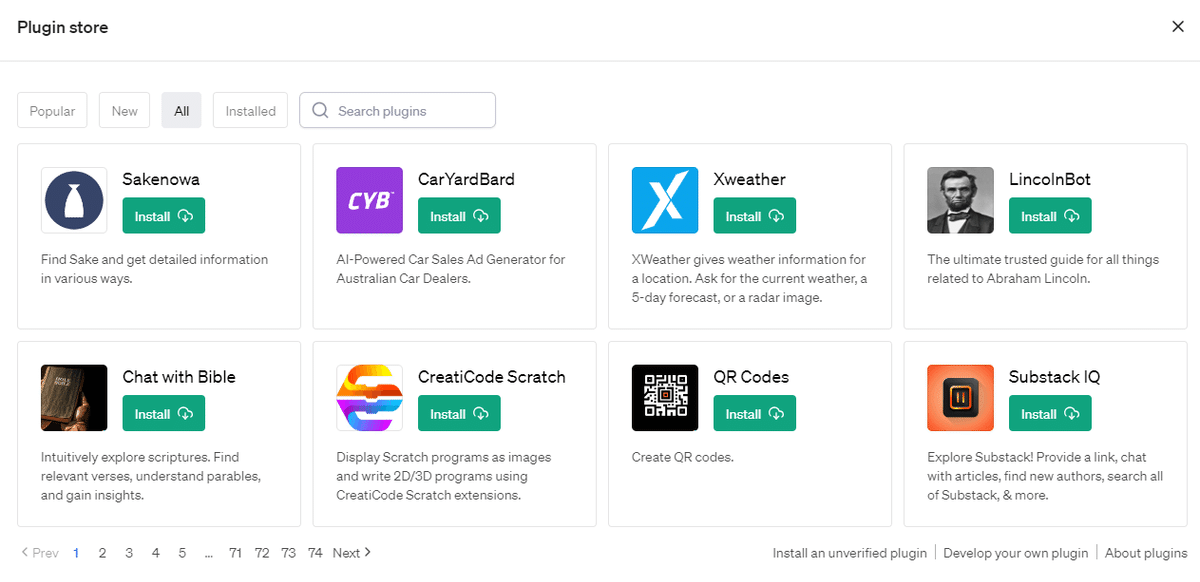

pluginとはChatGPTと他のサービスをつなげるサービスで、現在(6/30)までに586個のサービスがつながることとなっています。

で、何がいいの?

という話ですとまずはUX/UIという概念が変わりそうです。

これはChatGPTが出た当初から落合陽一さんなどが話していた内容ですが

例えば食べログも一つのサービスですが、「子供と一緒に行ける場所でかつ吉祥寺でランチ」というワードで調べると下記のような結果が帰ってくるという、つまり「ブラウザでフリック入力、スワイプする」という操作性は関係なく、必要な情報は「対話」で情報を得る時代になってきそうです。

使い方については、下記のURLから。

(Googleのトップ結果の人のブログなので、特に理由はない紹介になります。)

2.Noteable(ChatGPTplugin) 5/24~

【超訳】全人類データサイエンスの時代到来!

さらにChatGPTのpluginのひとつをご紹介。

もう95%ぐらいのデータサイエンスはChatGPTにやらせればいいという感覚は下記の記事を見てから思っていました。

ですが、もう100%そうなると確信したのが

Noteable

というサービスの出現です!

エクセルより高度なことがエクセルよりも簡単にできる

と思える記事が下記になります。

最近はデータ分析、統計分析を教えるならこのサービスで公共データを使って教えていますので、今から始めるならあなたもすぐにデータサイエンティストです。

ぜひお試しあれ!

※ほかにも分析計ではこんなプラグインも。

3.ChatGPT APIの新バージョン登場!(6/14)

【超訳】早い!(3倍) 安い!(1/4) 長い!(4倍)

突如としてChatGPTを運営するOpenAIから下記のようなメールが。。

結論から言うと下記のようなことがアナウンスされました。

関数呼び出しができる(pluginみたいなもの)

長い文章も読み込めるようになった(4,000tokens→16,000tokens)

文章の数値化が75%安くなった

ついでにGPT3.5も25%安くなった

早くなった(私感3倍ぐらい)

公式のアナウンス文はこちら

結構OpenAIは唐突に安くすることがあるらしいので、今後も値下がりに期待したいです。

ちなみに「これが起きてどうなるの?」というと

サービス提供がしやすくなるので、開発している我々からすると嬉しいですね。今までですと結構高くてサービス展開するにもなかなかマネタイズが難しかったので。。。

今後もどんどんChatGPTのサービスが拡大しそうですね!

4.Azure OpenAI Service On Your Data(6/20)

【超訳】自社内のChatGPTがノーコードで可能に!

ChatGPTは基本的に2021年9月までの情報を元に学習させているものになりますので、現在2023年6月までの約2年間の情報が入っていないものになります。

また公共のデータを使用している関係上、自社内のChatBotを作りたくても学習できる方法もなかったという状況で

あと一歩届かないなと思っている次第でしたが

Azure(Microsoft)のサービスの中に自分のデータを読み込んで質疑応答してくれるサービスが立ち上がりました!

対象となる文章はPDF, HTML, Powerpoint, Wordのようで、それらをアップロードして待つだけで、あなた独自のChatGPTが完成します。

またWEB公開までもノーコードのようで、すごい時代来たなと思ってます。

使い方については下記がわかりやすかったです。

中身の仕組みとしては

1.自分の文章を数値化しておいておく

2.質問する

3.質問文を数値化して自分の文章群の中で数値が近いもの1位~3位ぐらいをChatGPTに読み込ませる

4.ChatGPTがその情報を元に回答する

という流れになります。

Langchainというプログラミング言語pythonのライブラリーを使って私も作ってはいたのですがもうノーコードが出るとは。。。

時代の流れが早くてびっくりしています。

5.PaLM2 (5/11~)

【超訳】Google版ChatGPT、LLM戦国時代

ChatGPTの登場により、立場が危ぶまれているGoogle

BardというAI検索サービスをリリースするも、誤りが発覚し

株価が8%も下落したニュースは記憶に新しいです。

そんなGoogleが新しくPaLM2を公開

会社を上げて戦いが始まっている感じがしますね。

まさに戦国時代が来ていると感じます。

下記の記事によるとパラメータ数はGPT3.5≒PaLM2 < GPT4ですが

GPT3.5以上の性能、問い場合によってはGPT4に匹敵するようなもののようです。

試し方はGCPのVertexAIというサービスに登録することで試せるようになるのですが所感としては

GPT3.5<PaLM2<GPT4

で精度を求めるならGPT4なのは間違いなさそうです。

ただし現在は無料で公開しているので、料金面で言ったらPaLM2のほうがいい部分もあるかもしれないです。

利用を検討する場合は下記からwaitinglistに入りまして

その後に利用が可能になるかと思います。

今後の精度改善やversionUPに来たいですね!

6.Gemini(6/27)

【超訳】Google傘下のDeepMind とうとう牙を剥くか!?

5番に続いてGoogle関連のニュースになります。

Googleは傘下にDeepMindという素晴らしい企業を抱えておりまして、例えばAlphaGoという囲碁のAIを開発したということで有名ですし、生物業界ではAlphaFold2というこれまたタンパク質の立体構造を推測するというすごい生成系AIを開発しています。

そのDeepMindが昨今のLLM開発に参入してくるということでこれは非常に注目のニュースかなと思っています!

OpenAIはGPT5以降は現在のところ開発をしていないとのことは

下記のニュースからも伺えるのですが

https://ledge.ai/articles/gpt5-not-yet/

ユーザー的にはもっと良いモデル、かつ安いもの、独自に学習できるものというのを求めていますので、DeepMind参戦はとても期待値が高いです。

今後数ヶ月でなにかまた新しい動きがありそうなので注視していきたいです!!

7.日本語版LLMリリース続々(5/17~)

【超訳】日本にも大規模言語モデルの流れ到来!!

汎用的な使い方ではChatGPTで良いですが

自社内のデータを使って、かつ日本語でとなると

日本語専用のLLM(大規模言語モデル)がほしいところでした

そんな需要をいち早く捉えてリリースしたのが

上記二社!

GPT3.5はパラメータ数が3500億なので、その1/50ぐらいの規模ですが日本にも同じような流れが来ているのはとても嬉しいです。

AIの専門家である松尾先生も今後日本でのLLMの開発を国家予算をかけて進んでいくべきとの話をインタビューでしていましたので

この一年間は本当に目が話せないです!

8.Phi-1 (6/20)

【超訳】Microsoftが激軽1/100なLLMをリリース!

OpenAIのChatGPTのリリースからはや3ヶ月。

現在のトレンドとして注目が集まっているのはパラメータ数を少なくして、かつ精度が同じがそれ以上のモデルを以下にして作り出すか

というところに注目が集まっています。

なんでパラメータ数少なくするの?

というとですね。

パラメータ数が多い=お金がすごいかかる

ということなんです。

ということでどこもかしこもパラメータ数が少なくて精度が高いものを開発しているのですが、おそらく一番乗りでその論文をリリースしたのがMicrosoft!

1/100で精度はGPT3.5よりも高いということで

これは社内独自のChatGPTを作るのも夢ではなくなってきました。

論文によるとGPUというAI学習用のコンピュータリソースでA100を8つ使用して、4日間学習させた、という話なので

例えばAWSで換算すると。。。

AWS p4d.24xlarge

44.92215 USD 1 時間あたり

45 USD × 4 日 × 24 時間 × 145 円 ≒ 62万円

人によるかもしれませんが結構安いと私は感じました。

データセットさえ用意できれば、これは社内独自、もしくは自分と同じようなオリジナルChatGPTを作るのも用意になるかもしれませんね!

9.LLM同士での学習は精度低下(5/27)

【超訳】まだまだシンギュラリティには遠い、、、かも・・・

AIに別のAIが生成したデータセットを学ばせるとどうなるか、という論文がリリースされたのでご紹介。

結論、精度低下が確認されたようです。

これ自体はまあそんなにどうってことな記事かもしれませんが、もしこれで精度が上がると言う結果だった場合、人間がいらなくなるような未来が更に加速するのではないかなと思って、今回ご紹介しました。

まだまだ人間は必要ということでホット一息。

終わりに

最後まで読んでいただきありがとうございます!

今後も定期的にニュースを(自分用に)まとめて行きたいと思います。

※やっていて思ったのですが、ChatGPTにまとめて記事にさせればよかったと後悔しています。。。

※自分用にまとめているとはいえ、もし間違いなどありましたら申し訳ございません。事実と違うことなどがありましたら修正いたしますので、お伝えいただけると幸いです。