数十秒の処理が、ほんの2秒に──Cerebrasの超高速AIを使ってみた

生成系AIが私たちの日常に浸透する中、最近はモデルの精度だけでなく「どれだけ速く処理できるか」というスピードが、重要視されています。

そんな中、AI専用チップを手がける半導体企業が注目を集めています。その中でも、アメリカを拠点とする Cerebras(セレブラス) は、特に注目されているように感じます。彼らが開発した超高速チップは、圧倒的な処理スピードを実現していると言われています。

そこで今回は、このCerebrasの速さや情報を整理してみました。

AI時代の半導体競争

まず、今の生成系AIブームを支えているのは、何といってもNVIDIAの存在だろうと思います。

H100やH200といったGPUチップは、巨大言語モデルの学習や推論を高い精度で可能にし、世界中のデータセンターやクラウド事業者の標準的な選択肢になっています。

株価の推移を見ても、NVIDIAはこの2~3年で急成長し、「生成AI銘柄」として圧倒的な評価を得ています。

しかし、一方で「NVIDIA一強」という状況を突き崩そうとする企業が続々と現れてきています。そのうちの一つがCerebrasです。

Cerebrasが提供する高速チップとは

Cerebrasが開発しているのはWSE-3と呼ばれるAI専用チップです。

公式サイトを見るとスピードを大々的にアピールしている事が分かります。

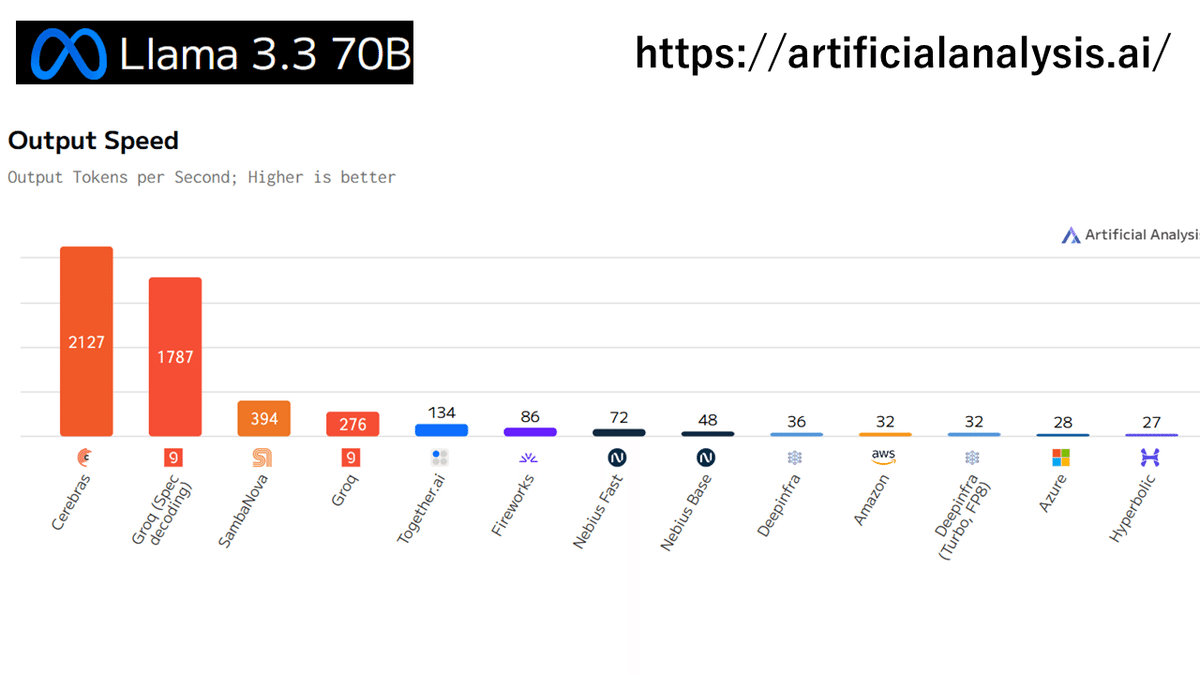

実際、Llama3.3 70Bのベンチマークでは、従来のAWSやAzureの環境と比べて圧倒的に処理速度が速い事が分かります。

生成系AIを本格的に業務で活用しようとしている企業にとって、処理時間を大幅に短縮できる点は、大きな魅力と映るのではないでしょうか。

処理速度を比較

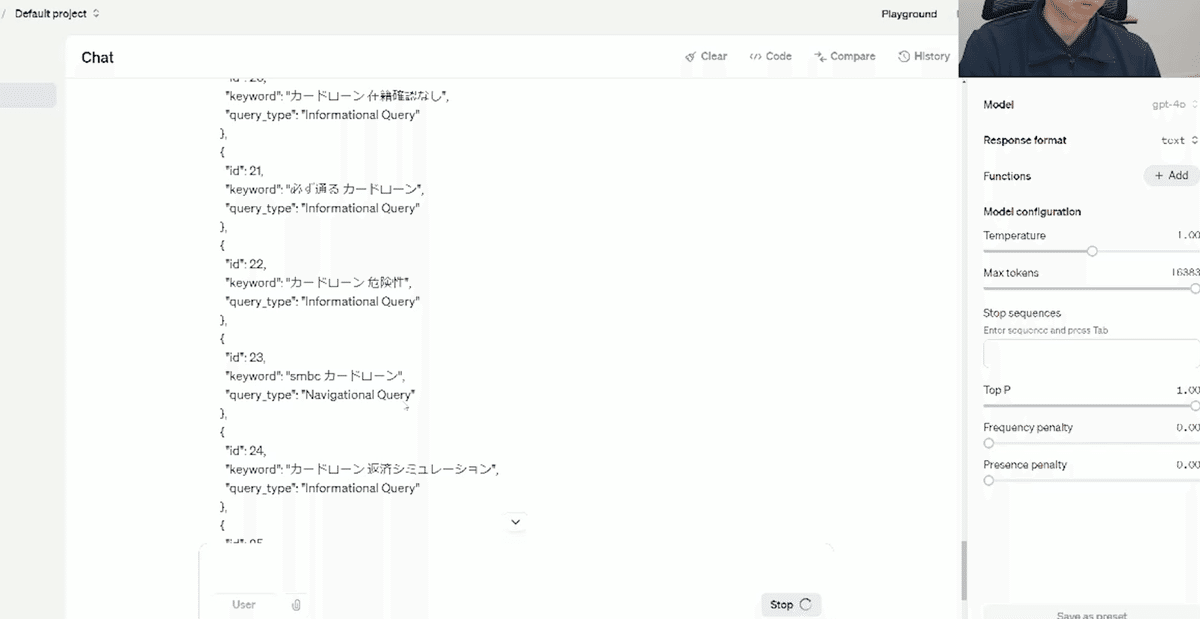

CerebrasとGPT-4で同じプロンプトを実行すると、その処理速度に大きな差があることがわかります。

今回、約60個のキーワードを仕分けするプロンプトを実行しました。

(※本来は異なるIaaS上で、同じモデル(Llama3.3 70B)で比較すべきですが、今回はGPT-4oとLlama@Cerebrasで比較しました)

CerebrasにてLlama3.3で実行した所、ほんの1~2秒で結果が返却されました。

もし100万件のキーワードを分類する場合、GPT-4でバッチ処理すれば半日以上かかることもあり得ますが、Cerebrasなら業務の合間の数分で終えられるかもしれません。

実際にこうした高速処理を体験すると、「待てばいい」という感覚がなくなり、逆に速度が遅いAIにストレスを感じる程です。

NVIDIAとCerebrasの今後

もちろんNVIDIAも黙っているわけではないと思います。

NVIDIAは次世代チップ「Blackwell」を開発中とされており、こちらも大幅に速度向上が期待できそうです。

一方でCerebrasは昨年の10月にIPO申請。もし正式に上場すれば、NVIDIAへの対抗馬としてさらに注目が集まると予想しています。

特に「速度」をウリにしたブランドイメージが確立されれば、学習や推論を最優先する現場で支持を得る可能性があるかもしれません。

最後に

生成系AIはChatGPTの登場により一気に普及し、モデルの精度や機能が大きな話題となりました。しかし、最近では「スピード」と「コスト」が次の課題として浮上しているように感じられます。

実際、AIがさまざまな業務に浸透するにつれ、処理時間がボトルネックとなるケースが少なくありません。特に数万件、数十万件といった大量データを扱う企業にとって、結果を迅速に得られるかどうかがビジネスの成否を左右する可能性があります。

このように考えると、Cerebrasのような専用チップを活用し「速さ」を実現する取り組みは非常に興味深いものです。また、NVIDIAもブラックウェルなどの新製品を投入する見込みがあり、選択肢はますます広がるでしょう。

「より速く、より安く、より手軽に使えるAI」が当たり前になる時代は、そう遠くないと考えます。

現在、AIを業務に使用している立場からすれば、すでに高い精度には慣れつつあり、「いかにストレスなく処理を終えられるか」が重要なポイントとなっています。1秒でも早く結果を手にしたい、バッチ処理で時間を浪費したくないというニーズは、今後さらに高まるのではないでしょうか。

新しいチップが登場するたびに学習モデルの可能性が広がり、活用方法も次々と変化していくことを期待しています。

今後、Cerebrasのような新興企業だけでなく、既存の大手ベンダーからも斬新なアプローチが生まれるかもしれません。スピード「も」重視する時代に向けて、AI関連の半導体市場はさらに盛り上がるかもしれません。