【日本語ローカルLLM】Llama 3.1 Swallowを試した話【期待のモデル】

はじめに

huggingfaceにLlama3.1ベースの新しい日本語モデルが公開されたので試してみました。

東京科学大学&産総研のモデルです。公式ページはこちら、

huggingfaceにアップされたLlama-3.1-Swallow-8B-Instruct-v0.1をQ4_K_M・ggufファイルに(自分で)変換したモデルで試しました。まだggufモデルはアップされていないようです。

Llama3.1はトークンサイズが最大128kですが、Swallowモデルは8kと表示されます。※ num_ctx=24kで日本語20kトークンを破綻なく処理できましたが。

日本語対応ローカルLLMで比較

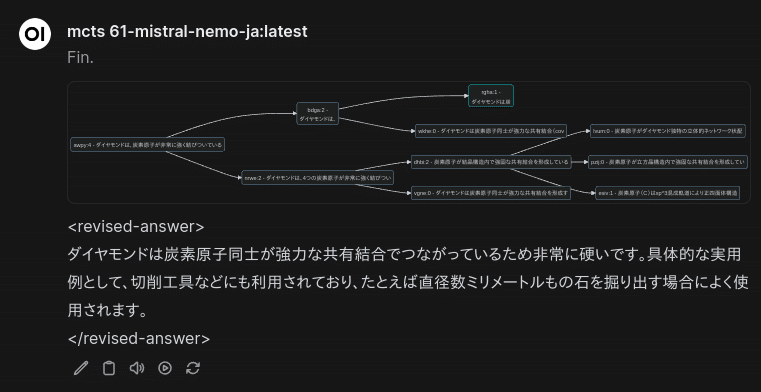

ダイヤモンドが硬い理由を説明して

自分で何度も自問自答する下記のやり方(モンテカルロ木探索思考)でテストしました。弱いモデルは途中で暴走するので、完走するだけでもローカルLLMでは高性能と言えます。

Llama-3.1-Swallow-8B-Instruct-v0.1-Q4_K_M

今回メインのモデルです。

自問自答のプロセスにおいて、特に破綻はありませんでした。非常に安定しています。

Llama3-Elyza-8B-Instruct-Q4_K_M

Llama3ベースのモデルです。同様に、破綻はありませんでした。

cyberagent/Mistral-Nemo-Japanese-Instruct-12B (imatrix)-IQ1_M

Mistral&NVIDIA開発のモデルの日本語チューニング版です。

途中で何度か(同じ文章を繰り返して)暴走していました。

qwen2.5-instruct-7B (imatrix)-IQ1_M

中国Alibaba開発のモデルです。途中で簡体字(中国漢字)と英語を混ぜていました。ただし、意味・文脈として安定しています。

まとめ

どれもローカルで利用可能な日本語LLMで(現状では)最高級の性能なので、それらと同等かそれ以上の性能を出しているのは明らかです。

以下、関連する記事の【PR】です