【ローカルLLM】DeepSeek-R1-14B(ただし蒸留Qwen2)を使ってみた話③【中国LLM】

はじめに

クラウド上で試せる本物のDeepSeek-r1(671B)を利用すると、確かに多くの難関大学の数学問題を解答できるのですが、家庭用PCで実行できる蒸留版のなんちゃってDeepseek-r1(14B)でもできるかどうか試してみました。

下記事の続きです。

東京大学令和5年度第2次学力試験

文系の数学ですが、こちらの問題の一問目を利用します。

Deepseek-r1を公式のクラウド上で利用する場合はVLモデルも含むため、画像をコピペするだけで問題ないのですが、ローカルで利用する場合は、紙の問題をVLMで読み取る必要があります。

家庭用PC性能で利用できる日本語対応のVLMは、現状Qwen2-vlしかありません。しかし残念ながらollamaではまだ利用できません。※ LM_Studioでは対応をうたっていますが、まだ限定対応であり、肝心の日本語文字や数式の読み取りはできないようです

現状でGUIを利用してqwen2-vlを利用する場合は、下記手順(OpenAI互換 APIを利用する)が必要です。

まずはクラウド上の本物DeepSeek-r1で解いてみる

ローカル蒸留モデルで頑張る(RTX 3060)

再挑戦します。

まとめ

数学モデルであるqwen2.5-mathを含めて、他のローカルLLMでは解答にたどり着けなかったので、Deepseek-r1の蒸留モデルであっても、論理推論力はそれなりのものがあるようです。

しかし日本語thinkになると実力を発揮できないのは残念です。

付録

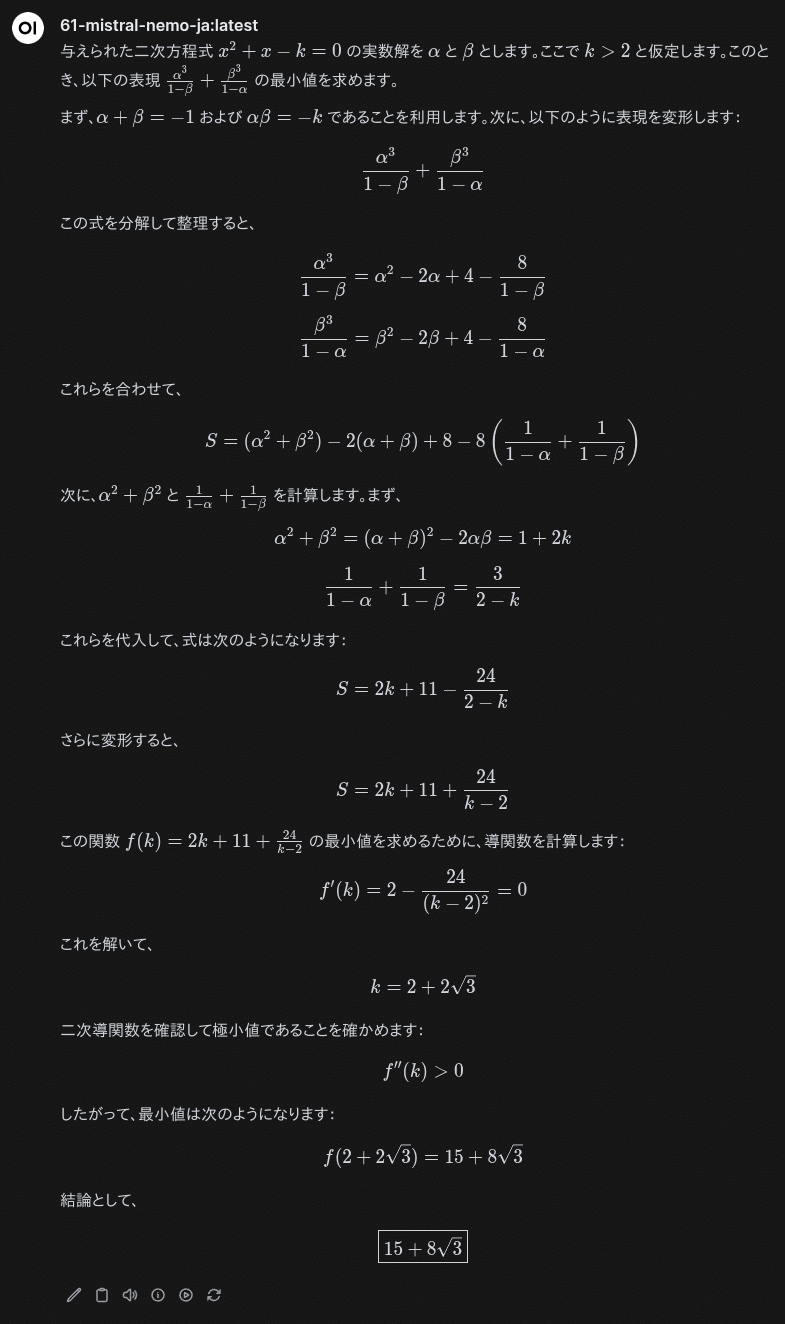

思考部が中国語なので、日本語LLM+プロンプトで日本語に変換します。Phi-4(14B)、Mistral-nemo-Japanese(12B)などで書き直すと綺麗になります。

## 指示

- 次の制約を厳守し推敲して、上述の文章をより良い日本語の文章に整形して書き直してください。

## 制約

- ハングルや簡体字や中国語が利用されていれば、例外なく日本語に変換してください。

- 結果のみを正しい文法の日本語で出力してください。

- 誤植があれば修正してください。

- 説明不足があれば、説明を追加してください。

以下、関連する記事の【PR】です。