ローカルLLMの活用【画像生成編】

はじめに

普及帯ゲーミングPC(VRAM 8〜16GB)を利用してローカルLLM(大規模言語モデル)を実行する場合、利用できるLLMの規模は〜12B、処理できるコンテキストサイズは8K〜32Kトークン(8Kトークンなら日本文8,000強文字)程度です。

汎用的な性能においては、数百billion以上の規模を持つオンラインサービスChatGPTやGeminiに大きく劣りますが、ローカルLLMの特有の利点もあります。

この記事では、筆者が利用している活用術やモデルを紹介したいと思います。

※ ローカルで利用するLLM実行ソフトウェアとして(Ollama)Open WebUIを利用しています

AI画像生成

① プロンプト作成

もっとも一般的な利用方法だと思います。Stable Diffusion 1.5時代は、単語ぶつ切りの記法が一般的だったので、LLM利用は限定的でしたが、SD3.5やFlux.1では、文法的な正しさと明瞭な的確さを要求されるため、英語の苦手な日本人にとって必須ツールになりました。

※ 本記事で紹介した具体的なLLMモデルの入手先や規模・量子化等情報を、付録の有料欄に記載しています。

単純に「〜の画像を生成するプロンプトを英語で作って」でも問題ありませんが、ネット世界の有志の方が作り込んだプロンプトがあるので、それを利用する方法もあります。

例として、筆者が良く利用しているプロンプト・テンプレートは、

https://openwebui.com/p/michelk/stable-diffusion-image-generator-helper

です。このプロンプトを利用すると、

a young woman sitting near the Japanese mini kei truck

次の質問が返ってきます。

I would like to ask you three questions to help me better understand your vision:

"Is the young woman interacting with or simply observing the Japanese mini kei truck?"

"What is the style of the image you have in mind (e.g. realistic, manga-style, watercolor painting)?"

"Are there any specific details you'd like included in the scene (e.g. time of day, location, objects around her)?"

質問が英語なのがイマイチですが(プロンプトをLLMで日本語に訳しても使えると思います)、質問に英語の単語で答えていきます。面倒な場合は、「GO」でスキップもできます。

interacting, realistic photo, golden hour and country side

さらに質問してきます。

I would like to ask you three questions to help me better understand your vision:

"Is there a particular gesture or action that you'd like the young woman to be doing while interacting with the truck (e.g. tinkering with the engine, admiring the design)?" "What is the relationship between the young woman and the Japanese mini kei truck (e.g. owner, enthusiast, artist)?" "Are there any specific visual elements or details that you'd like to include in the surrounding countryside (e.g. rolling hills, trees, buildings)?"

同様に、簡単な単語で答えます。

sitting near the truck , enthusiast, rolling hills,

I would now write a prompt for you based on your responses:

"A realistic photo of a young woman sitting near a vintage Japanese mini kei truck in a serene countryside setting during golden hour. She is an enthusiast who has taken great care to restore and maintain this unique vehicle, and her interaction with the truck is evident through her thoughtful expression. Her hands are gently resting on the hood as she admires the design, with the soft light of the setting sun casting long shadows across the rolling hills in the background."

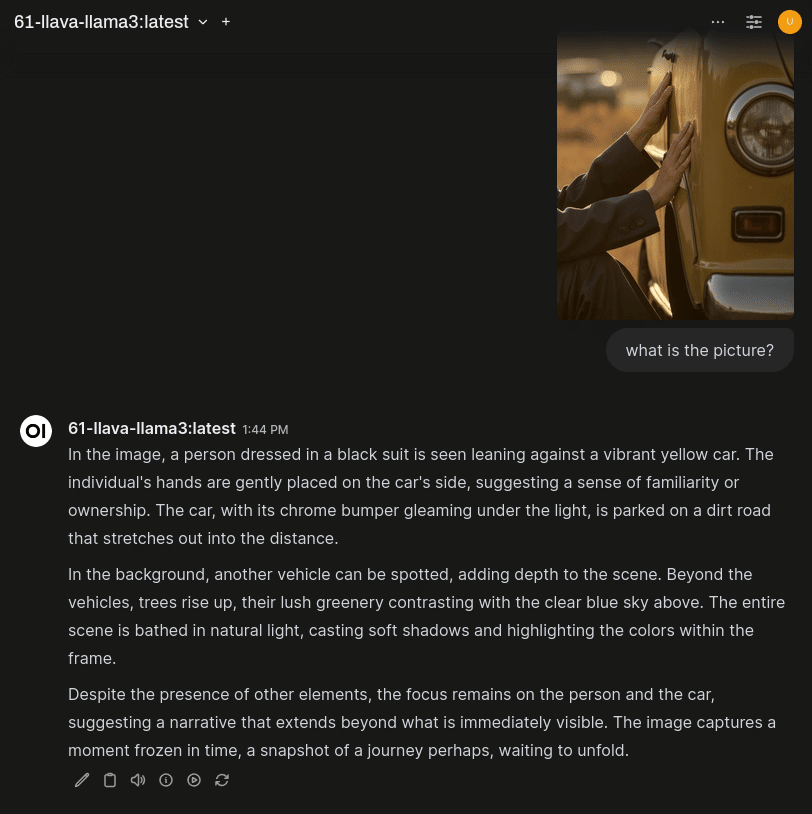

最終的なプロンプトを得ます。少し変更して画像を生成すると、次の画像を得ます。

※ ただし下記手法で生成したものです

この用途であれば、無料のネットサービスでいいじゃないかと思われるかもしれませんが、利用しているローカルLLMは脱獄モデルです。ネットで公開するサービスでは絶対に実現不可能です。絶大な利点です。

それに、最近は無料で画像生成にデフォルトで対応してしまった反面、「画像生成用プロンプト」を作ってと言っても画像を生成してしまい、プロンプトを表示してくれない事もあります。

次に、生成済みのプロンプトに対して「バリエーションを作る」事もLLMは得意です。上記プロンプトに対して、

画像生成用のプロンプト「A realistic photo of a young woman wearing blazer school uniform sitting near a vintage Japanese mini kei truck in a serene countryside setting during golden hour. She is an enthusiast who has taken great care to restore and maintain this unique vehicle, and her interaction with the truck is evident through her thoughtful expression. Her hands are gently resting on the hood as she admires the design, with the soft light of the setting sun casting long shadows across the rolling hills in the background.」のバリエーションを幾つか生成して

いくつかのバリエーションを作ってくれるので、それらを気軽にガチャとして試す事ができます。Flux.1ではプロンプト追従性が良い反面としてシードによる変化幅が少ないため、ガチャ利用する場合は、プロンプトを変化させる方が効果的です。

バリエーション2:

A realistic photo of a young woman wearing a yellow school uniform and sitting inside a vintage Japanese mini kei truck in a serene countryside setting during golden hour. She is an enthusiast who has taken great care to restore and maintain this unique vehicle, and her interaction with the truck is evident through her excited expression. Her hands are gently holding the steering wheel as she admires the interior, with the soft light of the setting sun casting long shadows across the rolling hills in the background.

② Visionモデルでプロンプト作成

LLMの種類には、視覚能力をもたせたVLM(Vision Language Model)やマルチモーダルモデルと呼ばれるものがあります。

VLMは画像を元にして会話する事ができます。「何の画像か?」と聞けば画像の内容を文字で記述してくれるため、そのまま画像生成用プロンプトとして利用可能になります。

※ もちろん、ChatGPT/Gemini等のサービスでも可能ですが、多くのWebインターフェースサービスでは、利用規約として入力データを企業の学習や改善等に提供する事になり、一般的なガイドラインでは、個人情報、著作物・肖像物などのアップロードが厳禁とされています。これは、流出リスクの無いローカルの利点でもあります。

インペイント時に本領を発揮します。部分的な画像の説明を詳細にできるため、インペイントがより高画質化します。※ 全体のプロンプトをそのまま利用して関係のないものが生成される事を防ぐ事もできます

Ollamaカスタムノードを利用すると、ComfyUIで自動化する事も可能です。筆者のComfyUI系記事では、ほぼ全てで利用しています。

また、ローカルなので、Webインターフェースを利用せずに、自分流の使い方ができます。定形コマンドを作ったり、ローカルに保存した画像ファイルの管理に利用したり、OCRのように部分スクリーンショットを解析して直接テキストに変換できます(ChatGPT等ではAPIを利用しないといけないので、無料では難しいです)

まとめ

Flux.1やSD3.5ではプロンプト追従性が向上し、画像生成分野でもLLM利用が必須になってきました。

現状では日本語文字画像を読み込めるVLMがほとんど無い状態ですが、画像生成AI用のプロンプトはベースが英語なので問題ありません。ベストなローカルVLM用途と言えます。

また、写真や画像を扱う場合は、個人情報・著作物の問題もあるため、ローカルLLM/VLM利用がよりリスクが少なく安全になります。

付録

本記事で利用したLLM/VLMモデルの詳細を記載しています。大した情報ではありませんが、記事作成を支援して頂ける場合はぜひよろしくお願いいたします。※ 脱獄モデルを含むため、利用する場合は細心の注意・自己責任でお願いします。利用を推奨するものではありません。

この記事が気に入ったらチップで応援してみませんか?