【Flux1】ローカルFlux.1だけで頑張った話JDJKJS【PixelWave】

はじめに

筆者が画像生成AIを利用する時は、(重くて遅い)Flux.1を品質や画質向上だけに利用して、構図生成やコントロールはSD1.5を利用しています。

また、普段利用するFlux.1のプロンプトも、描いたり生成した構図から自動で読み取るVLM(AI)任せなので、あまり自分で考える事がなかったのですが、CivitAIで公開されているPixelWaveのFlux.1モデル(特にschnell版)の品質が良さそうなので、真面目にFlux.1のみのプロンプト・コントロールで性能を調べてみました。

PixelWaveモデルで生成できる「日本的」なものはImageFXに匹敵するほどではありませんが、ベースモデルに比べると、日本的で見慣れた顔を多く生成できるようです。

JDの生成

North Koreaを入れると、昭和感というかレトロ感が増しました。

JKの生成

※ これからAI技術が進歩して人類の叡智を超えるAGIやASIが登場したとしても、AIでは絶対に不可能な事(ImageFXを含め近いうちに完全に不可能になるだろう事)があります。

人類に出来てAIにできない事は、人間的な事や創造的な事ではありません。それらはAGIの登場と共にすべて可能になりますから。

人類よりも上位の存在として拒否権(ブロック)を持つAGI/ASIでも絶対に不可能で、人類のみ可能な事は、人類が道具として完全使役可能な低性能AIと共に、アイドル&JK画像を生成する事ですw

トランプ大統領の影響で先延ばしになるかもしれませんが、DKもブロックされる日も近いのかもしれません。既にブロックされるという声もちらほら。

PixelWaveモデルは、ベースモデルに比べると日本的な制服がかなり生成しやすいと思います。アニメ調になる事もありません。

ベースモデルでは必ずセーラ服のシャツが「イン」になります。

JSの生成

※ 指などのハルシネーションはポスト修正しています

手法

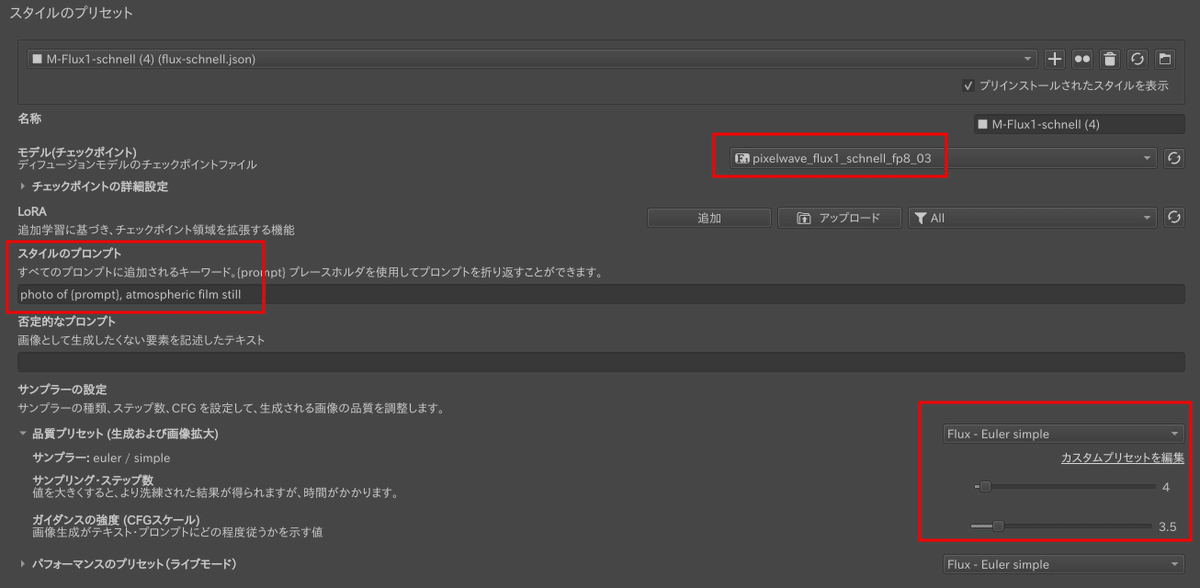

筆者はKrita-ai-diffusionを利用していますが、Flux.1(schnell+dev)が利用できるソフトウェアであれば何でも良いと思います。

schnellでノイズの多い画像と構図を生成して、devモデルでimg2imgして高精細にします。

schnellモデルを利用する理由は、高速(4step生成)で構図ガチャができるという事もありますが、最大の理由はノイズの多い画像ができるからです。

他の多くのschnellモデルはのっぺりした画質になってしまいますが、PixelWaveのschnellモデルだけはノイズの多い画像になります。一度のっぺりしてしまうと、img2imgで写実的にできません。

例として、猫画像を生成してみます。解像度は1280x720で生成します。

Schnell版でガチャをして構図を決めます。

PixelWave作者の説明欄には、8ステップ推奨とありますが、4ステップの方が構図が綺麗になるようです(指定のサンプラーが異なるからかもしれませんが)

構図が決まれば、devモデル(pixelwave_flux1Dev03.gguf)で高精細化します。解像度を直接変更してもいいのですが、Krita-ai-diffusionでは、生成時のダイアログで内部解像度を指定できます。

強度を30%程度にしてdevモデルでimg2imgします。

ちなみに、schnellモデルを利用せずに同じプロンプト&シードで生成した画像は次になります。schnellと比べて5倍程度の生成時間が必要ですので、devを直接ガチャ利用するのは現実的ではありませんし、生成画像もイマイチです。

※ 同じ品質にするには、ガチャ以外に品質プロンプト調整も必要だと思います。

まとめ

SD1.5と連成する場合や、手やハルシネーションの修正用途では、依然としてベースモデルが最も優れていると思います。しかしLoRAやControlNetなどを利用せずにプロンプトのみで生成する場合には、PixelWave・Flux.1モデル(のschnell版)が最も良さそうに思います。

付録

上記JS・JK生成プロンプトです。記事支援いただける場合はぜひよろしくお願いします。

※ ただし、Kritaで生成しているため、下記「prompt」を入れ替えたプロンプトが利用されます。

photo of {prompt}, atmospheric film still

この記事が気に入ったらチップで応援してみませんか?