【OpenWebUI】ローカルLLMの基本的な使い方ガイド

はじめに

ローカルでLLM(Large Language Model)を実用的に活用する基本的な使い方を、あらためて紹介したいと思います。

OpenWebUIのWindowsへの導入方法は下記事で紹介しています。

ローカルで利用できる日本語対応のLLMは複数あります。

基本

ローカルLLMとは?

ChatGPTやGeminiなど、インターネット上で文章生成やAIチャットができるネットサービスが盛んですが、これらと同様のサービスを、ローカルの自分のパソコンで実行する事ができます。

インターネットを介さずにローカル環境ですべての処理を行うため、セキュリティやカスタマイズ性で大きな利点があります。メールを含めた個人情報、私的なデータ、書籍や画像などの著作物をネットサービスのサーバー上にアップロードする事は、情報流出以外にも法的なトラブルを生じる可能性がありますので、ローカル環境でのAI運用は大きな利点になります。

(AI企業はあまり注意喚起しませんが)政府公表のAIガイドラインにおいても、機密保持契約を結んでいない場合のAIネットサービスへのセンシティブな情報の入力は御法度とされている事の一つです。

また、民主的な思想の自由がある事もローカルAIの利点です。最近のネット上のAIは、政治的なニュースにおいて翻訳や要約目的でもブロックや(こっそり)訂正される事が増加しています。もちろん自己責任論になりますが、これらブロック機能を外した脱獄モデルをローカルで利用する事も可能です。

※ 企業側からすると、AI回答の安全性に関しては頭の痛い問題なのでしょうが、AIが社会のインフラになり、大手AI企業の思想の強制やブロックが増えすぎると、マスゴミのように罵られる未来しかみえません。。

そして、(電気代以外は)完全無料です。電気代はゲーム用途と似たようなものになるはずです。

デメリットとしては、重いAI処理を自分のパソコンで行う必要があるため、NVIDIA製GPUを搭載したゲーミングPCクラスの高性能なパソコンが必要になります。また、スパコンやデータセンターに設置されるような業務用・超高性能な演算資源は利用できないため、単純なAI性能はネットサービスに劣ります。また、面倒な環境構築も自分で行う必要があります。

無料利用できるメジャーなローカルLLMのGUI実行環境

Ollama + OpenWebUI

筆者おすすめです。頻繁に更新が行われ、商業の新サービスが発表される度に、それらと同等の機能を常に追加しています。

LM Studio

通常のWindowsアプリケーションなので、インストールがとても簡単です。とりあえずローカルLLMを試してみたい場合にはおすすめです。機能が若干少ない事もありますが、Ollamaよりも安定&高速に動作します。

Ollama + Dify

開発者や管理者にとっては超高機能ですが、利用ユーザー側の機能は超貧弱です。※ 限定や制限が必要な企業やビジネス利用を想定している事もあるのでしょう

ローカルLLMの活用法

単純なチャット以外の機能や、特にAPIを利用する場合のネットサービスは有料・従量課金である事がほとんどなので、ローカル(無料)利用の大きなメリットです。

各種文章の生成や校正

ブレインストーミング・アイデア出し

各種アプリケーションのコパイロット

GPTsのような目的に合わせたチャットボットの作成

翻訳や要約

プログラミング

学習や教材作成

図表作成

(テキストの)フォーマット変換

各種データ分析

会話シミュレーション

ネット検索(もちろん検索エンジンの利用はローカルだけでは不可能です)

メール、企画書やビジネス文章作成

小説などのクリエイティブ用途

画像生成(画像生成AIやマルチモーダルAIモデルが必要です)

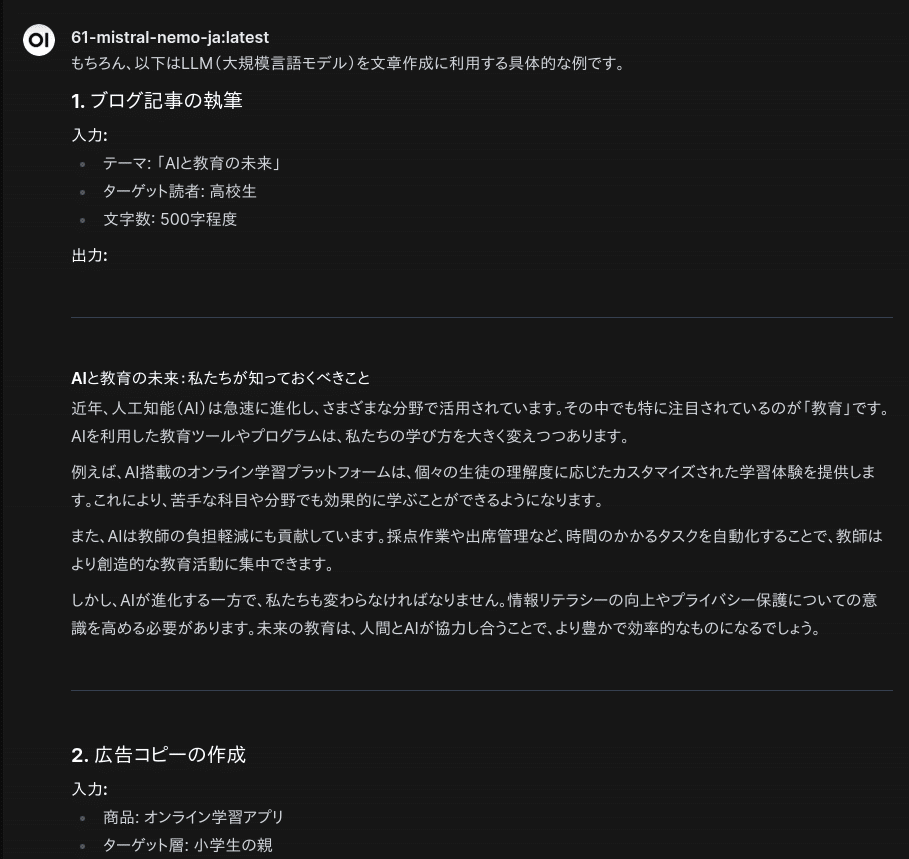

文章の生成や校正

LLMの基本的な活用方法です。ただし、規模が小さい事もあり、プロンプトは(ChatGPT等の大規模なものと比べると)シンプルにした方が良い結果を出す傾向があります。

アイデア出し

ブレインストーミングとしてアイデア列挙ができます。プロンプト変更以外にも、入手できる様々なモデルを(パイプラインとして組み合わせたり)試す事で、意外なアイデアを得る事ができます。

ネットサービスのように、上限が存在したり、何度も再生成するとブロックされるような事はありません。納得のいくまで何度も連打&再生成しましょう。

GPTsのようなチャットボットの利用

システムプロンプトや知識RAG・外部ツールなどを関連づけて特定用途のチャットボットを作る事ができます。

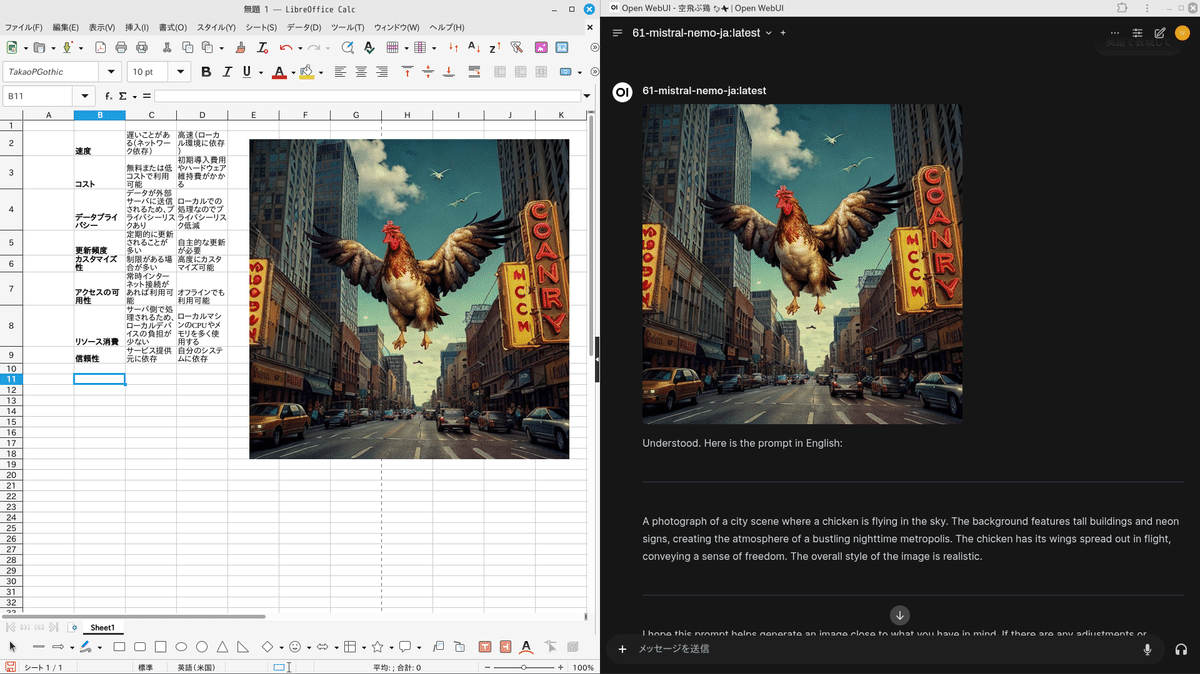

画像生成用のプロンプト作成と画像生成

自分で考えたものや、OpenWebUIライブラリで公開されている画像生成用のテンプレートを活用して、画像生成プロンプトを生成する事ができます。Stable Diffusion等の画像生成AIと組み合わせれば、OpenWebUI上での画像生成も可能です。

(OpenWebUIでは、A1111 Stable DiffusionとComfyUIが利用可能です)

コパイロット(非OpenWebUI)

Ollama APIを利用した各種コパイロットも利用可能です。ネットLLMサービスの場合のAPI利用は従量課金なので、気にせず利用できるローカルLLMならではの活用方法です。

Firefox/Chrome機能拡張

Firefoxであれば、ChatGPTやGeminiを利用できるようになりましたが、長文は弾かれ、ニュース等の内容(特に政治)によってブロックされる事が多くストレスが溜まっていましたが、ローカルLLMであればその様な事はありません。

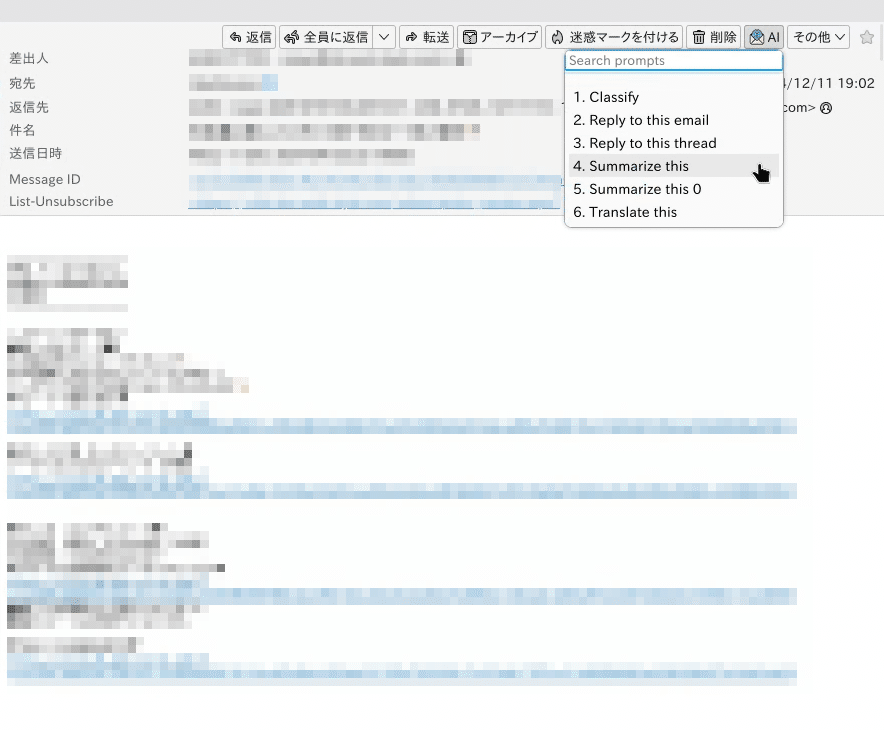

Thunderbird機能拡張

メールの要約、作成などにローカルLLMを利用可能です。

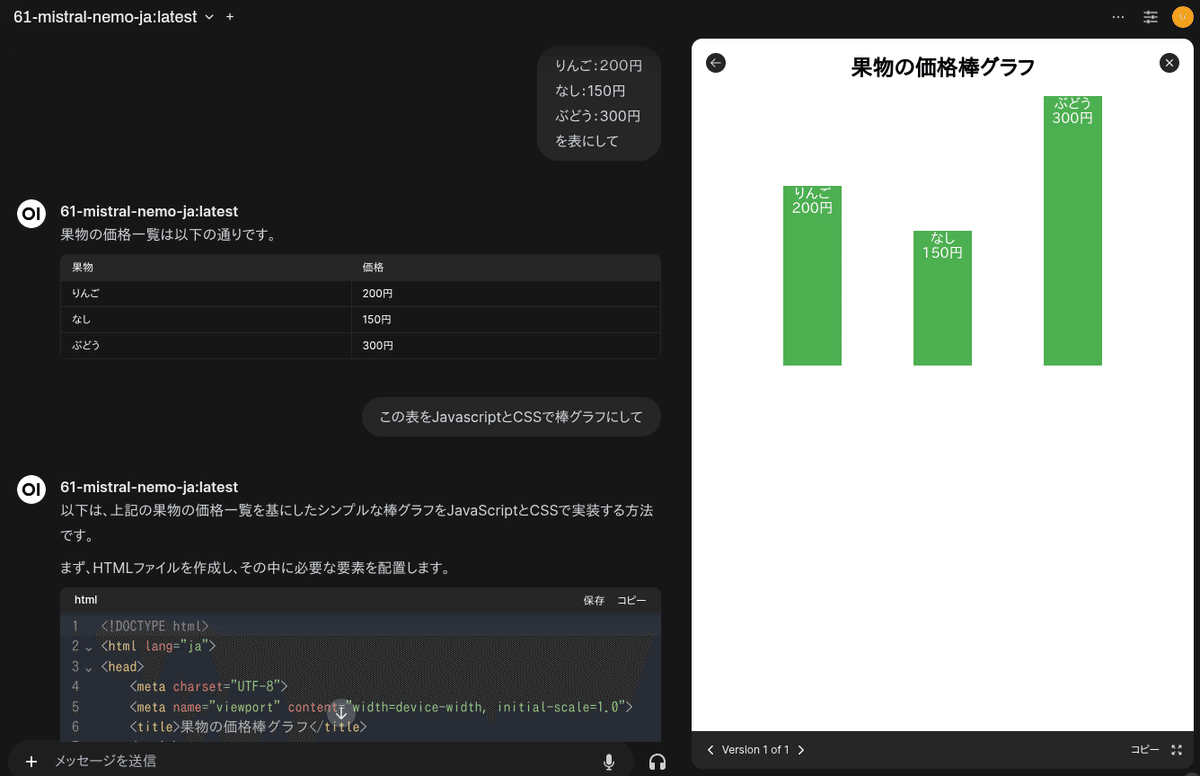

プログラミングや図表作成

OpenWebUI組み込みの機能として、JavaScript/html/CSSを利用した図表作成や簡単な動的Webページの作成も可能です。

Jupyter Notebook(対話的Python環境:Google colabのローカル版のようなもの)と連携して、本格的なデータ解析や処理も可能です

ChatGPT/Geminiと同じように、ExcelやLibreOfficeなどと連携して、図表のコピ&ペーストも可能です。ローカル処理なので、センシティブなデータも扱えます。

ローカルLLMとリアルタイム会話

もちろん時間上限はないので、時間を気にせずに常時LLMとの会話ができます。クリックする必要なく常時音声を拾うので、ゲーム等の作業で両手が利用できない時もボイス・チャットが可能になります。

※ 注意が必要な事は、TTS/STTにおいてWebAPIを利用すると、会話データが外部に送信されて音声に変換されます。

RAGを利用したカスタマイズ

RAG(Retrieval Augmented Generation)とは、外部のデータベースや検索情報を組み合わせることで、より正確性の高い情報回答を可能にする技術です。

基本的に「What」利用に弱いローカルLLMでは必須の強化手法です。

辞書検索のような利用方法になるため、LLMの文脈コンテキスト(ローカルLLMでは8K〜32Kトークンが一般的)に収まりきらないような書籍や全論文などの大データを利用する事もできます。

知識はシャープ「#」の記号を入力する事で挿入できます。

ネット検索結果を元にチャット

ボイスチャットする場合には、リアルタイム情報を取得できるため有用かもしれませんが、ローカルLLMでのネット検索用途は少し貧弱かもしれません。

※ そもそもネットを利用するので、ローカル利用としてのメリットが薄れます。素直にPerplexityやGensparkを使った方が快適だと思います。

その他実験的(アドバンス)な機能

OpenWebUIライブラリで公開されている機能拡張を導入すると様々な追加機能を利用できるようになります。

OpenAI o1モデルのように、自問自答して精度を上げたり、複数の異なるモデルを利用した mixture of agents手法を試す事もできます。(ただし、超遅いので実用性はあまりないと思います)

まとめ

ローカルLLMの利点は「無料」である事に注目されがちですが、実際はそれ以上に「自由」と「カスタマイズ性」に利点があります。

産業革命以降で最大の発明と言われる生成AI技術の最大の恩恵は、汎用性にあると思います。ネットAIサービスのアイデアとして、マインドマップを生成したり、画像を生成する有料サービスは数多存在しますが、それこそAIに自分専用にアイデアと共にローカルで作ってもらうべきです。「マインドマップを生成するシステムを作って」と。

もちろんまだまだ発展途上なので、プロンプト指示ひとつだけでは簡単にできませんが、技術者でなくても、自分専用であれば、十分実用的なシステムを作る事ができる時代になっています。

しかもアイデアすらAIに出してもらえる時代なので、これからの人類に必要な事は、実力や能力よりも、やる気と知的好奇心なのかもしれません。

(料金体系や安全性確保のため)受け身・均一化しがちなネットAIサービスよりも、ローカルAIをリミッターなく自分専用にカスタマイズして最大限活用していきたいものです。

付録

筆者がOpenWebUIのショートカットプロンプトとして利用しているローカルLLM向けのプロンプト集です。記事支援いただける場合は、ぜひよろしくお願いします。(面白みのない)一般的なプロンプトですが、参考程度にご利用ください。

筆者が良く利用している Mistral-Nemo-Japanese-Instruct-2408 モデルにて動作確認したものです。

この記事が気に入ったらチップで応援してみませんか?