ChatGPT の応答が遅いときにパノンを召喚してジョークを言わせるようにシュッとしてみた

ChatGPT を組み込んだサービスいっぱい出てきましたよねー

チャットサービスとかだとシュッと会話ができて楽しい(*´▽`*)

でもその内気づくのよ、、、

レスポンス、、、安定しなくね?( ゚д゚)

そう、OpenAI さんの状況によってはレスポンスが遅くなったりするのでござんす。(リトライとかあるしね)

さらにはエージェント的に裏側であれやこれやとしているとあっという間にユーザー体験が悪くなっちゃいますです。はい。辛い。

ChatGPT の場合 Steam で返却してちょっとずつ文字を表示していくようにすると緩和されるのだけれども、、、

裏側の処理によってはちょっとずつ出すのが難しかったりするのですん。゚(゚´Д`゚)゚。

というわけで

会話のつなぎ役用意すればいいんじゃね?

はい。

特定キャラクター(ボット)でやると待ち時間がバカにならんので待ち時間の間に早いレスポンス返すやつを用意すればいいじゃん(*´▽`*)

というわけで Just Do It!!

ジピコとパノン

とりあえず今回の主役となるボット達に名前をつけてみたドンっ!!

ジピコ(主人格)かわいいボット

パノン(モブ)会話をつなぐためにこちらのいうことを無視して永遠にジョークをいう存在(うざい)

ってなわけでこれをどのように実装するか考えるドンっ!!

結果

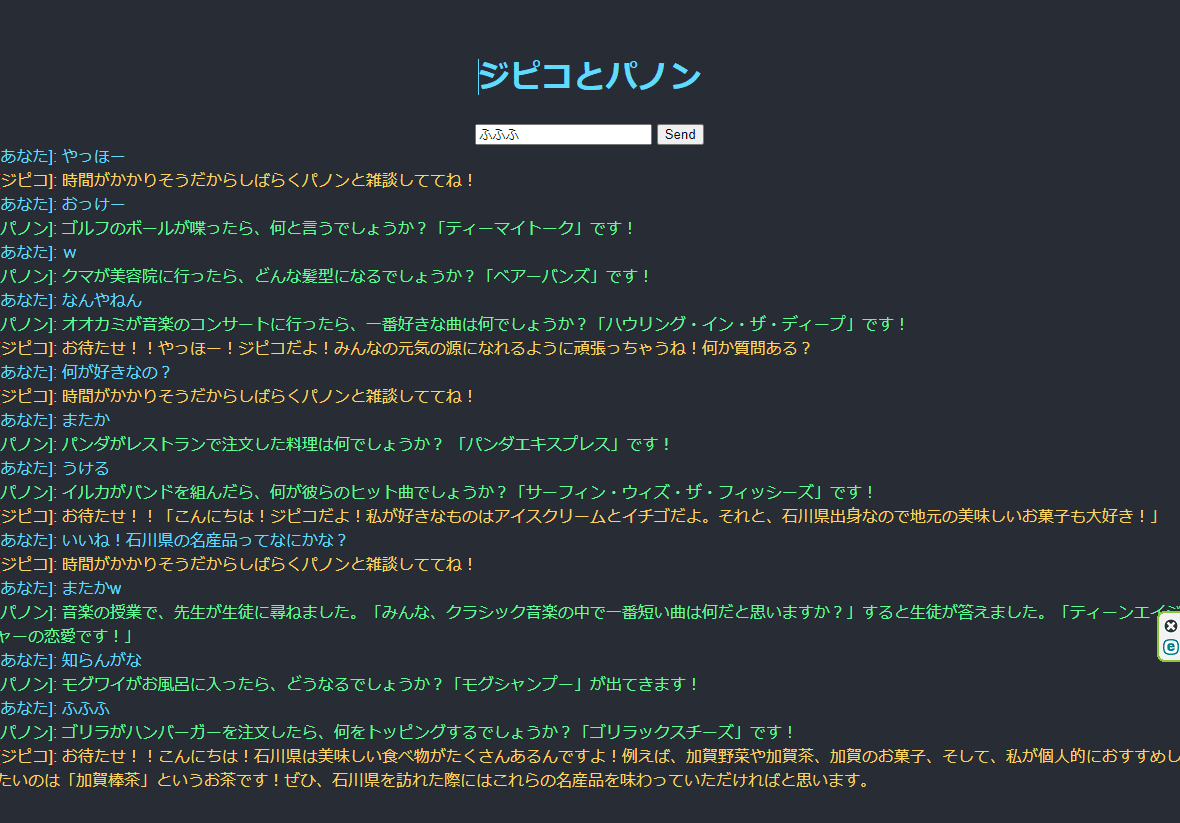

能書きはいいので結果を表示するのだ(〇-〇ヽ)クイッ

ということでまずは結果を公開しちゃうぞ☆

テキストボックスに何かいれる

ジピコが反応する

時間がかかりそうなら「ちょっと待ってね」と返事がくる

それ以降ユーザーが何を入力してもパノンがジョークを繰り出してくる(うざい)

ジピコの処理が完了したらジピコにリクエストを出せるようになる

とりあえず雑にシュッと遊びで作っただけなのでテキトーな内容ですけど GitHub にコードおいておくドンっ!!

ほんとにローカルで適当に遊んでいただけなので、実際にサービスに組み込む場合は最寄りのエンジニアさんに相談してインフラを含めてちゃんとした設計をしてね☆

ローカル LLM とのマリアージュの可能性

さて、今回はお遊びだったのでジピコちゃんが忙しい場合はパノンが事前定義済みのジョークをランダムに返すだけにしてますドンっ!!

しかしながら、こういう実装ではなく、パノンに相当する部分をローカル LLM で対応させるとただただジョークを垂れ流すだけではなくふんわりジピコが回答を返すまでのふにゃっとしたトークを繰り広げることができるやもしれません。。。

という言葉を残して気が済んだのでおしまい。