世界最大のAR/VRアワード「Auggie Awards」の興味深い作品とそこからの学び

先日世界最大のAR/VRアワード「Auggie Award」の受賞者・ファイナリストが発表されました。

Auggie Awardsでは世界中から数多くのXR作品がエントリーし、各カテゴリー毎にそれぞれ最も優秀な価値あるプロダクトと認められたAR/VR作品が賞を受賞します。

今回はそんな中で、あまり知られていないけどXRに関わる人達にとってヒントが詰まった興味深い3つのエントリー作品の紹介や作品にまつわるトピック、学びをご紹介したいと思います。

映画「Lion King」のバーチャル撮影システムを開発した「Magnopus」とは何者か?

1つ目にご紹介するのはほぼ全てのシーンをVR空間内で撮影したことで話題を呼んだ映画「Lion King」のVR撮影システム。

Auggie Awardsでは「The Lion King Virtual Production System」という名前で「Best Input & Output Hardware」と「Best Interaction Software」の2つのカテゴリでファイナリストにノミネート、見事Best Interaction Softwareで賞を受賞しました。

動画や記事などを見るとかなり映画制作者が撮影をしやすいように設計されていて、実際に映画の撮影現場で活用する機材を模したハードウェアを制作し、VR内のカメラを操作できるようにしているようです。

以下の動画では映画撮影者が使いやすいように設計されたVR撮影システムの紹介がされています。

後述する本システムの開発企業Magnopusは映画「Jungle Book」の制作にも関わっており、その制作経験を活かして今回のLion Kingの制作システムに行き着いたそうです。

Jungle Book制作の際にはAutodeskが提供する「Motion Builder」というソフトウェアがバックボーンに使われていたそうです。

ちなみに、Lion KingのプロトタイプはJungle Bookの動物のモデルアセットを使って制作されていたため、ディズニーのファンが集まるイベントで公開されたLion Kingの予告映像ではアフリカ象ではなく、アジア象が背景に使用されていたことを鋭いファンから指摘されたそうです笑

このシステムはUnityをベースに作られていますが、実は彼らがこのLion Kingのプロジェクトに取り組み始めたのが2016年の後半でした。当時はUnityにはまだPipelineアニメーション機能がなく、彼らが独自にPipelineアニメーションに似た機能を実装したそうです。

また大量のアセットを入れ替えながら、理想のシーンを再現しスムーズに撮影するため、Unityのエディタモードを独自改造して全てのシーンをエディタモードで撮影できるようにもしたみたいです。

彼らのUnityとVRを使った映画撮影の試行錯誤の全貌はこちらの記事にたくさん載っていますので、興味ある方はぜひご覧ください!

Lion Kingのバーチャル映画撮影システムを作った制作会社「Magnopus」とは?

このバーチャル撮影システムを開発したのはLAに本拠地を構えるMagnopus。

彼らのホームページを訪れると彼らに関する数少ない情報を得ることが出来ます。

彼らはヒット映画の制作からスーパーボウルのCM、テーマパークなど、あらゆる作品を手がけてきた制作会社で、制作チームにはビジュアルエフェクトクリエイターやゲーム業界出身者も数多く在籍しているようです。

We take content security very seriously before, during, and after a project.

We’re doing it because it needs to be done, and “less talking” means “more doing.”

とサイト内で宣言しているように、彼らは基本的に自分たちの制作実績を公表しないスタンスのようで、今回のAuggie Awardsでの公表例は異例の対応だったようです。

そんな彼らの会社サイトにはVR/ARの制作に関するページが用意されており、現在彼らがVR/ARの制作に力を入れて始めていることが伺えます。

会社サイトでは彼らがどんな作品を作ったのか見ることはできませんが、検索していくといくつか彼らの作品を見つけることができました。

■Blade Runner 2049 Trailer with Oculus Rift

■Mission ISS with Oculus Quest in collaboration with NASA

■Coco VR

さすが映画畑出身ということもあり、VRコンテンツではかなり有名所の映画プロモーションを制作しているようです。

そして実は映画以外の有名所でも最近彼らが制作したVRコンテンツがリリースされています。

最近Oculus Questで正式リリースとなったハンドトラッキング機能。このハンドトラッキングのチュートリアル的なアプリケーションである「Elixir」も実はMagnopusが制作したものでした。

映画のプロモーション作品から、ElixirなどのOculusのメインコンテンツまで幅広く制作を手掛け、今後さらにVRやARのコンテンツ制作で勢いを見せてきそうなMagnopus。

今後も彼らの動向に要注目です!

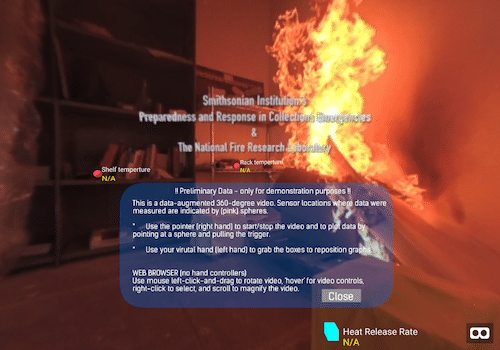

過酷な火災現場でのWebVRトレーニングシステムにみるAR in VRの新たな可能性

次にご紹介するのはNIST(アメリカ国立標準技術研究所)が開発した火災現場におけるARトレーニングアプリケーション「Data Augmented 360-Degree Fire Video」。

彼らはBest of Social Impactという部門で惜しくも賞は逃しましたが、ファイナリストにノミネートされました。

興味深いのは火災現場をリアルに再現するためVR空間の中でモデリングを行うのではなく、特性の透明な冷却ケースを制作しその中に360度カメラと冷却水を入れて火災現場を撮影し、VRで視聴できるようにしている点です。

さすがアメリカというべきか、やることが大胆ですね笑

独自に開発したWebXRツールを使って、360度空間の中にデータビジュアライゼーションを施し、火災現場でのデータを可視化して消防士などの教育に役立てます。

こちらの記事ではどのように360度動画を取れるシステムを開発したか、どのように活用されているのかなどの説明が詳細に書かれています。

AR in VRの進化系としてのARシミュレーターの可能性

このプロジェクトを見て、現在MESONが提供しているVRの中でARのシミュレーションを提供する手法に新たな価値を付加できる可能性を感じました。

現在MESONではVRの中でARのコンテンツを擬似的に表示して、現場にいかなくてもARコンテンツの見栄えなどをテストできるシミュレーション環境を提供しています。

直近ではコロナの影響で外出できず、現地でARのテストができないようなプロジェクトでも活用いただけていたりします。

こちらの動画はモデリングしたゴルフ場でARグラスの視野角を模した枠を表示して、その中でARコンテンツを表示している様子です。

これまでMESONでは現実の空間をモデリングしたりフォトグラメトリスキャンしてAR体験をシミュレートしていましたが、この手法だとモデリングのコストやAR体験を作る上で大事な「リアルな場所でのARの見え方」までは正確に再現することはできませんでした。

しかしこのプロジェクトのように360度で撮影した動画を用意したり、もしくはリアルタイムに360度動画を配信することで、実際にそこにいる状況でどのようにARコンテンツが見えるのかを確認することができます。

場所をモデリングした場合に比べて空間内の移動は制限されますが、プロジェクトの性質に応じてうまく使い分けることでよりプロジェクトのニーズにあったVR内でのARシミュレーションを提供することが可能になると考えられます。

その他の用途として、KDDIが先日公開していた攻殻機動隊の360度動画コンテンツのように、AR展示をよりリアルにイメージしてもらうために360度動画で会場を予め撮影し、会場でどんなARコンテンツが楽しめるのか簡単に体験してもらうなどロケーションベースARコンテンツのPR手段の一つとしても活用できそうだと感じました。

これがマジなら超すごい!次世代ARアシスタント「Eve」

次に紹介するのは「Best of Use AI」部門で賞を獲得した次世代ARアシスタント「Eve」。

提供しているのはTechSeeというイスラエル発のスタートアップ。

動画でも紹介があるように顧客のスマホカメラを通して、商品の組み立て方や使い方をアシスタントする画像認識AIエージェントを提供しています。

TechSeeについて調べてみると2年前からVodafoneなどに遠隔のビジュアルコールシステム「TechSee Live Contact Centers」を提供しており、ここで得たデータを基に現在のEveのような画像認識AIエージェントを構築していたようです。

現状、単体のアプリではなく、クライアント企業のアプリに組み込むAIエージェントとして提供しているようで自分の手元で実際に試せるものは見つかりませんでした。

コンシューマーアプリケーションにおける画像認識活用の機運

コンシューマーアプリはエンタープライズアプリに比べるとカメラに映るシーンが千差万別で、ユーザーのカメラのかざし方なども違ってくるので、かなりのロバスト性が求められます。

そのためこれまでコンシューマー向けのARアプリケーションでこういった画像認識AIを活用することは難しいと考えられてきました。

実際にこのアプリを使ったことがないので、どのくらいまでの精度が出せるのかは少し疑問ではありますが、もしこれが実用ケースで使えているなら、コンシューマー向けのARアプリケーションにおいても画像認識AIとARを組み合わせたアプリケーションの可能性を真剣に考える必要があると感じました。

最後に

有名なプロダクトだけではなく、あまり知られていないプロダクトにも注目してみると今後のXR開発におけるヒントがたくさん見つけられました。

他にも多くの素晴らしいXR作品がノミネートされているのでぜひ気になった方はAuggie Awardsのページから作品集をご覧ください!

そして今年はなんとMESONが開発した「PORTAL with Nreal」がAuggie AwardsのBest Campaign賞を受賞することができました!

ソフトウェアとしては日本で初めてAuggie Awardsを受賞することができ、MESON一同本当に嬉しい気持ちでいっぱいです。

そしてPORTAL with Nrealの実現に尽力してくれたチームメンバー、これまでMESONを支えてくれた多くの方々、Auggie Awardsで投票してくれた友人たちに心から感謝したいです!

MESONからエントリーしたもう一つの作品「Spatial Message」も、惜しくも賞は逃しましたがファイナリストにノミネートしていただくことができました。

これを契機に日本から世界のAR業界へ存在感を示していけるように頑張っていきたいと思います!

そしてそんなMESONと一緒に仕事をしてみたいというパートナー企業様はぜひ一度弊社にご連絡ください!

是非次回のAuggie Awardsで賞を獲得できるようなXRプロダクトを一緒に作りましょう!

少しでもこの記事が役に立ったと思ってもらえたら、ぜひ「スキ」ボタンも押して頂けると嬉しいです!

この記事が気に入ったらサポートをしてみませんか?