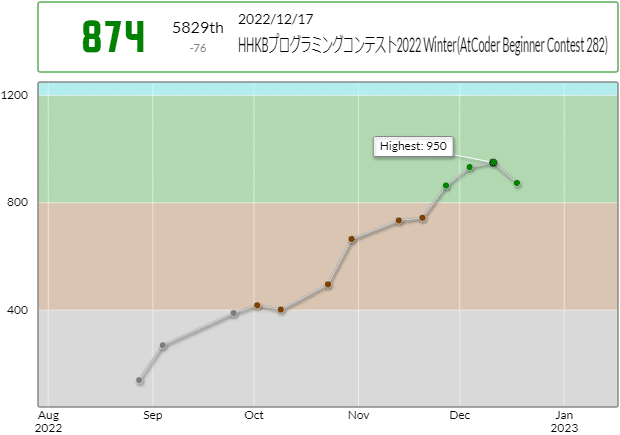

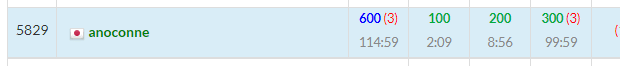

AtCoder Beginner Contest反省会 ~入緑編~

最近Pythonを勉強しはじめました。本を読み続けてページが進んでいくと充実感があるのですが、本を読んでるだけでは実は何も身についてないという厳しい現実に対して危機感があり、適度に課題を見つけて実践しようと努力しています。勉強が進んでないような焦りも感じますが、そうした中でしか得られない発見があると言い聞かせています。

「Wordleをやっててふと思いついた問題をPythonで解く」という記事は、そんな取り組みの1つです。この記事を書いたときに、noteの他のプログラミング記事をいろいろ読んでいると、AtCoderをやっている人が結構いて興味がわき、AtCoder Beginner Contest 266に初めて参加してみました。勉強になったので、自分のためという性質が強いですが、メモを書きます。今後参加したときもこの記事に追記していきます。上記、Wordleの記事で処理時間の長いプログラムを書きましたが、AtCoderをやっているうちに、一瞬で処理できるアルゴリズムが見つかるのではないかと思えてきて、探しています。

AtCoder Beginner Contest 266

時間内に正解したのはA、B、C、Eの4問でした。Aの時点で10分かかり、type(4/2)の結果が、<class 'float'>だったのがまず勉強になりました。Cまで正解したあと、Dの問題文を読んでおもしろい問題のように感じましたが、全く解き方の見当がつかず、あきらめてEに進むとEはすぐに解けました。Dが400点でEが500点なので、Eの方が難易度が高いのでしょうか?その後Fのコードを書いているときに制限時間となりました。G、Exはまだ問題も読んでいませんが、問題も理解できないかも知れません。

D - Snuke Panic (1D)

問題を読んでおもしろそうだと思い、なんとかしたかったですが、残念ながら全く解き方の見当がつきませんでした。解説を読むと動的計画法(Dynamic Programming, DP)と書いてあり、発想に驚きました。この問題を見るまで、でかい配列を作ってしまっていい(作らなくてもいいですが)という考えが、ぼくにはありませんでした。DPを知ると確かに簡単かもしれません。DPの他のパターンもいろいろ勉強しておきたいです。 2022-08-27

n = int(input())

t_max = 10**5

dp = [[-10**10]*5 for _ in range(t_max+1)]

sunuke = [[0]*5 for _ in range(t_max+1)]

t_last = 1

for _ in range(n):

t, x, a = map(int, input().split())

sunuke[t][x] = a

if t > t_last:

t_last = t

dp[0][0] = 0

for t in range(1,t_last+1):

for x in range(5):

dp[t][x] = dp[t-1][x]

if x < 4 and dp[t-1][x+1] > dp[t][x]:

dp[t][x] = dp[t-1][x+1]

if x > 0 and dp[t-1][x-1] > dp[t][x]:

dp[t][x] = dp[t-1][x-1]

dp[t][x] += sunuke[t][x]

print(max(dp[t]))追記1。問題Exを読んだところ、すぬけ君の出現領域がでかすぎて全領域メモリ確保は無理だったのでここに戻ってきました。最初にメモリ確保せず、すぬけくんの出現位置での情報だけで解いてみます。時間tに影響するのはt-3以降の影響があるものと、t-4以前の最大値という考え方で解きました。実行時間とメモリ使用量の最大値が242ms/103152KBから280ms/114388KBに増えたのが気になります(あれ?)が、全領域でDPやらなくても正常に動作しました。コードも上のよりスッキリしないですが、すぬけ君出現位置だけに注目して解ける感覚は得られました。問題Exに戻る。 2022-08-31

n = int(input())

sunuke = {}

bests = {}

ts = []

for _ in range(n):

t, x, a = map(int, input().split())

if x > t:

continue

sunuke[t] = (x, a)

bests[t] = [0,0] # best at sunuke point and best so far

ts.append(t)

best_so_far = 0

for i in range(len(ts)):

j = i - 1

max_effect = 0

while j >= 0 and ts[j] > ts[i] - 4:

if ts[i] - ts[j] >= sunuke[ts[j]][0] - sunuke[ts[i]][0] >= ts[j] - ts[i]:

if bests[ts[j]][0] > max_effect:

max_effect = bests[ts[j]][0]

j -= 1

if j >= 0 and bests[ts[j]][1] > max_effect:

max_effect = bests[ts[j]][1]

bests[ts[i]][0] = max_effect + sunuke[ts[i]][1]

if bests[ts[i]][0] > best_so_far:

best_so_far = bests[ts[i]][0]

bests[ts[i]][1] = best_so_far

print(best_so_far)F - Well-defined Path Queries on a Namori

xからyに行く単純パスが一意に定まるか?という問題。最初、xから同じ頂点を通らないルートを全探索して、2通り見つかった時点でNoとするコードを書いていましたが、当然それでは実行時間制限3秒に収まらずNGでした。グラフに関する数学的な知識を前提に解く必要があります。解説によるとN頂点N辺の連結なグラフのことを「なもりグラフ」といい、閉路が必ず1つのグラフになるそうです。なぜ閉路が1つになるのか考えてみました。3頂点では明らかに閉路1つです。N頂点で閉路0のグラフを作れたとすると、その枝の先の頂点と辺を除くことでN-1頂点で閉路0のグラフを作れることになり、3角形が閉路1つであることと矛盾します。閉路2つの場合については、枝があれば閉路0の場合と同じロジックで説明でき、枝がなければグラフは閉路2つだけとなり、連結であることに矛盾します。ということで、この問題の条件は「なもりグラフ」であることなので、1つの閉路とそこから木が生えた構造であり、同じ木に属する頂点同士は単純パスが一意に定まり、そうでなければ定まらないです。このような問題が出題されるのであれば、グラフ関連のこともいろいろ勉強しておきたいです。しかし「N頂点N辺の連結なグラフ」という前提条件が恣意的な感じもしてしまいますが、現実世界でよくあるのでしょうか? 2022-08-28

グラフの問題を見直しているので久しぶりにやってみたら、難しかった。巡回路ノータッチで、サブツリーの部分を検出してやる。しかし処理速度が他の人より遅いのが気になるな。みんなどうやってんだろう?ぼくの提出は1826msから1506msになっただけ。この時から経験積んだからこなれたかもしれないけど、処理内容あまり変わってない? 2022-12-17

N = int(input())

g = [set() for _ in range(N)]

for _ in range(N):

u, v = map(int, input().split())

g[u-1].add(v-1)

g[v-1].add(u-1)

leaves = []

for i in range(N):

if len(g[i]) == 1:

leaves.append(i)

subtrees = {}

for leaf in leaves:

cur = leaf

v_subtree = set()

while len(g[cur]) == 1:

v_subtree.add(cur)

next = g[cur].pop()

if next in subtrees:

v_subtree |= subtrees[next]

subtrees.pop(next)

g[next].remove(cur)

cur = next

v_subtree.add(cur)

subtrees[cur] = v_subtree

sub = [-1]*N

for root, vs in subtrees.items():

for v in vs:

sub[v] = root

Q = int(input())

for _ in range(Q):

x, y = map(int, input().split())

if sub[x-1] != -1 and sub[x-1] == sub[y-1]:

print('Yes')

else:

print('No')G - Yet Another RGB Sequence

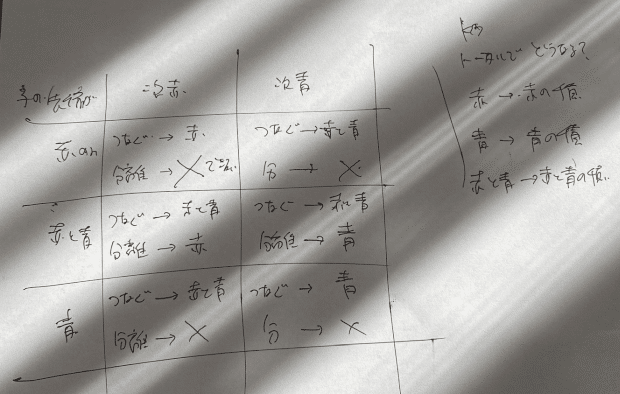

ついに、問題Gを解説を見ずに自力でACできました!比較的易しい問題ではありましたが、それでも今後の意識の変化につながる大きな一歩です。実は直前にABC267 Gで「挿入DP」を学んだ直後で、「数列に挿入していく」という見方が身についていたため、ぼくの頭が、この問題の解き方を思いつきやすい状態になっていた可能性はあります。DPかなと思わせてDPではありませんでしたが、ちゃんとひらめくことができました。しかもPythonでの提出が160くらいあって、処理速度が5位でした。高速化のノウハウが身についてきているのでしょうか?RGをKで置き換えると、まず、K、B、Rを並べたあとで、Rの後ろ以外にGを挿入すればよいことがわかります。最近、過去に参加したABCのGまでの問題を埋めていってたのですが、この問題が最後でした。 2022-12-16

M = 998244353

R, G, B, K = map(int, input().split())

R -= K

G -= K

N = max(K+B+R, K+B+G)

fact = [0]*(N+1)

invfact = [0]*(N+1)

fact[0] = 1

for i in range(1, N+1):

fact[i] = fact[i-1] * i % M

invfact[N] = pow(fact[N], M-2, M)

for i in range(N-1, 0, -1):

invfact[i] = invfact[i+1] * (i+1) % M

invfact[0] = 1

def choose(n, r):

return fact[n] * invfact[r] * invfact[n-r] % M

ans = choose(K+B+R, K)

ans *= choose(B+R, B)

ans %= M

ans *= choose(K+B+G, G)

ans %= M

print(ans)Ex - Snuke Panic (2D)

問題Dの2D版ということでおもしろそうです。問題読みましたが、問題Dで学んだDPが使えない。すぬけ君の出現範囲が問題Dでは5x10^5だったのに対し、Exでは10^9x10^9x10^9、全領域のメモリ確保できません。ですよねぇ。Dの解法でも気になってたポイントなので。ひとまず、問題Dに戻り、すぬけ君の位置だけの情報で解くプログラムを作ってからExに戻ってきます。この問題はそれだけでは済まないですが。一旦問題Dに戻る。 2022-08-31

問題Dから戻ってきました。別の解き方をしたことで、全領域メモリ確保せずにすぬけ君の位置だけに注目して解く考え方がわかりました。現在のすぬけ君の位置でのポイントの最大値を求めるには、その位置に到達しうるすぬけ君の位置全部の最大値+現在のすぬけ君の大きさを求めればよいです。問題Dでは出現範囲が5しかないので4秒以上前のすぬけ君全部の影響を受けることになり、4秒以上前の最大値を順次更新していけば解けましたが、問題Exは出現領域が広すぎて単純化できません。かと言って他のすぬけ君の位置全部に対して影響するかどうか調べているとそれだけでO(N^2)になってしまいます。解説を見ると2次元セグメントツリーという言葉が書いてありましたので、セグメントツリーについて勉強しました。なるほど、2分木を使うことで範囲の最大値の更新も取り出しもO(log(N))ででき、感動です。これを2次元にするというのは、イメージするのに苦労します。2次元でO(log(N)^2)で取り出せます。しかしメモリがN^2になってしまうなら結局解けねぇじゃねぇかという疑問が残ります。これ、データが入ってるところだけ確保することでN log(N)^2になるとの説明。確かに辞書を使えばできるので感動モノです。そこまで理解しても、すぬけ君の位置はtもあり、3次元領域なのでどうやって解けばいいかわからず、解説を見ました。(t, x, y) -> (a=t-x-y, b=t+x-y, y) と座標変換することで、aとbとyの値がすべて現在のすぬけ君以下のものの影響を受ける、と言い換えることができます。2次元セグメントツリーなどの高速アルゴリズムを知っている場合、この座標変換の方が問題を解くときの肝になりそうです。解説では不等式を変形していってaとbにたどり着いていますが、影響を受けるすぬけ君の位置と影響を受けない位置の境界において、t-x-yとt+x-yは一定となるため、意味的に考えてもしっくり来る変換です。でも機械的に式を変形して導けた方が良いようにも思います。実装するにあたり、解説のC++実装例を参考にしました。何日も気になって考えていたら疲れており、何かで行き詰まったときに参考にできるコードがないと、がんばるエネルギーがもう残ってないです。読み始めて気づいたんですが、これセグメントツリーじゃないです。まず、サイズがnで変だなと思いました。セグメントツリーならサイズ2nになるはず。あとx&-xというなぞのビット演算。フェニック木(Binary Indexed Tree、BIT)というものでした。x&-xは最下位ビットを取り出す処理になります。なぜそうなるかというと、x+(-x)が0になるということは、xと-xは最下位ビットが同じで、それより上位のビットは全部逆になるからですね。これを足したり引いたりしていますが原理がわかるとすごいです。作った人、定式化した時に興奮したんじゃないかなと感じました。自分でBITを実装するときは1から7くらいまでバイナリ表現で紙に書いてみるといつでも思い出せます。最初に作ったバージョンは制限時間の5秒を0.5秒くらいオーバーしました。もう改善できるところないよ、Pythonでは無理なのか?とあきらめかけましたが、defaultdictやsetdefaultを使っているところで、いらないノードを追加してしまっていることに気づき(!)if文やgetに変更して無事正解しました。BIT.set、BIT.prod、BIT2D.set、BIT2D.prodの中でsetdefaultやgetやif分岐を使い分けているところです。不十分な検討でむやみにdefaultdictとかsetdefaultとか使ってしまっていたことがわかり、勉強になりました。 2022-09-03

class BIT():

def __init__(self, n):

self.n = n

self.maxima = {}

def set(self, i, input):

while i <= self.n:

if input > self.maxima.setdefault(i, 0):

self.maxima[i] = input

i += i&-i

def prod(self, i):

res = 0

while i > 0:

if self.maxima.get(i, 0) > res:

res = self.maxima[i]

i -= i&-i

return res

class BIT2D():

def __init__(self, n, m):

self.n = n

self.m = m

self.bits = {}

def set(self, i, j, input):

while i <= self.n:

if i in self.bits:

if input > self.bits[i].prod(j):

self.bits[i].set(j, input)

else:

self.bits[i] = BIT(self.m)

self.bits[i].set(j, input)

i += i&-i

def prod(self, i, j):

res = 0

while i > 0:

if i in self.bits:

max1d = self.bits[i].prod(j)

if max1d > res:

res = max1d

i -= i&-i

return res

n = int(input())

sunuke = []

pset = set()

qset = set()

for _ in range(n):

t, x, y, a = map(int, input().split())

if t >= x + y:

p = t-x-y

q = t+x-y

sunuke.append((y, t, p, q, a))

pset.add(p)

qset.add(q)

pmap = {p:i+1 for i, p in enumerate(sorted(pset))}

qmap = {q:i+1 for i, q in enumerate(sorted(qset))}

sunuke.sort(key=lambda x: (x[0], x[1]))

pnum = len(pset)

qnum = len(qset)

bit2d = BIT2D(pnum, qnum)

for item in sunuke:

p_compress = pmap[item[2]]

q_compress = qmap[item[3]]

max_pq = bit2d.prod(p_compress, q_compress)

bit2d.set(p_compress, q_compress, max_pq + item[4])

print(bit2d.prod(pnum, qnum))2次元セグメント木でもやっておきたいと気になっていたので、作ってみましたが、半分のテストケースで時間制限をクリアできません。厳しいですねぇ。いろいろ手を打ったけど、これ以上どこを改善できるのか?ただ、トライすることで、いろいろ気づきがあります。フェニック木は1から始まってたけど、このセグメント木は0からだなぁとか、無駄な処理いっぱいしてたなぁとか、デフォルト値は何かな?とか、更新するときに必ず更新するか、変更が入るときだけ更新するかみたいなのは問題によって変わるのかなぁとか。そういうことを考えているとライブラリーを使うってのも、何も考えずに適用できるわけではなく、問題に合わせて設定を変えたりする必要があって、なかなかむずかしいと認識しました。ACしないと意味ないですね。このコードでは、時間制限に引っかかってACできていないです。なんとかしたいけど、ここは一旦あきらめます。 2022-09-26

ABC283 Fをやっていて、初めてセグメントツリーで1問ACできた中で、改善点が見つかったので、ちょっと2次元セグメントツリーでのAC可能性でてきた?と思い修正してみました。再帰呼び出しをスタックに変更したり、無駄に子要素両方のmax値を計算し直していたのをやめたりしました。ていうか昔書いたコードってだめなところ見つかるもので、学習が進んでる証拠なのでいいですね。上にコピペしていたコードは問題があったので、コードは消して、提出リンクに変更しました。ていうか9月26日って始めてから1ヶ月のころです。それにしてはがんばっていて、時間間隔が変に感じます。が、確かに若干スピードアップしたものの、TLEx19がTLEx16になったに過ぎませんでした。正しく動いてそうなのは喜ばしいことですが。他のPythonでACしてる人の中で、フェニック木ではなくセグメントツリーを使っている人たちは、なぜか2次元部分を領域木というもので実装していそうです。領域木に秘密がありそうなので、領域木というものを別途学ぶ必要がありそうです。 2023-01-09

その後、ABC285 Fを通じて、さらにqueryの処理を改善し、またこの問題のTLE解消を期待しましたが、処理速度は速くなったものの、TLEの数は減りませんでした。 2023-01-16

AtCoder Beginner Contest 267

直前まで266のExをやってて頭が死んでる状態で、悩みましたが参加。A、B、Cまで解いて、Dがわかりませんでした。解説を見て驚愕。前回と同じでDPに持ち込む問題でしたがそのように見えてませんでした。まずは4問解くのが目標になりそうです。勉強になるのでおもしろいしやりたいけど、他の生活もあるので、続けてたらたぶん頭と体がもたないです。ある程度のレベルに達したらそんなことないのでしょうが。

B - Split?

問題がビットフラグで書かれていると影響受けます。 2022-09-04

D - Index × A(Not Continuous ver.)

ABC 266 Dと同じでDPで解ける問題と解説で知りましたが、気づきませんでした。こういった問題をDPに持ち込める頭になる必要がありそうです。あと負数もありうるということのあつかいは要注意でした。0と比較して0を最大値として採用してしまってバグりました。 2022-09-04

n, m = map(int, input().split())

a = [0]

a.extend(list(map(int, input().split())))

dp = [[-10**12]*(m+1) for _ in range(n+1)]

dp[0][0] = 0

for i in range(1,n+1):

dp[i][0] = 0

for j in range(max(1, m-n+i), min(i+1, m+1)):

dp[i][j] = max(dp[i-1][j], dp[i-1][j-1] + j * a[i])

print(dp[n][m])E - Erasing Vertices 2

解説に、「「現時点でコストが最も低い頂点に対して操作を行う」を N回繰り返すのが最適であることがわかります」と書かれています。頂点を全部消さないといけないし、操作のたびに他の頂点に対する操作のコストはどんどん減っていくだけなので、言われてみると当たり前なのですが、これにすぐ気づけません。こういったことに短時間で気づけるにはどのように頭を使えばよいのでしょうか?とりあえず問題文にグラフと書かれているからと言ってなにか複雑な理論が必要だとは思い込まないようにします。そしてプライオリティーキューというものが使われていました。Pythonではheapqというライブラリになっています。ヒープ領域のヒープと全く関係なく、ヒープ木を使うアルゴリズムとのことです。最小のものをO(1)で取り出すことができますが、最小以外の要素に簡単に操作ができません。そこで、同じ頂点の以前登録した情報を残したまま、コストが小さくなった頂点の情報を、どんどんプライオリティーキューに追加していってます。そして頂点を消したかどうかは別のところで管理しておき、heapqからすでに消した頂点が取れたときは無視するという方法を取っています。コードだけ見ると「あれ?」と思いましたが理由があるんですね。理由があるにせよ、古くなった情報はキューから消さねば…という思い込みがあるので、これでいいんだ!というのは頭を刺激されました。 2022-09-04

import heapq

from collections import defaultdict

n, m = map(int, input().split())

a = tuple(map(int, input().split()))

removed = [False for _ in range(len(a))]

nexts = defaultdict(set)

costs = defaultdict(int)

for _ in range(m):

u, v = map(int, input().split())

iu = u-1

iv = v-1

nexts[iu].add(iv)

nexts[iv].add(iu)

costs[iu] += a[iv]

costs[iv] += a[iu]

pq = [(item[1],item[0]) for item in costs.items()]

heapq.heapify(pq)

maxcost = 0

while pq:

item = heapq.heappop(pq)

id = item[1]

if removed[id]:

continue

if item[0] > maxcost:

maxcost = item[0]

for next in nexts[id]:

nexts[next].remove(id)

costs[next] -= a[id]

heapq.heappush(pq, (costs[next],next))

nexts.pop(id)

removed[id] = True

print(maxcost)F - Exactly K Steps

この問題、むずかしいと思うのですが、自力で解くことができました。ABC281、ABC268に続いて問題Fを自力で解けたのは3回目です。それが3日以内に急に起きているので、力がついてきたのではないか?とうれしいです。ぼくはグラフ理論における、木の直径という概念を全く知りませんでしたが、この問題においてそれを求めれば良いと気づき、かつ、DFSを2回やれば求められることまで自力でたどり着けました。ABCに初めて参加した3ヶ月半前には考えられなかったようなことです。最長のパスをstem、それ以外をbranchと名付けて処理しました。Uのrootからの距離がK以上の場合は、K代上の先祖、Uがstemにあって最長パスの末端からの距離がK以上の場合は、K代子孫、Uがstemにあって最長パスの末端からの距離がK未満の場合は、なし、Uがbranchにあってbranch root(stem上のbranchの分かれ目)経由で末端までの距離がK以上の場合は、branch rootからK-(branch内距離)子孫、Uがbranchにあってbranch root(stem上のbranchの分かれ目)経由で末端までの距離がK未満の場合は、なし。と場合分けしました。すべての場合について、頂点が存在する場合はn世代上の先祖を求める問題に帰着し、nを2のべき乗に分解してアクセスできるようにしました。かなり複雑になりましたが、ここまで自分で導いてACできたことは、喜びたいと思います。提出時に最初ほとんどのケースでREとなってしまい、調査が難航し、バグ修正に何時間もかかってしまいました。コメントアウトなどして提出を繰り返してREの位置を特定して確認したところ、リストの要素に()でアクセスしており、not callableエラーが発生していたようでした。ローカルではよく起きるミスですが、AtCoderで起きてもエラーメッセージが見れないため、気づくのがかなり大変です。RE発生時のあるあるパターンとして、記憶しておかなければなりません。せっかくこのような難しい問題を自力で解けてうれしいのに、バグ調査に時間がかかって気分が萎え萎えになってしまいました。解説に良い方法が説明されていそうですが、今は読む気が起きません。しかしぼくのこのコード、長いししんどいです。いつかコンテスト時間内にこんなのも書けるときがくるのでしょうか?答えを求めるための処理の流れの方針を決めて紙一枚に書き出し、その方法で処理を組み立てるために必要なデータは何か?ということを抽出し、ようやくコードを書き始めました。苦労して完成したコードでACできるって達成感がありますね。 2022-12-13

import math

N = int(input())

nexts = [[] for _ in range(N)]

for _ in range(N-1):

a, b = map(int, input().split())

nexts[a-1].append(b-1)

nexts[b-1].append(a-1)

root = N // 2 # arbitrary

longest = [root, 0]

used = [False]*N # need for undirected graph

stack = [(root, 0)]

while stack:

cur, dist = stack.pop()

used[cur] = True

if dist > longest[1]:

longest[0] = cur

longest[1] = dist

for next in nexts[cur]:

if not used[next]:

stack.append((next, dist+1))

root = longest[0] # reset root

dists = [-1]*N

# doubling [2^k][v]

max_double = math.floor(math.log2(N))

parents = [[-1]*N for _ in range(max_double + 1)]

longest = [root, 0]

stack = [(root, 0)]

# dfs again

while stack:

cur, dist = stack.pop()

dists[cur] = dist

if dist > longest[1]:

longest[0] = cur

longest[1] = dist

for next in nexts[cur]:

if dists[next] != -1:

# already accessed

continue

parents[0][next] = cur

x = 0

while x < max_double:

if parents[x][parents[x][next]] == -1:

break

parents[x+1][next] = parents[x][parents[x][next]]

x += 1

stack.append((next, dist+1))

cur = longest[0] # this is longest end

used = [False]*N

branch_root = [-1]*N

while cur != root:

used[cur] = True

parent = parents[0][cur]

for next in nexts[cur]:

if used[next] or next == parent:

continue

stack = [next]

while stack:

branch_cur = stack.pop()

# set branch root

branch_root[branch_cur] = cur

used[branch_cur] = True

for branch_next in nexts[branch_cur]:

if not used[branch_next]:

stack.append(branch_next)

cur = parent

def ask_ancestor(v, step):

i = 0

cur = v

while step:

if step % 2 == 1:

cur = parents[i][cur]

step //= 2

i += 1

return cur

Q = int(input())

for _ in range(Q):

u, k = map(int, input().split())

u -= 1

if dists[u] >= k:

print(ask_ancestor(u, k)+1)

else: # dists[u] < k

if branch_root[u] == -1: # u on stem

dist_from_end = longest[1] - dists[u]

if dist_from_end >= k:

print(ask_ancestor(longest[0], dist_from_end-k) + 1)

else:

print(-1)

else: # u on branch

local_root = branch_root[u]

local_root_dist = dists[local_root]

local_dist = dists[u] - local_root_dist

# must < k

dist_on_stem = k - local_dist

dist_from_end = longest[1] - local_root_dist - dist_on_stem

if dist_from_end >= 0:

print(ask_ancestor(longest[0], dist_from_end)+1)

else:

print(-1)G - Increasing K Times

問題Gを初めて自力で解くべく、DPだろうと思ったので、過去にやったDPの問題をすべてふりかえって、ヒントを抽出しました。インスピレーションを得たうえで、しばらくこの問題を考えてみましたが、結局なにもひらめかず、断念しました。解説によると「挿入DP」というようで、見たことがない全く新しい手法でした。それを使って苦労して解きましたが、提出した解答の処理時間は遅めで、TLEを回避するのにも苦労しました。でもなんか、むちゃくちゃ速い解答提出してる人いっぱいいるんですよね。どういう考え方で解いてるんでしょうか?問題Gって、ひらめけば一瞬で解ける問題が結構混じってるんでしょうか?ABC279 Gもそうでした。ABC279 Gは理解できましたが、この問題も理解したいです。 2022-12-15

from collections import defaultdict

M = 998244353

N, K = map(int, input().split())

acount = defaultdict(int)

for a in map(int, input().split()):

acount[a] += 1

# https://atcoder.jp/contests/abc267/submissions/37291675

# 階乗やchooseの処理省略

alist = list(acount.items())

alist.sort(key=lambda x:x[0])

alen = len(alist)

dp = [0]*(K+2)

dp[0] = 1

total = 1 # gap number

shuffle = 1

for i, a_n in enumerate(alist):

ii = i + 1 # ii is idx for a

n = a_n[1]

dp_new = [0]*(K+2)

for j in range(min(K+2, total+1)):

if not dp[j]:

continue

# j -> j + x <= K + 1

for x in range(min(n+1, total-j+1, K+2-j)):

if n-x > n+j-1:

continue

dp_new[j+x] += dp[j] * choose(total-j, x) * choose(n+j-1, n-x)

dp_new[j+x] %= M

dp = dp_new

total += n

shuffle *= fact[n]

shuffle %= M

print(dp[K+1] * shuffle % M)上記の通り、昨日提出したコードが遅いのが気になったので、やり直したところ、なんと、ぼくの提出が一気に最速となりました。速い人が特殊なことをやっていたわけではなく、同じく「挿入DP」ですが、同じ値の数字をまとめて挿入せず、1つずつ挿入しているだけのようです。あまりにもコードの様子が変わるので、すごいことしてるように見えてました。上のコードを提出した時は、まとめて挿入する方が自然だと感じてそのように実装したのですが、1つずつ挿入することによって複雑にならないし、むしろコードがむちゃくちゃシンプルになって速くなりました。Chooseを何度も計算するために、事前に階乗を計算しておくとか、必要なくなり、いいですね。シンプル・イズ・ベストです。やはりコードがシンプルなのは気持ちいいですね。ってまあ、場合によるのでしょうが。また、DPのリストをループの中で作り直していません。数字を挿入したときにAi<Ai+1となる箇所の個数は増えるだけなので、挿入したときにリストの中で影響を受けるインデックスは、より大きなインデックスとなります。より大きなインデックスにしか影響しないのであれば、大きい方から順に計算することで、DPのリストを直接更新することが可能となります。これは、ABC269 Gから学んだことです。DPの高速化では、非常に有効な方法ですね。早速使えてうれしいです。もう1つの高速化ポイントは、DPの状態遷移がi->i+1としたとき、iからi+1の状態を計算するのではなく、i+1の状態を、関係するiから引っ張ってきて計算しています。このことによって、i+1での新しい値が1回の足し算でも止まっています。これもポイントですね。ということで学んだノウハウが生きて、ぼくの提出が現在最速の132mとなりました。昨日の1666msから大幅に改善です。しかし「挿入DP」とはまたクレイジーです。この問題のような並べ替えの場合、左から確定していくと、残りの値を覚えておく必要があって破綻します。それを解決する秩序ある処理順が、小さい順に挿入していく方法だったというわけですね。 2022-12-16

from collections import defaultdict

M = 998244353

N, K = map(int, input().split())

acount = defaultdict(int)

for a in map(int, input().split()):

acount[a] += 1

alist = list(acount.items())

alist.sort(key=lambda x:x[0])

alen = len(alist)

# init

dp = [0]*(K+2)

fact_a0num = 1

for i in range(2, alist[0][1]+1):

fact_a0num = fact_a0num * i % M

dp[1] = fact_a0num

aida = alist[0][1] + 1

for a, n in alist[1:]:

for acount in range(n):

for k in range(min(aida+2, K+1), 0, -1):

dp[k] = (dp[k] * (k+acount) + dp[k-1] * (aida-k+1-acount)) % M

aida += 1

print(dp[K+1])Ex - Odd Sum

数列の並び順は関係なく、どの数字を何個使うかだけ。ということに気づいてプログラミング脳になってきたか?いけるかも。とちょっと期待してランニングしながら頭の中で解き方を考えていたけど、どうしても計算量減らせず断念。解説を見てすげぇと思ったけど、高速フーリエ変換のしくみを思い出せないので一旦保留。高速フーリエ変換を勉強し直して戻ってきたいです。 2022-09-04

1ヶ月かかって高速フーリエ変換を勉強し、戻ってきました。1ヶ月と言ってもコンテストにたまに参加したりすると毎回毎回新しいことが出てきてそれを勉強しなければならず、高速フーリエ変換なんて勉強してるヒマがありませんでした。しかし解けてない問題はずっと気になるので、よしと思って一気にやった感じです。週末こんなのを理解しようとしてたら、久しぶりにとんでもなく頭が疲れたのを感じて、そのあとパワーナップしたら気持ち良すぎました。仕事でこの感覚を味わうことはできないのでいいですね。AtCoderに出てくるどのアルゴリズムを見てもクレイジーだと感じていますが、高速フーリエ変換は群を抜いてクレイジーだと思いました。1ヶ月前に読んで理解した解説を思い出しながら自力で動的計画法の実装をし、畳み込みの部分はmaspy氏のnumpyのfftを使った畳み込みを使い、サンプルに正解できました。サンプル問題で正解が出力された時は脳内物質が出てむちゃくちゃ興奮しました。たぶん、1ヶ月放置してた反動ですね。しかし提出したら実行エラーが発生しました。コードテストでModuleNotFoundError: No module named 'numpy'と出力されたので何かと思ったら、PyPyではnumpyが使えないけど、Pythonでは使えるということらしいです。今まで無意識にPyPy使ってました。PyPyは速いらしいので、numpyを取るかPyPyを取るかみたいな選択をせまられるんですね。 2022-10-02

ようやく正解できました。maspy氏のnumpyのfftを使った畳み込み、確かにconvolve2を使わないと不正解になっちゃいますね。最後ギリギリのところでの速度改善をしていて、大変でした。といっても今回numpyをはじめて使い、全く詳しくなかったので無駄に標準のlistを作ってからnumpyのarrayに変換したりしてたのをやめたら結構改善しました。combination計算のために階乗と階乗の逆元を事前に計算しておくところは、解説を参考にしましたが、逆元を1回しか計算しないのは効率的ですね。階乗計算のnはちゃんと一番多い数字の個数までしか計算しないようにしました。高速フーリエ変換をする時は、できるだけ係数のリストが小さくなるように、i*(iの個数)と、Mの小さい方の値までとしました。最後の最後でTLEがあと7つのテストケースとなったところで、入れた改善は、1から10まで順に計算するのではなく、i*(iの個数)が小さい順に計算するようにしたことです。畳み込みのたびにどんどんリストは大きくなるはずなので、できるだけ小さい状態を維持するには、係数リストが小さい順に計算したほうがよいはずです。この修正で十分速くなる保証はなかったですが、なんと、残りの7つのテストケースも間に合うことに成功しました。解説のC++コードが全く気にしていないところに気を使ってギリギリAC、やったぜ!って感じです。Pythonでの正解はぼくが11人目でしたが、ぼく以外全員PyPyでした。 2022-10-08

# fftコード省略

mod = 998244353

n, m = map(int, input().split())

from collections import Counter

counter = Counter(map(int, input().split()))

count_max = counter.most_common(1)[0][1]

# https://atcoder.jp/contests/abc267/submissions/35459588

# 階乗やchooseは省略

odd_prev = np.array([])

even_prev = np.array([])

is_first = True

counter_list = list(counter.items())

counter_list.sort(key=lambda x: (x[0]*x[1]))

for i, num in counter_list:

coef_maxidx = min(i*num, m)

odd_cur = np.zeros(coef_maxidx+1, dtype=np.int64)

even_cur = np.zeros(coef_maxidx+1, dtype=np.int64)

sum = 0

even_cur[0] = 1

is_even = False

for n in range(1, num+1):

sum += i # iをn個

if sum > coef_maxidx:

break

if is_even:

even_cur[sum] = choose(num, n) % mod

is_even = False

else:

odd_cur[sum] = choose(num, n) % mod

is_even = True

if is_first:

odd_prev = odd_cur

even_prev = even_cur

is_first = False

else:

new0 = convolve2(odd_prev, even_cur, mod) \

+ convolve2(even_prev, odd_cur, mod)

new1 = convolve2(odd_prev, odd_cur, mod) \

+ convolve2(even_prev, even_cur, mod)

odd_prev = new0[:m+1] if new0.size > m+1 else new0

even_prev = new1[:m+1] if new1.size > m+1 else new1

if odd_prev.size >= m+1:

print(odd_prev[m] % mod)

else:

print(0)AtCoder Beginner Contest 268

他にやることがあってリアルタイム参加はあきらめました。翌日、ワイン1杯飲んでましたが、バーチャル参加しました。時間内にはA、B、Cだけ解けました。Cが結構むずかしいと感じ、Cを解いた時点で35分くらいでした。それでも1時間以上残っているのでなんとか目標の4問を目指しましたが、D、Eがどちらもむずかしく、4問正解なりませんでした。過去問を6問やって解けるのも増えてきたかなと感じてましたがまだまだダメでした。D、Eの解説をみてやりましたが、実際むずかしかったです。

D - Unique Username

Tと一致しないことを短時間で判定できればよい。あとはこの条件に従ってユーザー名を生成したときにどれくらい作られるのか?ということが気になります。多すぎると処理が終わりません。まさにそれが解説に書かれていました。十分少ないとのこと。そして計算しなくてもプログラムを動かしてカウントしてみても良いと書かれていました。これは役に立つノウハウです。ぼくが、この問題を解けなかった原因は他にあり、そもそもどのようにユーザー名の候補を生成すればよいかで行き詰まってました。Xの文字数が3以上16以下ということで'_'を使う数に幅があり、それをどうあつかえばよいかわからず、行き詰まりました。不覚です。16文字ギリギリまで用意しておいて、右端の'_'列だけ捨てれば良いとのこと。これは気づけなかったのが悔しい。まあ'_'の数でループしても良いですが、頭疲れてます。そこまでわかれば、解けます。あとはユーザー名が3文字以上という条件を入れないと不正解になってしまうテストケースもあったので要注意でした。 2022-09-12

import sys

from itertools import permutations

from itertools import combinations

n, m = map(int, input().split())

ss = [input() for _ in range(n)]

ts = {input() for _ in range(m)}

s_all_len = len(''.join(ss))

us_split_point_num = 16 - s_all_len

for s_per in permutations(ss):

for us_split_combi in combinations(range(us_split_point_num), n-1):

us_lens = []

id_cur = -1

for id_temp in us_split_combi:

us_lens.append(id_temp - id_cur)

id_cur = id_temp

res = ''

for i in range(n-1):

res += s_per[i]

res += '_'*us_lens[i]

res += s_per[n-1]

if res not in ts and len(res) >= 3:

print(res)

sys.exit()

print(-1)E - Chinese Restaurant (Three-Star Version)

頭の中にギザギザの不満度グラフがn個思い浮かんでいましたが、これをどう処理すればO(N^2)より小さくできるのかさっぱりわからず、公式解説を見ました。「いもす法」を使うと書かれていました。すべての場所で全データ処理しなくても、変化するところだけ覚えておいて、あとで走査すればO(N)で処理できるというものです。大事です。この問題のすごいところは、1次関数の次数ごとに「いもす法」を使うというところでした。クレイジーです。そこまでわかったとしても、同じ人の不満度を表す1次関数が範囲ごとに変化しギザギザになるので、それを正確に表現するのがむずかしく感じました。nが偶数だったら、nが奇数だったら、など考えました。実際最初バグっていて、1つだけ不正解が出て、整理し直してなんとか正解できました。今の実力で、時間内にこれを正解できる気はしません。むちゃくちゃ大変だと感じました。それにしても明らかにロジックに誤りがあるのに、1つを除いて正解になってしまったのは驚きました。この1つがなかったらバグを見つけられなかったと思うと、06_corner_03.txtはナイステストケースです。 2022-09-12

n = int(input())

ps = [p for p in map(int, input().split())]

imosu = [[0]*2 for _ in range(n)]

c = [[0]*2 for _ in range(n)]

for i, p in enumerate(ps):

t = (p-i) % n

if t < int(n/2):

imosu[0][1] += -1

imosu[0][0] += t

imosu[t][1] += 2

imosu[t][0] -= 2*t

imosu[t+int((n-1)/2)+1][1] -= 2

imosu[t+int((n-1)/2)+1][0] += (2*t + n)

else:

imosu[0][1] += 1

imosu[0][0] += (-t + n)

imosu[t-int(n/2)][1] -= 2

imosu[t-int(n/2)][0] += (2*t - n)

imosu[t][1] += 2

imosu[t][0] -= 2*t

c[0][1] = imosu[0][1]

c[0][0] = imosu[0][0]

for x in range(1, n):

c[x][1] = c[x-1][1] + imosu[x][1]

c[x][0] = c[x-1][0] + imosu[x][0]

min = 10**11

for x in range(n):

cur = x*c[x][1] + c[x][0]

if cur < min:

min = cur

print(min)F - Best Concatenation

遡って解くぞシリーズ。この問題は自力で解くことができ、ABC281 Fに続いて2つ目の自力で解けた問題Fとなりました。ABC281は先週土曜日に開催され、今日は火曜日です。そして実はABC267 Fも、難しかったと思いますが、この問題のあとで自力で解けました。問題Fを初めて自力で解いてから、急に3日で3問、自力で解けたことになります。急に力がついたんでしょうか?うれしいです。この問題の考え方は、まず数字だけの文字列がXの前にあってもスコアになりませんから、全部まとめて後ろだなーと気づきました。よって、Xを含む文字列の順序だけ考えればよいとわかります。数字の区別は必要でしょうか?数字がそのままスコアになるので、区別せずに、全部足して考えればよいと気づけます。i番目とj番目の文字列のどちらを前に持ってこればよいでしょうか?i番目が前の場合と、j番目が前の場合、それぞれスコアを計算して大きくなる方の順序にすればよいです。Xの個数をnXi、nXjとし、数字の合計をFi、Fjとすると、スコアは、iが前の場合nXi*Fj、jが前の場合、nXj*Fiとなります。iを前にした方が良くなる、nXi*Fj > nXj*Fiを変形してFj/nXj > Fi/nXiということがわかり、F/nXでソートした順序が正解であることがわかります。最初に述べたように、nXが0のときは全部後ろでよいので、ソートのキーを最大値にしておきます。それぞれの文字列の中でもXの後ろに数字があればスコアになりますので、それも加えて答えを出力すればよいです。よし!解けるぞ! 2022-12-13

N = int(input())

ans = 0

# X count, fugure sum

ss = [[0,0] for _ in range(N)]

for i in range(N):

s = input()

n_X = 0

sum_fig = 0

for c in s:

if c == 'X':

n_X += 1

else:

fig = int(c)

ans += fig * n_X

sum_fig += fig

ss[i][0] = n_X

ss[i][1] = sum_fig

ss.sort(key=lambda x:10**7 if x[0] == 0 else x[1]/x[0])

n_X = 0

for item in ss:

ans += n_X * item[1]

n_X += item[0]

print(ans)G - Random Student ID

解説を読むだけの仕事になってしまってますが、時間を区切って解説を見ることにしないと体が持ちません。ていうかもう持ってないです。学籍番号の期待値を計算するということで、計算方法が全く検討つかなかったわけですが、解説によると、iさんの学籍番号の期待値を計算するには、jさんの名前がiさんの名前の接頭辞ならjさんは確実に前にいるので+1、iさんの名前がjさんの名前の接頭辞なら確実に後ろにいるので0、それ以外は1/2で計算すると。クレイジーです。期待値ってこうやって計算するんだということにまず驚き、そしてiさんとjさんの名前の何文字目かが異なる場合は前か後ろかの確率が1/2っていうのも驚きです。そして、トライ木(Trie)という構造を使うと、お互いに接頭辞になる人の人数を高速で数えられると書いてありましたので、素直に実装しました。ようやく提出したら、005.txtと015.txtだけ実行時エラー。同じ結果になってる人もいてなんだろうと思ったのですが、長い名前のテストケースを作って実行してみたら「RecursionError: maximum recursion depth exceeded」が発生し、原因がわかりました。深くなる再帰関数を使わないでおこうと思ってstackとかqueueを使ってたのですが、あきらめて、sys.setrecursionlimit(10**6)としました。これで無事正解です。ところで再帰回数が限界を超えたのはTrie.addです。別オブジェクトを作ってから呼んでるので、RecursionErrorが発生するまで、ぼくは再帰関数と認識していませんでした。Pythonってオブジェクトは引数のselfなんですよね。つまりオブジェクトを関数に渡して呼んでるだけなのでTrie.addを再帰的に呼び出していることになるという気づきが得られました。この問題では、有理数の答えをmod 998244353で出力するということで、これも厄介な話で、分子に分母の逆元(フェルマーの小定理により分母のm-2乘)をかけるとのこと。 2022-09-13

import sys

from collections import deque

sys.setrecursionlimit(10**6)

class Trie():

def __init__(self, c='', parent=None):

self.c = c

self.parent = parent

self.children = {}

self.name = ''

self.anc_num = 0

self.desc_num = 0

self.visited = False # for dfs

def add(self, idx, name):

if not self.c:

if name[0] not in self.children:

self.children[name[0]] = Trie(name[0], self)

self.children[name[0]].add(0, name)

elif idx == len(name) - 1:

self.name = name

else:

if name[idx+1] not in self.children:

self.children[name[idx+1]] = Trie(name[idx+1], self)

self.children[name[idx+1]].add(idx+1, name)

m = 998244353

inv = pow(2, m-2, m)

n = int(input())

root = Trie()

ss = {} # s and answer

for i in range(n):

s = input()

ss[s] = 0

root.add(0, s)

s = deque([])

s.append(root)

while s:

trie = s.pop()

if not trie.visited:

trie.visited = True

s.append(trie)

for child in trie.children.values():

child.anc_num = trie.anc_num

if trie.name:

child.anc_num += 1

s.append(child)

else:

if trie.name:

ss[trie.name] = ((1 + trie.anc_num - trie.desc_num + n) * inv) % m

if trie.parent:

trie.parent.desc_num += trie.desc_num

if trie.name:

trie.parent.desc_num += 1

for res in ss.values():

print(res)Ex - Taboo

Sを1文字目から順番に調べていき、Tが見つかったらその終端位置を覚える。その終端位置の中で一番手前のものを*に変える。という考え方でいけそうです。問題Gで覚えたばかりのトライ木で、最初に見つかるTの終端位置を見つけ、プライオリティキューに入れていけば一番手前をすぐに取り出せます。どう考えても計算量に無理がありますが、無駄な処理はいろいろ減らせるのでとりあえずやってみました。そして、不正解と時間切れになったのを確認して迷わず解説へ。公式解説のSuffix Arrayというクレイジーなアイデアに驚きつつ、SA-IS法がマジでわけがわからない(といいつつDNAとかの研究でも使うらしくむちゃくちゃ大事、O(N)でSuffix Arrayが作れるらしい)ので、別の方法を見ていると、エイホ–コラシック法(Aho-Corasick)というので解けるらしいと知りました。これはトライ木を発展させたものであり、大変わかりやすいです。Aho-Corasickは、トライ木の各ノードがSuffixが最も長く一致するノードへのリンクを持っている構造です。これを使うと、Sの文字を1文字進めるごとに最初からTと一致しているか調べ直さなくても、トライ木の途中から始まっているTもいっしょに調べることができてしまいます。Aho-Corasickは、トライ木のルートから幅優先で走査して生成できます。苦労してACしました。他の人よりメモリ使用量が多いのが解せません。 2022-09-18

import sys

sys.setrecursionlimit(10**6)

class Aho():

def __init__(self, c=''):

self.c = c # c is '' only when this is root

self.children = {}

self.is_word = False

self.link = None

def add(self, s, idx):

if not self.c: # root

if s[0] not in self.children:

self.children[s[0]] = Aho(s[0])

self.children[s[0]].add(s, 0)

elif idx == len(s)-1:

self.is_word = True

else: # len(s) > 1

if s[idx+1] not in self.children:

self.children[s[idx+1]] = Aho(s[idx+1])

self.children[s[idx+1]].add(s, idx+1)

from collections import deque

s = input()

n = int(input())

root = Aho()

for _ in range(n):

t = input()

root.add(t, 0)

q = deque([])

for rootchild in root.children.values():

rootchild.link = root

q.append(rootchild)

while q:

node = q.popleft()

cs = set(node.children)

linkcand = node.link

while cs:

clist = list(cs)

for c in clist:

if c in linkcand.children:

node.children[c].link = linkcand.children[c]

if not node.children[c].is_word:

node.children[c].is_word = linkcand.children[c].is_word

cs.remove(c)

elif linkcand == root:

node.children[c].link = root

cs.remove(c)

linkcand = linkcand.link

q.extend(node.children.values())

i = 0

count = 0

aho = root

while True:

if i == len(s):

break

if s[i] in aho.children:

aho = aho.children[s[i]]

if aho.is_word:

count += 1

aho = root

else:

while aho.c:

aho = aho.link

if s[i] in aho.children:

aho = aho.children[s[i]]

if aho.is_word:

count += 1

aho = root

break

i += 1

print(count)AtCoder Beginner Contest 269

ABC268 Exが解けていなかったので、参加していません。その前のABC267 Exもまだ時間がかかりそうで、これ以上解けてない問題が増えるのは精神的にきついです。仕事もありつつ、Exの問題は1週間で理解できるレベルではないので、参加するエネルギーないです。その後日曜日にABC268 Exがなんとか解けたので、懲りずにABC269の問題を見てしまう。しんどいです。ググる回数が減るように、使った機能の復習はざっとした方が良さそうです。

B - Rectangle Detection

PyPyって文字列扱うのやたら遅いのでしょうか?なぜかPython勢もPyPyではなく、普通のPythonを使っている人が多く、その人達が実行速度上位でした。ムカついたので、C言語でテキトーに書いて2msにしました。1msは無理でしょうか。 2023-01-25

C - Submask

2022-09-19

n = int(input())

ans = [0]

while n:

smallest = n & -n

new = [i + smallest for i in ans]

ans.extend(new)

n -= smallest

for i in ans:

print(i)D - Do use hexagon grid

こういう連結成分の個数を出力する問題あるよなぁと思いながら、やったことがなかったです。ちょっと遠回りな感じもしますが、とりあえず隣同士のものを最初に見つけておいてから、幅優先でたどって全部のグリッドを見ればよいでしょうか?x, y, x-yの値が全部+-1の範囲にあるものが隣なので、そのように実装しました。最初bisectを使って-1から1の範囲を取り出していましたが、自分の環境では動くのに、AtCoderの環境では全テストケース実行エラーとなってしまいました。何かと思ったら、bisect.bisect()の引数のkeyを使っており、これはPython 3.10で追加されたので、AtCoderではまだ使えないようです。bisectなど使わず、座標の辞書を作ってもいけそうだったので、書き直して正解しました。 2022-09-19

from collections import defaultdict

from collections import deque

n = int(input())

nexts = {}

grids = []

c_dict = [defaultdict(set), defaultdict(set), defaultdict(set)]

for i in range(n):

x, y = map(int, input().split())

grids.append((x, y, x-y))

c_dict[0][x].add(i)

c_dict[1][y].add(i)

c_dict[2][x-y].add(i)

for i in range(n):

nextset = set()

for dir in range(3):

c = grids[i][dir]

if dir == 0:

nextset = c_dict[dir][c-1] | c_dict[dir][c] | c_dict[dir][c+1]

else:

nextset &= c_dict[dir][c-1] | c_dict[dir][c] | c_dict[dir][c+1]

nextset.remove(i)

nexts[i] = nextset

s = set(range(n))

count = 0

while s:

count += 1

q = deque([])

x = s.pop()

q.append(x)

while q:

cur = q.pop()

for next in nexts[cur]:

if next in s:

s.remove(next)

q.append(next)

print(count)E - Last Rook

遡って解いていこうシリーズ。インタラクティブな問題は、Grundy数を使ってゲームに勝つ問題だったABC278 G以来、2回目です。今回は自力でいけました。が、i方向で絞り込んだ値をそのままj方向を調べるときにも使ってしまい、1ペナしてしまいました。1辺が1000なので、2^10より小さく、行列合計20回の2分探索で見つけることができ、質問回数の上限に設定されています。他の人より妙に遅いのが気になります。コードに違いがあるようには見えないのですが。 2022-12-10

N = int(input())

imin = 1

imax = N

while imin < imax:

imid = (imin+imax) // 2

print('?', imin, imid, 1, N, flush=True)

T = int(input())

if T < imid - imin + 1:

imax = imid

else:

imin = imid + 1

# imin = imax

jmin = 1

jmax = N

while jmin < jmax:

jmid = (jmin+jmax) // 2

print('?', 1, N, jmin, jmid, flush=True)

T = int(input())

if T < jmid - jmin + 1:

jmax = jmid

else:

jmin = jmid + 1

# jmin = jmax

print('!', imin, jmin)F

めんどうなので、スキップ。 2022-12-11

G - Reversible Cards 2

問題Gを自力で解きたいと思ってやってますが、達成できず。これは相当難しかったです。そして非常に勉強になりました。いつものようにシンプルな問題ですが、公式解説にいろいろ書いてあって深いです。愚直に自分なりにDPをやるとこのようになりました。b-aの絶対値が同じものをまとめておき、負数の場合はマイナス回裏返すというように考えて、まとめて処理しています。この実装ではDPのリストをループ中で作り直しているので、b-aの絶対値が同じものに関しては、DPのリストの作り直し1回で済ませており、そこが高速化ポイントになっていると思ったのですが、これはTLEx8です。

解説の実装例を見ると、DPのリストを作り直していないんですよね。1つのリストを更新し続けて処理しています。これがものすごく不思議に見えました。ぼくは、カードの合計値のループの中で、裏返す回数のループを回していた上に、減るときをマイナス回にしてまとめて処理してたので、DPリストを作り直すしかないと思っていたんです。でも解説では、裏返す回数のループの内側で、カードの合計値のループを回し、かつ、裏返して合計値が増えるパターンのときはreverseした順序でループを回すことで、DPリストの作り直しが不要となっていました。リスト1つでも、処理順を工夫することで、排他的に実行しなければならないDPの更新処理が、互いに影響しないようにできるということです。それだけではなく、c増える操作をn回やる場合の処理を驚くべき方法で、高速化していました。自然数nをこのように分解していました。このループでnを分解したmの組み合わせで、1からnまでの自然数をすべて生成できることは、考えればわかります。n回裏返す処理が、log(N)回裏返す処理の組み合わせで表現できてしまいます。

x = 1

while n:

m = min(n, x)

# do something

n -= m

x *= 2最終的なぼくのコードは、いろいろとがんばってこれで、1209msになりました。が、まだまだ速いコードが複数提出されています。中身を見ても何が違うんだかさっぱりわかりません。処理速度の違い、なぞなことが多いんですよねぇ。解説には|b-a|の種類が高々√M程度であることが、示されています。√M個の数字を小さい順にびっしり詰めると、1,2,3,4,…,√Mとなりますが、すべて加えると(√M(√M+1))/2です。負数も加えるとMを超えます。しかしΣb+Σa=Mであることから、Σ|b-a|は、明らかにM以下ですので、√M個 小さい順に詰めてもMを超えてしまうのであれば、|b-a|の種類は√M種類より小さくなければならないとわかります。つまり、Nが大きければb-aが同じものが大量に発生するので、今回のような高速化が可能です。入れ子ループのどちらを内側にするのかによって、自然数を分解した今回の高速化が可能になることや、ループの順序を工夫することでDPのリストは作り直す必要がなくなることなど、クレイジーな学びのある問題でした。あ、解説でreversed(range(l,r+1))というような書き方がされていましたが、range(r,l-1,-1)とした方が効率的なようです。 2022-12-12

import sys

input = sys.stdin.readline

from collections import defaultdict

N, M = map(int, input().split())

INF = N + 1

suma = 0

sub_count = defaultdict(int)

for _ in range(N):

a, b = map(int, input().split())

suma += a

c = b - a

if c != 0: # skip 0

sub_count[c] += 1

dp = [INF]*(M+1)

dp[suma] = 0

l = r = suma

sub_ordered = list(sub_count.items())

sub_ordered.sort(key=lambda x:abs(x[0]*x[1]))

for sub, n in sub_ordered:

x = 1

while n:

m = min(n, x) # m step at once

for k in (range(r, l-1, -1) if sub > 0 else range(l, r+1)):

if dp[k] == INF:

continue

k_ = k + sub * m

dp[k_] = min(dp[k_], dp[k] + m)

if sub > 0:

r = r + sub * m

else:

l = l + sub * m

n -= m

x *= 2

for k in range(M+1):

print(-1 if dp[k] == INF else dp[k])Ex

理解するのきつそう。FFTはまた出てきたけどそれ以外のところ。 2022-09-19

AtCoder Beginner Contest 270

4問正解を目指して過去問などもやっていますが、基礎的なことを勉強していないせいで解説を読むたびに毎回度肝を抜かれ、ネットなどで調べて勉強しようとし、精神的にしんどいです。みんな基礎的な知識を身につけてやっているようで、どうやって身につけているんだろう?と調べてみると、蟻本に知りたかったことがいろいろ書かれていそうと気づきました。そこで今は蟻本を読み始めています。蟻本、問題に関連するアルゴリズムなど、気になったところを読めばいいと思ってましたが、全部読んだほうが良さそうです。いろいろと解けてない問題を抱えていてしんどいですが、そんなこと言ってたら永久に参加できないので今回のABCは参加しました。Cまでで1時間かかりました。Cのような、いかにも基本的な問題でも0から考えてる感じで時間がかかります。とはいえ、あと40分もあります。しかしDはまんまと引っかかって貪欲でいってしまい、正解できませんでした。むずかしいです。

C - Simple path

グラフの初級編のところを今蟻本で読んでるんですが、むずかしいです。この問題はいかにも基本って感じがしますが、ぼくにとっては0から考えてる感じでしんどいす。隣接リストを作り、そこから1を根とした木(各頂点の親と深さをメモ)を作り、xとyからLCA(Lowest Common Ancestor)まで親をたどっていきました。良いやり方なのかはわかりません。LCAに関連するアルゴリズムは今勉強したいと思っていることの1つで、この問題に関しては複雑なことをせずに解けましたが、気になっていることがいろいろあります。あと、この問題ではjoinで数値のlistを文字列化しようとしたときに失敗して手こずりました。strにしてからjoinしないといけないようです。' '.join([str(n) for n in [3,4,5]])。と思ったらリストを引数にアンパックして渡せるので、print(*l)でいいらしい。解説に書いてあったんですが、yを根にすればxから登っていくだけでよかったのか。なるほど! 2022-09-24

from collections import defaultdict

from collections import deque

n, x, y = map(int, input().split())

par = [0 for _ in range(n+1)] # 0,1,2,..,n

depth = [-1 for _ in range(n+1)]

nexts = defaultdict(set)

for _ in range(n-1):

u, v = map(int, input().split())

nexts[u].add(v)

nexts[v].add(u)

q = deque([])

q.append(1)

par[1] = 1 # root

depth[1] = 0

while q:

cur = q.popleft()

depth_cur = depth[cur]

par_cur = par[cur]

for c in nexts[cur]:

if par[c] != 0:

continue

depth[c] = depth_cur + 1

par[c] = cur

q.append(c)

xline = [x]

yline = [y]

while True:

if depth[x] > depth[y]:

x = par[x]

xline.append(x)

else:

y = par[y]

yline.append(y)

if x == y:

yline.pop(-1)

yline.reverse()

xline.extend(yline)

print(*xline)

breakD - Stones

正解できませんでした。4問正解ならず。解説にこのように書いてあります。「「各手番で石を取れるだけ取る」という貪欲法で解くことはできません」反例を思いつかず、ひっかかりました。最初に提出したコードはこれです。半分のテストケースで不正解となりました。Sampleのテストケースでは気づけないようになっていたので厳しく、むずかしいです。

正しくはこのように動的計画法で解くとのことです。この感覚がまだ身についておらず、不思議な感じが抜けません。dp[n]はn個から始めて先手が取れる個数。その時後手の取れる個数はn - dp[n]。よって、先手が取れるのは、max(Ai + (n-Ai) - dp[n-Ai]) = max(n - dp[n-Ai])となる。0からnまで計算していく。 2022-09-24

n, k = map(int, input().split())

alist = []

for a in map(int, input().split()):

alist.append(a)

dp = [0]*(n+1)

for i in range(n+1):

for j in range(k):

if alist[j] > i:

break

dp[i] = max(dp[i], i - dp[i-alist[j]])

print(dp[n])E - Apple Baskets on Circle

これは特殊なことが不要で、愚直に回転数を重ねていくだけで正解できました。Dを飛ばしてこれを解いたほうが良かったようです。ただ、処理の流れを整理するのは苦労したので、短時間で整理できるように訓練が必要だと感じました。解説ではm回転したときの食べた個数をΣmin(a,m)で計算し、kになるところを2分探索していて勉強になりました。 2022-09-25

n, k = map(int, input().split())

alist = []

a_nonzero = []

for a in map(int, input().split()):

alist.append(a)

if a != 0:

a_nonzero.append(a)

a_nonzero.sort()

i = 0

rot = 0

basket_num = len(a_nonzero)

a_prev = 0

while True:

a = a_nonzero[i]

if (a - a_prev) * basket_num >= k:

rot += int(k / basket_num)

amari = k % basket_num

break

k -= (a - a_prev) * basket_num # k > 0

rot = a

a_prev = a

while a == a_nonzero[i]:

i += 1

basket_num = len(a_nonzero) - i

for i in range(len(alist)):

alist[i] -= rot

if alist[i] <= 0:

alist[i] = 0

elif amari:

alist[i] -= 1

amari -= 1

print(*alist)復習なう。2分探索でやってみました。1回でACできて良かったですが、2分探索に慣れてないせいか、ループの終了条件がこれでいいのか?ちょっと悩んでしまいました。処理時間遅めです。 2023-01-05

F - Transportation

最小全域木の問題っぽい、ですが道路だけでなく、空港と港の建設によってつなぐこともできるため、解き方の見当がつきません。解説を読むと、空というノードを考え、空港建設のコストを、島と空をつなぐ道路のコストと考えればよいと書いてありました。港の場合は海をノードと捉えるのです。最初から空をノードにして最小全域木を作ってしまうと、必ず空港を建設するのが前提になってしまいますから、道路のみの場合と、空だけを追加する場合と、海だけを追加する場合と、空と海を両方追加する場合の4通りで最小全域木を計算し、一番コストが小さいものを回答すればよいです。またまた発想がクレイジー過ぎます。しかしこれを読むだけで、あー解けるなと思えるすごいトリックです。最小全域木はクラスカル法を使って解きます。新たに追加するエッジの両端ノードがすでに作られた木を通してつながっているかどうかは、Union-Findを使って判定します。このあたりは蟻本を見ながらUnionクラスとして実装しました。ノードの最大インデックス+1で初期化しているのでこれが無駄にでかくなると嫌ですが、まあ今後も使えると思います。この問題は道路だけですべての島をカバーできる前提ではないので、道路の最小全域木を求めても、答えになっていない場合が半分以上あるので注意が必要です。 2022-11-04

class Union():

# 省略

n, m = map(int, input().split())

aircosts = [(x, i, n) for i, x in enumerate(map(int, input().split()))]

portcosts = [(y, i, n+1) for i, y in enumerate(map(int, input().split()))]

roads = []

road_cover = set()

for _ in range(m):

a, b, z = map(int, input().split())

roads.append((z, a-1, b-1))

road_cover.add(a)

road_cover.add(b)

# sky

es = roads + aircosts

es.sort(key=lambda x: x[0])

u = Union(n+1)

res = 0

for e in es:

if not u.same_tree(e[1], e[2]):

u.unite(e[1], e[2])

res += e[0]

# sea

es = roads + portcosts

es.sort(key=lambda x: x[0])

u = Union(n+2)

cost_cur = 0

for e in es:

if not u.same_tree(e[1], e[2]):

u.unite(e[1], e[2])

cost_cur += e[0]

if cost_cur < res:

res = cost_cur

# sky and sea

es = roads + aircosts + portcosts

es.sort(key=lambda x: x[0])

u = Union(n+2)

cost_cur = 0

for e in es:

if not u.same_tree(e[1], e[2]):

u.unite(e[1], e[2])

cost_cur += e[0]

if cost_cur < res:

res = cost_cur

# when roads cover all islands

if len(road_cover) == n:

roads.sort(key=lambda x: x[0])

u = Union(n)

cost_cur = 0

for e in roads:

if not u.same_tree(e[1], e[2]):

u.unite(e[1], e[2])

cost_cur += e[0]

if cost_cur < res:

res = cost_cur

print(res)G - Sequence in mod P

遡ってGまで解くぞシリーズ!また新しい、あたおかな武器を手に入れてしまった。「Baby-step Giant-step」という。例によって自力で解こうとして、取りうる値は高々P個だからループするなぁ、そのループの中にGが含まれているのか?どうなのか?という問題だなぁ、一般項は求められるなぁ、などと考え行き詰まり、何か使える情報はないかと、ググって整数論の定理の記事などを苦しみながら読んでも、解決には結びつきませんでした。「Baby-step Giant-step」!いやぁクレイジーですね。理解して問題に適用するのに苦労しました。Wikipediaに書いてある例のように、Pがバカでかいときに、A^x≡B (mod P)となるxを求めるテクニックのようです。mを√P以上の数とします。x=im+jとすると、0<=i,j<mとすれば、xで0からP-1までカバーできます。A^j≡B(A^-m)^iと変形できます。A^jをj=0からmまで計算しておきます。A^-mを計算し、(A^-m)^iを、iを0からmまで変化させて計算します。先程計算したA^jの中のどれかと一致すれば、見つかったことになります。これまた、なんでこれで速くなってるの?とすごく不思議です。なぜか、ちょっと「半分全列挙」を思い出します。この離散対数問題を解く方法を見ると、A^-mを計算できていますが、この問題では逆関数m回の処理を計算していません。どう計算すればよいかも、よくわかりません。「Baby-step Giant-step」は、この問題のようなループする数列に対して適用できます。Baby-stepは数列を1歩ずつ進むことです。Giant-stepはm歩進むことです。Giant-stepでmずつm歩進むと、Baby-stepで0からm-1まで1歩ずつ進んだとき通った場所に、必ず当たるという性質を利用しています。√Pというのはどこから出てきたのか考えてみます。mは√Pでなくても、Babyでm歩、GiantでP/m歩歩けば同じ性質が得られます。BabyとGiantの歩数の合計であるm+P/mを最小化しようと思うと、m=√Pが導かれますので、そのような理由で√Pが採用されているのだと思います。この問題ではXi=S*A^i+B*(A^i-1)/(A-1)ですので、Giant-stepであるXmを直接計算することができます。あとはS=GやA=1やB=0のときを特別扱いする必要があって注意が必要でした。エグいです。最近の目標は、問題Gを自力で解くことになってますが、なかなか実現できません。 2022-12-09

import math

T = int(input())

for _ in range(T):

P, A, B, S, G = map(int, input().split())

if G == S:

print(0)

continue

if A == 0:

print(1 if G == B else -1)

continue

if A == 1:

if B == 0:

print(-1)

else:

print((G - S) * pow(B, P-2, P) % P)

continue

giant = math.ceil(P**0.5)

cur = G

babies = {cur:0}

for i in range(1, giant):

cur = (A * cur + B) % P

babies[cur] = i # set biggest ok

A_giant = pow(A, giant, P)

A_giants = A_giant

A_inv_1 = pow(A-1, P-2, P)

for i in range(1, giant+1):

val = (A_giants * S + (A_giants-1) * A_inv_1 * B) % P

if val in babies:

print(i*giant - babies[val])

break

A_giants *= A_giant

A_giants %= P

else:

print(-1)AtCoder Beginner Contest 271

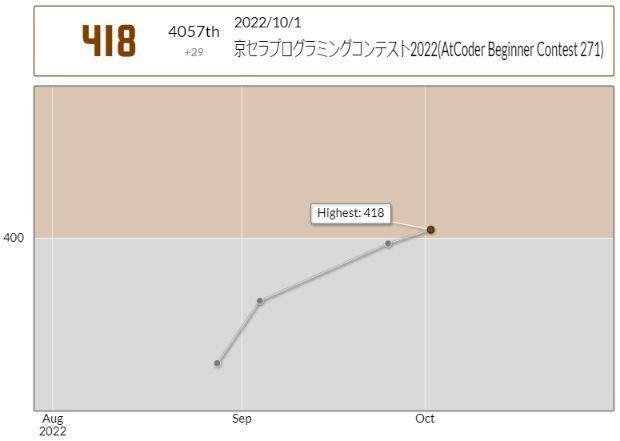

Cでハマって過去最低の2問正解で終了し、無理かと思いましたが、入茶しました!。しかし、勉強続けてるのに点数が右肩下がりで納得いきません。

C - Manga

時間中、なんとか正解したいと粘りましたが解けず、ついに過去最低の2問正解で終わってしまいました。解説によるとx冊読めるかどうか簡単に計算できるので、2分探索すればよいと。問題がかなりシンプルに整理されて素晴らしいです。サンプル問題で「高橋君は同じ巻を 2 冊以上持っているかもしれません。」と書いてあり、いじわるだと思いましたが、高橋君が持ってる巻の数列が単調増加じゃないテストケースもありそうです。(たぶん。)だとするとユニークな巻を取り出すにはsetを使わなければならないので、問題を整理しきれてないから解けないんだとがんばっていたのに、これはさすがに悪意が強く、ひどい引っかけだと感じました。考えても意味がないことで時間を無駄にしたくないです。2分探索のコードは、はじめて書きましたが、自力で書いたら解説と同じになっていて良かったです。Pythonで、/で整数の割り算をするとfloatになってしまうことに気づいていたので、これまでint(n/2)というような書き方をしていましたが、切り捨て除算が別に用意されており、n//2と書けることを初めて学びました。 2022-10-01

n = int(input())

a_set = set(map(int, input().split()))

def can_read(x):

global n

i = len(set(range(1, x+1)) & a_set)

return i + (n-i) // 2 >= x

l = 0

r = n+1

while r > l + 1:

x = (l+r) // 2

if can_read(x):

l = x

else:

r = x

print(l)上に書いた、高橋君が持っている巻の数列が単調増加じゃない引っかけテストケースを考慮し、ソートを1回入れたら最初の方針で正解できました。同じ巻を複数冊持っている場合はどんどん後ろに回し、持ってない巻があれば後ろから売って埋め合わせていくという割と愚直な方法です。1回目のsortを実行しないと、02_srnd_03、02_srnd_04、03_rnd_00、03_rnd_01、03_rnd_02、03_rnd_03のテストケースで不正解となりました。問題の条件を見れば単調増加じゃない可能性があることはわかるのですが、そこで引っかけても参加者にとって勉強にならないので、できればやめて欲しいです。笑。上の2分探索コードは892ms、このコードは179msで処理が終わりました。 2022-10-01

復習なうです。今のところこのコンテストが唯一の2完ですが、この問題C確かにむずかしいですね。やっかいなので2完も納得です。もう一度やってみたらこうなりました。2分探索おもしろいけど、自然に考えたらこうなりますよね。 2023-01-06

N = int(input())

alist = list(map(int, input().split()))

alist.sort()

amari = 0

auniq = [alist[0]]

for i in range(1, N):

if alist[i] == alist[i-1]:

amari += 1

else:

auniq.append(alist[i])

auniq.extend([-1]*amari)

book = 1

i = 0

while i < N:

if auniq[i] != book: # need to sell

if N - i >= 2:

N -= 2

book += 1

else: # not enough

break

else:

book += 1

i += 1

print(book-1)D - Flip and Adjust

またもやわからん。解説に、できるかできないかを動的計画法でという説明があります。dpの範囲は100x10000。たしかに十分小さいです。そして、dpのマトリックスを作ってしまえば、逆向きにたどることで表か裏か決められるなぁ。クレイジーだなぁ。できる気がしないことをできてしまうマジック。ふぅ。 2022-10-01

import sys

n, s = map(int, input().split())

cards = []

for _ in range(n):

a, b = map(int, input().split())

cards.append((a,b))

dp = [[0]*(s+1) for _ in range(n+1)]

dp[0][0] = 1

for i in range(1, n+1):

for j in range(s+1):

x = dp[i-1][j-cards[i-1][0]] if j-cards[i-1][0] >= 0 else 0

y = dp[i-1][j-cards[i-1][1]] if j-cards[i-1][1] >= 0 else 0

dp[i][j] = x | y

if dp[n][s] == 0:

print('No')

sys.exit()

else:

print('Yes')

i = n

res = ''

while True:

if i == 0:

break

if dp[i-1][s-cards[i-1][0]] == 1:

s -= cards[i-1][0]

res += 'H'

else:

s -= cards[i-1][1]

res += 'T'

i -= 1

print(res[::-1])E - Subsequence Path

古いのを遡ってやり始めています。考えすぎてわからなかったのですが、コードを見ての通り、かなり簡単な処理で解ける問題です。くやしいです。数列Eを順番に処理して、その道を使ったときに次の都市に低いコストでたどり着ければ距離を更新する。それだけです。しかも同じリスト上で更新していくだけでOKです。こんなにシンプルなのに考え込んでしまってわからないってくやしいなぁ。長い文字列が入力されるので、input = sys.stdin.readlineでの高速化が有効に働く問題です。 2022-12-03

import sys

input = sys.stdin.readline

N, M, K = map(int, input().split())

A = [0]

B = [0]

C = [0]

for _ in range(M):

a, b, c = map(int, input().split())

A.append(a)

B.append(b)

C.append(c)

costs = [10**15]*(N+1)

costs[1] = 0

for e in map(int, input().split()):

cnext = C[e] + costs[A[e]]

costs[B[e]] = min(cnext, costs[B[e]])

print(-1 if costs[N]==10**15 else costs[N])F - XOR on Grid Path

「半分全列挙」というらしいですが、そこまでは、なぜか自力でたどり着けました。(1,1)から対角線上にある、i+j=N+1のマスまでの通り道の組み合わせは、最大2^20通りなので100万程度になることがわかります。ということは、そのまま(N,N)まで行く組み合わせはその2乗で1兆ということになり、すべて計算できません。しかし(N,N)から逆に進んで来て対角線にたどり着く場合はまた100万程度の計算で済み、出会ったところで比べれば良いのではないでしょうか?問題のマス目を見ていて自然に思いついたのですが、1兆通り計算しなければならないところを、√1兆=100万の計算で済んでしまうなんて、なんでそんなことが可能なのか?これまた化かされたような気分です。気づけたにも関わらず、あれ?なんでこんなに計算量減るんだ?と不思議でした。とはいえ、それがわかったあとの実装も結構大変でした。コードを見るとなんかサラッと書いてるように見えますが、ループを回すときのインデックスの値をちゃんと決めるのに苦労してました。こういったループ中の変数の値の整理を短時間で行うのは、まだまだ苦手だなぁと思います。XORが0になるのは、同じ値同士の場合だけです。なので(1,1)から来た値と(N,N)から来た値が一致している組み合わせ数を調べればよいです。そこはCounterを使って計算しました。pythonのCounter、めっちゃ便利ですね。 2022-12-04

N = int(input())

alist = []

for _ in range(N):

alist.append(list(map(int, input().split())))

# print(alist)

res1 = [[[] for _ in range(N)] for _ in range(N)]

res1[0][0].append(alist[0][0])

for i in range(1, N):

j = i-1

while j >= 0:

k = i-1-j # j+k = i-1

res1[j+1][k].extend([val^alist[j+1][k] for val in res1[j][k]])

res1[j][k+1].extend([val^alist[j][k+1] for val in res1[j][k]])

j -= 1

res2 = [[[] for _ in range(N)] for _ in range(N)]

res2[N-1][N-1].append(alist[N-1][N-1])

for i in range(N-1, 0, -1):

j = i

while j <= N-1:

k = i+N-1-j

if i == 1:

res2[j-1][k].extend(res2[j][k])

res2[j][k-1].extend(res2[j][k])

else:

res2[j-1][k].extend([val^alist[j-1][k] for val in res2[j][k]])

res2[j][k-1].extend([val^alist[j][k-1] for val in res2[j][k]])

j += 1

from collections import Counter

ans = 0

for i in range(N):

j = N-1-i

count1 = Counter(res1[i][j])

count2 = Counter(res2[i][j])

for n in count1:

if n in count2:

ans += count1[n]*count2[n]

print(ans)G - Access Counter

勉強になるので、参加し始めてからのABCの問題Gまでを、遡ってやっています。問題Gを自力で解けるようになりたいですが、まだまだです。半分くらいは自力で進むのですが、最後の1手がわからないというような感覚があります。その1手に毎回驚いて刺激を受けるのでやめられません。この問題は、i時にアクセスが発生してから次にj時にアクセスが発生する確率が無限級数で計算でき、24個の状態が次にどこに遷移するかの確率が計算できるということまで自力でたどり着けました。1回目は24通り計算すればいいです。2回目は24x24通り計算すれば良い。これくらいなら計算できるなぁということまでわかりましたが、Nの最大値が10^18と書いてあるのを見て行き詰まりました。1ステップずつ進む方法しか思いつかなかったからです。これだけNがでかいと、毎回24x24通り計算するのは無理です。と、ここまで自分でたどり着けるだけでもずいぶん成長した気がします。解説を見てやられたと思いました。「繰り返し二乗法」という名前がついているようです。そういえば、べき乗の計算の中身がこういうやり方で、なるほどと思ったことがあるのですが、この問題は複雑だったので、思いつけませんでした。気づけるようになりたいものです。 2022-12-08

MOD = 998244353

inv100 = pow(100, MOD-2, MOD)

N, X, Y = map(int, input().split())

# X:T高橋, Y:A青木

S = input()

p = [(X if c=='T' else Y)*inv100%MOD for c in S] # access

q = [(100-X if c=='T' else 100-Y)*inv100%MOD for c in S] # noaccess

rate_next = [0]*(24*24)

rates = [rate_next]

for i in range(24): # prev access is i

noaccess_sum = 1

for j in range(1,25):

t_next = (i + j) % 24

ij = i * 24 + t_next

rate_next[ij] = noaccess_sum * p[t_next] % MOD

noaccess_sum = noaccess_sum * q[t_next] % MOD

infx = pow(1-noaccess_sum, MOD-2, MOD)

for i in range(24*24):

rate_next[i] = rate_next[i] * infx % MOD

def multiply(l, r):

ret = [0]*(24*24)

for i in range(24):

for j in range(24):

idx = i * 24 + j

for k in range(24):

ret[idx] = (ret[idx] + l[i*24+k]*r[k*24+j]) % MOD

return ret

count = 1

N_half = N // 2

while count <= N_half:

rates.append(multiply(rates[-1], rates[-1]))

count *= 2

digit = 0

first = True

while N:

if N % 2 == 1:

N -= 1

if first:

total_multiply = rates[digit]

first = False

else:

total_multiply = multiply(total_multiply, rates[digit])

N //= 2

digit += 1

ans = 0

for i, c in enumerate(S):

if c == 'A':

ans = (ans + total_multiply[24*23+i]) % MOD

print(ans)AtCoder Beginner Contest 272

前回に続き、問題Cで罠にハマってしまい5回も不正解を提出して、時間をロス。Cはなんとか解けましたが、Dは間に合わず、3問正解でした。前回2問正解で入茶したのに、早速脱落しかけています。直前までABC267 Ex Odd Sumをがんばっていて、なんとか正解できた直後の参加でした。解けない問題が積み上がっていると疲れますね。完全消化してから次のコンテストに臨めるようになりたいものですが、今の実力では無理です。いずれできるようになるのでしょうか?

C - Max Even

大きい順に3つの数字を選べば、その中の2つの和に必ず偶数が現れるなぁ、と思い、その値を回答すれば良いと思いこんでしまいました。実際には2番目と3番目の和より、1番目と4番目の和の方が大きい可能性があります。このことになかなか気づけず、なんとか正解したときには1時間以上経っていました。つらい。偶数の上位2つの和と奇数の上位2つの和を比較して大きい方を回答すればよかったのですね。それならシンプルでわかりやすいです。でも思いこんでしまうと抜け出せないなぁ。 2022-10-08

リベンジ。今となってはこうとしか思えないな。 2023-01-06

import sys

input = sys.stdin.readline

N = int(input())

even = []

odd = []

for a in map(int, input().split()):

if a % 2 == 0:

even.append(a)

else:

odd.append(a)

ans = [-1]

if len(even) >= 2:

even.sort()

ans.append(even[-1]+even[-2])

if len(odd) >= 2:

odd.sort()

ans.append(odd[-1]+odd[-2])

print(max(ans))D - Root M Leaper

間に合わなかったけど、Cでハマらずに十分時間が取れたら正解できたかもなぁと思っています。 2022-10-08

from collections import deque

n, m = map(int, input().split())

import math

move = set()

for i in range(m):

j2 = m - i**2

if j2 < 0:

break

root_j2 = int(math.sqrt(j2))

if root_j2**2 == j2:

move.add((i,root_j2))

move.add((i,-root_j2))

move.add((-i,root_j2))

move.add((-i,-root_j2))

move.add((root_j2,i))

move.add((-root_j2,i))

move.add((root_j2,-i))

move.add((-root_j2,-i))

grid = [[-1]*n for _ in range(n)]

q = deque([])

grid[0][0] = 0

q.append((0, 0))

while q:

x, y = q.popleft()

for delta in move:

x_next = x + delta[0]

y_next = y + delta[1]

if 0 <= x_next < n and 0 <= y_next < n:

if grid[x_next][y_next] == -1:

grid[x_next][y_next] = grid[x][y] + 1

q.append((x_next, y_next))

for i in range(n):

print(*grid[i])E - Add and Mex

これは無理だろ、M回の操作すらできないよ。と思って解説を見たら0からNまでの範囲内には、調和級数により、O(N log(N))しか入ってこないのだとか。調和級数なんて普段考えることないと、衝撃を受けますね。その情報を元にやってみると正解できました。考え方はむちゃくちゃ普通ですが、いけるという判断をするのがむずかしいですね。 2022-10-08

import math

n, m = map(int, input().split())

alist = list(map(int, input().split()))

val_list = [set() for _ in range(m+1)]

for i, a in enumerate(alist):

i += 1

if a > n:

continue

l = max(1, math.ceil(-(a/i)))

r = min(m, math.floor((n-a)/i))

for j in range(l, r+1):

val_list[j].add(a + i*j)

for i in range(1, m+1):

for j in range(n+1):

if j in val_list[i]:

continue

print(j)

breakF - Two Strings

ABCに参加するようになってから、Suffix Array(接尾辞配列)という言葉に何度かめぐりあっています。Suffix Arrayという概念に最初に触れた時は「マジかよ」と思いました。そこソートすんのかよ!と。しかもSA-ISという方法を使うとO(N)で計算できるようです。エグすぎます。ぼくは問題を解くときに、必要なアルゴリズムを一応理解して、自分なりに実装して解こうと試みるのが、基本姿勢としてあります。SA-ISも理解しようとはしましたが、こればかりは意味不明だったため、処理の流れを追ったところで自分で実装するエネルギーなどなく、「Suffix Arrayで解けます」と書かれている問題には、なかなか手を付けられずにいました。蟻本ではSA-ISの実装は説明されていません。ダブリングの実装が書かれています。しかしダブリングでは間に合わない問題が出題されてるっぽいですよね。もうSA-ISはブラックボックスとして使うしかないと腹をくくりました。「SA-IS Python」でググるとyaketake08さんの実装がヒットしますのでこれを使わせていただきました。で、普通に解けました。今後は苦手意識を持たずにSA-ISを使えるようになっていきたいです。解説では、SS、'a'をN回連続、TT、'z'をN回連続をつなげた文字列Xを考え、これのSuffix Arrayを構築すればよいと書いてありました。しかし、a-zだけを使うことにこだわらなければ、SS`TT{という文字列Xでいけると思いましたので、そのように実装しました。SA-ISを使う問題が解けたのは気持ちいいです。文字列Xを作ってSuffix Array、かなりおもしろい解き方だと思いました。 2022-11-04

# https://tjkendev.github.io/procon-library/python/string/sa_sa-is.html

# SA-ISコード省略

n = int(input())

s = input()

t = input()

x = s + s + chr(ord('a')-1) + t + t + chr(ord('z')+1)

res = 0

count_t = 0

for i in sais(x):

if 2*n+1 <= i <= 3*n:

count_t += 1

elif 0 <= i <= n-1:

res += (n-count_t)

print(res)蟻本を読んで作ったダブリングバージョンも載せておきます。ACx9、TLEx63でした。だめだこりゃ。SA-ISがないとやってられねぇ。 2022-11-04

def sa_doubling(x):

n = len(x)

sa = [0]*(n+1)

rank = [0]*(n+1)

tmp = [0]*(n+1)

def compare_sa(i, j, k):

if rank[i] != rank[j]:

return rank[i] < rank[j]

else:

ri = rank[i+k] if i+k <= n else -1

rj = rank[j+k] if j+k <= n else -1

return ri < rj

for i in range(n+1):

sa[i] = i

rank[i] = ord(x[i]) if i < n else -1

k = 1

while True:

if k > n:

break

sa.sort(key=lambda x: (rank[x], rank[x+k] if (x+k) <= n else -1))

tmp[0] = 0

for i in range(1, n+1):

tmp[sa[i]] = tmp[sa[i-1]] \

+ (1 if compare_sa(sa[i-1], sa[i], k) else 0)

for i in range(n+1):

rank[i] = tmp[i]

k *= 2

return sa

n = int(input())

s = input()

t = input()

x = s + s + chr(ord('a')-1) + t + t + chr(ord('z')+1)

res = 0

count_t = 0

for i in sa_doubling(x):

if 2*n+1 <= i <= 3*n:

count_t += 1

elif 0 <= i <= n-1:

res += (n-count_t)

print(res)G - Yet Another mod M

自力でたどり着けたのは、Mは素数と4だけで良いな、というところまででした。解説を見ると、「確率的にほぼ正解が出る」という解法が書かれており、みんなそれを使って高速なプログラムを書いていることに驚きました。一般的なやり方なのでしょうね。もう一方の解法は確実性のある方法だったのでこちらの方法で解くことにします。過半数がmod Mで一致するという条件から、もしもMが存在するなら、隣同士の数字の差の約数の中に含まれることがわかります。これ、気づけませんでした。なるほどです。確かに過半数の中に、必ず隣あうものが存在するはずです。3以上の素数と4のみでよいということまでは、わかっているので、見つかった素数で全探索しています。速度は出ませんが、これでACできました。この問題で、素因数分解のプログラムも勉強できたので、良かったです。 2022-12-01

import sys

from collections import defaultdict

N = int(input())

half = N // 2 + 1

alist = list(map(int, input().split()))

# return set of prime or 4 except for 2

def prime_factorization(n):

res = set()

count2 = 0

while n % 2 == 0:

count2 += 1

n //= 2

if count2 >= 2:

res.add(4)

a = 3

while a*a <= n:

while n % a == 0:

res.add(a)

n //= a

a += 1

if n != 1:

res.add(n)

return res

# return True if found

def checkall(p):

counter = defaultdict(int)

countmax = 0

for i in range(N):

a = alist[i]

x = a % p

counter[x] += 1

if counter[x] == half:

return True

if counter[x] > countmax:

countmax = counter[x]

if countmax + N - 1 - i < half:

return False

return False

checked = set()

for i in range(N):

diff = abs(alist[i]-alist[0 if i == N-1 else i+1])

cands = prime_factorization(diff)

for p in (cands-checked):

if checkall(p):

print(p)

sys.exit()

checked |= cands

print(-1)AtCoder Beginner Contest 273

京都に旅行してたので不参加でした。

この回も2022年末から2023年始にかけて問題Gまでやりました。 2023-01-03

D - LRUD Instructions

書き方をミスるだけでわかりにくいコードになってしまいそうな問題です。整理してわかりやすく書ければ良いと思いました。境界部分は全部壁と思えば良いので、defaultdictのdefault値をlambda関数で渡してdefaultdict(lambda: [0,W+1])としているあたりや、1方向の移動後の位置を、壁の前と壁がない場合に到達する位置の近い方、というように表現したことでわかりやすくなったと思います。 2022-12-30

import sys

input = sys.stdin.readline

from collections import defaultdict

import bisect

H, W, ti, tj = map(int, input().split())

N = int(input())

blocks_hori = defaultdict(lambda: [0,W+1])

blocks_vert = defaultdict(lambda: [0,H+1])

for _ in range(N):

i, j = map(int, input().split())

blocks_hori[i].append(j)

blocks_vert[j].append(i)

for i in blocks_hori:

blocks_hori[i].sort()

for j in blocks_vert:

blocks_vert[j].sort()

Q = int(input())

ans = []

for _ in range(Q):

d, c = input().split()

c = int(c)

if d == 'L':

blocks = blocks_hori[ti] if ti in blocks_hori else [0,W+1]

idx = bisect.bisect(blocks, tj)

tj = max(tj - c, blocks[idx-1] + 1)

elif d == 'R':

blocks = blocks_hori[ti] if ti in blocks_hori else [0,W+1]

idx = bisect.bisect(blocks, tj)

tj = min(tj + c, blocks[idx] - 1)

elif d == 'U':

blocks = blocks_vert[tj] if tj in blocks_vert else [0,H+1]

idx = bisect.bisect(blocks, ti)

ti = max(ti - c, blocks[idx-1] + 1)

elif d == 'D':

blocks = blocks_vert[tj] if tj in blocks_vert else [0,H+1]

idx = bisect.bisect(blocks, ti)

ti = min(ti + c, blocks[idx] - 1)

ans.append('{} {}'.format(ti, tj))

print(*ans, sep='\n')E - Notebook

問題文を素直に読むと、SAVEで整数列Aを丸ごとノートにコピーしたり、LOADでノートからAに丸ごとコピーしてきたりと、膨大な処理が必要になるように読めますが、Aを整数のツリーで管理すると、SAVEはツリーNodeにタグをつけることに、LOADはツリーNodeにポインタを移動することに対応し、膨大な操作は不要となります。問題の読み替えができるかどうかにかかっている、おもしろい問題です。 2022-12-30

import sys

input = sys.stdin.readline

class Node():

def __init__(self, c, p):

self.p = p # parent

self.c = c

self.children = {} # c -> Node

def add(self, c): # return added Node

if c not in self.children:

self.children[c] = Node(c, self)

return self.children[c]

note = {} # int -> Node

Q = int(input())

cur = ROOT = Node('', None) # root

ans = []

for _ in range(Q):

q = input().split()

if q[0] == 'ADD':

cur = cur.add(int(q[1]))

elif q[0] == 'DELETE':

if cur != ROOT:

cur = cur.p

elif q[0] == 'SAVE':

note[int(q[1])] = cur

elif q[0] == 'LOAD':

if int(q[1]) in note:

cur = note[int(q[1])]

else:

cur = ROOT

ans.append(-1 if cur == ROOT else cur.c)

print(*ans)F - Hammer 2

最初、グラフを作ってクリティカルパスを調べて解けないか?と思って考えていましたが力尽きました。その方針で解けるのか?まだ気になりますが、ここでは解説の方法でやります。区間DPという新しいDPが出てきました。最近、過去にやったDPをまとめてふり返る機会を作り、これでちょっとDPに慣れたかなぁと思ったあとで、挿入DPが出てきて、さらにこの問題で区間DPが出てきました。まだあるんかい!と衝撃を受けています。到達した両端がLとRの状態でDPする、その情報を頼りにどうやって遷移していくのか?考えて、ようやくやり方がわかるまで苦労しました。Lにいる場合とRにいる場合も分け、L+1にLから行く場合とRから行く場合、R+1にLから行く場合とRから行く場合を計算していくんですね。見ての通りif分岐が多く、コードが長くなり苦労が見えます。ハンマーのインデックスを負数にすることで、壁と区別し、また、ゴールと原点のインデックスは0としました。このあたりの実装方針がこれで良かったのか?判断がむずかしいですが、ACにたどり着くことができました。入手済みハンマーを覚えておくところもややこしいですよね。 2023-01-03

N, X = map(int, input().split())

levents = [(0, 0)]

revents = [(0, 0)] # origin id 0 posi 0

if X > 0:

revents.append((0, X)) # set goal id 0

else:

levents.append((0, X))

# wall idx is +

for i, y in enumerate(map(int, input().split())):

if y > 0:

revents.append((i+1, y))

else:

levents.append((i+1, y))

# hammer idx is -

for i, z in enumerate(map(int, input().split())):

if z > 0:

revents.append((-i-1, z))

else:

levents.append((-i-1, z))

revents.sort(key=lambda x:x[1])

levents.sort(key=lambda x:-x[1])

rnum = len(revents)

lnum = len(levents)

rdp = [[-1]*rnum for _ in range(lnum)]

ldp = [[-1]*rnum for _ in range(lnum)]

rdp[0][0] = 0 # [l][r]

ldp[0][0] = 0

lhammers = set()

ans = -1

for i in range(lnum):

ni = i + 1

l = levents[i]

if l[1] == X:

break # no need to move any more

if l[0] < 0: # hammer

lhammers.add(l[0])

hammers = set(lhammers)

for j in range(rnum):

nj = j + 1

r = revents[j]

if r[1] == X:

break # no need to move any more

if r[0] < 0:

hammers.add(r[0])

if ni < lnum: # update ldp next

nl = levents[ni]

if nl[0] <= 0 or nl[0] > 0 and -nl[0] in hammers:

if rdp[i][j] != -1:

next = rdp[i][j] + r[1] - nl[1] # r->l

ldp[ni][j] = next if ldp[ni][j] == -1 else min(ldp[ni][j], next)

if ldp[i][j] != -1:

next = ldp[i][j] + l[1] - nl[1] # l->l

ldp[ni][j] = next if ldp[ni][j] == -1 else min(ldp[ni][j], next)

if nl[1] == X and ldp[ni][j] != -1:

if ans == -1:

ans = ldp[ni][j]

else:

ans = min(ans, ldp[ni][j])

if nj < rnum: # update rdp next

nr = revents[nj]

if nr[0] <= 0 or nr[0] > 0 and -nr[0] in hammers: # can break r

if rdp[i][j] != -1:

next = rdp[i][j] + nr[1] - r[1] # r->r

rdp[i][nj] = next if rdp[i][nj] == -1 else min(rdp[i][nj], next)

if ldp[i][j] != -1:

next = ldp[i][j] + nr[1] - l[1] # l->r

rdp[i][nj] = next if rdp[i][nj] == -1 else min(rdp[i][nj], next)

if nr[1] == X and rdp[i][nj] != -1:

if ans == -1:

ans = rdp[i][nj]

else:

ans = min(ans, rdp[i][nj])

print(ans)G - Row Column Sums 2

最終的にDPの問題として解きましたが、自力ではできませんでした。DPをもっと解けるようになりたいですが、問題Gを自力で解いたのは過去1回しかないですし、まだまだ困難です。この問題はDPかなぁとも思ったのですが、最初別の方法で解けるのではないか?と思って試行錯誤していました。その時に少し考えを進めたあとで、RとCの1と2が同じ個数と勘違いしていて、心折れて解説を見ました。R方向に遷移していくDPで、残り2の列の個数をインデックスにすればよいとのこと。確かに、それまでに通った行を見れば、残った数字を計算でき、よって残り2の列の個数から残り1の列の個数も得ることができるので、これでいけます。こういったDPの式を、自力で思いつけるようになりたいものです!ところで、Python3でACしている30人ほどの中で、ぼくの処理速度が下から2番目の2408msだったのは少し気になります。この問題に関しては、配るDPより貰うDPの方が効率的で、処理速度が速くなりそうです。が、思考の流れが配るDPだったので配るDPで実装しました。書き換えるのは面倒です。貰うDPでやる強い意志を持って、その方針でささっと式を書くスキルは必要な場面が多そうですね。 2023-01-03

import sys

N = int(input())

mod = 998244353

# https://atcoder.jp/contests/abc273/submissions/37708024

# 階乗やchoose省略

R = list(map(int, input().split()))

sumR = sum(R)

sumC = 0

count2 = 0

for c in map(int, input().split()):

sumC += c

if c == 2:

count2 += 1

if sumR != sumC:

print(0)

sys.exit()

dp = [0]*(N+1) # 2 left

dp[count2] = 1

sum_left = sumR

for i in range(N): # i->i+1

if R[i] == 0: # do nothing

continue

dp_next = [0]*(N+1)

for x in range(N+1):

if dp[x] == 0:

continue

y = sum_left - 2*x

if y < 0:

break

if R[i] == 1:

if x > 0:

dp_next[x-1] += dp[x] * x

dp_next[x-1] %= mod

dp_next[x] += dp[x] * y

dp_next[x] %= mod

elif R[i] == 2:

if x > 1:

dp_next[x-2] += dp[x] * choose(x, 2)

dp_next[x-2] %= mod

if x > 0:

dp_next[x-1] += dp[x] * x

dp_next[x-1] += dp[x] * x * y

dp_next[x-1] %= mod

if y > 1:

dp_next[x] += dp[x] * choose(y, 2)

dp_next[x] %= mod

sum_left -= R[i]

dp = dp_next

print(dp[0])AtCoder Beginner Contest 274

ようやく初回以来の4問正解できました。これまで参加したABCの正解数は4,3,3,2,3,4です。初回にビギナーズラックなのか?4問正解でベストの成績を収め、その後低迷していたので、ようやく4問正解にたどり着けて嬉しいです。問題D - Robot Arms 2で、p2=(A1,0)というp2だけは+方向確定という条件を見逃していて、テストケース1つ不正解になる原因がわからず、残り30秒で気づいて正解するという奇跡を演じました。ミスったら不正解のまま終了という手に汗握る状況で正解できました。この罠にハマってなかったら問題Eを30分くらい考えられたのではないか?問題Eはたまに簡単なこともあるし解けたかもしれない。と悔しかったですが、問題Eはむずかしく、時間があってもどうせできませんでしたので、今回の4問正解は実力だなと納得しています。

E - Booster

わからなくて解説見ましたが、S\{i}というのは集合Sからiを除くという意味のようですね。これを知らなかったので、解説の理解にも手こずりました。いつも考え方を理解したあと、まずは自力で実装してみるのですが、bitDPのビットフラグの部分を、通過点のセットのタプルで表現し、dictを使ってやりましたところ、順当に時間制限にひっかかりました。で、解答例を見ました。なかなかエグいです。ビット演算を使いまくってるのはビット演算に慣れるのにいいですね。注意点として覚えたのは、&などのビット演算子の優先順位は+などの演算子より低いということ。なのでビット演算子を使う時()で囲っておいたほうが無難だなと思いました。知らない言葉も覚えました。popcountというのはビットが1の桁の数のようです。この問題ではboosterの回数を調べるのに5bitの整数のpopcountが必要なので、最初に計算してリストを作成していました。作り方もおもしろいです。ちなみに、Python3.10でint.bit_count()が追加されましたが、AtCoderでは使えませんね。hypotというのは2乗和の平方根らしいです。hypotenuse(ハイポテニュース)の略で、斜辺という意味です。平方根の計算をするときにmath.sqrtを使うのが当たり前と思っていましたが、**0.5と0.5乗する方法もあることも知りました。ぼくは距離は最初に全部計算して覚えておくように実装しました。この問題で最後に気になったのはdpのループの順序がこれで問題ないのか?ということです。通過した場所のリストをn+m桁のビットフラグで持っていて、for s in range(1, 1<<(n+m))のようにループさせてdpを更新しています。これでいいのか?ということです。考えてみると、これでいいということがわかりました。現在見ている[s]を更新できる条件は、sの部分集合の[sub_s]がすでに更新されていることですが、ビットフラグで考えるとsub_sのビットはsのビットの一部であることから、sub_s < sであることは明らかです。なのでこのループ処理において、[s]を更新する時点ですべての[sub_s]は更新されていることがわかります。なので、これで良いのです。最初に自力で実装したときは、popcountが小さい順じゃなければならないのではないかと思って、popcountをインクリメントしながらループして、combinationでsを作ってましたからね。そりゃあいろいろと重い。bitDP、クレイジーですね。 2022-10-23

popcount = [0]*32

for i in range(1, 32):

popcount[i] = popcount[i>>1] + (i&1) # + > &

n, m = map(int, input().split())

nodes = [(0,0)]

for _ in range(n+m):

nodes.append(tuple(map(int, input().split())))

dists = [[0.0]*(n+m+1) for _ in range(n+m+1)]

for i in range(n+m+1):

for j in range(n+m+1):

if j == i:

continue

if j < i:

dists[i][j] = dists[j][i]

dx = nodes[i][0] - nodes[j][0]

dy = nodes[i][1] - nodes[j][1]

dists[i][j] = (dx*dx + dy*dy)**0.5

# initialize

dp = [[1e12]*(1<<(n+m)) for _ in range(n+m)]

for i in range(n+m):

dp[i][1<<i] = dists[0][i+1] #index+1 in dists

for s in range(1, 1<<(n+m)):

boost_count = popcount[s>>n]

for i in range(n+m):

if not s & (1<<i):

continue

for j in range(n+m):

if s & (1<<j):

continue

# i in s, j not in s

new_time = dp[i][s] + dists[i+1][j+1]*0.5**boost_count

if new_time < dp[j][s|(1<<j)]:

dp[j][s|(1<<j)] = new_time

res = 1e12

for s in range((1<<n)-1, 1<<(n+m), 1<<n):

boost_count = popcount[s>>n]

for i in range(n+m):

time = dp[i][s] + dists[i+1][0]*0.5**boost_count

if time < res:

res = time

print(res)F - Fishing

わからなかったので解説の考え方を見ました。ある時刻において「左端に魚が必ずいる状態を調べれば良い」ということまでは自力でわかっていたのですが、その先の発想の転換ができませんでした。「時刻tではなくfish[i]に注目する」という視点の転換は、プログラミングにおいて、あるあるパターンだと思います。「左端に魚がいる状態を見ればいい」→「左端の魚を固定してみる」これが自然に思いつくようになりたいです。で、そこまでわかっても、Pythonで時間制限を突破するのはしんどかったです。最初heapqでイベントの発生順を管理しようとしましたが、全然間に合いませんでした。しかもPythonで間に合わせるユーザー解説に書いてあるように、ぼくもタプルをheapqにつっこんでました。無駄に第2要素の重さも見てしまってるようだし、いろいろ重い。時間のsetと、時間をキーとする重さの変化のdictを別々に管理してようやく間に合いました。Pythonで正解するにはノウハウがいろいろ必要ですね。いもす法なんですが、当たり前すぎていもす法とか言わないんでしょうか。笑。 2022-10-24

from collections import defaultdict

n, a = map(int, input().split())

fish = [tuple(map(int, input().split())) for _ in range(n)]

# w x v

res = 0

for i in range(n):

# watch fish[i]

imosuplus = defaultdict(int)

imosuminus = defaultdict(int)

times = set()

for j in range(n):

if i == j:

continue

v_rel = fish[j][2] - fish[i][2]

if v_rel == 0:

if fish[i][1] <= fish[j][1] <= fish[i][1]+a:

times.add(0.0)

imosuplus[0.0] += fish[j][0]

elif v_rel > 0: # j is faster

if fish[j][1] <= fish[i][1]+a:

if fish[i][1] <= fish[j][1]:

times.add(0.0)

imosuplus[0.0] += fish[j][0]

else:

time = (fish[i][1]-fish[j][1])/v_rel

times.add(time)

imosuplus[time] += fish[j][0]

timeout = (fish[i][1]+a-fish[j][1])/v_rel

times.add(timeout)

imosuminus[timeout] -= fish[j][0]

elif v_rel < 0: # i is faster

if fish[i][1] <= fish[j][1]:

if fish[j][1] <= fish[i][1]+a:

times.add(0.0)

imosuplus[0.0] += fish[j][0]

else:

time = (fish[i][1]+a-fish[j][1])/v_rel

times.add(time)

imosuplus[time] += fish[j][0]

timeout = (fish[i][1]-fish[j][1])/v_rel

times.add(timeout)

imosuminus[timeout] -= fish[j][0]

weight = fish[i][0]

if weight > res:

res = weight

for time in sorted(list(times)):

weight += imosuplus[time]

if weight > res:

res = weight

weight += imosuminus[time]

print(res)G - Security Camera 3

問題の内容がシンプルでとっつきやすいので、自力で解けるんじゃないかと錯覚しましたが、いろいろな新しいことを勉強しなければ、ぼくには解けない問題でした。右方向と下方向のカメラだけ考えれば良くて、'.'が連続して並んでるところは1つのカメラで監視できます。すべての'.'をどちらかのカメラで監視するには最低いくつのカメラが必要か?というように、問題を読み替えられます。単純だし、全部右方向だけでもそこそこいい答えが得られそうじゃないですか。でも簡単ではありませんでした。この問題を通じて新しい言葉やアルゴリズムを覚えることとなりました。右方向のカメラのノードセット1、下方向のカメラのノードセット2を考え、それらの間をエッジ('.'に相当)でつなぐグラフの問題となります。このような、ノードが2つのグループに分けられて、同じグループ内のノードは隣接していないようなグラフを「2部グラフ」と呼びます。最小数のノードを選択することですべてのエッジをカバーするにはどうすればよいか?という問題だということがわかりますが、それを「最小点カバー」「最小点被覆」と呼びます。さらに、2部グラフの「最小点カバー」は「最大マッチング」と一致するため、「最大マッチング」を解く問題に帰着します。(追記:マッチングの片方の点を選んでカバーできるということです。)なぜ「最小点カバー」と「最大マッチング」が一致するのかというと、グループ1のマッチしていない点Aの隣接点は必ずマッチしています。なぜなら隣接点もマッチしていないなら新しいマッチングが作れるので「最大マッチング」になってなかったことになりますから。グループ2のマッチしていない点Bについても同様です。では、Aの隣接点とBの隣接点同士がマッチしていることがあるかというと、それはありません。もしそうなっていると、Aと隣接点、Bと隣接点で2つマッチを作ったほうが良いことになり、この場合も「最大マッチング」になってなかったことになりますから。そのように考えを進めると、「最小点カバー」は「最大マッチング」と一致することがわかります。では「2部グラフ」の「最大マッチング」はどのように求めるのか?Source(s)ノードからグループ1のすべてのノードにつながっており、グループ2のすべてのノードがSink(t)につながっているようなグラフを考え、「最大流」を求めることで、「最大マッチング」を得ることができます。「最大流」を求めるにはFord-Fulkersonアルゴリズムを使います。sからtに流せるルートが無くなるまで、深さ優先探索をやり続けるという方法です。すでに流したエッジは、流量を減らすことで逆方向に流すことができると考えるのが味噌です。なぜ、Ford-Fulkersonで最大流量が求まるか?処理が終わるとtまで流せなくなったので、まだ流せる頂点の集まりSを考えます。これを残余グラフと呼びます。(Sから出ていく流量)-(Sに入ってくる流量)が現在求まっている総流量のはずです。ここで(Sから出ていく流量)は、キャパ限界で、(Sに入ってくる流量)は0となっているはずです。そうでないなら、流量を減らす余地があることになり、残余グラフSをもっと広げられることになるからです。よって、Sからこれ以上出ていくことができない状態になっていることがわかりますので、化かされたようなロジックですが、最大流量は確かに求まっていることがわかります。しかしFord-Fulkersonは効率的ではなく、最初このアルゴリズムを使ってやってみたらTLE(Time Limit Exceeded)でした。Dinic法という、より速い方法があります。Ford-Fulkersonは何も考えずにDFSを繰り返しますが、Dinic法では、BFSで各頂点へのSからの距離を計算し、一番短い経路から順にDFSします。これで速くなるというのがぼくにはあまり直感的ではありませんが、Ford-Fulkersonに比べて、処理がとても秩序だっていることはわかります。Dinic法を実装することで、ようやくACすることができました。この問題は、非常にシンプルで自力でいけそうでしたが、解くために新しい言葉を覚え、苦労してアルゴリズムを理解し、何ステップも経てのACで、勉強になりました。 2022-11-02

import sys

from collections import defaultdict

h, w = map(int, input().split())

s = []

cam_wdir = [[0]*w for _ in range(h)]

cam_cur = 0 # source

g = defaultdict(list)

for i in range(h):

gap = True

s_row = input()

s.append(s_row)

for j, c in enumerate(s_row):

if c == '.':

if gap == True:

cam_cur += 1

gap = False

g[0].append([cam_cur, 1, len(g[cam_cur])])

g[cam_cur].append([0, 0, len(g[0])-1])

cam_wdir[i][j] = cam_cur

if c == '#':

gap = True

camlist_hdir = []

for j in range(w):

gap = True

for i in range(h):

if s[i][j] == '.':

if gap == True:

cam_cur += 1

gap = False

camlist_hdir.append(cam_cur)

g[cam_wdir[i][j]].append([cam_cur, 1, len(g[cam_cur])])

g[cam_cur].append([cam_wdir[i][j], 0, len(g[cam_wdir[i][j]])-1])

if s[i][j] == '#':

gap = True

cam_cur += 1 # sink

if cam_cur == 1:

print(0)

sys.exit()

for i in camlist_hdir:

g[i].append([cam_cur, 1, len(g[cam_cur])])

g[cam_cur].append([i, 0, len(g[i])-1])

from collections import deque

level = []

def bfs(s):

global g

global level

level = [-1]*len(g) # initialize level

level[s] = 0

q = deque([s])

while q:

v = q.popleft()

for e in g[v]:

if e[1] and level[e[0]] < 0:

level[e[0]] = level[v] + 1

q.append(e[0])

watch = [0]*len(g)

def dfs(v, t, f):

global g

global watch

global level

if v == t:

return f

for i in range(watch[v], len(g[v])):

watch[v] = i

e = g[v][i] # e = [to, capa, rev_id in g[to]]

if e[1] and level[e[0]] > level[v]:

d = dfs(e[0], t, min(f, e[1])) # f=e[1]=1 in this problem

if d > 0: # d must be 1 in this problem

e[1] -= d

g[e[0]][e[2]][1] += d

return d

return 0

flow = 0

while True:

bfs(0)

if level[len(g)-1] < 0:

break

watch = [0]*len(g)

while True:

f = dfs(0, len(g)-1, 1)

if f == 0:

break

flow += f

print(flow)PyPyではなく、Pythonを使えば、NetworkXというライブラリを使うことができ、NetworkXには2部グラフの最大マッチングを求める関数も用意されているようです。それも試してみました。上のコードより少し処理時間が伸びましたが、ACできました。Hopcroft–Karpアルゴリズムを使っています。速そうですが、PyPy+自分で実装したDinicには勝てませんでした。NetworkXのhopcroft_karp_matchingを利用した2部グラフの最大マッチング計算は、以下のコードの最後の部分です。matchingのdictには逆方向のエッジも含まれるため、2で割る必要があります。 2022-11-02

import networkx as nx

h, w = map(int, input().split())

s = []

cam_wdir = [[0]*w for _ in range(h)]

cam_cur = 0

cams_wdir = []

for i in range(h):

gap = True

s_row = input()

s.append(s_row)

for j, c in enumerate(s_row):

if c == '.':

if gap == True:

cam_cur += 1

gap = False

cams_wdir.append(cam_cur)

cam_wdir[i][j] = cam_cur

if c == '#':

gap = True

es = []

cams_hdir = []

for j in range(w):

gap = True

for i in range(h):

if s[i][j] == '.':

if gap == True:

cam_cur += 1

gap = False

cams_hdir.append(cam_cur)

es.append((cam_wdir[i][j], cam_cur))

if s[i][j] == '#':

gap = True

B = nx.Graph()

B.add_nodes_from(cams_wdir, bipartite=0)

B.add_nodes_from(cams_hdir, bipartite=1)

B.add_edges_from(es)

matching = nx.bipartite.hopcroft_karp_matching(B, cams_wdir)

print(len(matching)//2)AtCoder Beginner Contest 275

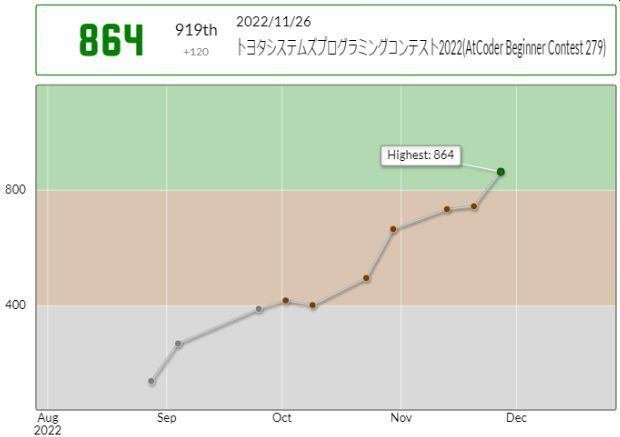

はじめて5問正解できました!前回まで4問を目指してがんばっていて、ようやく4問解けたところでしたが、その次の回で更新できるとは、ノッているようでうれしいです。問題Cは、頂点ペアを全探索し、それを1辺とする正方形があればカウントし、最後に4で割るという方法でやりましたが、処理時間は問題ありませんでした。問題Dは、最初f(10)くらいまで書き出してなにか規則がないかなどと考え始めましたが、f(n)を求めるのに、f(n/2)とかf(n/3)の値がわかればいいので結構計算が必要なところはスカスカであることに気づき、メモしながら再帰で解けました。問題Eは、逆元が必要な問題は過去に出会って計算方法を覚えていたので、そこでは悩みませんでした。確率の計算もこなれて、できたのかもしれません。Ratingが+169で665に伸びました。 2022-10-29

F - Erase Subarrays

DPだろうと思いながらも、どうすればいいかわからず、解説を読みました。確かに解説の通り、DPの式を作ることができます。これを自力で思いつけるようになるには、いろいろなパターンを解いていくしかないように思います。解説にdp[i][j][k]で、k=0のときaiを削除し、k=1のときaiを残すと書かれていますが、そのまま実装するとTLE(Time Limit Exceeded)となってしまいました。どうもPythonは、リストの数がパフォーマンスに大きく影響するようです。dp[i][j][k]だと、3次元目の要素数2のリストがN x M個作られることになります。これをdp[i][k][j]という順序にいれかえると、3次元目の要素数がMになり、リスト数はN x 2となり、この問題では1000分の1以下に削減できることになります。実際そのようにjとkを入れ替えるだけでACすることができました。制限時間2秒に引っかかっていたのに、431msで処理が終わりました。解説でdp[i][j][k]となっているのは理解しやすくて自然ですが、Pythonで解くには罠になっていました。高速に動作するためには、小さいリストをたくさん作るのを避け、大きなリストを少なく作るようにするべきです。メモ用の多次元リストは機械的に行列入れ替えられるはずなので、そのように実装すべきです。この問題から非常に重要な知見を得ることができました。 2022-10-30

n, m = map(int, input().split())

alist = list(map(int, input().split()))

dp = [[[3000]*(m+1) for _ in range(2)] for _ in range(n)]

dp[0][0][0] = 1

if alist[0] <= m:

dp[0][1][alist[0]] = 0

for i in range(1, n):

for j in range(0, m+1):

dp[i][0][j] = min(dp[i-1][1][j]+1, dp[i-1][0][j])

j_ = j - alist[i]

if j_ >= 0:

dp[i][1][j] = min(dp[i-1][1][j_], dp[i-1][0][j_])

for j in range(1, m+1):

res = min(dp[n-1][0][j], dp[n-1][1][j])

print(-1 if res >= 3000 else res)G - Infinite Knapsack

今日は2022年12月1日。最近ABCの7問目である問題Gまでを、コンテスト終了後にACできるようになっています。ABC276、277、278、279は、やりました。昔はできてなかったのですが、力がついてきたのか、コンテスト終了後解説を見てACできているのです。非常に勉強になっているので、遡って問題Gまでを埋めていこうかなと思います。最初がこの問題で、最終的にはABCに参加し始めたところまで戻っていければと思います。この問題ですが、全部価値が1になるようにして解けば良く、Σxi = 1の条件で、max(Σai*xi, Σbi*xi)の最小値を求める問題であるというところまで、自力で問題を言い換えられていました。そこでなんとなく、力尽きたなぁと思って解説を見に行ったところ、凸包と書いてありました。自分で書いた式をよく見たらΣxi = 1で(Σai*xi, Σbi*xi)ってたしかに(ai, bi)の凸包ですね。冴えてたら気づけたと思うとちょっとくやしいです。で、凸包はこれを使えば良いと解説にありました。ロジックはわかりやすく、コピーして使います。この問題は、凸包の経験さえあればいけそうに感じました。問題Gの自力正解もちょっと近づいてきたような気がします。 2022-11-30

N = int(input())

points = []

for _ in range(N):

a, b, c = map(int, input().split())

points.append((a/c, b/c))

points.sort()

def cross(o, a, b):

return (a[0]-o[0])*(b[1]-o[1]) - (a[1]-o[1])*(b[0]-o[0])

lower = []

for p in points:

while len(lower) >= 2 and cross(lower[-2], lower[-1], p) <= 0:

lower.pop()

lower.append(p)

# upper = [] # upper[:-1]

# for p in reversed(points):

# while len(upper) >= 2 and cross(upper[-2], upper[-1], p) <= 0:

# upper.pop()

# upper.append(p)

len_con = len(lower)

res = max(lower[0][0], lower[0][1])

if len_con > 1:

for i in range(1, len(lower)):

a, b = lower[i-1]

c, d = lower[i]

if d >= b:

break

res = min(res, max(c, d))

t = (a-b)/(a+d-b-c)

if 0.0 < t < 1.0:

res = min(res, a+(c-a)*t)

print(1/res)AtCoder Beginner Contest 276

家族で焼肉を食べに行ってたので、リアルタイム参加していません。翌日バーチャル参加し、問題A-Dの4完でした。4問解けたのは喜ばしいです。問題Cでなかなかバグを取れず45分くらいかかってしまいました。それでも問題Eに30分くらいかけられましたが、間に合いませんでした。ぼくの問題Eの方針は、壁伝いに進むというものだったのですが、うまく実装できず混乱に陥ってしまいました。笑。

E - Round Trip