AIアニメ動画の作り方

この記事は、生成AI Advent Calendar 2024の12月9日の記事です。

今年後半に入って、動画生成AIが急激に性能が上がってきました。ちょこちょこ触っているうちに、一人でもアニメっぽい表現ができるのではないかと思うようになりました。もちろん、生成AIはまだまだ限界だらけで、期待するほど良い成果を出してくれないという傾向もあります。それでも、試してみると、これが面白くなってしまいハマっています。

継続的にストーリー物みたいなのを作ってみたいと思っているのですが、手軽に作れる部分もあるのですが、課題もいろいろです。そこで、現時点での私の作り方みたいなのをご紹介したいと思います。

紹介するのは下記の動画のメイキングです。約1分でそれなりにストーリー性を持った表現をすることを目指していました。

時の断片 #AIVideo #AIanime #AI眼鏡部

— Alone1M (@Alone1Moon) November 4, 2024

Gen3 Advanced Camera Controlをかなり使って画面を作ってみました。Zoomばっかりですが。適当にランダムに出てくるのよりは制御しやすい気がします。やはり、DMMボイスで声を当てています。さすがに作成に5時間かかりました。#AI動画生成チャレンジ 17日目 pic.twitter.com/KpBCx6H6g2

■シナリオやカメラワークはChatGPTを利用して作成

作成する上で、かなり頼ったのが、ChatGPT 4oです。30秒という限定的な条件をつけて、適当なストーリーのアイデアを5つ考えてもらいました。その中から、気に入ったものをピックアップして、セリフとカメラワークまで考えてもらいました。特にシーンの構成といったものは、私は素人のため、思いつかなかったからです。そのアウトプットを見て、さらに注文をして、修正を行い、一応の草案としました。

タイトルは「時の断片」というものです。

とりあえずカット数が多ければ、それなりに見れるものになるのではないかと思ったのですが、ChatGPTの提案は、それなりにボリュームがあって、これは提案で来ている通りの30秒に収めるのは、無理じゃない?という感じの提案ではありました。目標としては1分以内には収めたいとは思っていました。

■まずは画像を揃えるところから

とはいえ、それらのことは後から調整すればいいので、ともかくは画像を揃えることから始めます。背景の画像は、基本的にMidjouneyで作成し、登場するキャラクターについては、WebUI Forge環境でSDXLを使って作成しています。

この話の中では、懐中時計の存在が重要なため、懐中時計をMidjouneyで作った後に、情報量が多すぎるので、Flux.1 devのi2iを使って修正をしています。

主人公がいるシーンでは、背景はMidjouneyを加工した物を使うのですが、その構図にあったポーズのキャラクターをしっかり出すのは難しいです。そのため、「VRM Posing Desktop」を使ってVRMでポーズを作成し、それをSDXLのControlNetを使って狙ったポーズを生成したりもしています。

それを、加工した背景と、Photoshopで合成しています。

SDXLを使って作った主人公を後から合成している

また、異世界のシーンも、背景を適当にMidjouneyでいくつも作りました。台本のなかに「異世界の風景。空には二つの月が浮かび、草原が青い光で揺れている」という指定があったので、特に「二つの月」はわかりやすいシンボルになると思ったので、背景作成のときには意識してプロンプトに入れました。

■AI動画生成段階

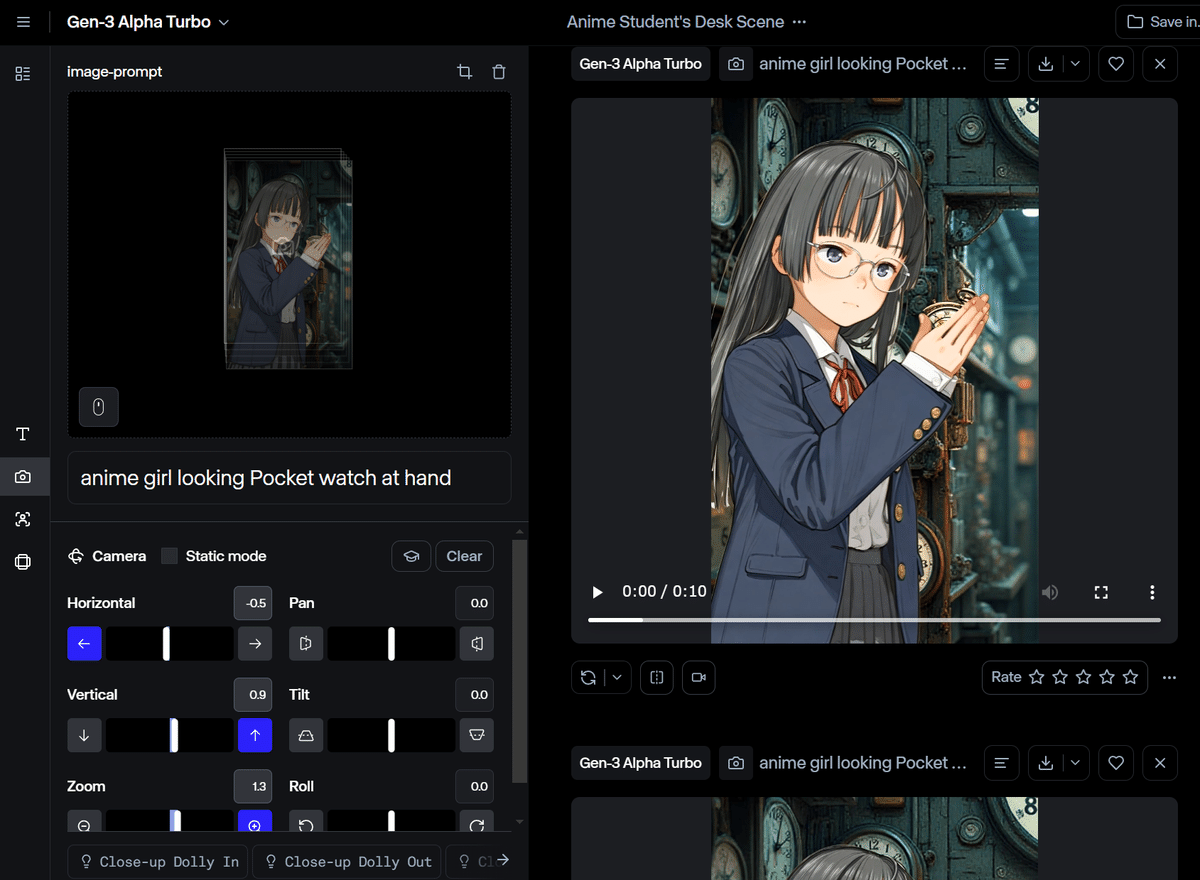

ある程度画像のセットが揃った後は、「Runway Gen3 Alpha Turbo」を使って動かしていきます。この動画を作った時には、ちょうどRunwayに「Advanced Camera Mode」が追加されたところで、任意のズームインといったものを扱えるようになっていました。

それぞれのシーンで、何らかのカメラの動きを行っていれば、それっぽく見えるので、少しでも動いていることを意識して設定していきました。ただ、Runwayも制御できるとはいっても、失敗するのが大前提で、何回も生成して、そこから出来の良いものを選んでいくという作り方をせざる得ません。

主人公が、時計を持っているシーンだけでも、あらためて数えたら13回も生成していました。

その他、各シーンも色々作っていきます。

ちなみに、Runwayは使い放題(Unlimited)プランが1ヶ月95ドルと本気で高いです。商用利用ユーザーを対象にした価格設定をしているのかなと思います。ただ、それ以外のプランのポイント制だと、ちょっと試しているだけで一瞬で使い切ってしまいます。

AI動画のサービスの多くの最もいいプランが、月95ドル設定なのが多いので、今の相場なのかもしれません。他の動画サービスも色々試しているのですが、キャラクターの一貫性が高いので、Runwayを中心に使っています。動画をやるとなると、どこかのサービスに100ドル程度の課金をすることは必要になってきます。

再生速度を上げて、Premiereの半透明化設定で背景と合成して誤魔化している

また、動画生成AIが現状生成が苦手な動画もあります。主人公が過去を思い出す中で、騎士として戦っていたシーンを差し込んでいるのですが、剣のような武器を持たせて闘わせる動きを作るのは、現状の動画生成AIでは、非常にハードルが高いようです。

動画生成AIは、前後関係とか、何かのものを持っているといった対象物との関係性を捉えるのが苦手なようで、どうしてもミスが起きます。そのため、そういう苦手な部分は仕方ないと割り切って、はっきりと戦闘シーンを描かないという形で誤魔化しています。

そうして、シーンとなる動画を揃えていきます。

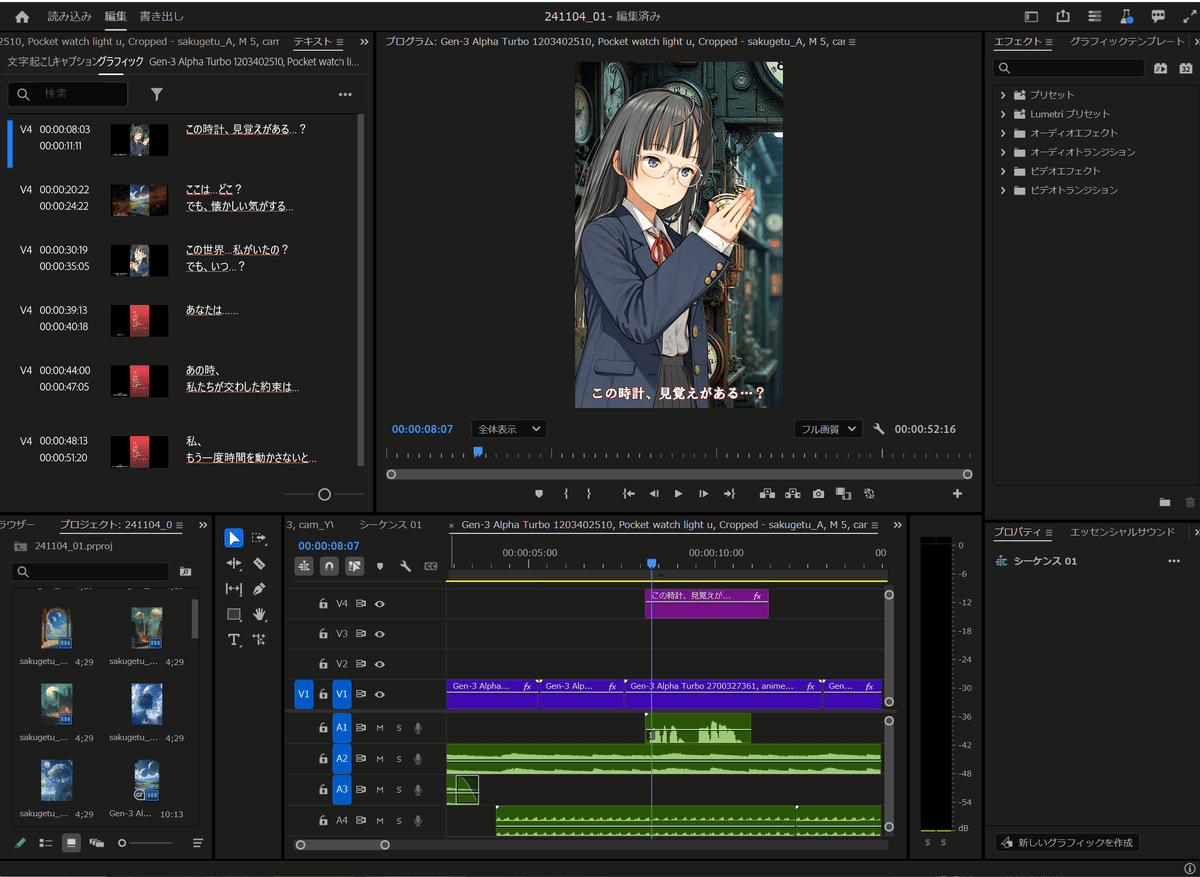

■音声や音楽などを入れて動画を整えていく

大体のシーンが揃ったら、動画編集ソフト「Adobe Premiere Pro」にそれらを流し込んで、順番を整えてきます。最初の段階ではラフなので、時間的なものを細かく決めてはいません。動画編集はこれまで本格的にやったことがなかったのですが、Premiereはつい最近使い方を覚え始めました。無料で使えるので、機能制限があったりしますが「Davinci Resolve」でも、最初のうちは十分かもしれません。

全体を整えていく時に重要なのが、音声や音楽です。

すでにこの動画を作る前に、音楽生成AIサービス「Suno」を使って、ダンス動画用の曲を作ったりしていました。Sunoはそれっぽい曲を手軽に作るのには向いています。また、無料で毎日ポイント(10曲ぐらい分)をくれるので、手軽に試すことができます。今回の曲は、インストルメンタルを選び、プロンプトで作成してほしい曲の雰囲気を指定したものでした。

また、音声は、当時ベータサービスが始まったばかりだった「にじボイス(旧DMMボイス)」を使って、セリフの音声を作っていきました。感情に大きな振り幅は現状は作れませんが、独白のようなセリフは簡単に作れるので便利です。それらのセリフを音声データとして、Premiereに配置した後、セリフに合わせてシーンを整えていきました。セリフを話すタイミングがでシーン切り替えをやると自然になるようです。

(たまたま、タイミングもあって、にじボイス(旧DMMボイス)の原田様に、私の動画を応用例の一つとしてご紹介いただきました。ありがとうございます)

https://note.com/1230yuji/n/n2ce8958d6d3c

SEも重要な要素です。SEは「ElevenLabs」を使いました。ここは音声変換をするサービスがメインなのですが、SE生成のサービスもあります。ここのサービスも、月に一定回数までは無料でできます。

ここで、時計屋に入る時のカランコロン音、時計のコチコチ音、異世界へのワープ音、剣の戦闘シーンの音、といったものを作りました。プロンプトを指定すると、4つSEが作られます。ここもハズレとなることが少なくないので、気に入ったSEが出るまで何度も生成します。

割とありふれているようなものは出やすい

動画に、音声やセリフ、SEを組み合わせることによって、説得力のある動画になってきます。さらに今回のものは、短い動画なので理解しやすいように、字幕もつけています。ChatGPTの当初プランでは、30秒はおろか、1分にも収まらないので、適当にセリフを端折ったりしています。そして、最終的には、約1分ほどの動画へと仕上げました。

作成にかかったのは、トータルで、5時間程度です。

もちろん、荒削りなところはたくさんあり、もっと細部を詰めて、より品質を上げていけるのではないかと考えています。また、ある程度、どの生成AIで何が作れるといった知識を持っていたので、短くできている側面はあると思いますが、それでもこの短さでできるというのは、自分でも驚きました。

■動画生成AIには金がかかりますけど、のめり込んでます

現状、動画生成AI環境は、クラウドAIが基本なので結構お金がかかります。

すでに触れたRunwayの95ドルもそうですが、もし他の動画生成AIサービスも使うとなると値段がその分上がってきます。Runwayだけでは表現しきれないことも多いので、他の動画生成AIにもついつい課金してしまいたくなってしまいます…。しかし、それ以前にけっこうかかっています。

Adobe Premiere ProもAdobeの全部入り環境だと、月7780円ととても高いのですが、毎年ブラックフライデーの時期に半値セールをやっているので、その時に払うようにしています。Photoshopのプランが月2380円なので、そこからプラス1000円と考えると、高いけどまあ許せるかという感じです。

それ以外に、ChatGPT Plusの月30ドル、Midjouneyのスタンダートプランの月30ドル、Sunoが月10ドル(商用利用の場合は必須)、にじボイスがベーシック(月1万字)なら1000円とキリがありません。

ローカル環境のみならば抑えられるのですが、それでも別途ビデオカード代はかかっているわけで、AIは金かかるなあというのが正直なところです。

このコストが、AI動画をやる場合の一つのハードルになっているなあとは思います。趣味だと思っても……月3万円は……やっぱり高いですね……。

それでも、同じような内容を手描きで実現するのは、私にはまず無理であり、3D技術でUnreal Engine等で目指した場合には、とてつもなく時間がかかり、アセットなどを揃えていくと、これ以上のお金がかかる可能性があると考えます。

やはり、性能の高いものが、AI技術の発達によって、個人でも頑張れば手が届くところにまで一般化しているという状態にはあると思います。

ボブ娘さん口パクテスト2 #AIVideo #AIAnime

— Alone1M (@Alone1Moon) December 8, 2024

Runway Act-Oneのビデオリファレンスモードのテスト、その2。声は #にじボイス で作成後、ウェブカメラで声に合わせて口パクを撮影して結合。それなりに成立してますね。#AI動画生成チャレンジ 40日目 pic.twitter.com/is8YKRDeQq

私はもうある程度、AIを使った遊びにのめり込んでいるのは確かので、少々のコストがかかっても、今後も続けると思います。実際、Xのアカウントの方で、動画AIの技術的なテストを繰り返し続けています。

今は、30分ぐらいの本格的なAIアニメーションの作成を、個人で実現してみたいと考えるようになりました。1日で1分作れるのであれば、1ヶ月あれば、30分アニメは作れる計算になるため、案外と実現は可能な気がします。

これは個人的には、来年の目標でしょうか。

<その他、作成した動画の例です>

調停者の独白 #AIVideo #AIAnime

— Alone1M (@Alone1Moon) December 8, 2024

Runway Act-Oneのビデオリファレンスモードで割と真面目に作ってみました。声は #にじボイス 。カットを近距離、中距離、遠距離と意図的に分けてみました。固定カメラに近いとアニメ系も結構いけますね。#AI動画生成チャレンジ 41日目 pic.twitter.com/p2qAG1u1eO

AI娘のラブソング #AIVideo #AIAnime

— Alone1M (@Alone1Moon) November 6, 2024

電波ソングを作れないかやってみました。当たり前ですが、最初のトンチキ絵以外は、塗り過程もすべてAIです。だいぶ、ふざけてますが、かなり曲を気に入っています #AI動画生成チャレンジ 19日目 pic.twitter.com/5hBgfdaYFS