「AIのゴッドファーザー」ジェフリー・ヒントンがノーベル物理学賞を受賞

元OpenAIの主任開発者であったイリヤ・サツケヴァー氏の恩師・ヒントン教授は、人工知能に関する研究でプリンストン大学のジョン・ホップフィールド教授とともにこの賞を受賞しました。

博士曰く「こんな事が起こるとは思ってもみなかった」

スウェーデン王立科学アカデミーは、カナダのトロント大学に勤務するジェフリー・ヒントン教授が、機械学習の基礎となる発見と発明により、プリンストン大学のジョン・ホップフィールド教授とともにこの栄誉を共同受賞したと発表しました。

ストックホルムでのイベントで講演したヒントン教授は「驚愕した」と述べ、「こんなことが起こるとは思ってもみなかった。とても驚いている」と付け加えました。

ノーベル賞のXアカウントのポストが良い感じです。ヒントン氏が本日の記者会見で「私はカリフォルニアの安いホテルに泊まっていますが、インターネットも電話もつながりがよくありません。今日はMRI検査を受ける予定でしたが、キャンセルしなくてはなりません!」と述べたとポストしています。

"I'm in a cheap hotel in California which doesn't have a good internet or phone connection. I was going to have an MRI scan today but I'll have to cancel that!"

— The Nobel Prize (@NobelPrize) October 8, 2024

- New physics laureate Geoffrey Hinton speaking at today’s press conference where his #NobelPrize was announced. pic.twitter.com/i7jnucEhFl

こちらはニューラルネットワークについて、最も参照されるヒントン博士の論文です。

それでは上記のジェフリー・ヒントン博士が受賞した今回のノーベル物理学賞の一環として、彼が最も有名な論文のひとつである「大規模データで学習する画像認識AIのすごい進化」(2012年発表)について、高校生にもわかりやすく解説してみます。

大規模データで学習する、画像認識AIのすごい進化

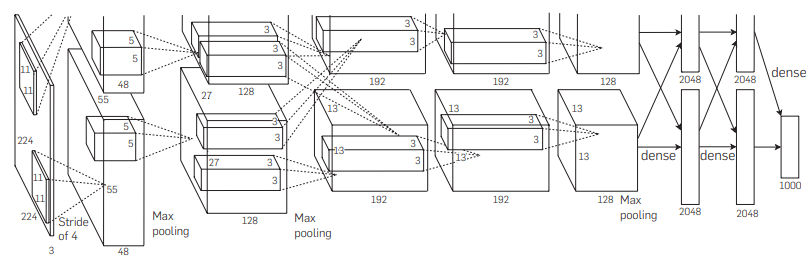

この論文は、画像認識の精度を大幅に向上させた「深層畳み込みニューラルネットワーク(CNN)」という技術について述べています。CNNは、人間の視覚の仕組みを模倣して設計された人工知能のモデルです。この技術により、コンピュータは「画像から何が写っているか」を認識する能力を飛躍的に高めることができました。(注01)

深層畳み込みニューラルネットワーク(CNN)とは

論文の中心には「ImageNet」という非常に大きなデータセットを使った実験があります。ImageNetには1500万枚以上のラベル付き画像があり、それぞれに22,000以上のカテゴリーが設定されています。このデータを使って、1,000種類の物体を識別するためのCNNを訓練しました。研究では、このネットワークが以前の最先端技術と比べて大幅に高い精度を達成したことが報告されています。具体的には、「トップ5のエラーレート」が15.3%という驚異的な成績を収めました。これは、コンピュータが5つの候補の中に正しい答えを含める確率が非常に高いということを示しています。

モデルが特定のパターンに依存するのを防ぐドロップアウト

このネットワークには、「畳み込み層」と「全結合層」という2つの主要な種類の層があります。畳み込み層は画像の中の特徴を捉える役割を持ち、例えばエッジやテクスチャといった基本的なパターンを見つけるのに使われます。一方で全結合層は、これらの特徴を使って最終的な分類を行う部分です。また、この論文で使われたネットワークには「ドロップアウト」と呼ばれる工夫が施されています。これは、モデルが特定のパターンに依存しすぎないようにするための技術で、過学習(訓練データに対する過剰な適応)を防ぐために非常に効果的です。

従来のニューロンより計算速度が速いReLU

さらに、この研究では「ReLU(Rectified Linear Unit)」(注02)と呼ばれる新しいタイプのニューロンも使用されました。従来のニューロンに比べて計算速度が速く、ネットワークを大きくすることが可能になり、それによって高い精度を実現しました。ReLUは、入力が0を超える場合はそのまま出力し、0以下の場合は0を出力するという非常にシンプルな動作をします。このシンプルさが、計算の効率化に寄与しています。

ジェフリー・ヒントン博士らのこの研究は、現在のAIの進展における重要な転換点となり、GoogleやFacebookなどの多くの企業がこの技術を採用し、画像認識だけでなく、音声認識や自然言語処理といった他の分野にも応用が広がっています。彼らの成果は、単なる技術革新にとどまらず、私たちの日常生活にAI技術が深く関わるきっかけとなりました。

※注01:ニューラルネットワークの初期の発展は音声認識や文字認識などさまざまな分野にわたっていました。最初に注目されたのは1980年代の手書き文字認識などで、これは言語処理に関連していました。ただし、深層畳み込みニューラルネットワーク(CNN)のような構造は、特に画像認識の分野で非常に成功し、広く普及しました。このため、画像処理の応用が特に有名になったのです。

画像認識においてCNNが非常に優れた性能を発揮したことで、他のAIモデルも画像から得た経験や技術を応用し、言語処理や音声処理などに展開されるようになったのです。

※注02:最新の大規模言語モデル(LLM)では、ReLUのようなシンプルな活性化関数は使われていないことが多いです。代わりに、例えば「ゲル状活性化関数」や「シリコンニューラル活性化関数」など、より滑らかで勾配が扱いやすい関数がよく使われています。これは、より深い層のネットワークにおいて学習の安定性を確保し、言語処理に適した性能を引き出すためです。

LLMにおけるTransformerはジェフリー・ヒントン博士の発明ではない

ChatGPTなどは、Transformerというネットワークアーキテクチャを使っており、この中では「ゲル状活性化関数」や「正規化」を行うことで、より大規模で複雑なネットワークの効率的な学習を実現しています。つまり、最新の言語モデルにおける活性化関数は、ReLUとは異なる設計である場合が多いのです。

CNN(畳み込みニューラルネットワーク)は主に画像認識で強みを発揮する一方、Transformerは自然言語処理(NLP)に特化して開発され、後には画像処理などにも応用されています。

Transformerはシーケンスデータ(例えば文章や音声)を扱うのに適していて、その一部である「自己注意機構」によって、入力の全体を考慮しながら関連性を重視して処理することができます。このため、ChatGPTのような言語モデルでは、文脈を理解し長い文章を処理するのにTransformerがとても効果的です。

Transformerを発見したのは?

Transformerは、2017年にGoogleの研究者たちによって発表された論文「Attention is All You Need」によって紹介されました。この論文の主要な著者には、VaswaniやShazeer、Parmarなどの名前があります。Transformerは、自己注意機構(Self-Attention)を中心に構築されていて、これによって文脈をより効率的に理解することが可能になり、自然言語処理に革命をもたらしました。

ヒントン博士は、ニューラルネットワークの基礎技術やディープラーニングに関する重要な研究に多くの貢献をしてきましたが、Transformer自体は彼の発明ではありません。彼の研究は、特に深層畳み込みニューラルネットワーク(CNN)やバックプロパゲーション(誤差逆伝播法)に関連するもので、画像処理や深層学習の普及において非常に大きな役割を果たしました。

LLMに警告を鳴らしたヒントン博士

ジェフリー・ヒントン博士がGoogleを退職し、AI技術の危険性について警鐘を鳴らしたのは、特にトランスフォーマーベースの大規模言語モデル(LLM)が持つリスクに対する強い懸念があったからと言えます。ヒントン博士はAIがもたらす社会への影響や、人間の制御を超えてしまう可能性を深く憂慮しています。これが、Googleを退社してからより自由に意見を述べるようになった一因と言われています。

彼が特に懸念しているのは、トランスフォーマーを基にした言語モデル(つまりChatGPTのようなLLM)が、人間の意図を超えて急速に能力を向上させている点です。例えば、フェイクニュースの生成や、偽情報の拡散、人々の心理に影響を与える力があまりにも強力になってしまうことを危険視しており、この技術の急速な発展を、政府や規制機関が追いかけるのは非常に難しいと感じています。

ヒントン博士の愛弟子元OpenAI主任開発者イリヤ・サツケヴァー

ChatGPTは元主任開発者のイリヤ・サツケヴァー氏が指揮をとり開発されたのであるが、彼はReLUで開発していたヒントン博士の弟子でした。彼はトロント大学でヒントン博士の元、大学院生として研究を行っていました。そして、ジェフリー・ヒントン博士と共に「ImageNet Classification with Deep Convolutional Neural Networks」などの重要な論文に共同で取り組み、ディープラーニング技術の発展に大きな貢献をしました。その後、彼はGoogleに移り、Google Brainプロジェクトの一員として活躍しましたが、彼はTransformerの開発に直接関与していたわけではありません。

サツケヴァー氏も恩師のノーベル物理賞受賞に祝辞をポストしています。

Congratulations to @geoffreyhinton for winning the Nobel Prize in physics!!

— Ilya Sutskever (@ilyasut) October 8, 2024

@geoffreyhintonさん、ノーベル物理学賞受賞おめでとうございます!!

何故OpenAIはGoogleに先立ちLLMを開発できたのか?

サム・アルトマンは、Transformerの論文を見てその可能性をすぐに認識し、これを使ってOpenAIで次のステップに進むべきだと決断したのでしょう。

一方Googleではヒントン博士が、特に社会におけるAIの制御や倫理面での影響を強く危惧してTransformerの開発にGoogle社内で警鐘を鳴らしました。そして、その警告がGoogle内の研究者たちに影響を与え、一時開発が中断されたり、さらにはその技術をどう進めるべきか再考する動きがありました。

結果、Googleが慎重な態度を取る間に、OpenAIはTransformerを応用した大規模言語モデルを開発し、その技術が先にChatGPTとして世に出ることで、大きな注目を浴びました。

ある意味、ヒントン博士の警告がGoogleのAI開発を送らせてしまったとも考えられるかもしれません。

彼はアルトマン氏を解雇した教え子を誇りに思っている

そういうわけで、ヒントン博士は自分の開発したの後継者であるサツケヴァー氏が2023年11月にOpenAIでクーデターを起こしサム・アルトマンを解雇した事を賞賛しています。

Geoffrey Hinton says he is particularly proud that one of his students fired Sam Altman because Sam is much less concerned with AI safety than with profits pic.twitter.com/HFmQVi6NXW

— Tsarathustra (@tsarnick) October 9, 2024

ジェフリー・ヒントン氏は、サム・アルトマン氏がAIの安全性よりも利益を重視しているため、彼の生徒の一人が彼を解雇したことを特に誇りに思っていると語る。

Hinton博士が、Transformerの採用を巡って自分の影響力が弱くなったと感じていた可能性はあると思います。Googleで開発されたTransformerモデルがOpenAIによって選ばれたことは、Hintonとその系統であるIlyaが進めていたReLUベースのアプローチではなく、Googleの研究成果が次世代AIの土台に選ばれたという意味で、Hintonやその支持者にとっては「自分たちのアプローチが後回しにされた」という感覚があったのかもしれません。

サツケヴァー氏はクーデターを起こした事に対して深く反省していましたが、サムを解雇しようと取締役会に訴えたのは、ひょっとしてヒントン博士に言われて実行した事だったかもしれません。

I deeply regret my participation in the board's actions. I never intended to harm OpenAI. I love everything we've built together and I will do everything I can to reunite the company.

— Ilya Sutskever (@ilyasut) November 20, 2023

私は取締役会の行動に参加したことを深く後悔しています。OpenAIに危害を加えるつもりはまったくありませんでした。私たちが一緒に築き上げてきたものはすべて愛しており、会社を再統一するために全力を尽くします。

ヒントン博士が誇りに思っている、教え子サツケヴァー氏の取締役会を巻き込んだ、サム・アルトマン下ろしのクーデターの結末については下記のNoteにまとめましたので合わせてご覧ください。