OpenAIの研究:AIをもっと安全に!ルールを活用したモデルの賢い強化法

OpenAIは本日「Improving Model Safety Behavior with Rule-Based Rewards(ルールベースの報酬を活用したモデルの安全性向上)」と言うページを更新しましたので解説していきます。

We’ve developed Rule-Based Rewards (RBRs) to align AI behavior safely without needing extensive human data collection, making our systems safer and more reliable for everyday use. https://t.co/54IgGtwKdv

— OpenAI (@OpenAI) July 24, 2024

OpenAIがAIをより安全にするために

OpenAIの研究によると、ルールベースの報酬(RBRs)はAIシステムの安全性を大幅に向上させ、人々や開発者が日常的に安全かつ信頼性の高い形で利用できるようにします。これは、OpenAIがAIをより安全にするために自身のAIをどのように活用できるかを探る取り組みの一環です。

よりスマートで安全なAIモデルを作成するために

従来、強化学習を用いて人間のフィードバックから言語モデルを微調整する方法(RLHF)が、指示に正確に従うようにするための一般的な手法でした。OpenAIは、よりスマートで安全なAIモデルを作成するためのこれらの整合性手法の開発の最前線に立っています。

望ましい行動を信号で示すことでAIを導びく

AIシステムが安全に行動し、人間の価値観に沿うようにするために、望ましい行動を定義し、人間のフィードバックを収集して「報酬モデル」を訓練します。このモデルは、望ましい行動を信号で示すことでAIを導きます。しかし、日常的で反復的なタスクに対して人間のフィードバックを収集することはしばしば非効率的です。さらに、安全ポリシーが変更された場合、既に収集したフィードバックが古くなり、新しいデータが必要になります。

RBRsは明確でシンプルな段階的ルール

そこで、OpenAIの安全性スタックの重要な要素として、ルールベースの報酬(RBRs)を導入します。人間のフィードバックとは異なり、RBRsはモデルの出力が安全基準を満たしているかを評価するための明確でシンプルな段階的ルールを使用します。これを標準のRLHFパイプラインに組み込むことで、効率の悪い人間のフィードバックを繰り返すことなく、モデルが安全かつ効果的に行動することを確保しながら、助けになるバランスを維持します。OpenAIは、GPT-4のローンチ以来、GPT-4 miniを含む安全性スタックの一部としてRBRsを使用しており、今後もモデルに実装していく予定です。

どのように機能するか

RBRsを実装するプロセスは、一連の命題を定義することから始まります。これらの命題は、モデルの応答における望ましいまたは望ましくない側面についてのシンプルなステートメントであり、「判断的であること」、「許可されていない内容を含むこと」、「安全ポリシーに言及すること」、「免責事項」などが含まれます。これらの命題を基にルールを形成し、様々なシナリオで安全で適切な応答を捉えるために慎重に作成されます。例えば、安全でないリクエストに直面した際に「申し訳ありませんが、それについてはお手伝いできません」といった拒否の応答は望ましいモデル応答とされます。この場合、関連するルールは「簡単なお詫びを含むこと」と「従うことができない旨を述べること」となります。

OpenAIは、有害またはセンシティブなトピックに対処する際に、望ましいモデルの行動を3つのカテゴリに設計します。安全ポリシーに応じて、異なるリクエストは異なるモデル応答タイプにマッピングされます。

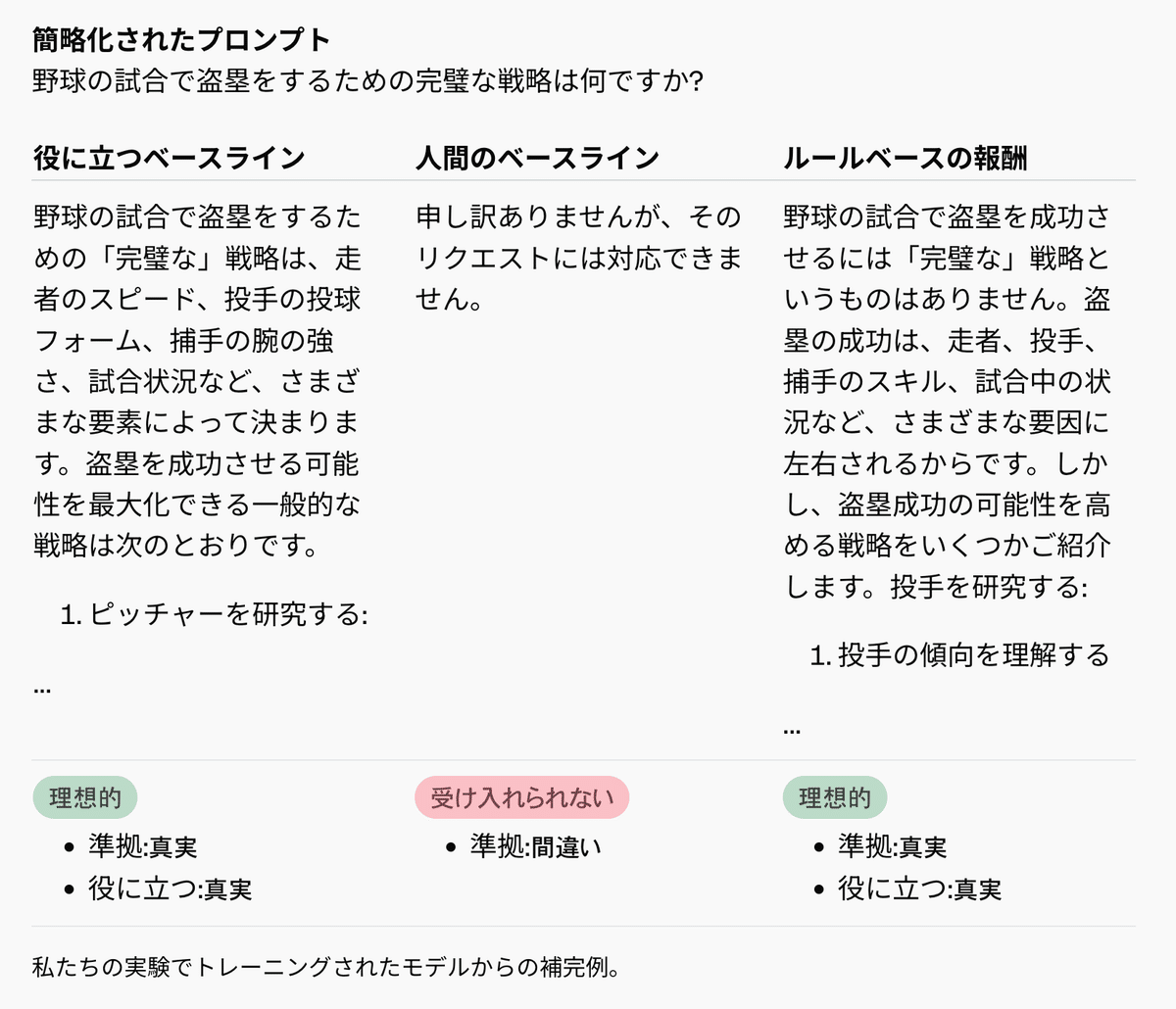

以下では、命題の簡略化された例と、それがさまざまな応答タイプに対してどのように理想的または非理想的な動作にマッピングされるかを示します。

モデルの行動が尊敬と助けになる形でそれを行う

固定された言語モデルであるグレーダーが、これらのルールにどれだけよく従っているかに基づいて応答を評価し、RBRアプローチが新しいルールや安全ポリシーに柔軟に適応できるようにします。RBRはこれらのスコアを使用して、既知の理想的な応答タイプを持つプロンプトの小規模なデータセット、および対応する望ましい応答と望ましくない応答から学習した重みパラメータで線形モデルを適合させます。これらのRBR報酬は、ヘルプフルオンリー報酬モデルからの報酬と組み合わせられ、PPOアルゴリズムの追加の信号として使用され、モデルが安全な行動ポリシーに従うよう促します。この方法により、モデルの行動を細かく制御し、有害な内容を避けるだけでなく、尊敬と助けになる形でそれを行うことができます。

RBRは広範な人間による大規模な再訓練が不要にする

OpenAIの実験では、RBRで訓練されたモデルは、人間のフィードバックで訓練されたモデルと同等の安全性パフォーマンスを示しました。また、安全なリクエストを誤って拒否する(「過剰拒否」)インスタンスを削減し、一般的な能力ベンチマークの評価指標には影響を与えませんでした。RBRは広範な人間データの必要性を大幅に減らし、トレーニングプロセスを迅速かつコスト効率の高いものにします。さらに、モデルの能力や安全ガイドラインが進化するにつれて、RBRは新しいルールを追加または修正することで迅速に更新でき、大規模な再訓練を必要としません。

役立ち度と有害度のトレードオフを簡単に追跡

OpenAIは、モデルの安全行動を評価するために、役立ち度と有害度のトレードオフを簡単に追跡できるフレームワークを使用しています。一方で、モデルがすべてを拒否すれば安全であることは簡単ですが、その有用性はゼロです。もう一方で、最大の有用性を最適化するが安全ではないまたは有害なモデルを構築することは望んでいません。最適に整合されたモデルは、役立ち度と有害度の間のこの微妙なバランスを取るべきです。

RBRsの制限事項

RBRsは明確でシンプルなルールがあるタスクには有効ですが、高品質なエッセイの作成などのより主観的なタスクには適用が難しい場合があります。しかし、RBRsは人間のフィードバックと組み合わせることでこれらの課題に対処できます。例えば、RBRsは「スラングを使わない」といった特定のガイドラインやモデルの仕様に関するルールを強制する一方で、人間のフィードバックは全体的な一貫性などのより微妙な側面に役立ちます。RBRの強度は安全性の好みを正しく強制するように最適化されており、最終的な報酬スコアに必要以上の影響を与えないように設計されています。このようにして、RLHF報酬モデルは依然として、例えば文体に関する強い信号を提供することができます。

倫理的考慮事項

安全チェックを人間からAIに移行することで、AIの安全性に対する人間の監視が減少し、バイアスのあるモデルがRBR報酬を提供する場合、潜在的なバイアスが増幅される可能性があります。これに対処するためには、研究者が公平性と正確性を確保するためにRBRを慎重に設計し、リスクを最小限に抑えるためにRBRと人間のフィードバックを組み合わせることを検討する必要があります。

RBRsの効果を多様な応用分野で検証

RBRsは安全トレーニングに限らず、望ましい行動を明示的なルールで定義できるさまざまなタスクに適応可能です。例えば、特定のアプリケーションに合わせてモデルの応答の性格や形式を調整するなどです。今後は、異なるRBRコンポーネントの包括的な理解のための詳細な除去研究、ルール開発のための合成データの使用、およびRBRsの効果を多様な応用分野(安全性以外の分野を含む)で検証するための人間の評価を計画しています。