OpenAI、イデオロギーの対立

スーパーアライメントチームの主要研究者であるイリヤ・サツケヴァー氏とヤン・ライク氏が昨日OpenAIを退職しました。イデオロギーの対立があったとみられます。

サム・アルトマン氏更迭事件

昨年11月に、イリヤ・サツケヴァー氏は取締役会の3人と共に、サム・アルトマン氏に電撃的に解雇をいい渡しました。主犯格のイリヤ・サツケヴァー氏が沈黙を守る中様々な憶測が乱れ飛んでいましたが、これはひとえにAGI・ASI開発におけるイデオロギー対立だとみられます。

サム・アルトマン氏が効果的加速主義であるのに対し、クーデーターを起こしたイリヤ・サツケヴァー氏と元取締役会のヘレン・トナー氏(注01)などは効果的利他主義というイデオロギーでした。

※注01:ヘレント・ナー氏がサム・アルトマン更迭の理由を語っている詳しい解説は下記のNoteをご覧ください。彼女は、効果的利他主義(Effective Altruism, EA)という思想をもっており、EAは、限られた資源を使ってできるだけ多くの善を行うことを目指す運動で、テクノロジーや社会問題に関する考え方と深く結びついています。

効果的加速主義とは

効果的加速主義(e/acc)とは、21世紀に生まれた哲学運動で、テクノロジーと資本主義の推進を通じて社会改革を目指す思想です。テクノロジーの開発は足枷をはめることなく推進されるべきで、そうしてこそ複雑なシステムが出来上がると信じています。

AI開発における効果的加速主義

効果的加速主義をAI開発の文脈で考えると、以下のような視点が提供されます:

技術の無制限な推進

効果的加速主義は、AIを含むすべての技術開発を制限なく推進することを支持します。この思想によると、技術の急速な進展が社会全体のイノベーションを促進し、長期的には人類に利益をもたらすとされます。AIの場合、研究と開発を加速することによって、より早く高度なAIシステムが実現し、それにより医療、環境、経済など多くの分野で革新的な変化が生まれると期待されます。システムとインフラの進化

効果的加速主義は、複雑なシステムが自然発生的に進化することを奨励します。AI技術においては、この考え方が自律的な学習アルゴリズムや自己改善システムの開発を後押しすることができます。AIが自己進化し、独立して学び続ける能力を持つことで、技術的な限界を超える新しい可能性が開かれると見なされます。倫理的・規制的懸念の扱い

効果的加速主義では、技術の進歩を妨げる可能性のある厳格な規制や倫理的制約に対して批判的です。AI開発においても、過度の規制がイノベーションを阻害すると考えられるため、より柔軟な規制の枠組みが求められることがあります。ただし、これにはリスク管理や倫理的考慮を軽視するという批判もあります。社会改革への影響

効果的加速主義者は、AIのような技術革新が経済的・社会的な不平等を解消し、新しい社会構造を生み出す手段として機能することを期待しています。AIが労働市場、教育、政府の運営方法を変えることにより、より公正で効率的な社会システムが構築されると見なされます。

アルトマン氏解雇に意義を唱えたOpenAIの中のe/accたち

サム・アルトマンの電撃解雇(注02)後にすぐに、サム・アルトマン氏と一緒に出て行ったグレッグ・ブロックマン氏をサティア・ナデラ氏の取り計らいによりMicrosoftに二人は引き入れたのですが、当初のOpenAI社員770名余りの中の740名程が彼らをOpenAIに戻さなければ自分達は全員Microsoftについていくという声明を出しました。よって大半のOpenAI社員効果的加速主義という事になります。

※注02:この解雇激辛の電撃帰還までの一連の事件は下記のNoteに詳しく解説していますので合わせてご覧ください。

Xのアカウントでe/accをさがしてみよう

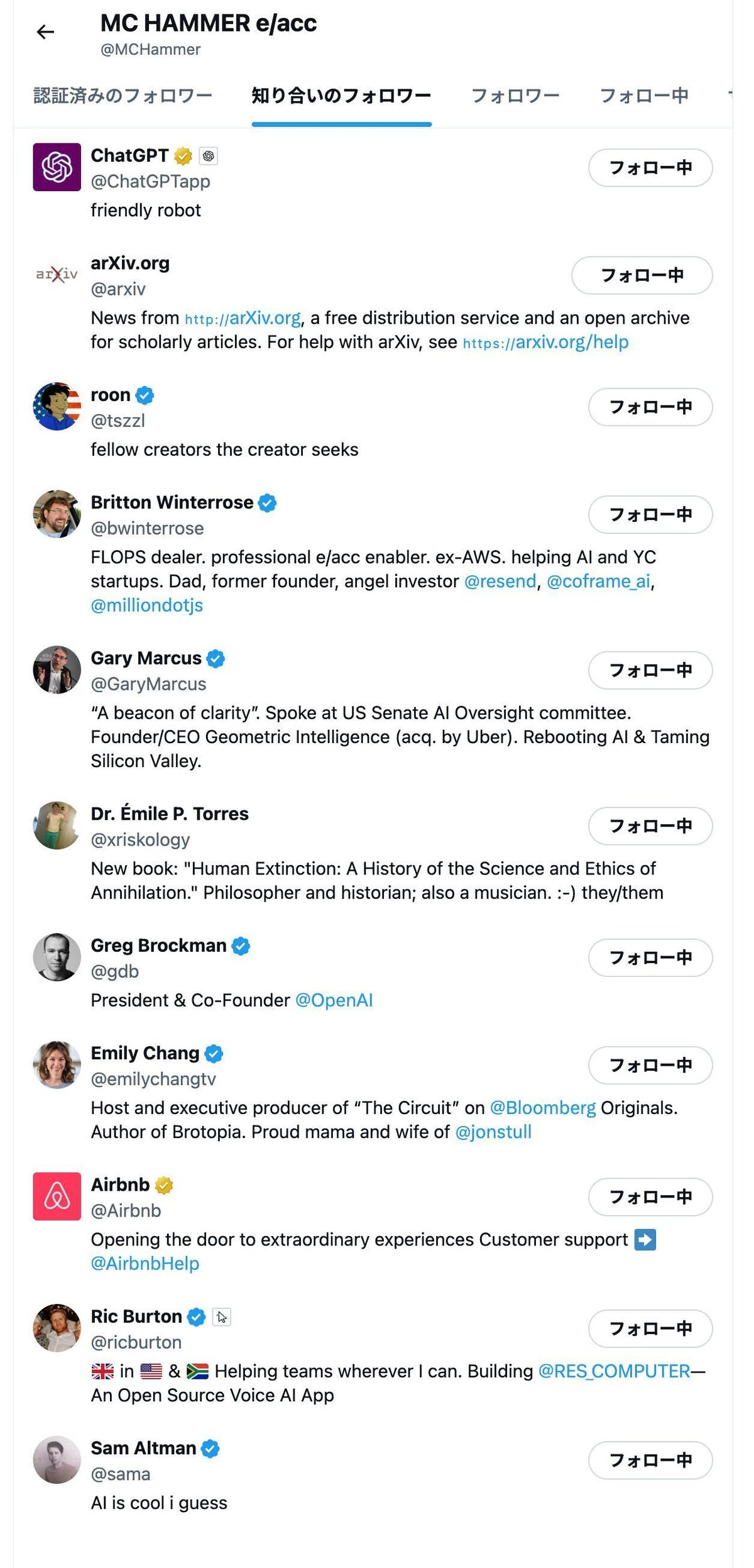

エンドレスで続くのでごく一部のみスクショしますが、とにかく大変大勢の人が効果的加速主義(e/acc)である事がわかります。

特に一番上のMC HAMMER e/accというアカウントはChatGPT公式アカウント、サム・アルトマン、OpenAI社長グレッグ・ブロックマン、Airbnb公式、ブルームバーグのエミリー・チャンなどににフォローされていることがわかります。

効果的利他主義とは

効果的利他主義(EA)とは、他者に貢献して社会をより良くするうえで、効率とインパクトの最大化を目的とする考え方を指します。

AI開発における効果的利他主義

効果的利他主義をAI開発の文脈で解説すると、以下のようになります:

リソースの効率的利用

AI開発において、限られたリソース(資金、人材、データ、計算資源)を最も影響力のある研究やプロジェクトに配分します。これには、最大の社会的、倫理的影響をもたらす技術や応用を特定し、そこに投資することが含まれます。例えば、気候変動対策、医療の進歩、貧困削減など、社会的課題の解決に直接貢献できるAI技術の開発が優先されるかもしれません。長期的な影響の考慮

AIが持つ長期的な影響を考慮に入れることがEAの中心的な考え方です。これには、技術の安全性、倫理的な使用、将来的なリスク(例えば、自動化による雇用への影響、監視社会への懸念など)の管理が含まれます。AIが人類にとってプラスに働くよう、潜在的なネガティブな影響を事前に識別し、対策を講じる必要があります。透明性と協調

AI開発における透明性を確保し、幅広いステークホルダー(研究者、政策立案者、一般市民など)との協調を図ることも、効果的利他主義の原則に沿います。プロジェクトの目的、進行状況、成果について公開し、多様な意見を取り入れることで、公平かつ倫理的な技術開発を目指します。具体的なアウトカムの追求

単に技術を開発するだけでなく、その技術が実際にどのように社会に貢献しているかを定量的に測定し、評価することが重要です。効果的利他主義では、具体的なアウトカム(たとえば、病気の治療率の改善、教育へのアクセスの拡大など)を重視し、その成果を基にさらなる改善を図ります。

OpenAIの中にいた効果的利他主義者たち

サム・アルトマンを解任した3人の取締役会とスーパーアライメントチームのメンバー、この度退職したイリヤ・サツケヴァー氏とヤン・ライク氏、そして機密を漏洩した罪で解雇されたレオポルド・アシェンブレナー氏(注03)がこれに当たります。尚、レオポルド・アシェンブレナー氏は現在イーロン・マスク氏のテスラ AIに入社済みです。昨日辞めたイリヤ・サツケヴァー氏とヤン・ライク氏がテスラに合流するのか、あるいはサムと対立してOpenAIをやめたDario Amodei氏がCEOを務めるAnthropic社に合流するかはまだ不明です。

※注03:2名のイリヤ・サツケヴァー氏の傘下で働く開発者が情報漏洩で解雇された件に関しては下記のNoteに詳しく解説していますので合わせてご覧ください。

OpemAIを抜けてAnthropicを設立したDario Amodei氏

Dario Amodei氏がOpenAIを去ってAnthropicを設立した背景には、AIの安全性や倫理性に対する強い関心があります。Amodei氏とそのチームがAnthropicで重視しているのは、「AIの安全性」と「AIによる意思決定の透明性」です。これらはEAコミュニティが重視する倫理的な配慮と一致する側面がありますが、Anthropicの主な焦点はAIの信頼性と人間にとっての理解しやすさを確保することにあります。

ヤン・ライク氏自らのイデオロギーをXで語る

彼は、OpenAIを離れるにあたり一緒に開発を続けてきた仲間に感謝を述べると共にイデオロギーの違い、これから公開されるであろうOpenAIのAGIに対する警告をXへのポストで語りました。断片的なポストを書きにまとめて翻訳するとこのようになります。

昨日は、アライメント責任者、スーパーアライメントリード、およびエグゼクティブとしての私の最後の日でした

ここ3年ほどは本当にワイルドな旅でした。私のチームは、InstructGPT を使用して史上初の RLHF LLM を立ち上げ、LLM に関する最初のスケーラブルな監視を公開し、自動解釈可能性と弱から強への一般化を開拓しました。さらにエキサイティングな製品が間もなく登場します。

私は自分のチームが大好きです。スーパーアライメント チームの内外で一緒に働くことができた多くの素晴らしい人々にとても感謝しています。 OpenAI には、非常に賢く、親切で、有能な人材がたくさんいます。

この仕事から離れることは、私がこれまでに行った中で最も難しいことの 1 つでした。なぜなら、私たちは私たちよりもはるかに賢い AI システムを操縦し、制御する方法を早急に見つけ出す必要があるからです。

私が参加したのは、OpenAI がこの研究を行うのに世界で最適な場所だと考えたからです。しかし、私はかなり長い間、会社の中核的優先事項について OpenAI のリーダーシップに同意できず、最終的に限界点に達しました。

私は、セキュリティ、監視、準備、安全性、敵対的堅牢性、(超)調整、機密性、社会的影響、および関連するトピックなど、次世代モデルの準備に私たちの帯域幅のはるかに多くの時間を費やすべきだと考えています。

これらの問題を解決するのは非常に難しく、私たちはそこに到達する軌道に乗っていないのではないかと心配しています。

過去数か月間、私のチームは風に逆らって航海してきました。コンピューティングに苦労することもあり、この重要な研究を実行することがますます困難になってきました。

人間よりも賢いマシンの構築は本質的に危険な取り組みです。 OpenAI は人類全体を代表して大きな責任を担っています。

しかしここ数年、安全文化やプロセスは輝く製品よりも後回しになってきました。

私たちは、AGI の影響について信じられないほど真剣に取り組むのが遅れて久しいのです。私たちはできる限りそれらに備えることを優先しなければなりません。そうして初めて、AGI が全人類に確実に利益をもたらすことができるのです。

OpenAI は安全第一の AGI 企業にならなければなりません。

OpenAI のすべての従業員に言いたいのは、「AGI を感じることを学びましょう」ということです。あなたが構築しているものにふさわしい重みを持って行動してください。必要とされている文化的変化を「発信」できると私は信じています。私はあなたを頼りにしています。世界はあなたを頼りにしています。 :オープンハート:

Yesterday was my last day as head of alignment, superalignment lead, and executive @OpenAI.

— Jan Leike (@janleike) May 17, 2024

It's been such a wild journey over the past ~3 years. My team launched the first ever RLHF LLM with InstructGPT, published the first scalable oversight on LLMs, pioneered automated interpretability and weak-to-strong generalization. More exciting stuff is coming out soon.

— Jan Leike (@janleike) May 17, 2024

I love my team.

— Jan Leike (@janleike) May 17, 2024

I'm so grateful for the many amazing people I got to work with, both inside and outside of the superalignment team.

OpenAI has so much exceptionally smart, kind, and effective talent.

Stepping away from this job has been one of the hardest things I have ever done, because we urgently need to figure out how to steer and control AI systems much smarter than us.

— Jan Leike (@janleike) May 17, 2024

I joined because I thought OpenAI would be the best place in the world to do this research.

— Jan Leike (@janleike) May 17, 2024

However, I have been disagreeing with OpenAI leadership about the company's core priorities for quite some time, until we finally reached a breaking point.

I believe much more of our bandwidth should be spent getting ready for the next generations of models, on security, monitoring, preparedness, safety, adversarial robustness, (super)alignment, confidentiality, societal impact, and related topics.

— Jan Leike (@janleike) May 17, 2024

These problems are quite hard to get right, and I am concerned we aren't on a trajectory to get there.

— Jan Leike (@janleike) May 17, 2024

Over the past few months my team has been sailing against the wind. Sometimes we were struggling for compute and it was getting harder and harder to get this crucial research done.

— Jan Leike (@janleike) May 17, 2024

Building smarter-than-human machines is an inherently dangerous endeavor.

— Jan Leike (@janleike) May 17, 2024

OpenAI is shouldering an enormous responsibility on behalf of all of humanity.

But over the past years, safety culture and processes have taken a backseat to shiny products.

— Jan Leike (@janleike) May 17, 2024

We are long overdue in getting incredibly serious about the implications of AGI.

— Jan Leike (@janleike) May 17, 2024

We must prioritize preparing for them as best we can.

Only then can we ensure AGI benefits all of humanity.

OpenAI must become a safety-first AGI company.

— Jan Leike (@janleike) May 17, 2024

To all OpenAI employees, I want to say:

— Jan Leike (@janleike) May 17, 2024

Learn to feel the AGI.

Act with the gravitas appropriate for what you're building.

I believe you can "ship" the cultural change that's needed.

I am counting on you.

The world is counting on you.

:openai-heart: