【論文瞬読】Transformer2: 自己適応するLLMの新時代

はじめに

こんにちは!株式会社AI Nestです。今回は、大規模言語モデル(LLM)の新しい適応手法を提案する注目の研究を紹介します。

タイトル:Transformer2: Self-adaptive LLMs

URL:https://arxiv.org/abs/2501.06252

所属:Sakana AI, Japan & Institute of Science Tokyo, Japan

著者:Qi Sun, Edoardo Cetin, Yujin Tang

従来のLLM微調整には、以下のような課題がありました:

大きな計算コスト

柔軟性の欠如

タスク間の干渉

Transformer2は、これらの課題を解決する革新的なフレームワークを提案しています。

Transformer2の革新的アプローチ

SVF(Singular Value Fine-tuning)

Transformer2の核心技術であるSVFは、重み行列の特異値のみを調整することで、効率的な適応を実現します。

主な利点:

パラメータ効率:従来のLoRAと比較して大幅に少ないパラメータ

高い表現力:フルランクでの調整が可能

優れた正則化効果:過学習を抑制

3つの適応戦略

Transformer2は以下の3つの戦略を提供します:

プロンプトベース適応

タスク分類に基づく適応

軽量で効率的

分類エキスパート

専門化されたタスク識別

より正確な適応

Few-shot適応

テスト時の条件を活用

最も柔軟な適応が可能

実験結果

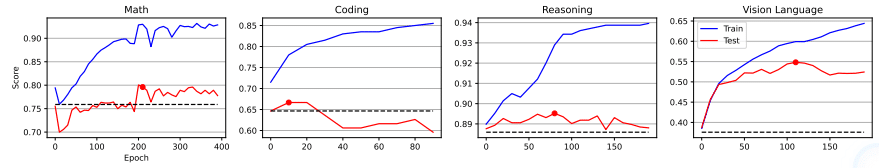

実験では、複数のLLMとタスクでTransformer2の効果を検証しました:

GSM8K(数学)で4%の性能向上

MBPP-Pro(コーディング)で3%の向上

ARC-Easy(推論)で1%の向上

特筆すべきは、これらの改善がLoRAと比較して大幅に少ないパラメータで達成されている点です。

クロスモデル転移

さらに興味深いのは、異なるモデル間での知識転移の可能性です。LLAMA3からMistralへの転移実験では、性能を維持したまま知識の再利用が可能であることが示されました。

まとめ

Transformer2は、以下の点で大きな前進を示しています:

効率的な適応メカニズム

柔軟な知識転移

実用的な計算コスト

今後の展望として、以下のような発展が期待されます:

より大規模なモデルへの適用

新しい適応戦略の開発

マルチモーダルタスクへの拡張

本研究は、LLMの実用化に向けた重要な一歩となるでしょう。