【論文瞬間】Chain-of-Abstraction: 大規模言語モデルとツールの協働による効率的な多段階推論

こんにちは!株式会社AI Nestです。

今日は、大規模言語モデル(LLM)の推論能力を向上させる新しい手法についてお話ししたいと思います。最近、GPTのような大規模な事前学習済み言語モデルが注目を集めていますが、これらのモデルを使って複雑な推論を行うには、まだ課題が残されているのが現状です。

そんな中、「Chain-of-Abstraction: Efficient Tool Use with Multi-Step Reasoning」という論文が登場しました。この研究では、LLMが外部ツールを使って多段階の推論を効率的かつ正確に行う新しい手法「Chain-of-Abstraction(CoA)」が提案されています。今回は、CoAの仕組みや特徴を詳しく見ていきましょう。

タイトル:Efficient Tool Use with Chain-of-Abstraction Reasoning

URL:https://arxiv.org/abs/2401.17464

所属:EPFL, FAIR @ Meta

著者:Silin Gao, Jane Dwivedi-Yu, Ping Yu, Xiaoqing Ellen Tan, Ramakanth Pasunuru, Olga Golovneva, Koustuv Sinha, Asli Celikyilmaz, Antoine Bosselut, Tianlu Wang

Chain-of-Abstractionとは?

CoAは、LLMのツール活用における新たなアプローチです。従来の手法では、LLMがツールを直接呼び出しながら推論を進めていましたが、CoAでは少し異なる方法を取ります。

まず、LLMが抽象的なプレースホルダを含む推論チェーンを生成します。これは、具体的な知識を含まない、推論の流れを表現したものです。次に、各ステップで必要な具体的な知識を、外部ツールを使って埋めていきます。この方法によって、LLMは知識に依存しない一般的な推論戦略を学習することができます。

また、ツールの呼び出しを推論チェーンの生成後に一括で行うため、並列処理による高速化も可能になります。

CoAの有効性を検証

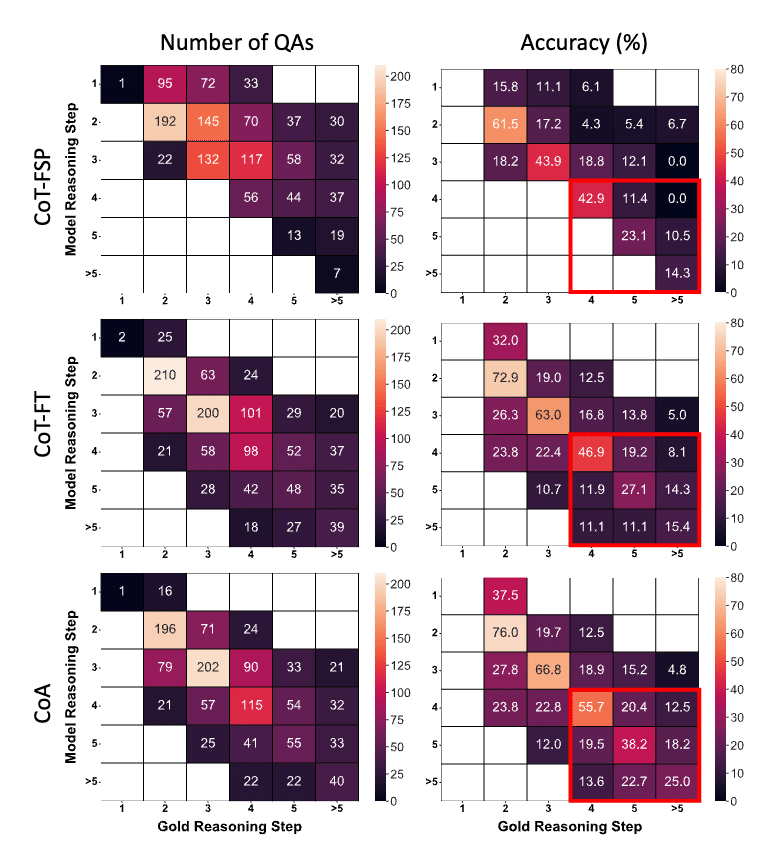

研究チームは、CoAの有効性を検証するために、数学的推論とWiki QAの2つのタスクで評価実験を行いました。

数学的推論では、GSM8K、ASDiv、SVAMP、MAWPSなどのデータセットを使用し、CoAがベースラインを上回る性能を示すことを確認しました。

特に、複数のステップを必要とする問題で、CoAの優位性が顕著に現れています。

Wiki QAでは、HotpotQA、WebQuestions、NaturalQuestions、TriviaQAといったデータセットで評価を行いました。ここでも、CoAは従来手法を上回る結果を示しています。

さらに、推論速度の面でもCoAの効果が確認されました。ツールの呼び出しを並列化できるため、推論にかかる時間を大幅に短縮できるのです。

CoAの意義と今後の展望

CoAの意義は、LLMのツール活用における新たな可能性を示した点にあります。従来手法の問題点を的確に指摘し、抽象的な推論表現とツールの分離という斬新なアイデアで、それらを解決しようとしているのは画期的だと言えるでしょう。

ただし、CoAにも課題がないわけではありません。適用可能なタスクの範囲や、推論プロセスの解釈性など、まだ議論の余地がある点も見受けられます。今後は、より多様なタスクへの適用を通じて、CoAのさらなる可能性を探るとともに、推論チェーンの可読性を高めるための工夫も必要になってくるでしょう。

それでも、CoAはLLMの推論能力を向上させる有望なアプローチの1つであることは間違いありません。この研究を出発点として、さらなる発展を遂げることを期待したいですね。

おわりに

いかがでしたか? CoAは、LLMとツールを組み合わせた推論の新しい形を提案する、非常に興味深い研究だと思います。抽象的な推論表現を用いることで、汎用性と効率性を両立しようとする発想は、今後のLLM研究に大きな影響を与えるかもしれません。

技術の進歩は日進月歩ですが、こうした新しいアイデアに触れることで、私たちも柔軟な思考を持つことができるはずです。これからも、LLMの可能性を追求する研究から目が離せませんね。