【論文瞬読】マルチモーダル大規模言語モデル(MM-LLMs)の最前線:126モデルを徹底解剖!

こんにちは!株式会社AI Nestです。今回は、人工知能の世界で最も熱い話題の一つ、マルチモーダル大規模言語モデル(MM-LLMs)について、最新の研究をもとに詳しくご紹介します。

タイトル:MM-LLMs: Recent Advances in MultiModal Large Language Models

URL:https://arxiv.org/abs/2401.13601

所属:Tencent AI Lab, China、Tencent AI Lab, USA、Kyoto University, Japan、Mohamed bin Zayed University of Artificial Intelligence, United Arab Emirates

著者:Duzhen Zhang、Yahan Yu、Jiahua Dong、Chenxing Li、Dan Su、Chenhui Chu、and Dong Yu

はじめに:MM-LLMsって何?

みなさん、「GPT-4」や「Claude」といった大規模言語モデル(LLM)についてはよく耳にすると思います。でも、「マルチモーダル大規模言語モデル(MM-LLMs)」という言葉はあまり聞き慣れないかもしれませんね。

簡単に言うと、MM-LLMsは、テキストだけでなく、画像、音声、動画などの複数の情報形態(モダリティ)を理解し、処理できる超優秀なAIモデルのことです。つまり、人間のように、見たり聞いたりした情報を総合的に理解し、それに基づいて文章を生成したり、質問に答えたりできるんです。すごくないですか?

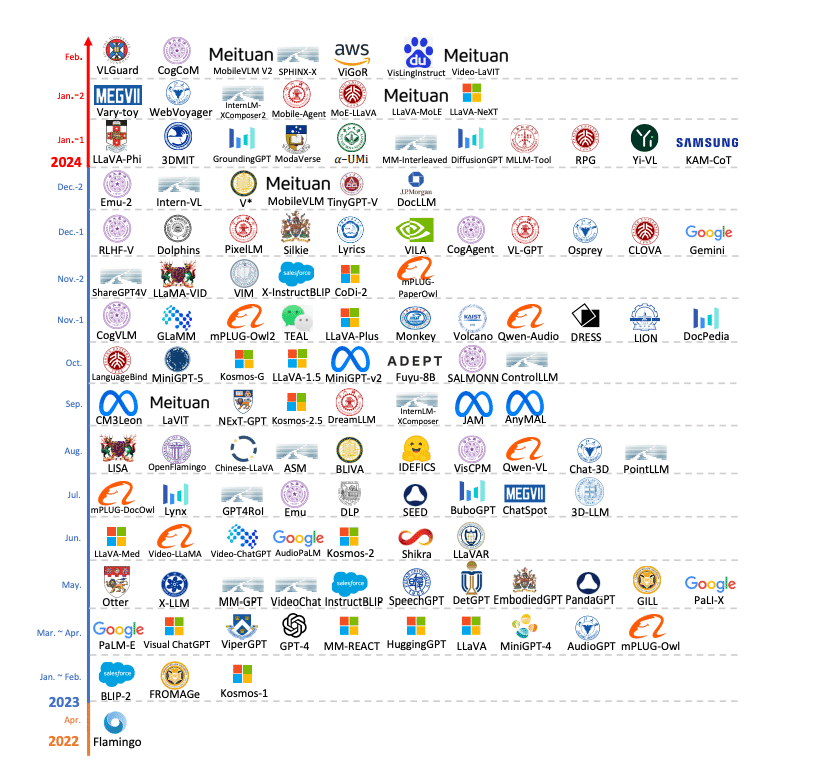

上の図は、MM-LLMsの発展の歴史を示しています。2022年4月のFlamingoから始まり、2024年2月までの主要なMM-LLMsの登場を時系列で見ることができます。この2年弱の間に、実に多くのモデルが開発されていることがわかりますね。特に2023年は大きな進展があった年だったようです。

MM-LLMsの最新動向:126モデルを徹底調査!

最近、Zhang et al.による興味深い論文が発表されました。この論文では、なんと126もの最先端MM-LLMsを徹底的に調査・分類しているんです。私たちの分野では珍しいほど包括的な研究で、正直、読んでいてワクワクしました。

モデルアーキテクチャの秘密

MM-LLMsのモデルアーキテクチャは、大きく5つの部品で構成されています:

モダリティエンコーダ:画像や音声を数値データに変換

入力プロジェクタ:変換されたデータをLLMが理解できる形式に調整

LLMバックボーン:データを理解し、処理する中核部分

出力プロジェクタ:LLMの出力を他のモダリティ用に調整

モダリティジェネレータ:テキスト以外の出力(画像や音声など)を生成

この図を見ると、各コンポーネントにどのような選択肢があるかが一目瞭然ですね。例えば、画像のエンコーダにはNFNet-F6やViTなど様々な選択肢があり、LLMバックボーンにはFlan-T5やLLaMAなどが使用されています。この構造を理解すると、MM-LLMsがどのように複数のモダリティを扱っているのか、イメージしやすくなりますよね。

学習の2ステップ:事前学習と指示調整

MM-LLMsの学習は主に2段階で行われます:

マルチモーダル事前学習(MM PT):大量のデータを使って基本的な能力を習得

マルチモーダル指示調整(MM IT):人間の指示に従う能力を磨く

特に指示調整の段階では、人間のフィードバックを活用した強化学習(RLHF)が使われることもあり、より人間の意図に沿った応答ができるようになります。

MM-LLMsの現在地:ベンチマークから見えてくるもの

論文では、18の視覚-言語ベンチマークを用いて主要なMM-LLMsの性能を比較しています。

この表を見ると、モデルによって得意不得意がはっきりしていることがわかります。例えば:

OKVQA(外部知識を要する視覚的質問応答)では、MiniGPT-v2とMiniGPT-v2-chatが最高性能を示しています。

VQA v2 (一般的な視覚的質問応答)では、VILA-13Bが最高性能です。

MME P (知覚タスク)では、LLaVA-1.5 + ShareGPT4Vが優れた性能を示しています。

これらの違いは、各モデルの設計思想や学習データの違いが反映されているんでしょうね。また、全体的なトレンドとして、モデルのサイズが大きくなるほど性能が向上する傾向が見られます。

MM-LLMsの未来:7つの挑戦

論文では、MM-LLMsの今後の研究方向として7つの課題を挙げています:

より一般的で知的なモデルの開発

より挑戦的なベンチマークの作成

モバイル/軽量展開の実現

具現化された知能(ロボットとの統合など)の探求

継続学習能力の向上

幻覚(存在しない情報の生成)の緩和

バイアスと倫理的問題への対処

個人的には、特に3番目のモバイル/軽量展開に注目しています。MM-LLMsのような高度なAIを、スマートフォンなど身近なデバイスで直接動かせるようになれば、私たちの日常生活が劇的に変わる可能性がありますからね。

まとめ:MM-LLMsが拓く新しい世界

MM-LLMsは、人間のように複数の感覚を統合して理解し、表現する能力を持つAIです。今回紹介した研究は、この急速に発展する分野の「現在地」を明らかにし、将来の方向性を示唆しています。

技術の進歩は日進月歩で、今後はさらに驚くべき能力を持つMM-LLMsが登場するかもしれません。例えば、複数の専門分野の知識を組み合わせて新しいアイデアを生み出したり、人間とより自然なマルチモーダルコミュニケーションを行ったりするAIが現実のものになるかもしれません。

一方で、このような強力なAI技術には責任ある開発と利用が求められます。バイアスの問題や倫理的な懸念にも真摯に向き合いながら、技術を発展させていく必要があります。

MM-LLMsの発展は、私たちの暮らしや働き方、さらには人間とAIの関係性そのものを変えていく可能性を秘めています。これからのMM-LLMsの進化に、皆さんも注目してみてはいかがでしょうか?

最後までお読みいただき、ありがとうございました。MM-LLMsについて、皆さんはどう思いますか?コメント欄で感想や意見を聞かせてください!